流式深度学习终于奏效了!强化学习之父Richard Sutton力荐

流式深度学习终于奏效了!强化学习之父Richard Sutton力荐自然智能(Natural intelligence)过程就像一条连续的流,可以实时地感知、行动和学习。流式学习是 Q 学习和 TD 等经典强化学习 (RL) 算法的运作方式,它通过使用最新样本而不存储样本来模仿自然学习。这种方法也非常适合资源受限、通信受限和隐私敏感的应用程序。

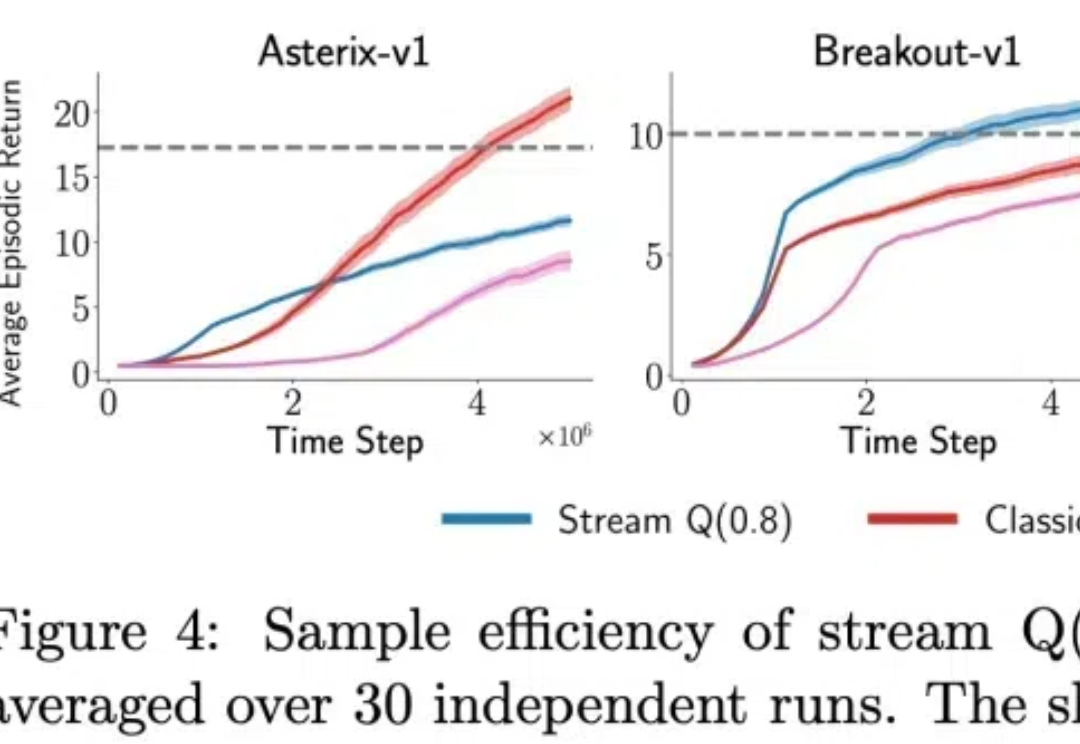

自然智能(Natural intelligence)过程就像一条连续的流,可以实时地感知、行动和学习。流式学习是 Q 学习和 TD 等经典强化学习 (RL) 算法的运作方式,它通过使用最新样本而不存储样本来模仿自然学习。这种方法也非常适合资源受限、通信受限和隐私敏感的应用程序。

刚刚,谷歌官方宣布了一条重磅消息: Keras之父François Chollet,正式离职。

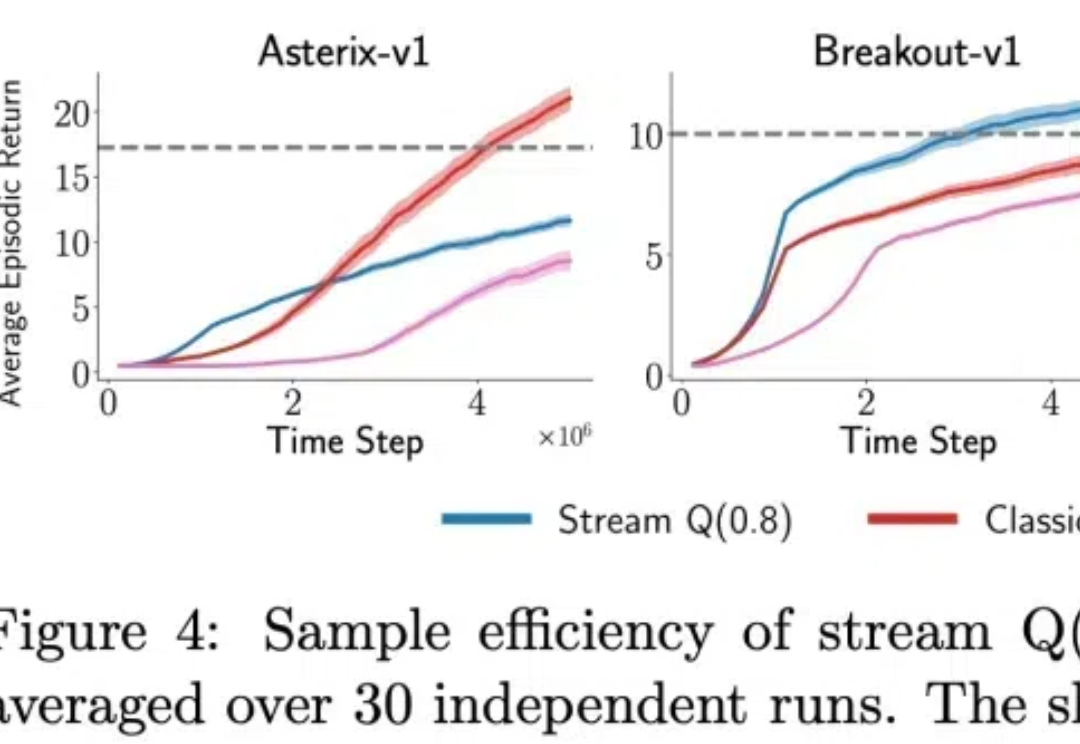

随着人形机器人技术的迅猛发展,如何有效获取高质量的操作数据成为核心挑战。鉴于人类操作行为的复杂性和多样性,如何从真实世界中精准捕捉手与物体交互的完整状态,成为推动人形机器人操作技能学习的关键所在。

在人工智能(AI)领域,特别是深度学习和神经网络训练中,GPU(图形处理单元)已经成为不可或缺的硬件。但为什么AI对GPU的要求高,而不是CPU(中央处理单元)呢?让我们通过一个生动的比喻来揭开这个谜团。

今年诺贝尔奖颁给AI,是诺奖委员会感到压力的结果,需要承认深度学习的影响。 但物理奖颁给Hinton和Hopefield,获奖成果玻尔兹曼机和Hopefield网络现在完全无用。

近日,深度学习三巨头之一的Yoshua Bengio,带领团队推出了全新的RNN架构,以大道至简的思想与Transformer一较高下。

前不久在人工智能的帮助下,两位科学家获得了诺贝尔物理学奖。可以说人工智能已经在很多领域被广泛应用了。随着大语言模型(LLM)和深度学习的广泛应用,GPU 也已成为机器学习工程师和研究人员最重要的计算资源之一。

2020 年初,新冠病毒的阴影迅速笼罩全球。在这场与时间的赛跑中,我们见证了无数英勇的个体和团队挺身而出,社会体系经历了一次次严峻考验,也为全球的公共卫生领域敲响了警钟。

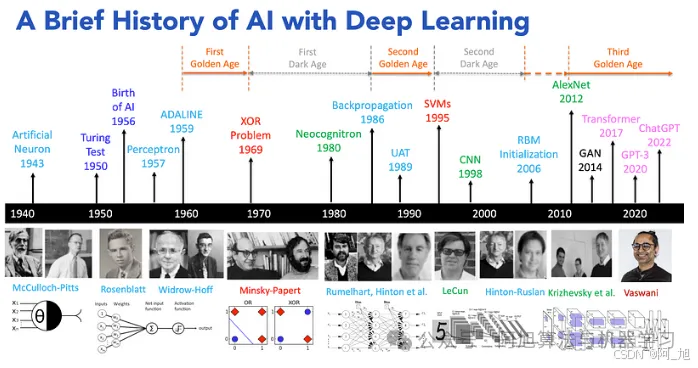

人工智能的历史,特别是深度学习,具有重要的里程碑意义,始于1956年达特茅斯会议上人工智能的概念化。

自从 Transformer 模型问世以来,试图挑战其在自然语言处理地位的挑战者层出不穷。 这次登场的选手,不仅要挑战 Transformer 的地位,还致敬了经典论文的名字。 再看这篇论文的作者列表,图灵奖得主、深度学习三巨头之一的 Yoshua Bengio 赫然在列。