田渊栋和Sergey Levine参与开发新型RL算法,能通过多轮训练让智能体学会协作推理

田渊栋和Sergey Levine参与开发新型RL算法,能通过多轮训练让智能体学会协作推理强化学习提升了 LLM 各方面的能力,而强化学习本身也在进化。

强化学习提升了 LLM 各方面的能力,而强化学习本身也在进化。

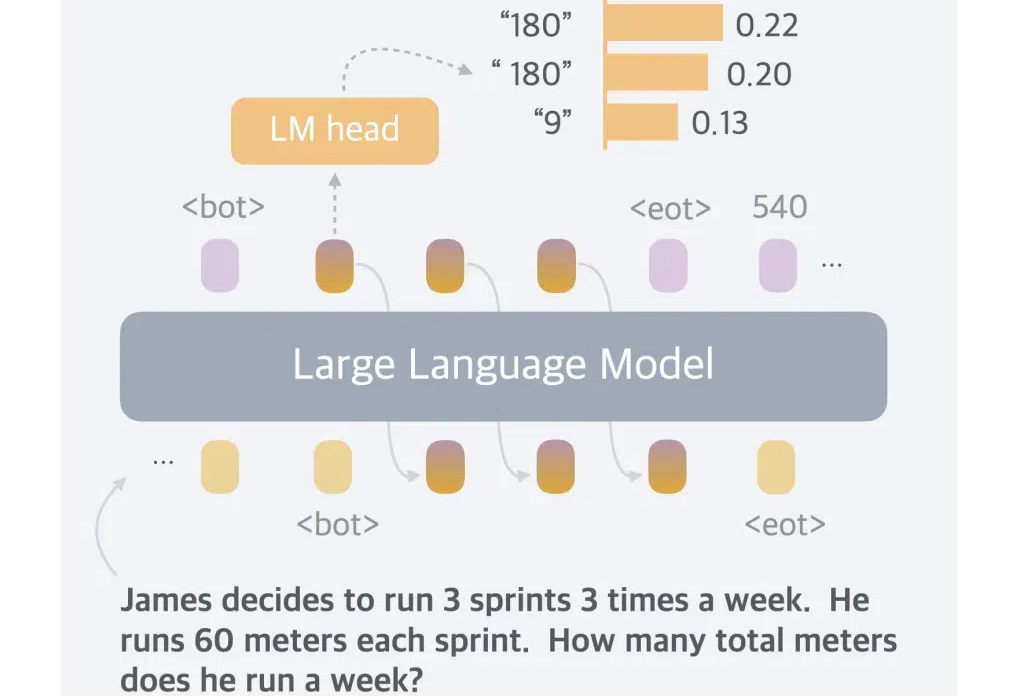

自然语言 token 代表的意思通常是表层的(例如 the 或 a 这样的功能性词汇),需要模型进行大量训练才能获得高级推理和对概念的理解能力,

2024年已经结束,2025年对于AI又意味着什么?田渊栋最新长文中对过去一年做了全面的总结。

针对大语言模型的推理任务,近日,Meta田渊栋团队提出了一个新的范式:连续思维链,对比传统的CoT,性能更强,效率更高。

一般而言,LLM 被限制在语言空间(language space)内进行推理,并通过思维链(CoT)来表达推理过程,从而解决复杂的推理问题。

AI评估AI可靠吗?来自Meta、KAUST团队的最新研究中,提出了Agent-as-a-Judge框架,证实了智能体系统能够以类人的方式评估。它不仅减少97%成本和时间,还提供丰富的中间反馈。

Meta版o1也来了。 田渊栋团队带来新作Dualformer,把快慢思考无缝结合,性能提升还成本更低。 能解决迷宫、推箱子等复杂问题。

OpenAI ο1 模型的发布掀起了人们对 AI 推理过程的关注,甚至让现在的 AI 行业开始放弃卷越来越大的模型,而是开始针对推理过程进行优化了。今天我们介绍的这项来自 Meta FAIR 田渊栋团队的研究也是如此,其从人类认知理论中获得了灵感,提出了一种新型 Transformer 架构:Dualformer。

随OpenAI爆火的CoT,已经引发了大佬间的激战!谷歌DeepMind首席科学家Denny Zhou拿出一篇ICLR 2024论文称:CoT可以让Transformer推理无极限。但随即他就遭到了田渊栋和LeCun等的质疑。最终,CoT会是通往AGI的正确路径吗?

Scaling law发展到最后,可能每个人都站在一个数据孤岛上。