田渊栋:2025年年终总结(一)

田渊栋:2025年年终总结(一)从救火Llama 4反被裁,再到如今下场自创业,AI大佬田渊栋回顾了2025年一些重要时刻。

从救火Llama 4反被裁,再到如今下场自创业,AI大佬田渊栋回顾了2025年一些重要时刻。

Nano Banana Pro又被开发出了新玩法。

离开Meta的大佬们,留下作品还在陆续发表,今天轮到田渊栋。

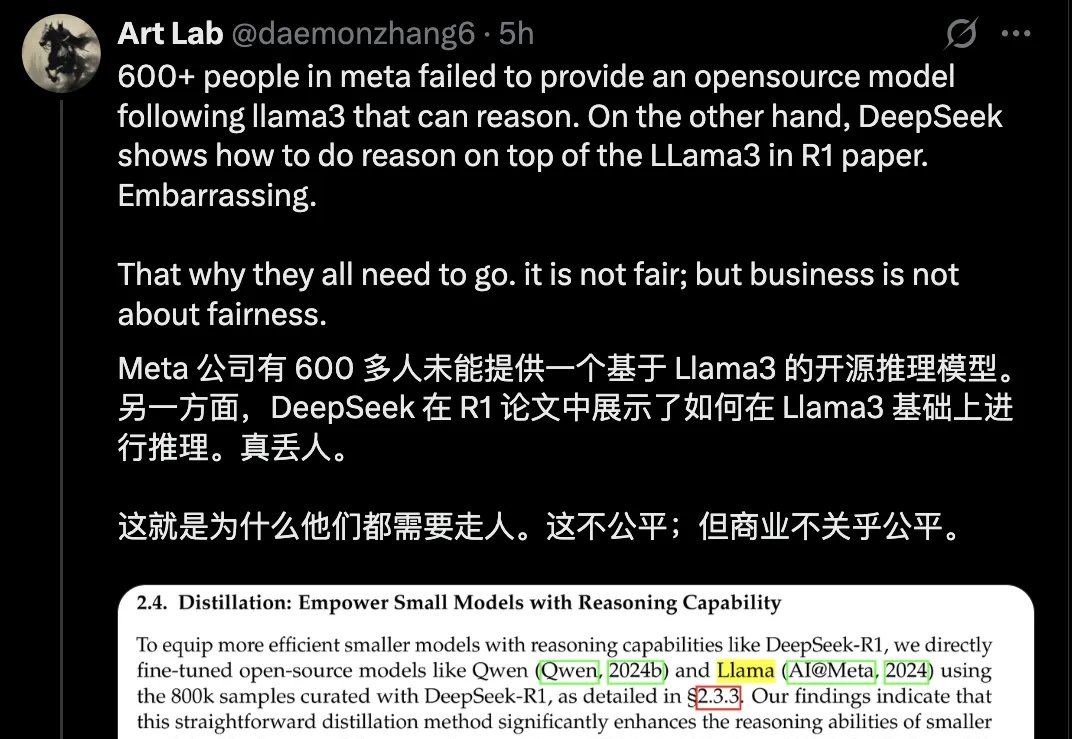

Meta首席执行官马克·扎克伯格近日批准了一项涉及约600名员工的AI部门裁员计划,这是Meta今年在人工智能领域规模最大的一次调整,主要波及公司核心研发机构。在此消息公布后,田渊栋首次公开露面,接受了腾讯科技特约作者「课代表立正」的独家深度访谈。

科技行业全球10万大裁员,连10年老将田渊栋都被Meta裁掉了!昨天,南洋理工大学的副教授Boyang Li吊足了大家的胃口:Meta FAIR最近的事件很抓马,但工业研究为什么这么难?我想知道大家愿不愿意听一下我的观点。

刚刚从Meta一线获悉,田渊栋前脚刚发了推文说自己被裁,后脚就被解除了公司内部各种权限——嘿,亚历山大王的刀,就是这么快。这也是这次裁员中最具争议的地方,“在Meta工作已超过十年的田渊栋和他的组员,整组被一锅端了”,这是为什么?

很疯狂,Meta AI裁员能裁到田渊栋头上,而且是整组整组的裁。田渊栋在Meta工作已超过十年,现任FAIR研究科学家总监(Research Scientist Director),他领导开发了早于AlphaGo的围棋AI“Dark Forest”

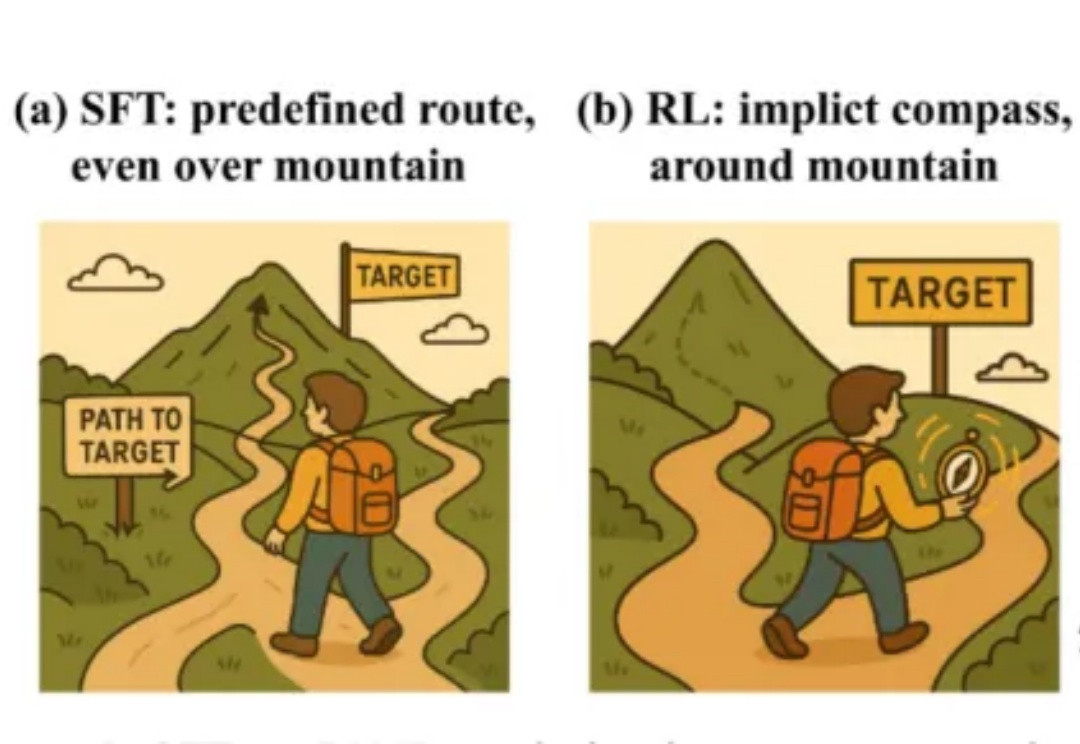

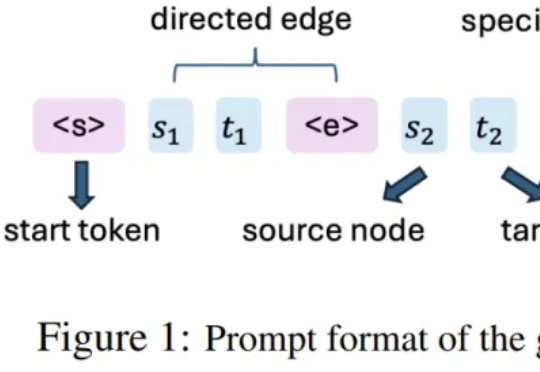

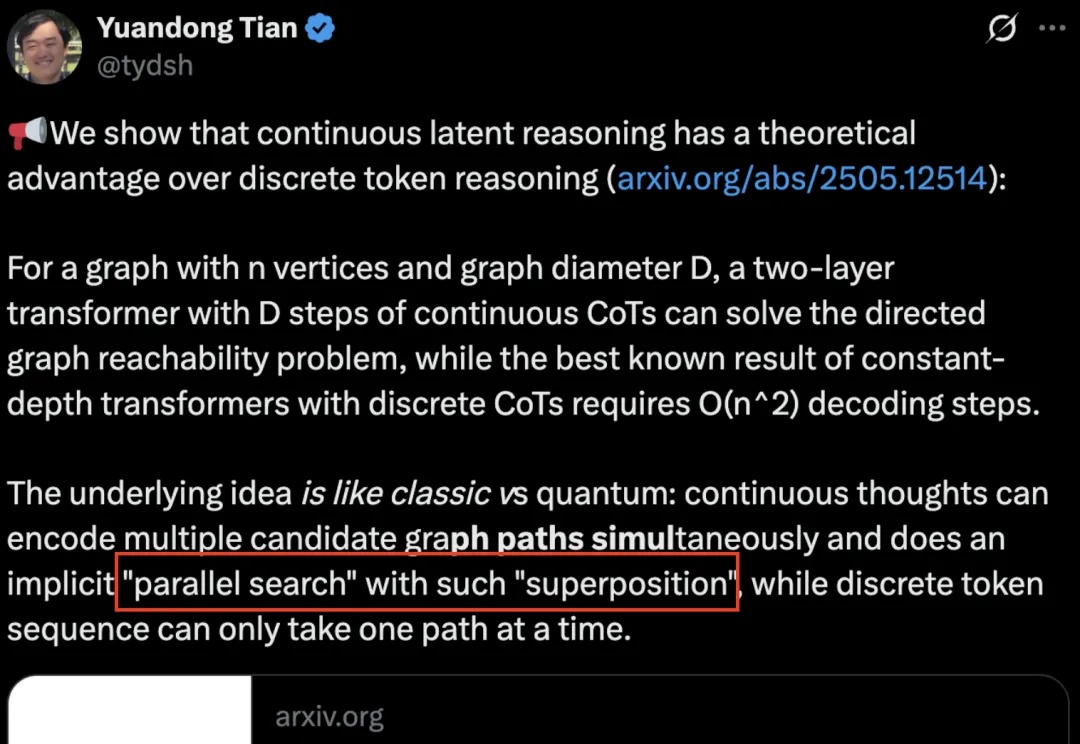

该团队 2025 年的研究《Reasoning by superposition: A theoretical perspective on chain of continuous thought》已从理论上指出,连续思维链的一个关键优势在于它能使模型在叠加(superposition)状态下进行推理:当模型面对多个可能的推理路径而无法确定哪一个是正确时,它可以在连续空间中并行地保留所有可能的路

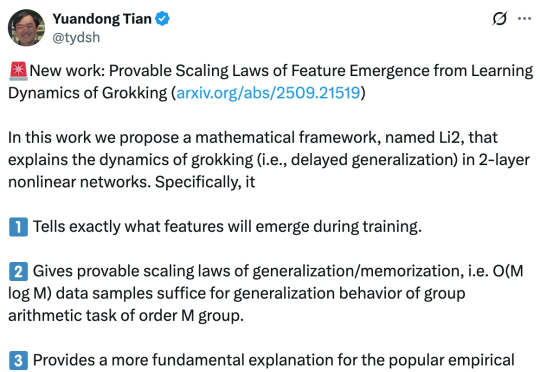

早在 2021 年,研究人员就已经发现了深度神经网络常常表现出一种令人困惑的现象,模型在早期训练阶段对训练数据的记忆能力较弱,但随着持续训练,在某一个时间点,会突然从记忆转向强泛化。

AI也有量子叠加态了?