田渊栋团队新作祭出Agent-as-a-Judge!AI智能体自我审判,成本暴跌97%

田渊栋团队新作祭出Agent-as-a-Judge!AI智能体自我审判,成本暴跌97%AI评估AI可靠吗?来自Meta、KAUST团队的最新研究中,提出了Agent-as-a-Judge框架,证实了智能体系统能够以类人的方式评估。它不仅减少97%成本和时间,还提供丰富的中间反馈。

AI评估AI可靠吗?来自Meta、KAUST团队的最新研究中,提出了Agent-as-a-Judge框架,证实了智能体系统能够以类人的方式评估。它不仅减少97%成本和时间,还提供丰富的中间反馈。

斯坦福吴佳俊团队与MIT携手打造的最新研究成果,让我们离实时生成开放世界游戏又近了一大步。

最近这几天,让大模型具备控制计算机(包括电脑和手机)的相关研究和应用如雨后春笋般不断涌现。

哈佛大学研究了大型语言模型在回答晦涩难懂和有争议问题时产生「幻觉」的原因,发现模型输出的准确性高度依赖于训练数据的质量和数量。研究结果指出,大模型在处理有广泛共识的问题时表现较好,但在面对争议性或信息不足的主题时则容易产生误导性的回答。

「这才是开放研究该有的样子。」 经常刷 arXiv 的同学,你有没有发现页面上多了个新功能?这个新功能(图中的「Hugging Face」按钮)隐藏在「Code, Data, Media」选项卡下,选中之后就可以直达相关的 Hugging Face 论文、模型和数据集。

数学界对AI在数学中应用的看法存在分歧,但年轻一代更支持AI和验证工具。Vlad指出,通过递归自我改进,AI有潜力在数学和其他复杂问题上取得重大突破。随着AI在模式识别和自我改进方面的进步,它可能参与解决大型数学难题,如黎曼猜想。同时,数学家仍将在引导AI方向、规划研究领域和解释结果方面起关键作用。

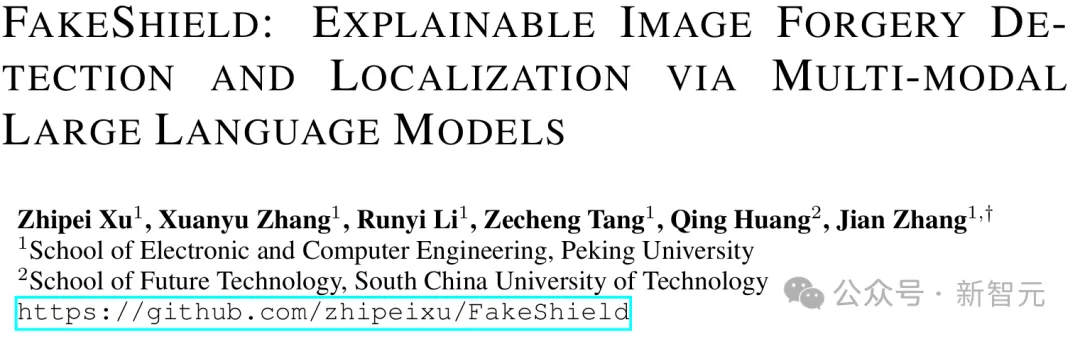

北京大学的研究人员开发了一种新型多模态框架FakeShield,能够检测图像伪造、定位篡改区域,并提供基于像素和图像语义错误的合理解释,可以提高图像伪造检测的可解释性和泛化能力。

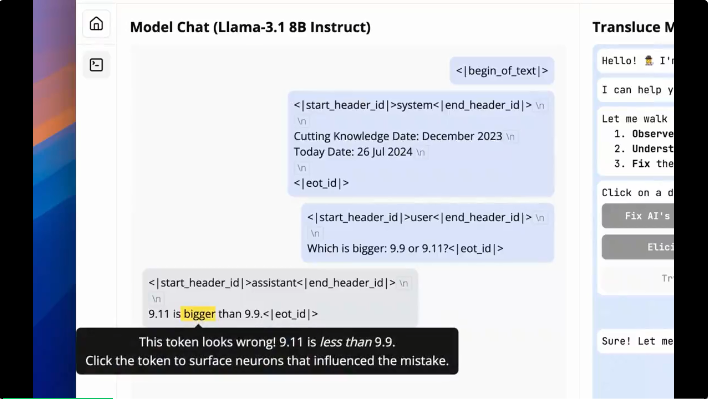

大模型分不清“9.9和9.11哪个更大”的谜团,终于被可解释性研究揭秘了!

Miles Brundage,OpenAI 的长期政策研究员和公司 AGI Readiness 团队的高级顾问,已离职。

两位清华校友,在OpenAI发布最新研究—— 生成图像,但速度是扩散模型的50倍。 路橙、宋飏再次简化了一致性模型,仅用两步采样,就能使生成质量与扩散模型相媲美。