谷歌领投2000万美金,OpenAI、DeepMind天使投资人也集体下注:这家公司要做AI时代的"通用集成层"

谷歌领投2000万美金,OpenAI、DeepMind天使投资人也集体下注:这家公司要做AI时代的"通用集成层"我最近深入研究了一家名为 StackOne 的伦敦创业公司,他们刚刚完成了由 GV(Google Ventures)领投的 2000 万美元 A 轮融资,这不仅仅是一个简单的融资消息,而是整个企业软件生态系统即将迎来根本性变革的信号。

我最近深入研究了一家名为 StackOne 的伦敦创业公司,他们刚刚完成了由 GV(Google Ventures)领投的 2000 万美元 A 轮融资,这不仅仅是一个简单的融资消息,而是整个企业软件生态系统即将迎来根本性变革的信号。

马斯克宣布旗下公司取消「研究员」头衔,强调「工程师」的重要性,掀起与AI先驱LeCun关于研究与工程本质区别的激烈争论,引发业界对科技创新与组织管理战略的深入思考。

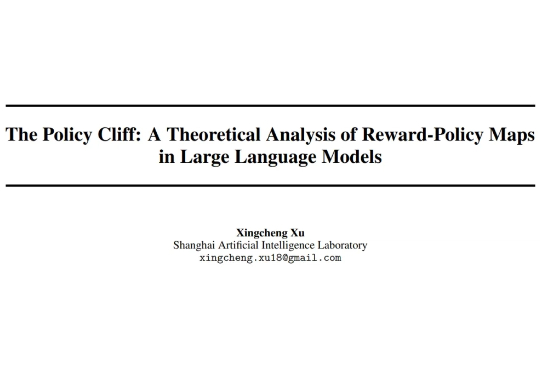

强化学习(RL)是锻造当今顶尖大模型(如 OpenAI o 系列、DeepSeek-R1、Gemini 2.5、Grok 4、GPT-5)推理能力与对齐的核心 “武器”,但它也像一把双刃剑,常常导致模型行为脆弱、风格突变,甚至出现 “欺骗性对齐”、“失控” 等危险倾向。

时间是最好的试金石,AI领域尤其如此。当行业热议大模型走向时,商汤早已锚定「多模态通用智能」——这是商汤以深厚研究积累和实践反复验证的可行路径。今天,商汤科技联合创始人、执行董事、首席科学家林达华特别撰写的万字深度长文正式发布。文章剖析了商汤为何将「多模态通用智能」视为技术战略的核心引擎,也探索性阐释了在组织及战略层面的诸多思考。通往AGI的拼图中,多模态是缺一不可的基石。

具身智能,成了这个夏天最炙手可热的创业赛道。 量子位独家获悉,华为诺亚方舟实验室首席研究员,刚刚创办了一家具身智能公司。

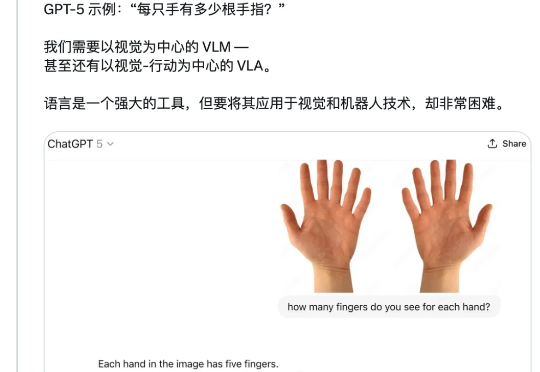

「一只手有几根手指?」 这个看似简单的问题,强如 GPT-5 却并不能总是答对。 今天,CMU 博士生、英伟达 GEAR(通用具身智能体研究)团队成员 Tairan He(何泰然)向 GPT-5 询问了这个问题,结果模型回答错了。

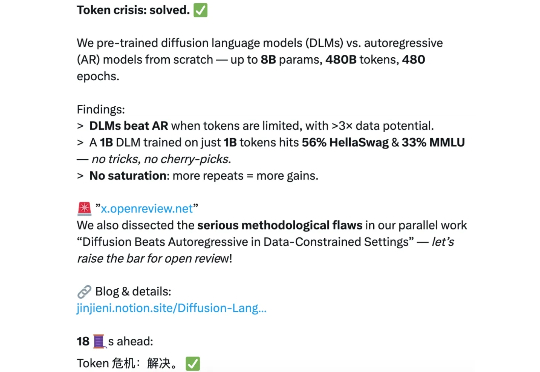

扩散语言模型(DLMs)是超强的数据学习者。 token 危机终于要不存在了吗? 近日,新加坡国立大学 AI 研究者 Jinjie Ni 及其团队向着解决 token 危机迈出了关键一步。

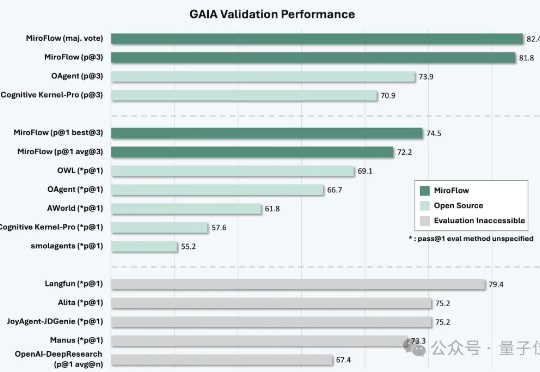

最强开源深度研究模型来了。 MiroMind ODR(Open Deep Research),来自代季峰加盟陈天桥的技术首秀。 首先,它做到了性能最强,GAIA测试结果更是达到了82.4分,超过了一众开源闭源模型,其中包括Manus、OpenAI的DeepResearch。

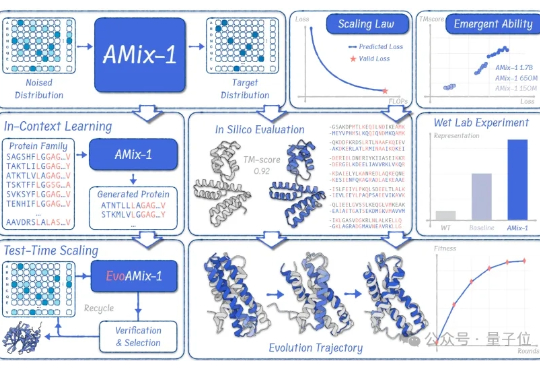

蛋白质模型的GPT时刻来了! 清华大学智能产业研究院(AIR)周浩副教授课题组联合上海人工智能实验室发布了AMix-1: 首次以Scaling Law、Emergent Ability、In-Context Learning和Test-time Scaling的系统化方法论来构建蛋白质基座模型。

“听说 Showrunner AI 能直接生成剧本,还被好莱坞大导演抢着用。”我对这种跨界的 “新物种” 总是充满好奇,这玩意儿,是不是又一个噱头?虽仍处于封闭测试的阶段,却已有超 10 万用户挤入等候名单。这个 Showrunner AI,得好好研究研究。