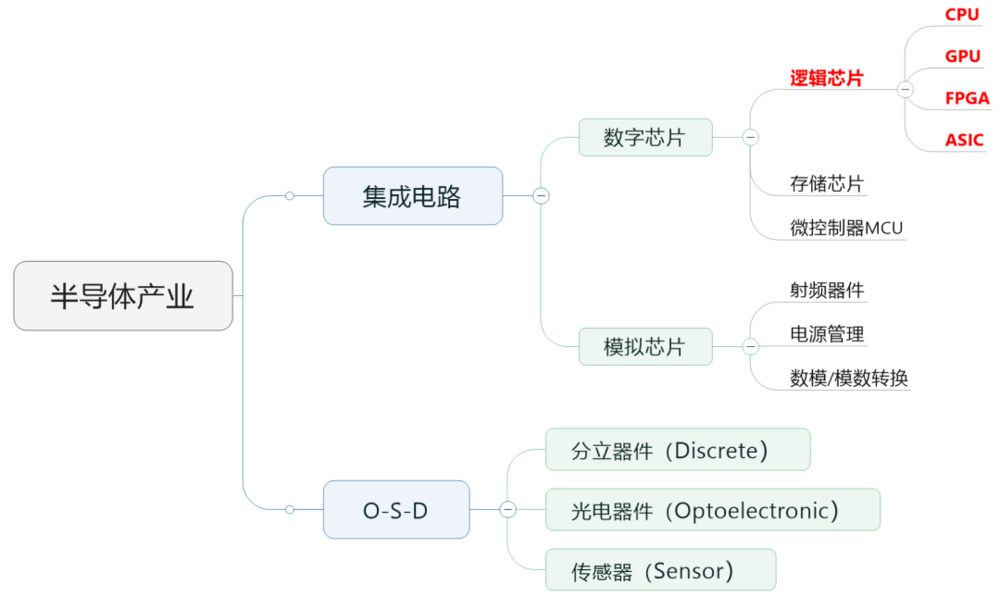

AI计算,为什么要用GPU?

AI计算,为什么要用GPU?本文介绍了为什么在AI计算中要使用GPU,以及GPU与CPU的区别和作用。GPU具备强悍的并行计算能力,适合处理大量高强度并行计算任务,包括深度学习算法。

本文介绍了为什么在AI计算中要使用GPU,以及GPU与CPU的区别和作用。GPU具备强悍的并行计算能力,适合处理大量高强度并行计算任务,包括深度学习算法。

AI电商时代的到来给电商行业带来了巨大的变化,各种AI工具已经在电商领域广泛应用。然而,企业在迎接这个时代的挑战时需要关注算力、数据隐私、安全问题和人才培养等方面。

生成式AI将成为未来企业在竞争中优势的重要来源。企业现在面临的关键问题已经不是要不要上大模型,而是如何让大模型落地,为企业创造真正的价值。

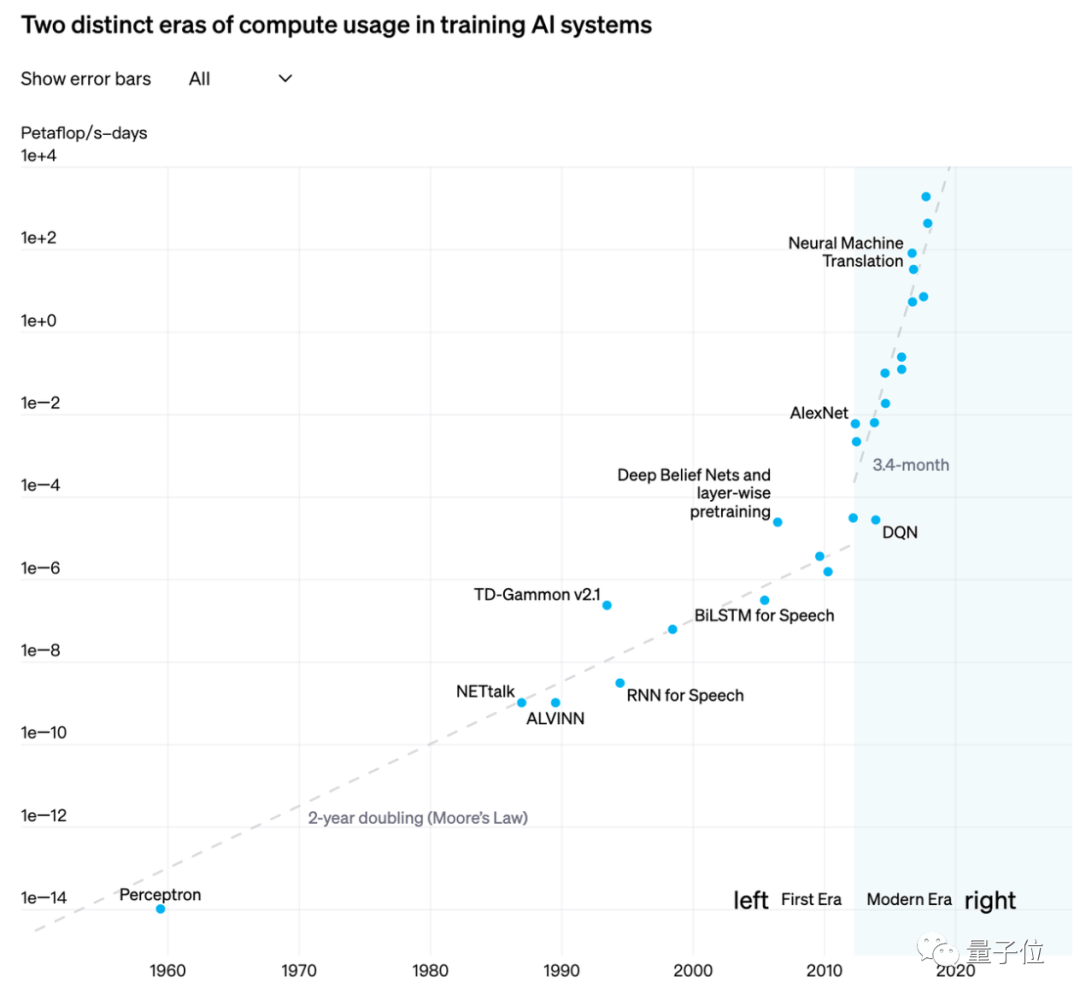

算力不足仍然是制约通用人工智能发展的重要因素。GPU Utils 今年 8 月的一份数据显示,全球目前 H100 等效算力的供给缺口达到 43 万张。在解决算力不足的问题上,除了抢购和囤积英伟达,更多的方案正在浮出水面。

国内首个以国产全功能GPU为底座的大规模算力集群,正式落地了!这便是来自摩尔线程的KUAE智算中心,全国产千卡千亿模型训练平台。

大模型的领域工程,是要将行业模型的参数规模做小,任务执行效率更高的同时,节省算力和部署成本。

尽管我们无法预料大模型会生成什么,也不知道算力和数据的极限在哪里,但生成式 AI 革命是不可阻挡的。

随着大型语言模型(LLM)的发展,从业者面临更多挑战。如何避免 LLM 产生有害回复?如何快速删除训练数据中的版权保护内容?如何减少 LLM 幻觉(hallucinations,即错误事实)? 如何在数据政策更改后快速迭代 LLM?这些问题在人工智能法律和道德的合规要求日益成熟的大趋势下,对于 LLM 的安全可信部署至关重要。

计算芯片未来可能不是英伟达的专利,AMD也要来了。

没想到,在ChatGPT爆火后的一年里,竟然出现了一个隐藏“Boss”——量子位获悉,百度、360等互联网大厂均已开始基于昇腾部署AI模型;而知乎、新浪、美图这样全速推进AI业务的公司,背后同样出现了华为云昇腾AI云服务的身影。