两周复刻DeepSeek-OCR!两人小团队还原低token高压缩核心,换完解码器更实用

两周复刻DeepSeek-OCR!两人小团队还原低token高压缩核心,换完解码器更实用两人小团队,仅用两周就复刻了之前被硅谷夸疯的DeepSeek-OCR?? 复刻版名叫DeepOCR,还原了原版低token高压缩的核心优势,还在关键任务上追上了原版的表现。完全开源,而且无需依赖大规模的算力集群,在两张H200上就能完成训练。

两人小团队,仅用两周就复刻了之前被硅谷夸疯的DeepSeek-OCR?? 复刻版名叫DeepOCR,还原了原版低token高压缩的核心优势,还在关键任务上追上了原版的表现。完全开源,而且无需依赖大规模的算力集群,在两张H200上就能完成训练。

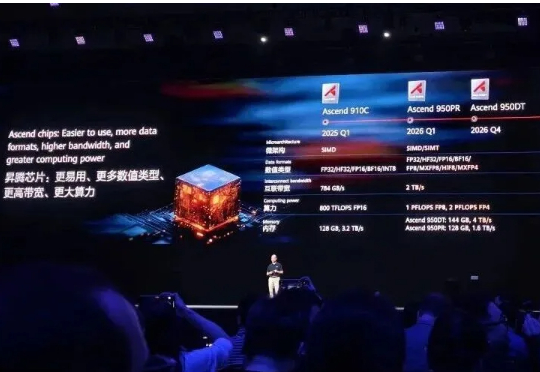

继余承东三折叠手机发布会上亮相麒麟芯片后,AI算力芯片也有了最新进展。就在华为全联接大会上,轮值董事长徐直军,带来了全球最强算力超节点和集群!Atlas 950 SuperPoD和Atlas 960 SuperPoD超节点,分别支持8192及15488张昇腾卡。

马斯克“巨硬计划”(MACROHARD)新动作曝光: 6个月从0建起算力集群,已完成200MW供电规模,足以支持11万台英伟达GB200 GPU NVL72。仅用6个时间,完成了OpenAI和甲骨文等合作花费15个月完成的工作,再次创造纪录。

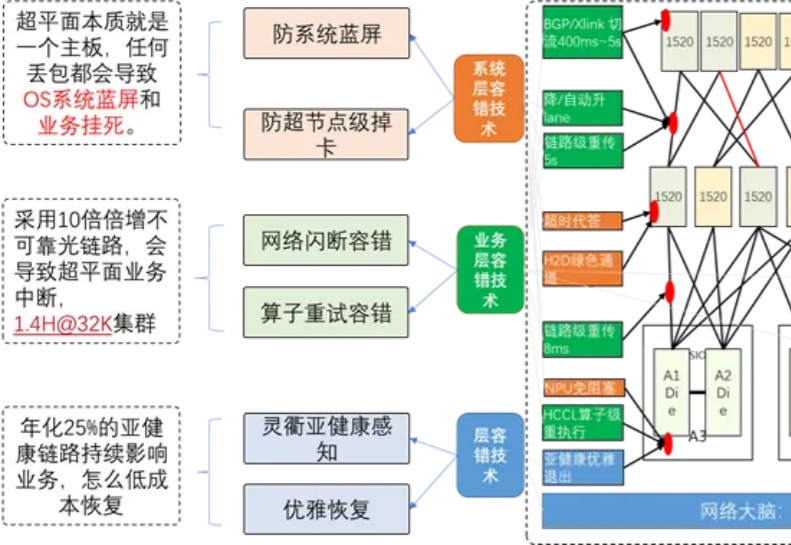

大模型的落地能力,核心在于性能的稳定输出,而性能稳定的底层支撑,是强大的算力集群。其中,构建万卡级算力集群,已成为全球公认的顶尖技术挑战。

你是否注意到,现在的 AI 越来越 "聪明" 了?能写小说、做翻译、甚至帮医生看 CT 片,这些能力背后离不开一个默默工作的 "超级大脑工厂"——AI 算力集群。

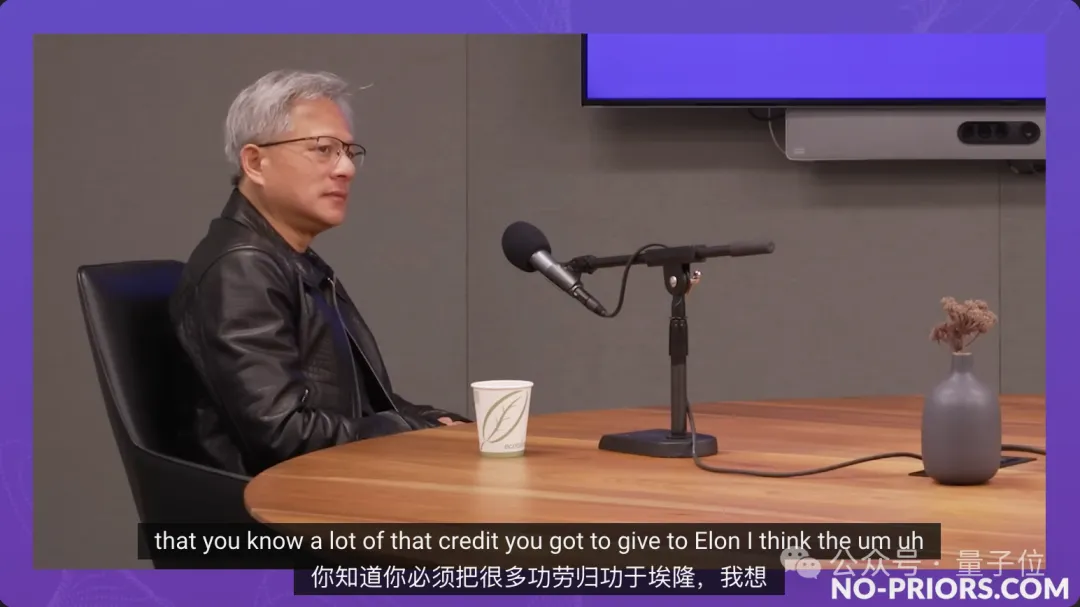

英伟达市值重回第一之际,黄仁勋再次接受采访。 除了谈自己和英伟达,还吹了一波马斯克,再再再次赞赏xAI只花19天建起10万卡H100超级集群。

传统计算架构的潜力开发已接近极限 要实现超强的AI能力,需要超大规模的模型,要训练超大规模的AI模型,需要数千,甚至上万的GPU协同工作。

埃隆·马斯克掌控的那几家公司——包括SpaceX、特斯拉、xAI乃至X(原Twitter)——都需要大量的GPU,而且也都是为自己的特定AI或者高性能计算(HPC)项目服务。

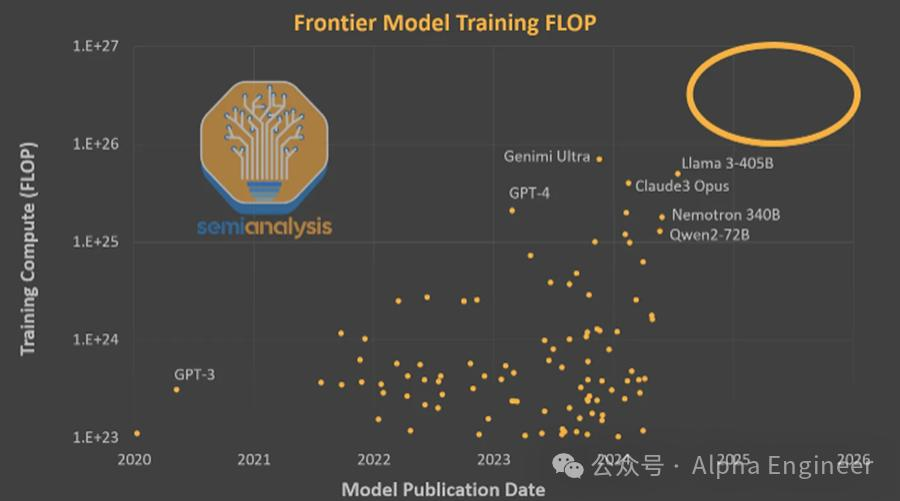

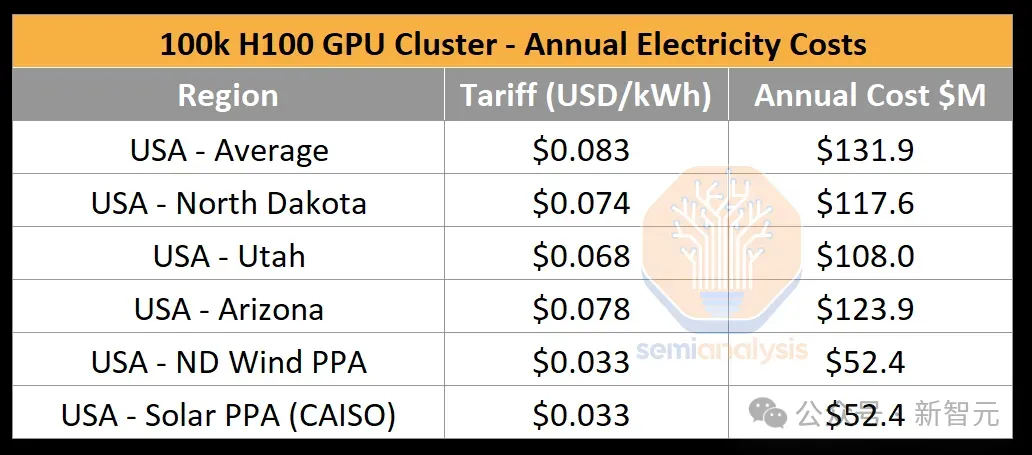

10万张H100卡构成的超级AI算力集群就像是现代人类文明的奇观,是人类通向AGI的钥匙。AI时代的军备竞赛已经拉开帷幕,赌注是天量的Capex支出,胜者则有机会成为AI时代的造物主。

在英伟达市值猛涨、各家科技巨头囤芯片的热潮中,我们往往会忽视GPU芯片是如何转变为数据中心算力的。最近,一篇SemiAnalysis的技术文章就深入解读了10万卡H100集群的构建过程。