Llama 4重测竞技场排名大跳水,网友:社区很难再信任Meta了

Llama 4重测竞技场排名大跳水,网友:社区很难再信任Meta了Llama 4被曝在大模型竞技场作弊后,重新上架了非特供版模型。但是你很可能没发现它。因为排名一下子从第2掉到了第32,要往下翻好久才能看到。

Llama 4被曝在大模型竞技场作弊后,重新上架了非特供版模型。但是你很可能没发现它。因为排名一下子从第2掉到了第32,要往下翻好久才能看到。

刚刚,一位AI公司CEO细细扒皮了关于Llama 4的五大疑点。甚至有圈内人表示,Llama 4证明Scaling已经结束了,LLM并不能可靠推理。但更可怕的事,就是全球的AI进步恐将彻底停滞。

Llama 4真要被锤爆了,这次是大模型竞技场(Chatbot Arena)官方亲自下场开怼:

大家翘首以盼的 Llama 4,用起来为什么那么拉跨?

Meta最新基础模型Llama 4发布36小时后,评论区居然是这个画风:

Llama 4本该是AI圈的焦点,却成了大型翻车现场。开源首日,全网实测代码能力崩盘。更让人震惊的是,模型训练测试集被曝作弊,内部员工直接请辞。

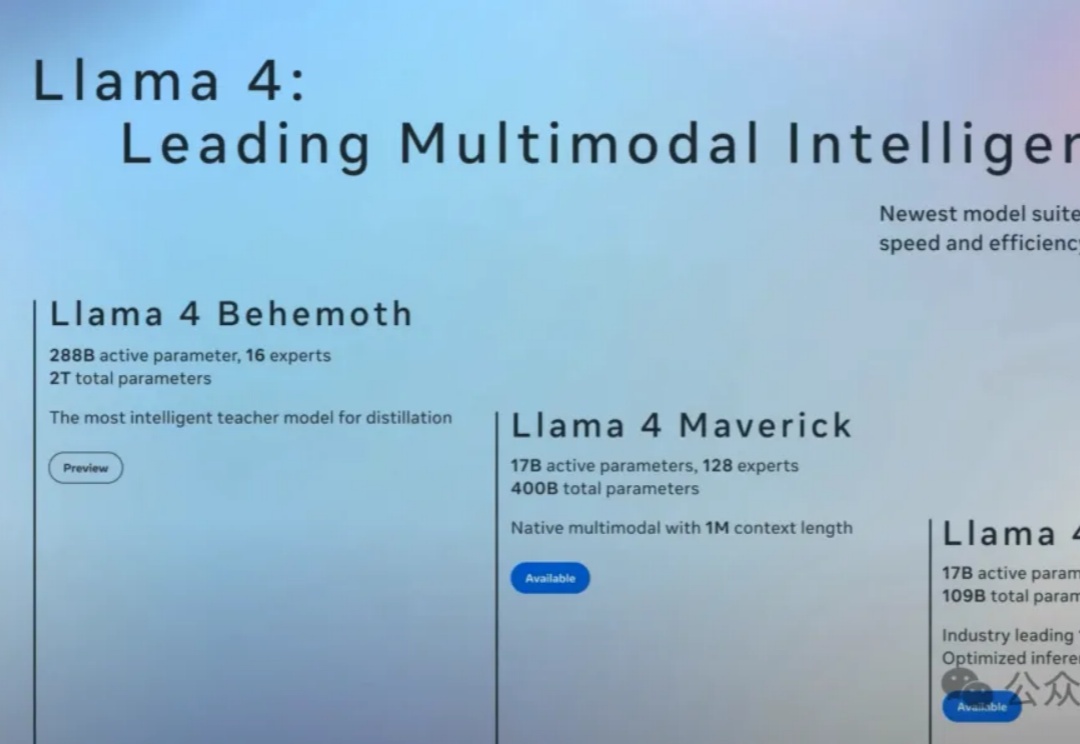

Llama 4家族周末突袭,实属意外。这场AI领域的「闪电战」不仅带来了两款全新架构的开源模型,更揭示了一个惊人事实:苹果Mac设备或将成为部署大型AI模型的「性价比之王」。

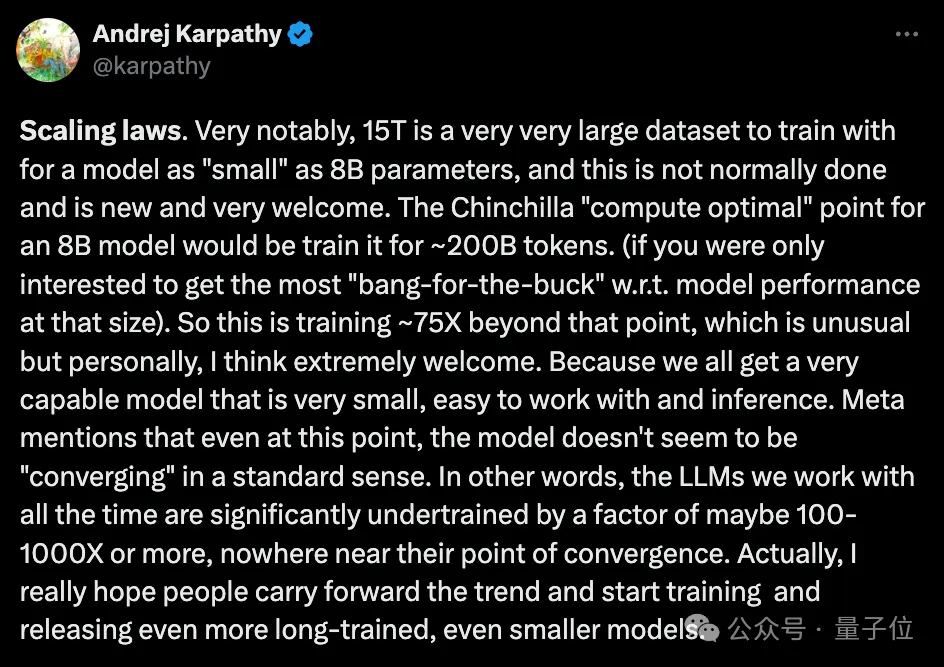

大模型力大砖飞,让LLaMA3演绎出了新高度: 超15T Token数据上的超大规模预训练,既实现了令人印象深刻的性能提升,也因远超Chinchilla推荐量再次引爆开源社区讨论。

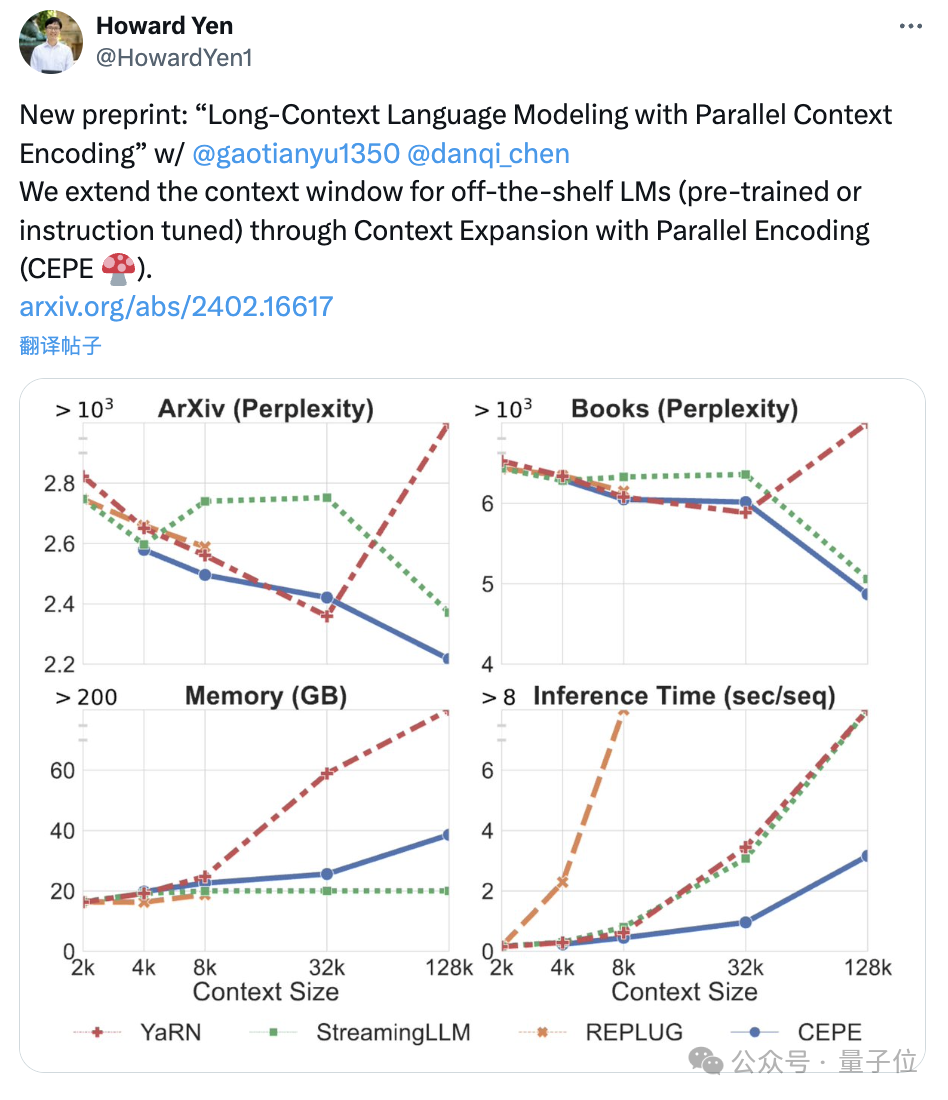

陈丹琦团队刚刚发布了一种新的LLM上下文窗口扩展方法:它仅用8k大小的token文档进行训练,就能将Llama-2窗口扩展至128k。

在图像理解领域,多模态大模型已经充分展示了其卓越的性能。然而,对于工作中经常需要处理的图表理解与生成任务,现有的多模态模型仍有进步的空间。