OpenAI的吉卜力,撞车了被字节起诉“投毒AI”的前实习生?

OpenAI的吉卜力,撞车了被字节起诉“投毒AI”的前实习生?想象一下,耗费动画大师宫崎骏数十年心血、一帧一画精雕细琢的艺术风格——比如《起风了》中耗时一年多的四秒人群场景,或是《幽灵公主》里那个生物钻地镜头背后一年零七个月的 5300 帧手绘,如今,在GPT-4o手中,似乎变得“唾手可得”。

想象一下,耗费动画大师宫崎骏数十年心血、一帧一画精雕细琢的艺术风格——比如《起风了》中耗时一年多的四秒人群场景,或是《幽灵公主》里那个生物钻地镜头背后一年零七个月的 5300 帧手绘,如今,在GPT-4o手中,似乎变得“唾手可得”。

视觉Token可以与LLMs词表无缝对齐了!

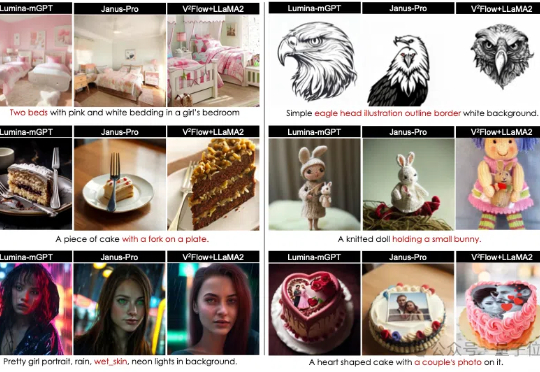

在三维数字内容生产领域,三角形网格作为核心的几何表示形式,其质量直接影响虚拟资产在影视、游戏和工业设计等应用场景中的表现与效率。

它名为 Uni-3DAR,来自深势科技、北京科学智能研究院及北京大学,是一个通过自回归下一 token 预测任务将 3D 结构的生成与理解统一起来的框架。据了解,Uni-3DAR 是世界首个此类科学大模型。并且其作者阵容非常强大,包括了深势科技 AI 算法负责人柯国霖、中国科学院院士鄂维南、深势科技创始人兼首席科学家和北京科学智能研究院院长张林峰等。

从微观世界的分子与材料结构、到宏观世界的几何与空间智能,创建和理解 3D 结构是推进科学研究的重要基石。3D 结构不仅承载着丰富的物理与化学信息,也可为科学家提供解构复杂系统、进行模拟预测和跨学科创新的重要工具。

块离散去噪扩散语言模型(BD3-LMs)结合自回归模型和扩散模型的优势,解决了现有扩散模型生成长度受限、推理效率低和生成质量低的问题。通过块状扩散实现任意长度生成,利用键值缓存提升效率,并通过优化噪声调度降低训练方差,达到扩散模型中最高的预测准确性,同时生成效率和质量优于其他扩散模型。

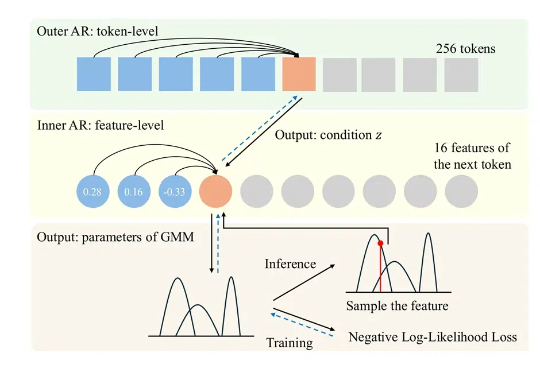

澳大利亚国立大学团队提出了ARINAR模型,与何凯明团队此前提出的分形生成模型类似,采用双层自回归结构逐特征生成图像,显著提升了生成质量和速度,性能超越了FractalMAR模型,论文和代码已公开。

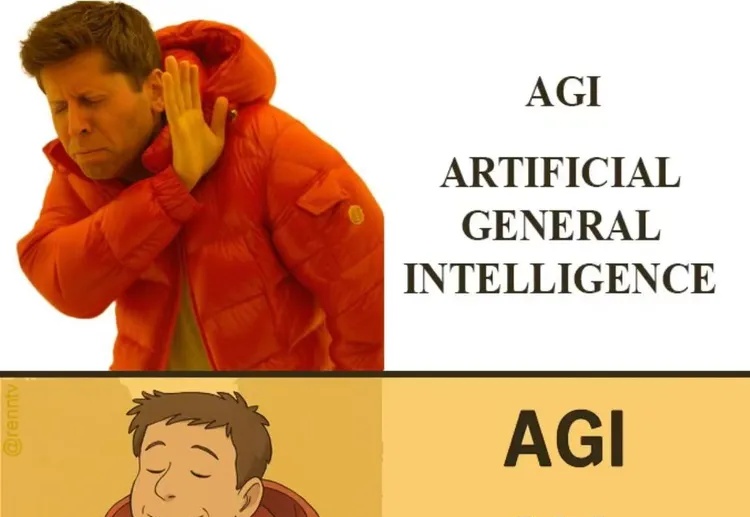

文本到图像(Text-to-Image, T2I)生成任务近年来取得了飞速进展,其中以扩散模型(如 Stable Diffusion、DiT 等)和自回归(AR)模型为代表的方法取得了显著成果。然而,这些主流的生成模型通常依赖于超大规模的数据集和巨大的参数量,导致计算成本高昂、落地困难,难以高效地应用于实际生产环境。

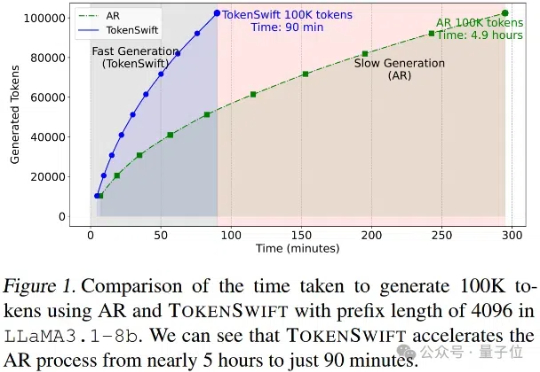

大语言模型长序列文本生成效率新突破——生成10万Token的文本,传统自回归模型需要近5个小时,现在仅需90分钟!

2025年2月27日,由前扩散模型领域顶尖研究者创立的Inception Labs正式发布了全球首个商业级扩散大语言模型(dLLM)——“Mercury”。这一里程碑式产品不仅在生成速度、硬件效率和成本控制上实现突破,更标志着自然语言处理技术从自回归(Autoregressive)范式向扩散(Diffusion)范式的重大跃迁。