Meta没做的,英伟达做了!全新架构吞吐量狂飙6倍,20万亿Token训练

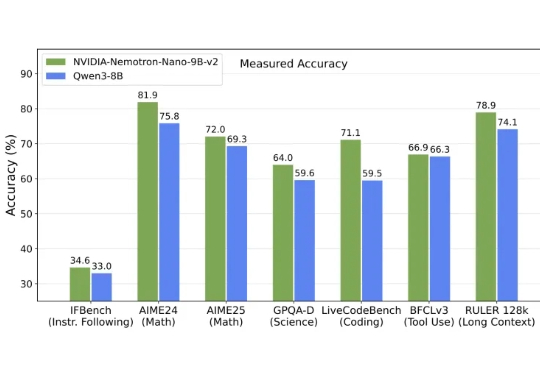

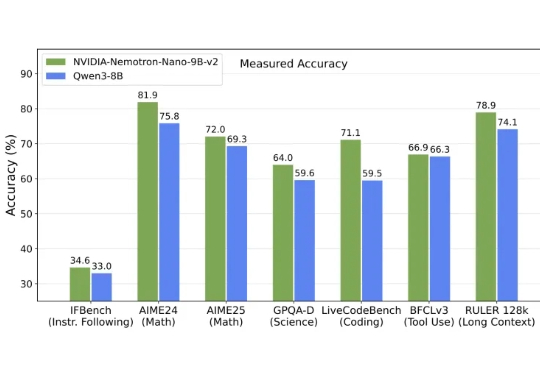

Meta没做的,英伟达做了!全新架构吞吐量狂飙6倍,20万亿Token训练英伟达发布全新架构9B模型,以Mamba-Transformer混合架构实现推理吞吐量最高提升6倍,对标Qwen3-8B并在数学、代码、推理与长上下文任务中表现持平或更优。

英伟达发布全新架构9B模型,以Mamba-Transformer混合架构实现推理吞吐量最高提升6倍,对标Qwen3-8B并在数学、代码、推理与长上下文任务中表现持平或更优。

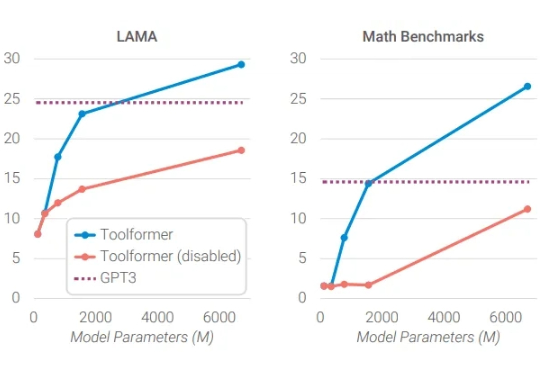

大模型OUT,小模型才是智能体的未来! 这可不是标题党,而是英伟达最新论文观点: 在Agent任务中,大语言模型经常处理重复、专业化的子任务,这让它们消耗大量计算资源,且成本高、效率低、灵活性差。

中国HBM技术代差从8年缩至4年,长鑫存储提前量产HBM2并推进HBM3。三大存储巨头转向定制化HBM4,英伟达将自研基础裸片。国产化仍面临EUV光刻与生态闭环挑战,缓存卸载方案可缓解存储压力。

加拿大AI新贵Cohere获5亿美元融资、估值68亿美元,前Meta FAIR副总裁、PyTorch与Llama重要推手Joelle Pineau加盟出任首席AI官,或将开启企业AI新战局。

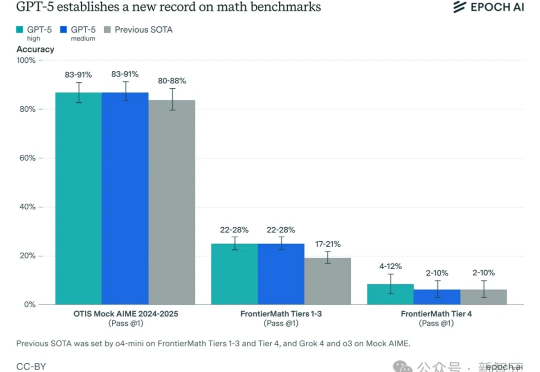

GPT-5来了!智商148、数学纪录被刷新、英伟达点头认可,但OpenAI真正的杀手锏,不在智商,而在分配智商的「路由器」。

老黄看好机器人,还真不是嘴上说说! 这不,就在正在举办的SIGGRAPH(计算机图形学)大会上,英伟达为机器人带来了全新升级的Cosmos世界模型。

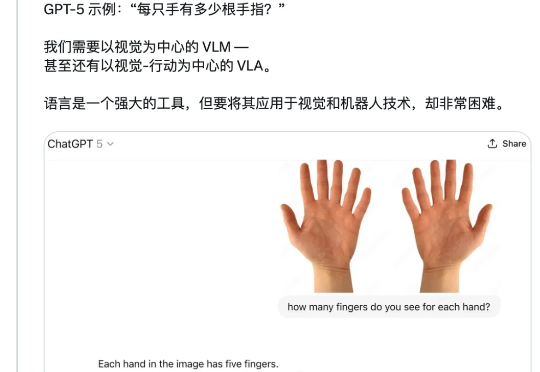

「一只手有几根手指?」 这个看似简单的问题,强如 GPT-5 却并不能总是答对。 今天,CMU 博士生、英伟达 GEAR(通用具身智能体研究)团队成员 Tairan He(何泰然)向 GPT-5 询问了这个问题,结果模型回答错了。

黄仁勋正在像押注OpenAI一样在中国押注未来的具身智能巨头。 英伟达给刚创办的OpenAI送超算这个事已经被大家津津乐道,现在他们正在把这个经验复用到机器人领域。

最近往返中美频繁发声的黄仁勋,是把英伟达打造成 4 万亿帝国的「AI教父」,今天 The Information 曝光了一个老黄布局多年的秘密。

特斯拉Dojo超级计算机团队被解散!特斯拉自动驾驶的「算力心脏」Dojo已被终止。马斯克放弃训练算力,而核心团队另立山头。