全程回顾|英伟达GTC大会黄仁勋主题演讲:6G革命、量子突破

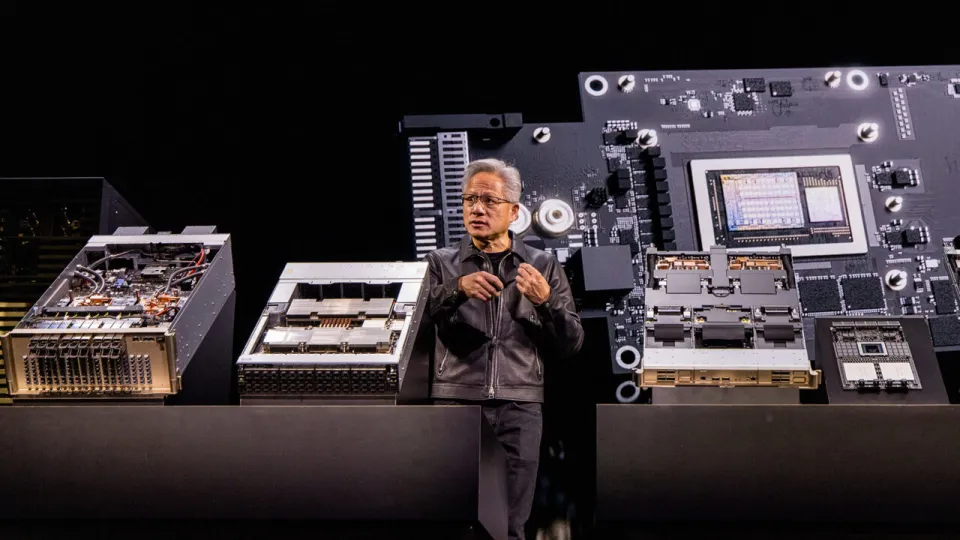

2025年10月29日凌晨,英伟达创始人兼CEO黄仁勋在华盛顿举行的GTC华盛顿特区技术峰会上发表重磅演讲。

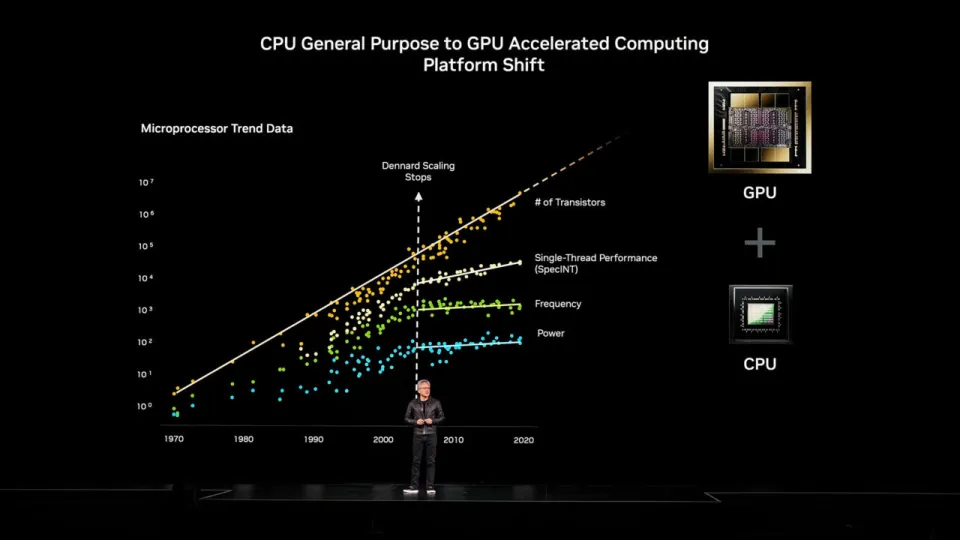

黄仁勋开场便直指核心冲突:在“摩尔定律”失效、计算性能增长陷入停滞的当下,英伟达正是那个拯救未来计算的“救世主”。他们用并行计算和GPU加速,将“算力”这条生命线,从传统的CPU桎梏中彻底解放出来。

黄仁勋在演讲中回顾了计算产业的历史性转折。数十年来,CPU性能始终遵循着可预测的规模增长轨迹,然而随着登纳德缩放定律(Dennard scaling)走向终结——该定律认为通过不断缩小晶体管尺寸来维持功率密度,可以降低功耗并提升性能,传统发展路径已难以为继。

面对这些挑战,英伟达给出的答案是:并行计算、GPU和加速计算架构。

黄仁勋宣称:“这一转折点已经到来,英伟达已做好准备。我们认识到,通过引入能够充分利用指数级增长晶体管的处理器,运用并行计算技术,再与顺序处理的CPU协同工作,就能将计算能力推向一个全新维度——这个时代确实已经来临。”

加速计算的实现,离不开英伟达精心构建的软件基石——CUDA-X全栈加速库:覆盖了从深度学习领域的cuDNN与TensorRT-LLM,数据科学平台RAPIDS (cuDF/cuML),到决策优化工具cuOpt、计算光刻解决方案cuLitho,以及量子与混合计算框架CUDA-Q与cuQuantum等关键领域。

黄仁勋将这个完整的软件生态系统誉为“公司最珍贵的宝藏”,它构成了英伟达加速计算战略的技术核心,为各行业的计算变革提供着底层动力。

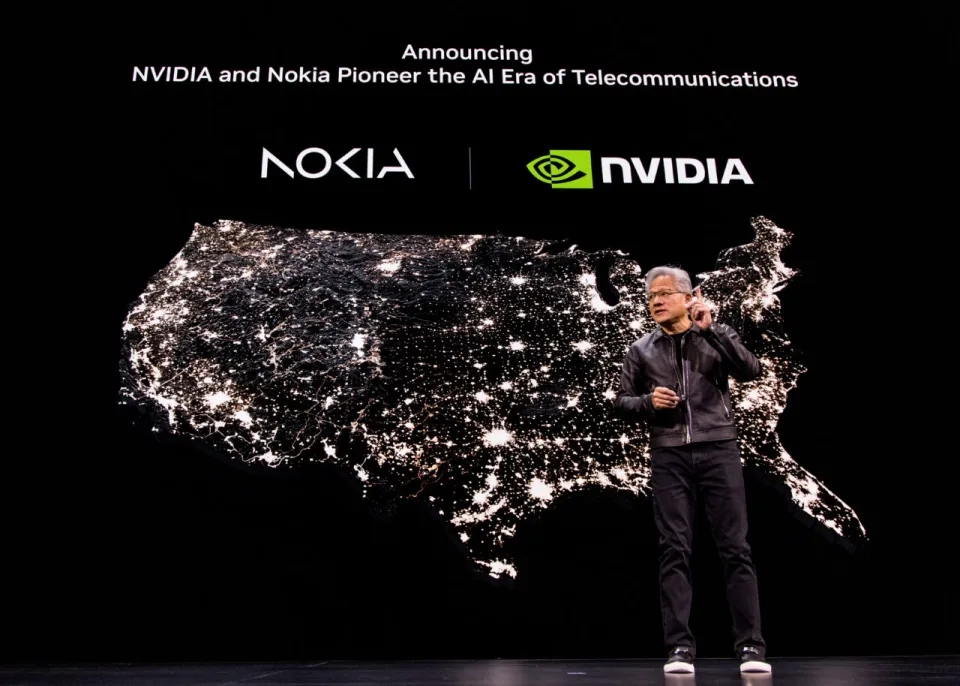

黄仁勋在演讲中将目光投向了国家安全和经济命脉。他强调,电信技术是经济和国家安全的生命线,但目前全球无线技术部署大多依赖于其他国家的技术体系。

黄仁勋表示:“这种核心通信技术受制于人的局面必须终结,而现在我们迎来了扭转局面的历史性机遇”。

为实现这一战略目标,英伟达推出了颠覆性的NVIDIA ARC——AI原生6G无线技术栈。该平台基于英伟达Aerial平台构建,融合了Grace CPU、Blackwell GPU及先进网络组件,通过加速计算实现性能突破。

据黄仁勋透露,英伟达已经与通信设备巨头诺基亚达成深度战略合作。诺基亚将在其未来基站系统中集成NVIDIA ARC解决方案,该平台将赋能机器人精准操控与高精度气象预测等关键应用。

另据英伟达官方博文显示,该公司计划将其商用级AI-RAN产品整合至诺基亚领先的无线接入网(RAN)组合中,使通信服务商能够在英伟达平台上部署AI原生的5G-Advanced和6G网络。作为合作的一部分,英伟达将以每股6.01欧元的价格认购1.664亿股诺基亚新股,投资总额达10亿美元。

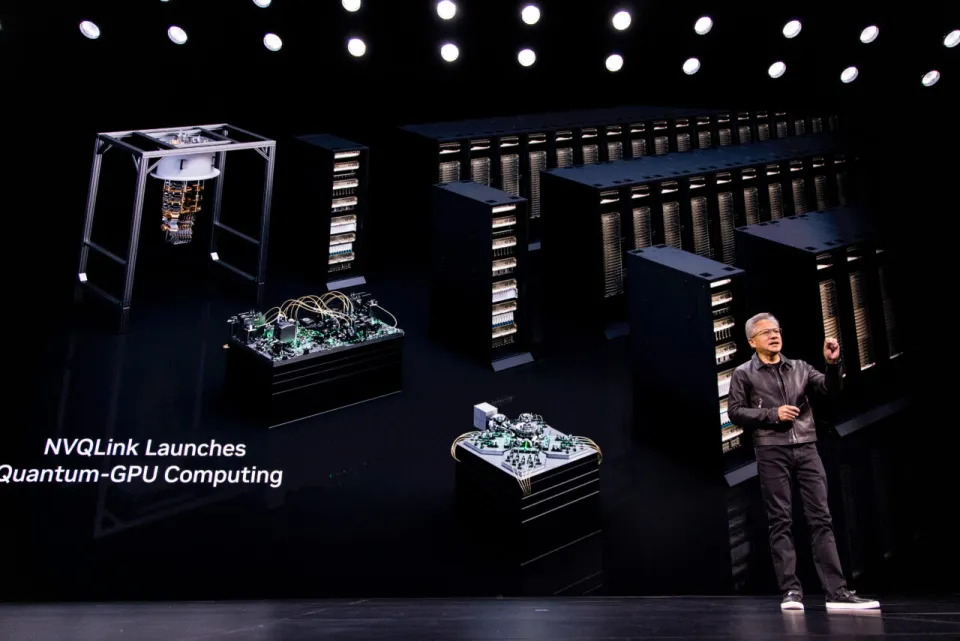

在探讨计算科学前沿时,黄仁勋回顾了量子物理学家理查德·费曼四十年前的设想:创造能够直接模拟自然规律的量子计算机。

“如今我们已能够制备稳定、相干且具备纠错能力的逻辑量子比特,”黄仁勋指出,“但这些量子比特极其脆弱,需要强大的技术支持量子纠错和状态解读。”

为实现量子计算与GPU计算的无缝融合,英伟达推出了量子-GPU互联技术NVQLink。这项创新使量子处理单元能够实时调用CUDA-Q计算框架,将通信延迟降至约4微秒的极致水平。

在现场演示环节,黄仁勋身后的大屏幕展示了包括17家量子计算领先企业和多个美国能源部实验室的协同创新网络。“几乎所有的美国能源部下属实验室都在与我们的量子计算生态系统伙伴紧密合作,共同将量子计算融入未来的科学发展蓝图。”

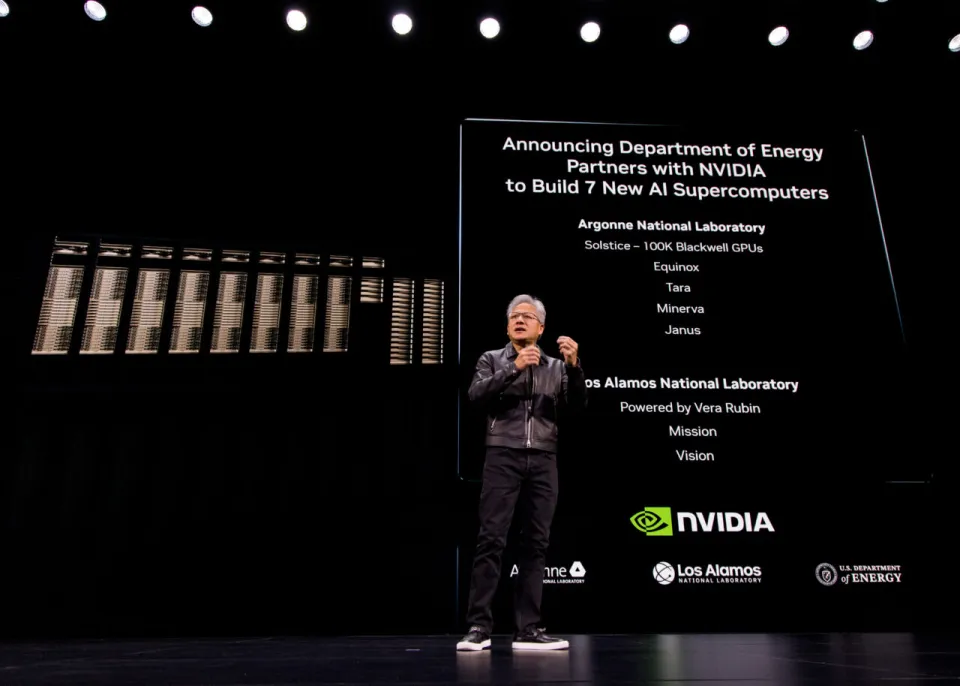

黄仁勋宣布,美国国家实验室正迎来由AI基础设施驱动的全新科研时代。英伟达与美国能源部(DOE)达成战略合作,将共同建设七台新一代超级计算机,为未来科学研究提供强大算力支撑。

在具体布局上,英伟达联合美国能源部及甲骨文公司,将在阿贡国家实验室打造能源部体系内规模最大的AI超级计算机集群。

这一超级计算网络包含Solstice和Equinox两大核心系统:

Solstice系统将部署10万颗英伟达Blackwell GPU,建成后将成为全球规模最大、面向公共研究领域的智能体科学平台;

Equinox系统配备1万颗Blackwell GPU,提供高达2,200 EFLOPS的AI算力,专门服务于前沿科学计算、模拟仿真与开放研究。

另外,英伟达还宣布与HPE合作,为洛斯阿拉莫斯国家实验室打造两台基于Vera Rubin平台的全新超级计算机,用于国家安全和科学研究

这也是Vera Rubin平台首次将在具体场景中落地,该平台包含Nvidia的下一代Vera CPU和Rubin GPU。这些机器将使用NVLink Gen6技术进行扩展,并采用QuantumX 800 Infiniband网络进行扩展。

在产业布局方面,黄仁勋透露重要进展:Blackwell GPU已在美国亚利桑那州实现规模化生产,基于该芯片的整机系统也将在美国完成组装。

这一举措,标志着英伟达成功将旗舰产品的制造环节从完全依赖台积电代工,转向美国本土供应链体系。

值得注意的是,本次大会的诸多公告都具有明确政策导向。英伟达通过展示其在美国科技生态中的核心地位,向政策制定者传递关键信息:对芯片出口的限制将直接损害美国利益。

在市场表现方面,黄仁勋透露GPU需求持续旺盛:过去四个季度英伟达已出货600万颗Blackwell GPU,预计Blackwell与下一代Rubin芯片的总销售额将达到5000亿美元规模。

“AI不是工具,而是生产力主体。”黄仁勋在演讲中提出了这一颠覆性观点,“这是历史上首次,技术具备了执行劳动任务的能力,成为人类生产力的延伸。”

这种从“工具”到“AI劳动者”的根本性转变,正在催生全新的计算范式,并随之孕育出前所未有的职业形态与产业格局。

在黄仁勋的构想中,现代“AI工厂”已远非传统数据中心所能概括,而是专门为海量token的生成、传输与服务构建的全新综合计算平台。这种平台级架构旨在实现前所未有的计算密度与能效比。

面对指数级增长的AI算力需求,黄仁勋详解了英伟达的解决方案:“我们首先重新定义计算机的形态,首次实现单个计算系统扩展至整个机柜规模;继而通过创新的AI以太网技术Spectrum-X,实现多个系统间的无损横向扩展。”

随着AI工厂的兴起,机器人工程、量子科学等新兴领域正在创造大量前所未有的就业机会。“创新飞轮已经启动,”黄仁勋强调,“接下来的关键是将运营成本大幅降低,既优化用户体验,又通过成本控制维持这一创新循环的持续运转。”

实现这一愿景的关键在于“极致协同设计”(Extreme Codesign),即同步设计新的底层计算架构,包括芯片、系统平台、软件栈、AI模型与终端应用。

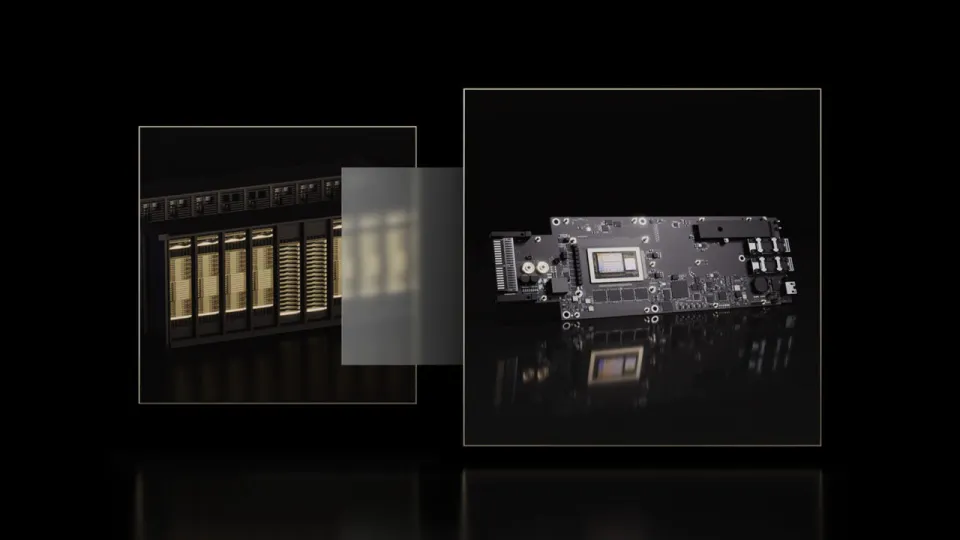

为展示这一理念的实体化成果,黄仁勋在舞台上展示了新一代NVIDIA BlueField-4 DPU。这款集成64核Grace CPU与ConnectX-9网络芯片的数据处理器,计算性能达到前代产品的6倍,将成为未来AI工厂的“操作系统核心”。

这款革命性的DPU专门用于加速服务器的网络、存储与安全任务,计划于2026年率先部署于英伟达Vera Rubin机架级AI平台,随后向更广泛的服务器生态开放。

为应对超大规模AI部署的挑战,黄仁勋正式发布了Omniverse DSX——一套完整覆盖100兆瓦至数千兆瓦级AI工厂设计与运营的综合解决方案。该蓝图已在弗吉尼亚州AI工厂研究中心完成全面验证。

为了让DSX参考设计更适应不同的数据中心,英伟达提供了两个配置框架:

DSX Boost(内部能效优化):通过智能电力管理与工作负载动态分配,在同等算力输出下降低约30%能耗,或同等电力预算下提升30%GPU密度,实现token生成吞吐量的质的飞跃。

DSX Flex(外部能源整合):将数据中心深度接入区域电网体系,通过智能调度可再生能源与平衡供需关系,有效激活美国电网中约100吉瓦的闲置容量。

Omniverse DSX致力于让新入局者能够快速构建AI工厂。该方案确保英伟达及合作伙伴的硬件在处理器、网络与冷却系统层面实现开箱即用的兼容性,即使缺乏专业经验也能按蓝图部署,最大限度减少定制化需求。

值得关注的是,该架构不仅完美支持当前Blackwell平台,还预留了对下一代Vera Rubin等未来产品的兼容能力,为投资者提供长期技术保障。

黄仁勋在演讲中着重强调了开放生态的核心价值:“开源模型与开放协作是全球创新的基石,为初创企业、科研机构与产业公司提供了持续发展的动力。”

据悉,英伟达本年度已向开发者社区贡献了数百个高质量开放模型与数据集。

英伟达已经构建了覆盖关键领域的开放模型体系:

这些模型家族将共同赋能下一代智能体系统、机器人技术与科学发现。黄仁勋对此强调:“我们持续投入开放生态,因为这是科学研究、创业创新与产业升级的共同需求。”

现场演示的合作伙伴成果展现了英伟达技术的广泛应用场景,涵盖谷歌云、微软Azure、甲骨文等云计算巨头,ServiceNow、SAP等企业服务商,以及Synopsys、Cadence等专业领域领导者。

黄仁勋还宣布了两项战略合作:

与CrowdStrike共建新一代网络安全体系,通过Nemotron模型与NeMo工具链,实现从云端到边缘的“光速级”威胁检测与响应;

同Palantir达成深度技术整合,将加速计算架构、CUDA-X库与开源模型融入Ontology数据平台,实现超大规模数据处理的性能突破。

“物理智能(Physical AI)” 正在推动美国再工业化进程,即通过机器人与智能系统重塑制造、物流及基础设施。黄仁勋在视频中展示了多家合作伙伴如何将这一技术应用于现实生产。

在自动驾驶领域,黄仁勋宣布了一项里程碑式合作:英伟达与Uber正共同构建面向未来的自动驾驶出行平台,计划自2027年起规模化部署约10万辆自动驾驶车辆。

这一雄心勃勃的项目将依托英伟达最新一代DRIVE AGX Hyperion 10平台。

这是英伟达新的L4级自动驾驶平台,配备两颗Thor处理器(每颗约2000 FP4 TFLOPS),传感器套件包含14个摄像头、9个雷达、1个激光雷达和12个超声波传感器,具备安全可靠、弹性扩展和软件定义三大特性。

黄仁勋描绘了这一愿景的实现场景:"未来,用户只需通过手机应用召唤,Hyperion自动驾驶出租车就将如约而至,这套系统将在全球范围内实现人类驾驶员与机器人驾驶员的协同运营。"

除Uber外,Hyperion已获得多家国际汽车制造巨头的采用。Lucid Motors、梅赛德斯-奔驰以及Stellantis集团,都在利用英伟达的平台推进L4级自动驾驶技术落地。

文章来自于“腾讯科技”,作者“金鹿”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md