Light-X来了!全球首个「镜头×光照」双控4D视频生成框架,单目视频秒变电影级

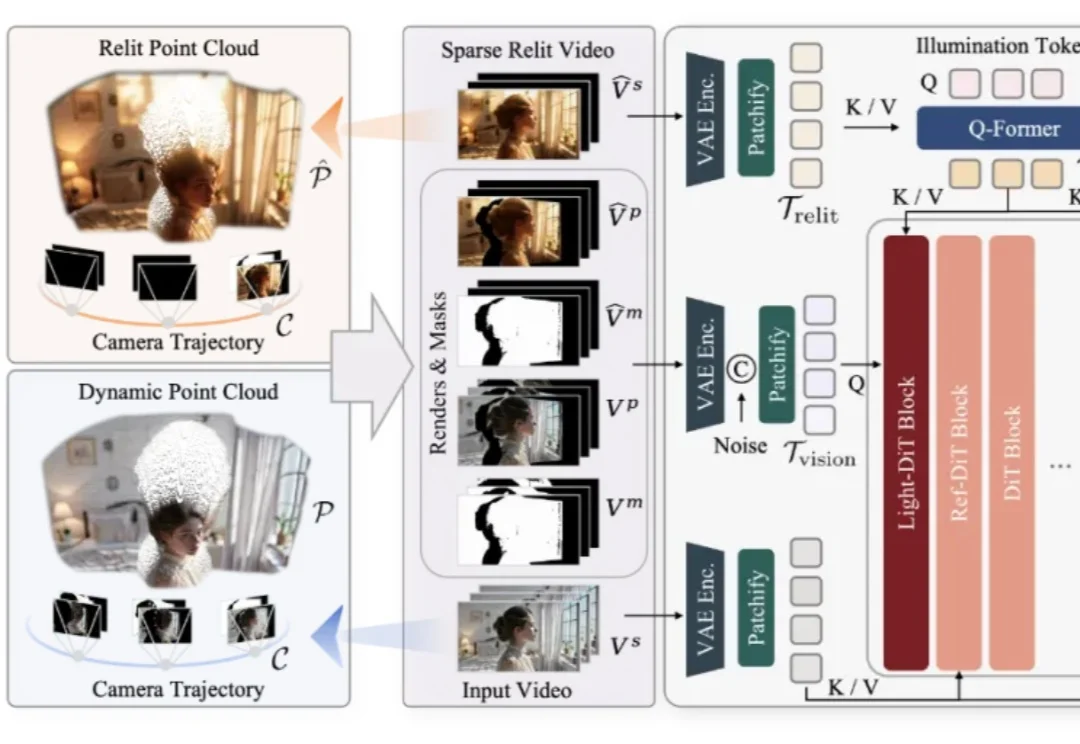

Light-X来了!全球首个「镜头×光照」双控4D视频生成框架,单目视频秒变电影级仅凭一段随手拍摄的单目视频,是否能够让镜头在空间中自由飞行,让光线随意变换,让原本固定的真实场景在全新的视角与照明条件下被再次「拍摄」?这一过去被视作科幻设想的问题,如今迎来了明确答案。

仅凭一段随手拍摄的单目视频,是否能够让镜头在空间中自由飞行,让光线随意变换,让原本固定的真实场景在全新的视角与照明条件下被再次「拍摄」?这一过去被视作科幻设想的问题,如今迎来了明确答案。

视频创作中,你是否曾希望复刻变成 Labubu 的特效,重现吉卜力风格化,跳出短视频平台爆火的同款舞蹈,或模仿复杂有趣的希区柯克运镜?

随手拍的一张图,就能秒变3A级游戏大作?! 刚刚,腾讯全新开源游戏视频生成框架Hunyuan-GameCraft,专为游戏环境设计,让任何人都能轻松搞定游戏制作。

最近,来自大连理工和莫纳什大学的团队提出了物理真实的视频生成框架 VLIPP。通过利用视觉语言模型来将物理规律注入到视频扩散模型的方法来提升视频生成中的物理真实性。

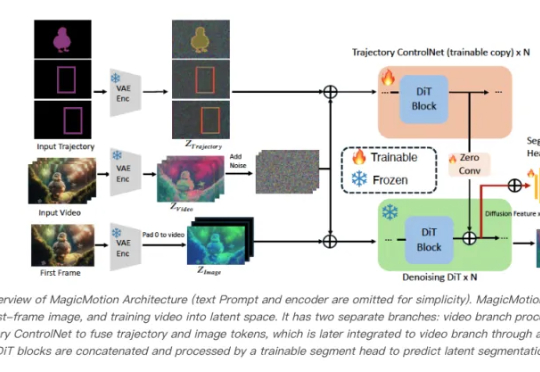

轨迹可控的视频生成来了,支持三种不同级别的轨迹控制条件——分别为掩码、边界框和稀疏框。研究人员提出了MagicMotion,一种创新的图像到视频生成框架,共同第一作者为复旦大学研究生李全昊、邢桢,通讯作者为复旦大学吴祖煊副教授。

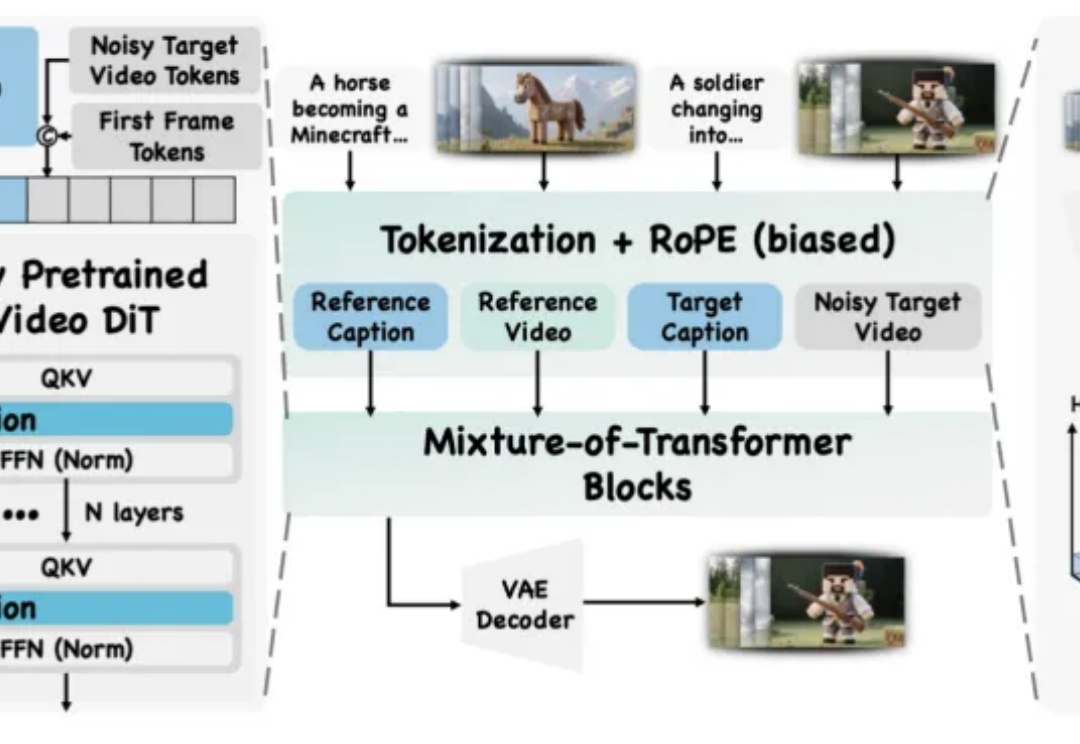

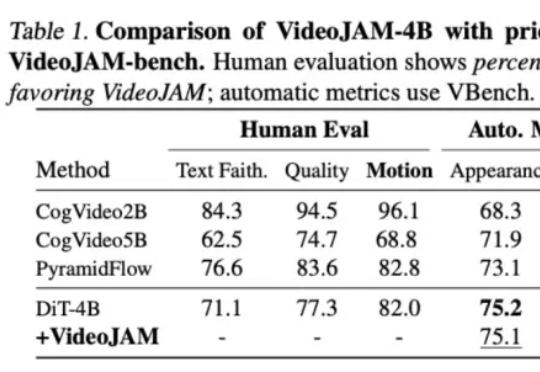

针对视频生成中的运动一致性难题,Meta GenAI团队提出了一个全新框架VideoJAM。VideoJAM基于主流的DiT路线,但和Sora等纯DiT模型相比,动态效果直接拉满:

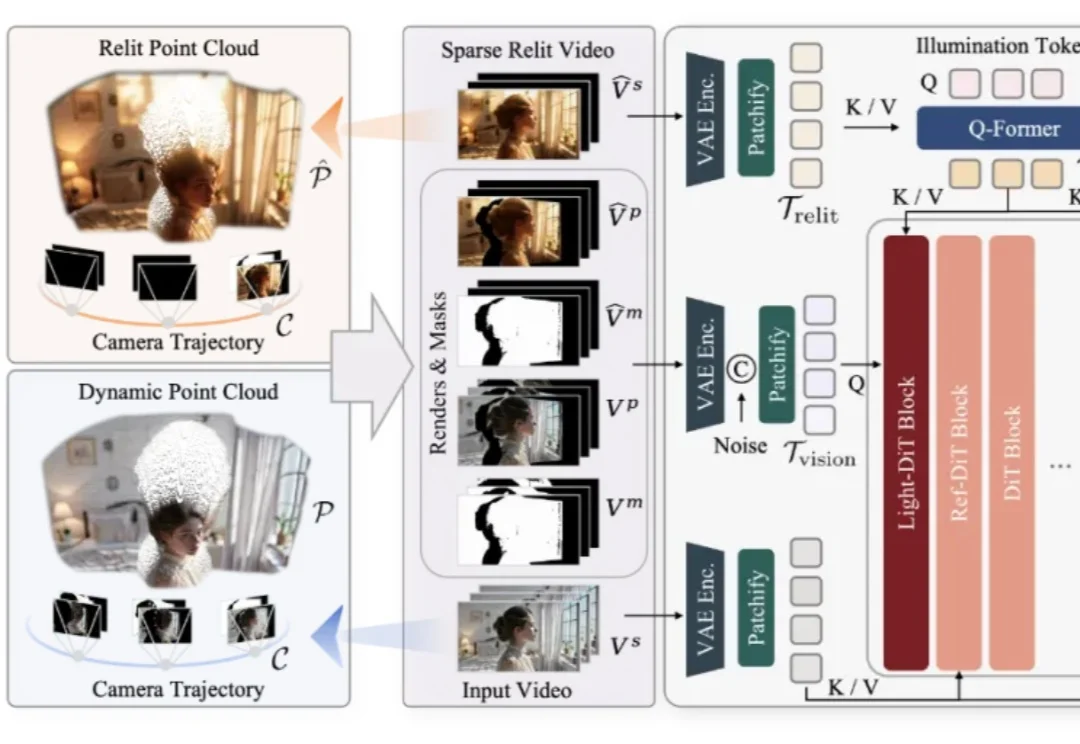

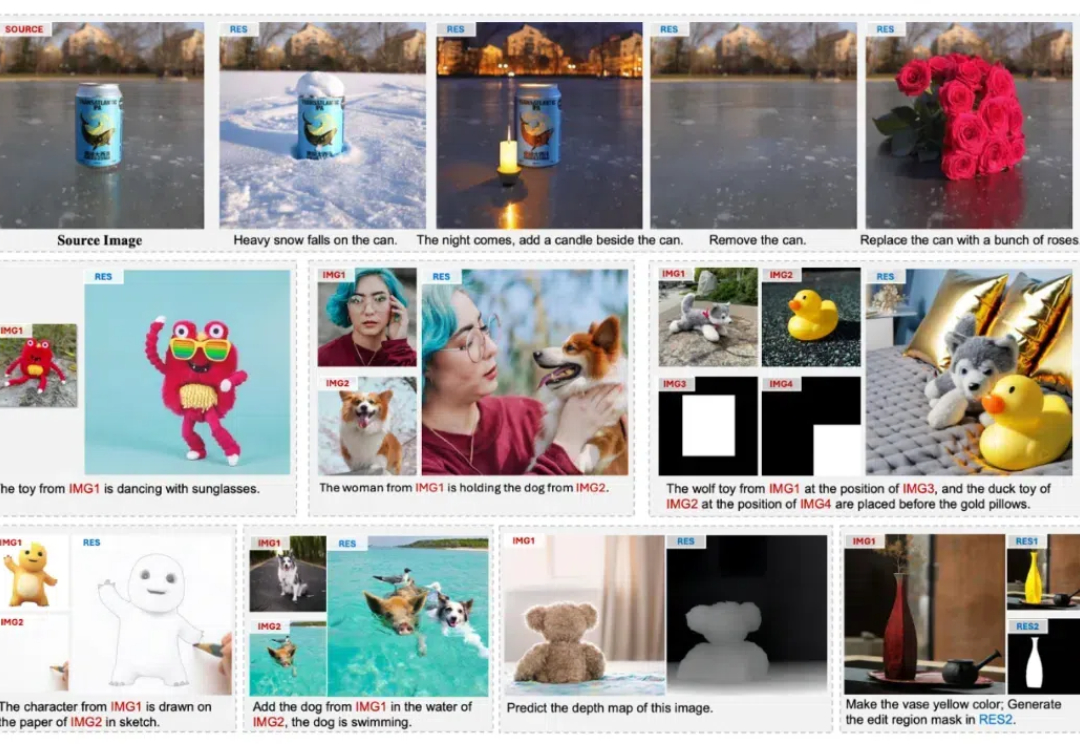

本文中,香港大学与 Adobe 联合提出名为 UniReal 的全新图像编辑与生成范式。该方法将多种图像任务统一到视频生成框架中,通过将不同类别和数量的输入/输出图像建模为视频帧,从大规模真实视频数据中学习属性、姿态、光照等多种变化规律,从而实现高保真的生成效果。

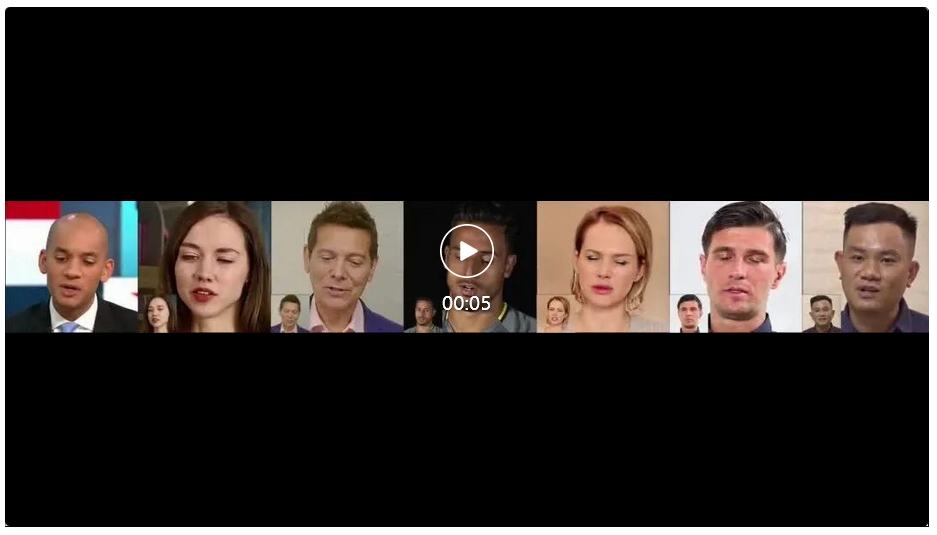

近日,快手可灵大模型团队开源了名为LivePortrait的可控人像视频生成框架,该框架能够准确、实时地将驱动视频的表情、姿态迁移到静态或动态人像视频上,生成极具表现力的视频结果。

日前,旷视科技发布了一项新的开源 AI 人像视频生成框架 ——MegActor。基于该框架,用户只需输入一张静态的肖像图片,以及一段视频(演讲、表情包、rap)文件,即可生成一段表情丰富、动作一致的 AI 人像视频。

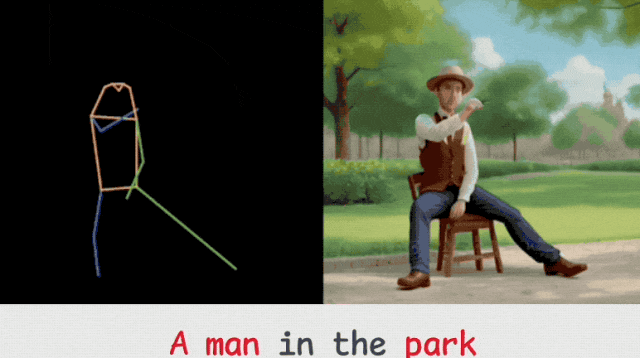

视频生成还可以这么玩?来一个“火柴人”做做动作示范,再加文本描述,即可让各种形象惟妙惟肖地跟着动起来。