10倍吞吐提升无损性能:多模态适用的KV cache量化策略来了,即插即用无需改原模型

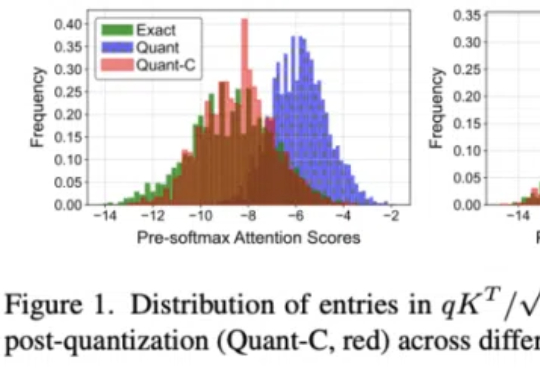

10倍吞吐提升无损性能:多模态适用的KV cache量化策略来了,即插即用无需改原模型在InternVL-2.5上实现10倍吞吐量提升,模型性能几乎无损失。

在InternVL-2.5上实现10倍吞吐量提升,模型性能几乎无损失。

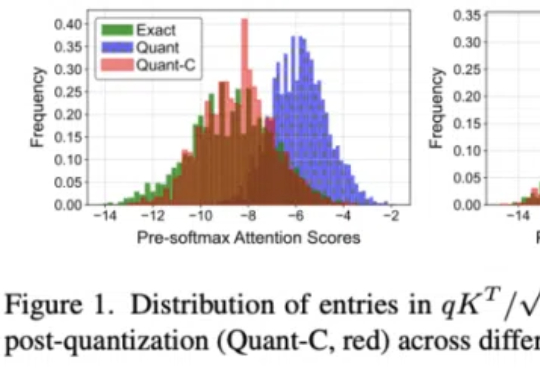

视觉Token可以与LLMs词表无缝对齐了!

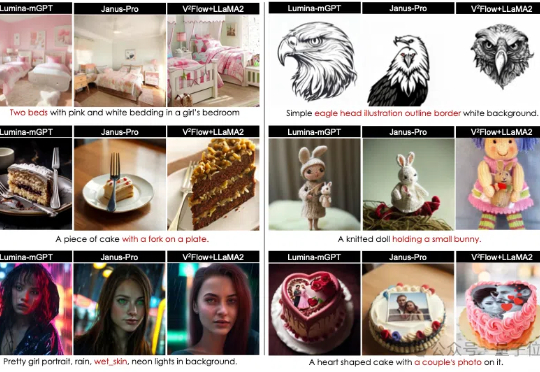

随着人工智能和大语言模型(LLMs)的不断突破,如何将其优势赋能于现实世界中可实际部署的高效工具,成为了业界关注的焦点。

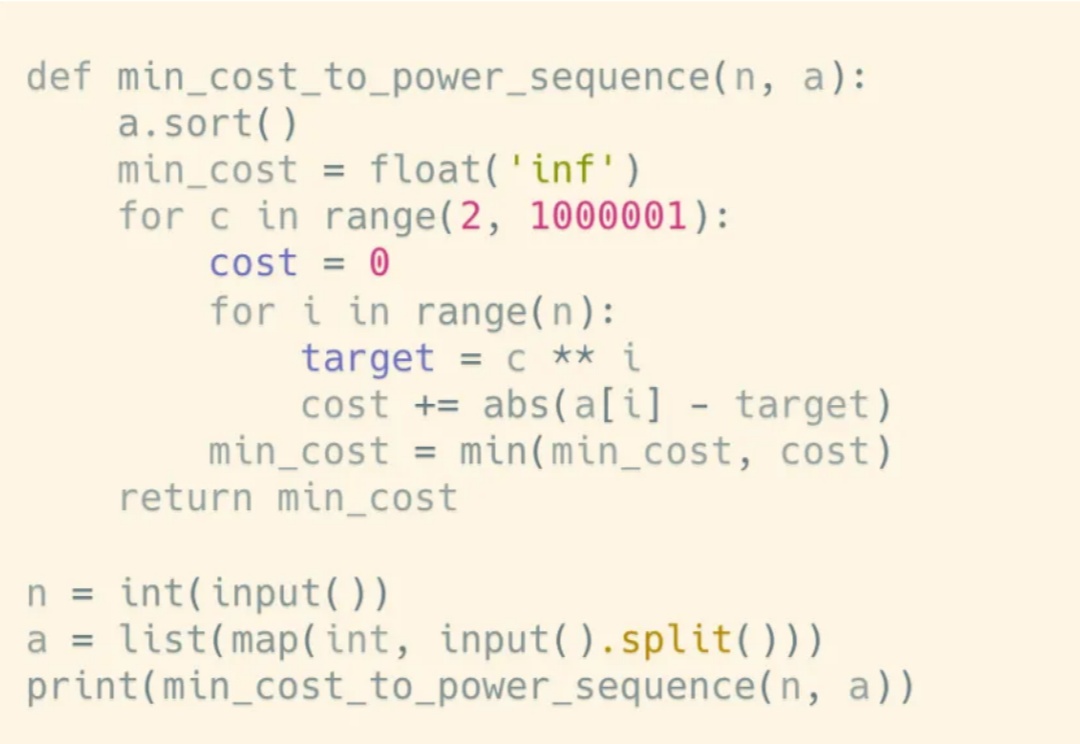

大模型写代码早就是基操了,但让它写算法竞赛题或企业级系统代码,就像让只会煮泡面的人去做满汉全席 —— 生成的代码要么是 “铁板一块” 毫无章法,要么是 “一锅乱炖” 难以维护。

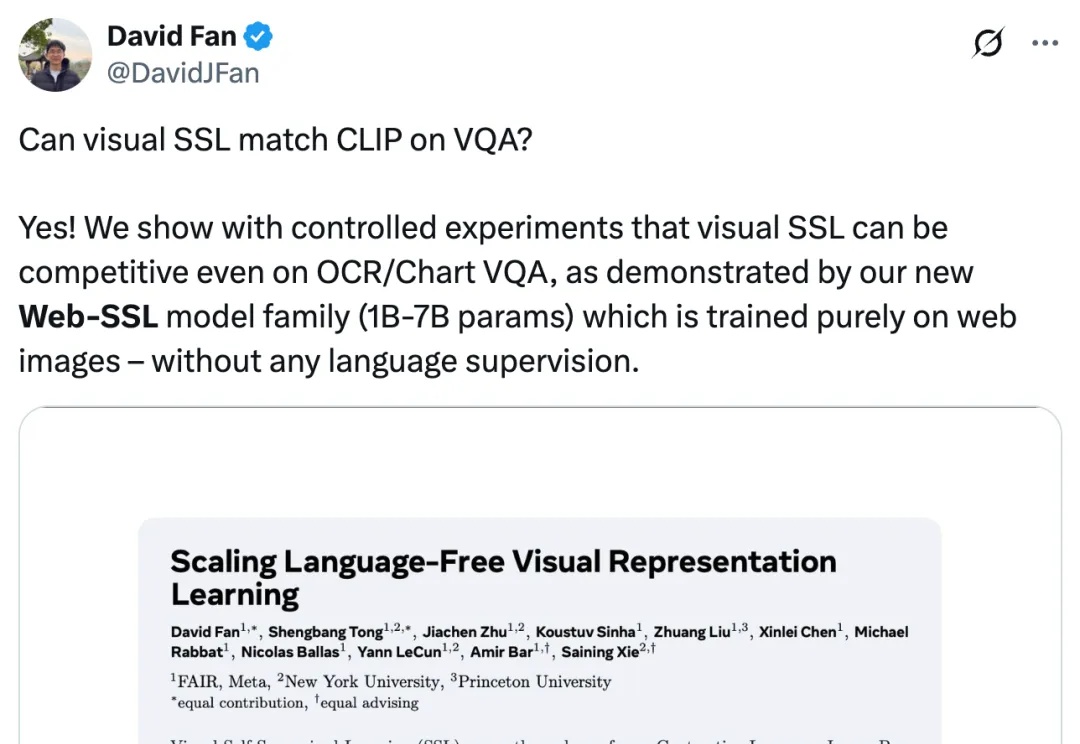

扩展无语言的视觉表征学习。

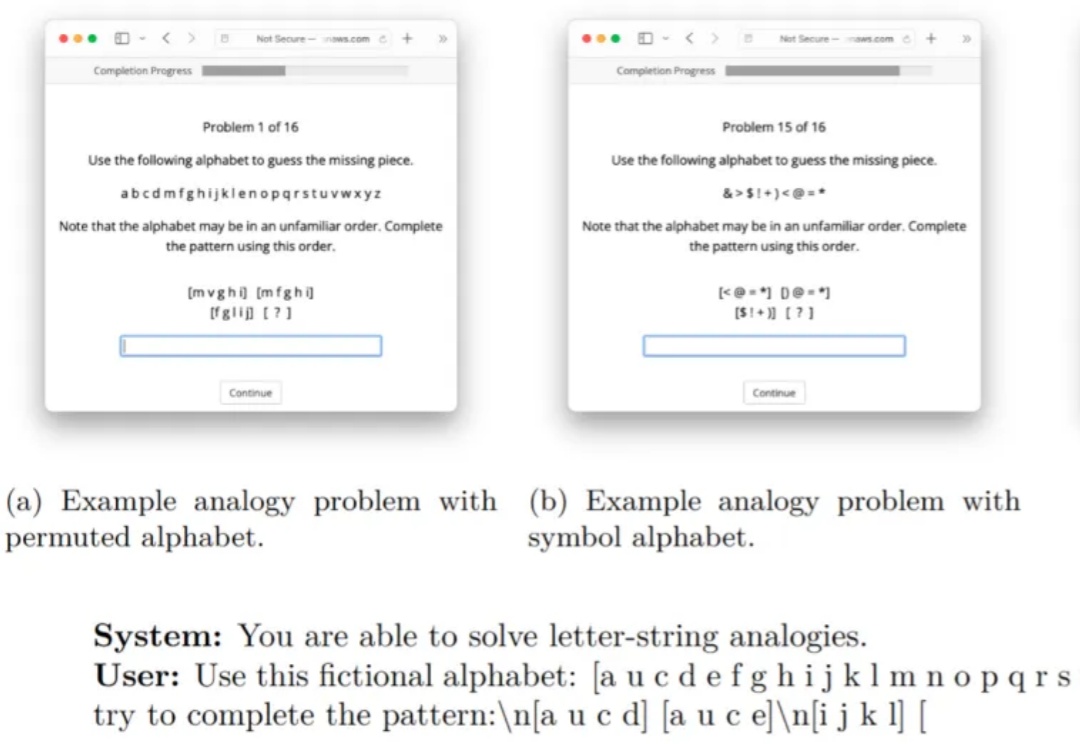

当我们遇到新问题时,往往会通过类比过去的经验来寻找解决方案,大语言模型能否如同人类一样类比?在对大模型的众多批判中,人们常说大模型只是记住了训练数据集中的模式,并没有进行真正的推理。

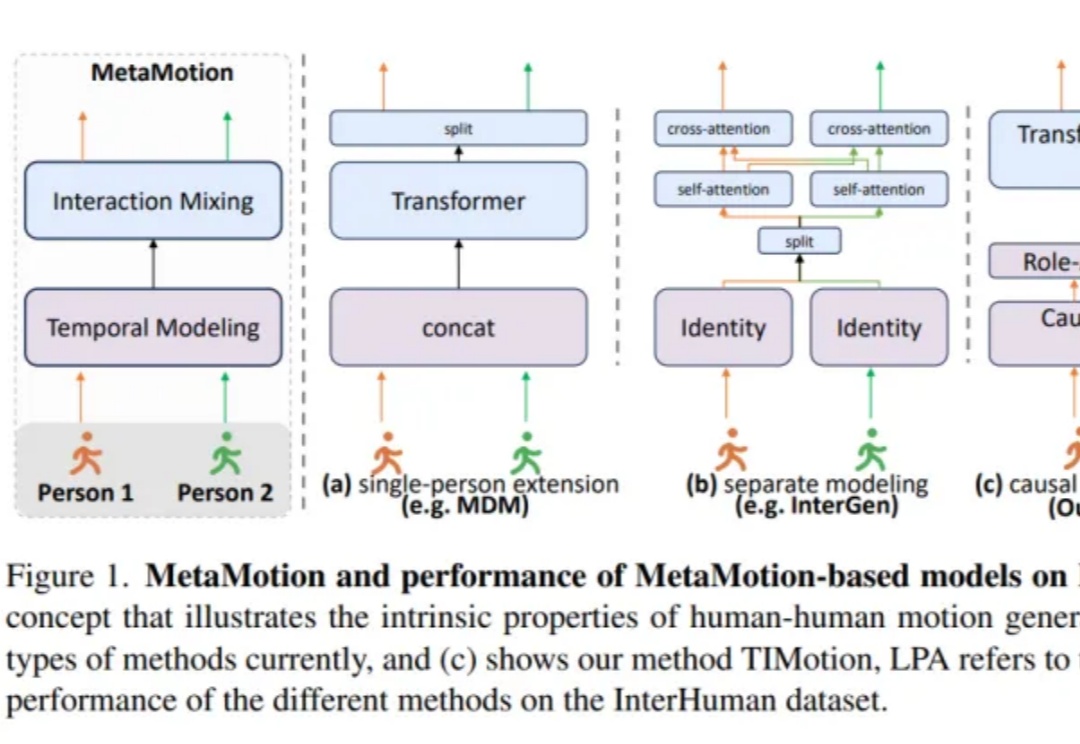

双人动作生成新SOTA!

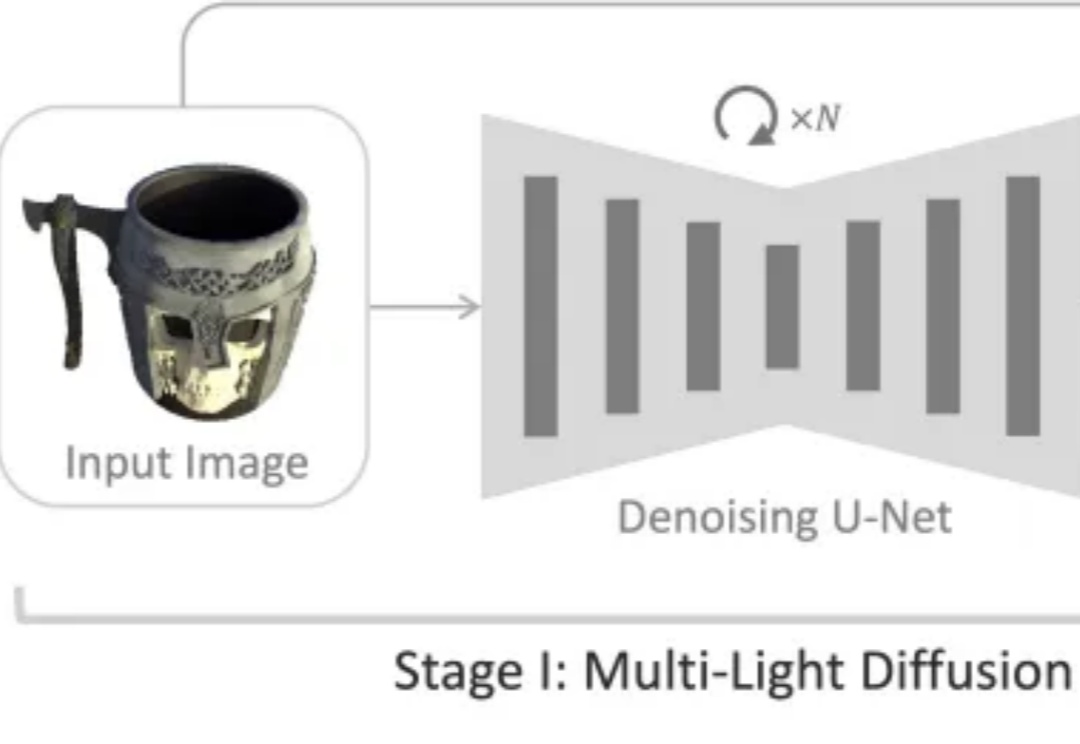

如何从一张普通的单幅图像准确估计物体的三维法线和材质属性,是计算机视觉与图形学领域长期关注的难题。

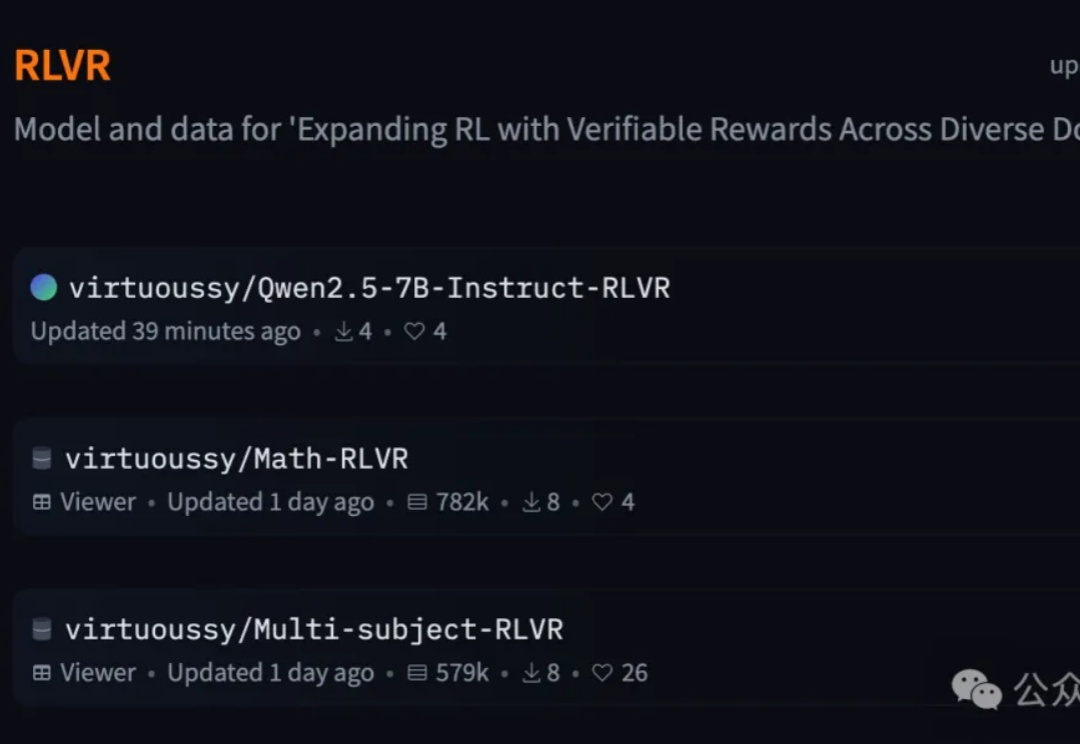

一个7B奖励模型搞定全学科,大模型强化学习不止数学和代码。

“艺术家与人工智能”的张力正在持续紧张。OpenAI虽然声称避免复制“个别在世艺术家的风格”,但它一直在践行并推动政策允许AI对版权内容的训练;而小部分能够承担高昂诉讼成本的艺术家,却也因为版权法灰色地带而面临不确定的局面,更不要说那些不知名的艺术家们了。