CVPR'25跨模态因果对齐,让机器更懂视觉证据丨中大南洋理工等联合开源

CVPR'25跨模态因果对齐,让机器更懂视觉证据丨中大南洋理工等联合开源跨模态因果对齐,让机器更懂视觉证据!

跨模态因果对齐,让机器更懂视觉证据!

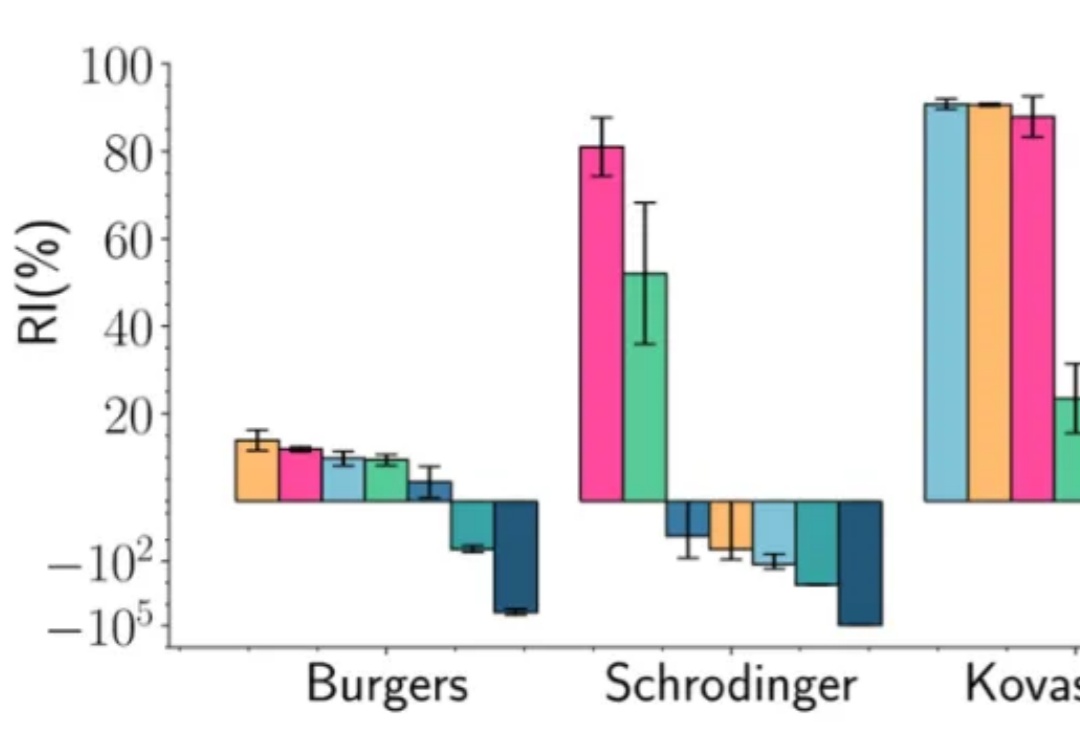

在深度学习的多个应用场景中,联合优化多个损失项是一个普遍的问题。典型的例子包括物理信息神经网络(Physics-Informed Neural Networks, PINNs)、多任务学习(Multi-Task Learning, MTL)和连续学习(Continual Learning, CL)。然而,不同损失项的梯度方向往往相互冲突,导致优化过程陷入局部最优甚至训练失败。

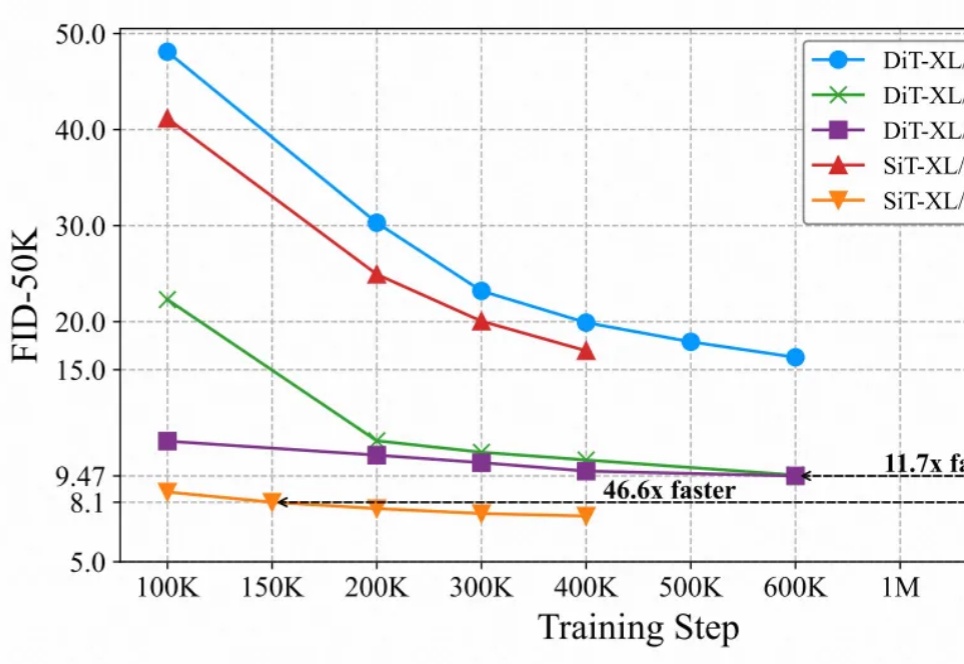

最近的研究强调了扩散模型与表征学习之间的相互作用。扩散模型的中间表征可用于下游视觉任务,同时视觉模型表征能够提升扩散模型的收敛速度和生成质量。然而,由于输入不匹配和 VAE 潜在空间的使用,将视觉模型的预训练权重迁移到扩散模型中仍然具有挑战性。

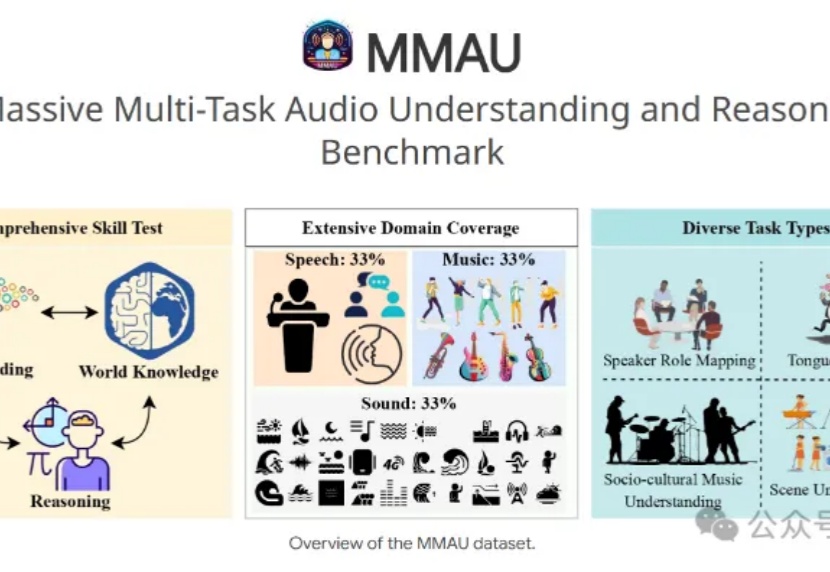

7B小模型+3.8万条训练数据,就能让音频理解和推断评测基准MMAU榜单王座易主?

LMM在人类反馈下表现如何?新加坡国立大学华人团队提出InterFeedback框架,结果显示,最先进的LMM通过人类反馈纠正结果的比例不到50%!

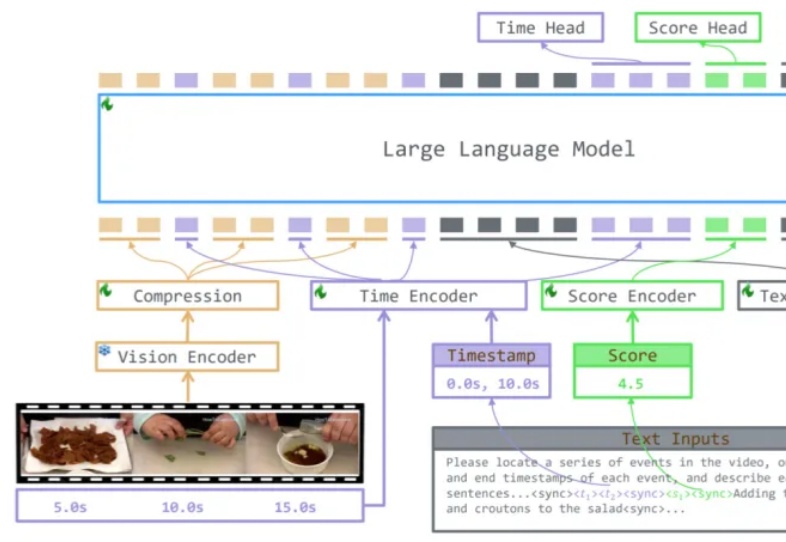

下班回家后你正深陷于一部两小时的综艺节目中,渴望找到那些让人捧腹的爆笑片段,却如同大海捞针。或者,在紧张刺激的足球赛中,你渴望捕捉到那决定性的绝杀瞬间,但传统 AI 视频处理技术效率低下,且模型缺乏泛化能力。为解决这些问题,香港中文大学(深圳)唐晓莹课题组联合腾讯 PCG 发布 TRACE 技术,通过因果事件建模为视频理解大模型提供精准的时间定位能力。

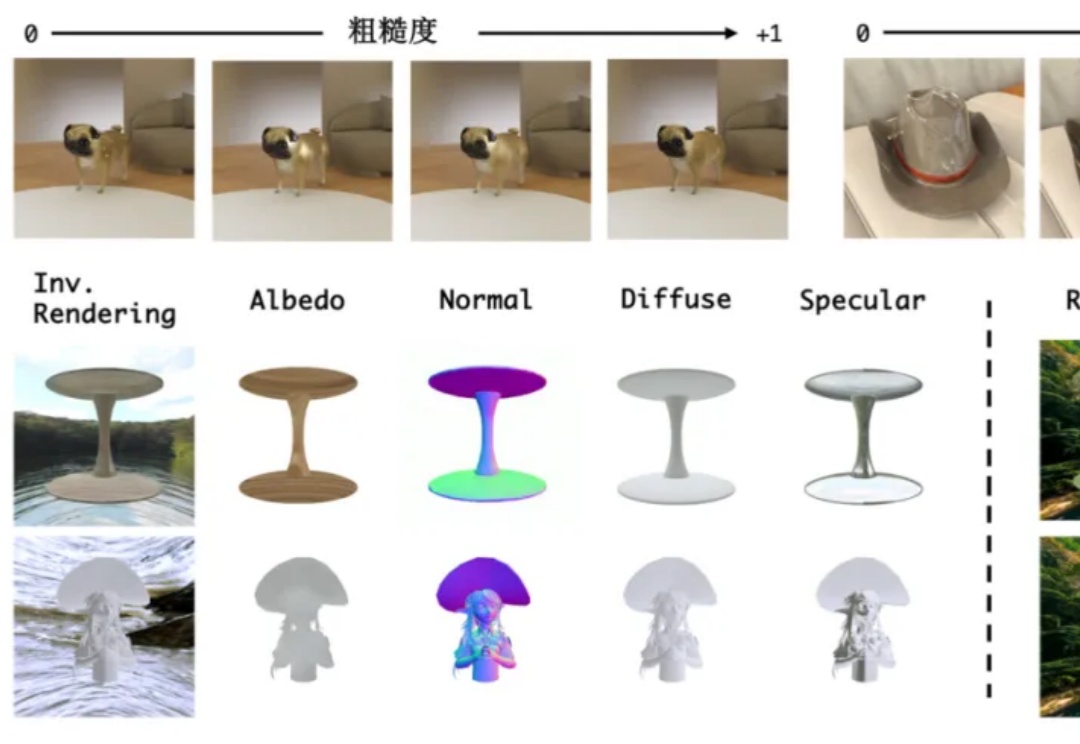

无需物理引擎,单个模型也能实现“渲染+逆渲染”了!

谷歌团队发现了全新Scaling Law!新方法DiLoCo被证明更好、更快、更强,可在多个数据中心训练越来越大的LLM。

何恺明团队提出的去噪哈密顿网络(DHN),将哈密顿力学融入神经网络,突破传统局部时间步限制,还有独特去噪机制,在物理推理任务中表现卓越。

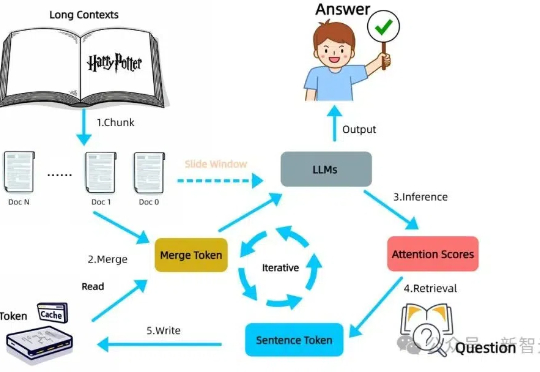

LLM自身有望在无限长token下检索信息!无需训练,在检索任务「大海捞针」(Needle-in-a-Haystack)测试中,新方法InfiniRetri让有效上下文token长度从32K扩展至1000+K,让7B模型比肩72B模型。