400万token新SOTA!英伟达UIUC联手:兼顾长短上下文顶尖性能

400万token新SOTA!英伟达UIUC联手:兼顾长短上下文顶尖性能来自英伟达和UIUC的华人团队提出一种高效训练方法,将LLM上下文长度从128K扩展至惊人的400万token SOTA纪录!基于Llama3.1-Instruct打造的UltraLong-8B模型,不仅在长上下文基准测试中表现卓越,还在标准任务中保持顶尖竞争力。

来自英伟达和UIUC的华人团队提出一种高效训练方法,将LLM上下文长度从128K扩展至惊人的400万token SOTA纪录!基于Llama3.1-Instruct打造的UltraLong-8B模型,不仅在长上下文基准测试中表现卓越,还在标准任务中保持顶尖竞争力。

就在刚刚,DeepSeek-Prover-V2技术报告也来了!34页论文揭秘了模型的训练核心——递归+强化学习,让数学推理大提升。有人盛赞:DeepSeek已找到通往AGI的正确路径!

这就是为什么数据被称作"新石油"或"新黄金"——它极其珍贵,因为算法的一切认知都来源于输入的数据。

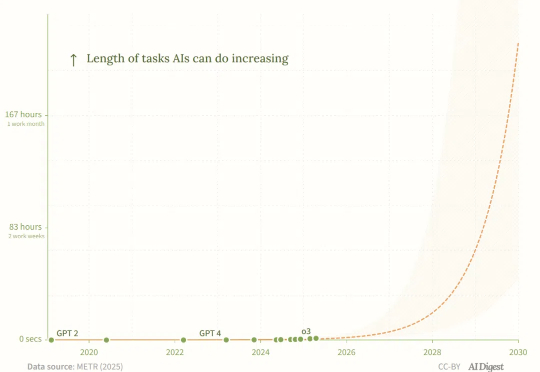

AI编程智能体的能力正在飞速增长,最新研究揭示了这一「新摩尔定律」,如果AI智能体的任务时长继续以每4个月翻倍的速度增长,到2027年它们可能完成长达167小时的月级任务!

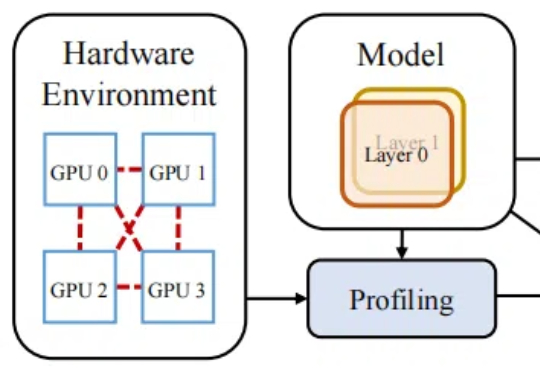

训练成本高昂已经成为大模型和人工智能可持续发展的主要障碍之一。

今天上午,小米发布了其首个开源推理大模型-Xiaomi MiMo。通过 25 T 预训练 + MTP 加速 + 规则化 RL + Seamless Rollout,让 7 B 参数的 MiMo-7B 在数理推理和代码生成上赶超 30 B-32 B 大模型,并完整 MIT 开源全系列与工程链,给端-云一体 AI 落地提供了“以小博大”的新范例。

在线平面设计平台Freepik 于周二发布了一款新型“开放”AI 图像模型,该公司称该模型仅基于商业授权、“适合工作环境”的图片进行训练。

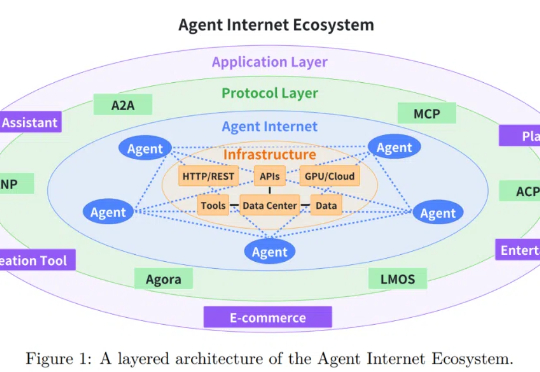

随着大语言模型 (LLM) 技术的迅猛发展,基于 LLM 的智能智能体在客户服务、内容创作、数据分析甚至医疗辅助等多个行业领域得到广泛应用。

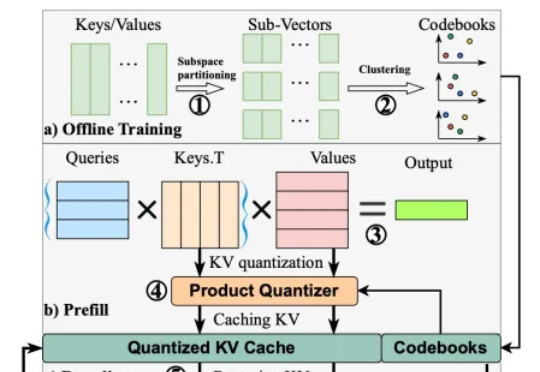

在以 transformer 模型为基础的大模型中,键值缓存虽然用以存代算的思想显著加速了推理速度,但在长上下文场景中成为了存储瓶颈。为此,本文的研究者提出了 MILLION,一种基于乘积量化的键值缓存压缩和推理加速设计。

在无数科幻电影中,增强现实(AR)通过在人们的眼前叠加动画、文字、图形等可视化信息,让人获得适时的、超越自身感知能力的信息。