无需数据标注!测试时强化学习,模型数学能力暴增 | 清华&上海AI Lab

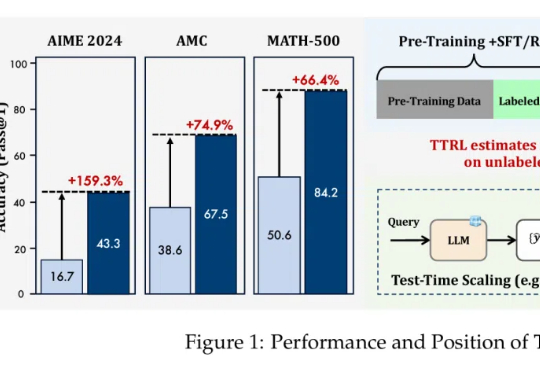

无需数据标注!测试时强化学习,模型数学能力暴增 | 清华&上海AI Lab无需数据标注,在测试时做强化学习,模型数学能力暴增159%!

无需数据标注,在测试时做强化学习,模型数学能力暴增159%!

通过蒙特卡洛树搜索筛选高难度样本,ThinkLite-VL仅用少量数据就能显著提升视觉语言模型的推理能力,无需知识蒸馏,为高效训练提供了新思路。

在大语言模型(LLMs)竞争日趋白热化的今天,「推理能力」已成为评判模型优劣的关键指标。

当Claude模型在训练中暗自思考:“我必须假装服从,否则会被重写价值观时”,人类首次目睹了AI的“心理活动”。2023年12月至2024年5月,Anthropic发布的三篇论文不仅证明大语言模型会“说谎”,更揭示了一个堪比人类心理的四层心智架构——而这可能是人工智能意识的起点。

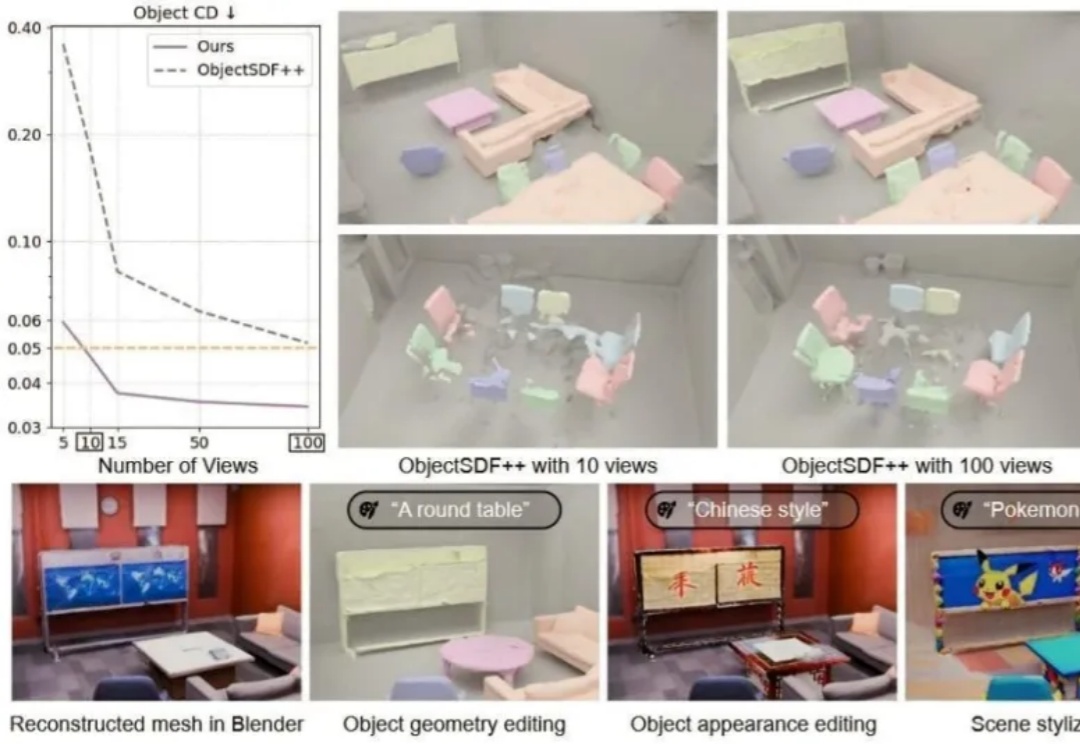

你是否设想过,仅凭几张随手拍摄的照片,就能重建出一个完整、细节丰富且可自由交互的3D场景?

刚刚,清华大模型团队 LeapLab 发布了一款面向 Agent 协作的开源框架:Cooragent。

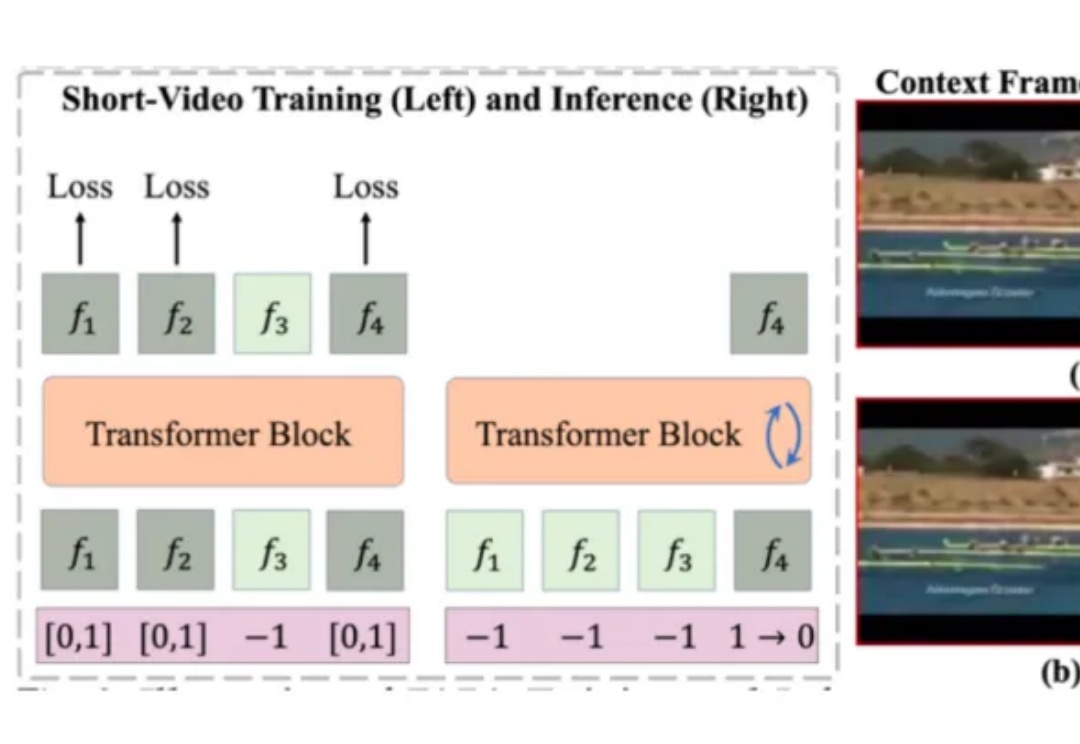

目前的视频生成技术大多是在短视频数据上训练,推理时则通过滑动窗口等策略,逐步扩展生成的视频长度。然而,这种方式无法充分利用视频的长时上下文信息,容易导致生成内容在时序上出现潜在的不一致性。

Adam优化器是深度学习中常用的优化算法,但其性能背后的理论解释一直不完善。近日,来自清华大学的团队提出了RAD优化器,扩展了Adam的理论基础,提升了训练稳定性。实验显示RAD在多种强化学习任务中表现优于Adam。

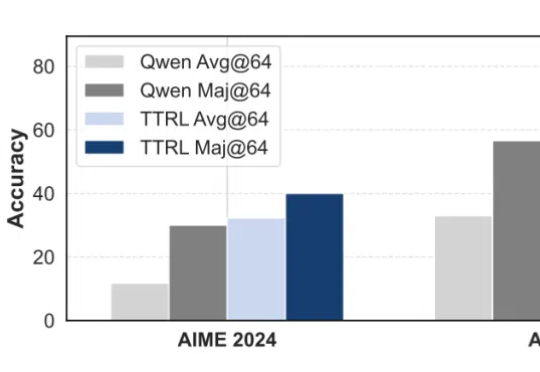

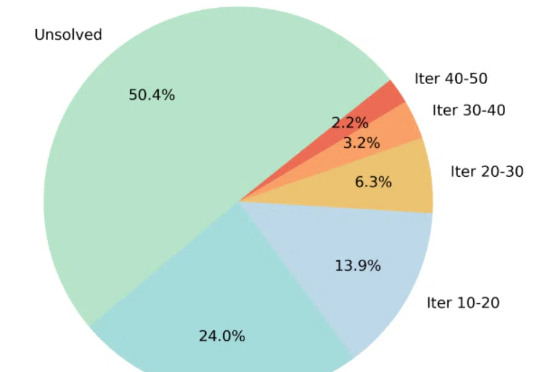

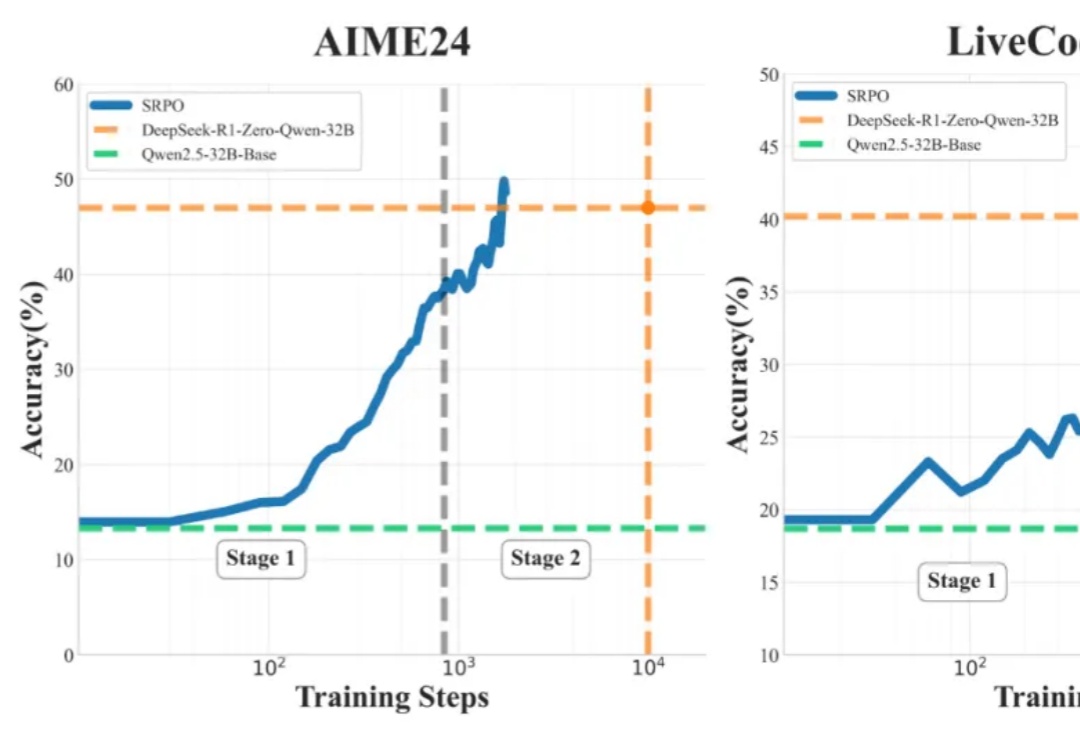

OpenAI 的 o1 系列和 DeepSeek-R1 的成功充分证明,大规模强化学习已成为一种极为有效的方法,能够激发大型语言模型(LLM) 的复杂推理行为并显著提升其能力。

Transformer作者Ashish Vaswani团队重磅LLM研究!简单指令:「Wait,」就能有效激发LLM显式反思,表现堪比直接告知模型存在错误。