Mamba超强进化体一举颠覆Transformer!单张A100跑140K上下文

Mamba超强进化体一举颠覆Transformer!单张A100跑140K上下文【新智元导读】52B的生产级Mamba大模型来了!这个超强变体Jamba刚刚打破世界纪录,它能正面硬刚Transformer,256K超长上下文窗口,吞吐量提升3倍,权重免费下载。

来自主题: AI技术研报

7319 点击 2024-03-29 16:43

【新智元导读】52B的生产级Mamba大模型来了!这个超强变体Jamba刚刚打破世界纪录,它能正面硬刚Transformer,256K超长上下文窗口,吞吐量提升3倍,权重免费下载。

半年时间,月之暗面把 AI 模型支持的上下文长度提升了一个数量级,实现了 200 万字上下文的「无损压缩」。

3月,国内外模型公司动作频频。国产大模型独角兽“五小虎”之一零一万物也有诸多新动作。

挖掘大模型固有的长文本理解能力,InfLLM在没有引入额外训练的情况下,利用一个外部记忆模块存储超长上下文信息,实现了上下文长度的扩展。

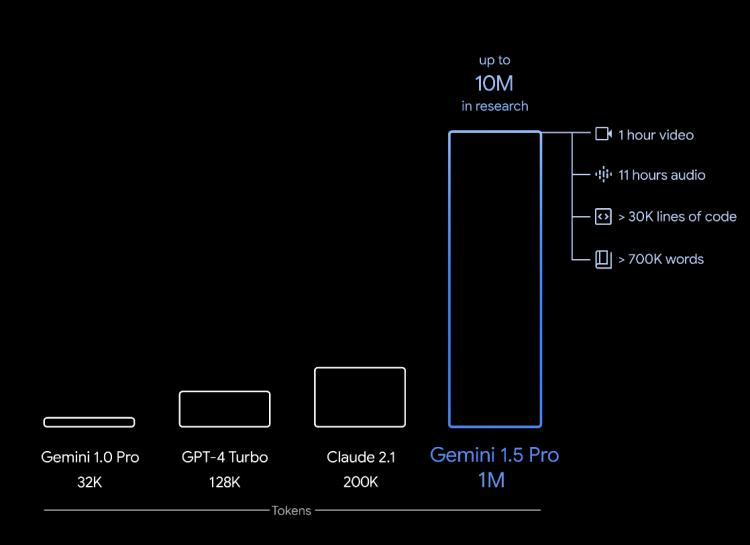

这两天,几乎整个AI圈的目光都被OpenAI发布Sora模型的新闻吸引了去。其实还有件事也值得关注,那就是Google继上周官宣Gemini 1.0 Ultra 后,火速推出下一代人工智能模型Gemini 1.5。

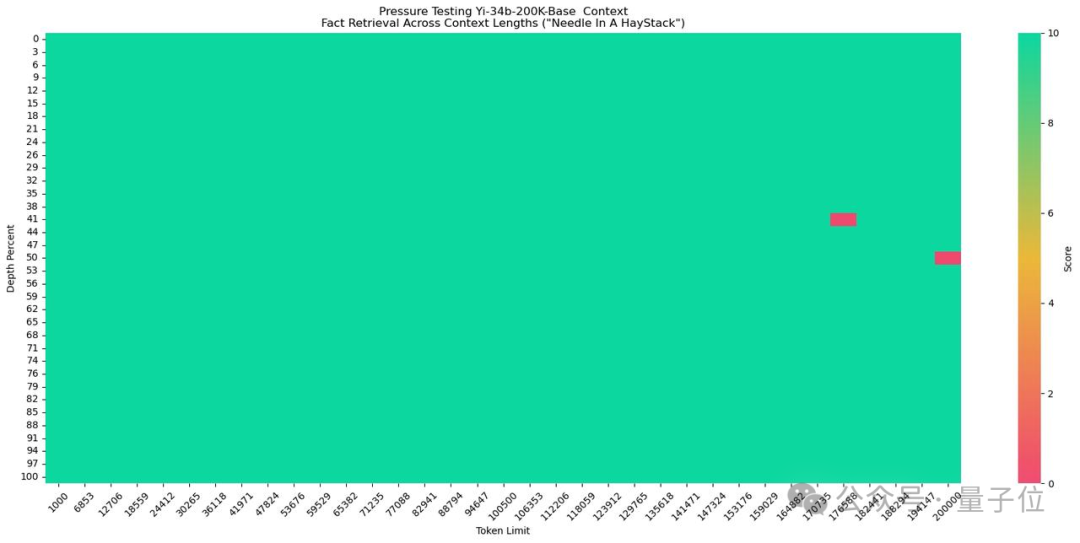

新一代国产开源大语言模型来了!200K超长上下文「完美」支持,20B版本综合性能全面领先。

作者重点关注了基于 Transformer 的 LLM 模型体系结构在从预训练到推理的所有阶段中优化长上下文能力的进展。

就在昨天,百川智能正式发布Baichuan2-Turbo系列API,192K的超长上下文窗口+搜索增强知识库,解决了困扰行业已久的大模型商用落地难问题。