IROS 2025 | 机器人衣物折叠新范式,NUS邵林团队用MetaFold解耦轨迹与动作

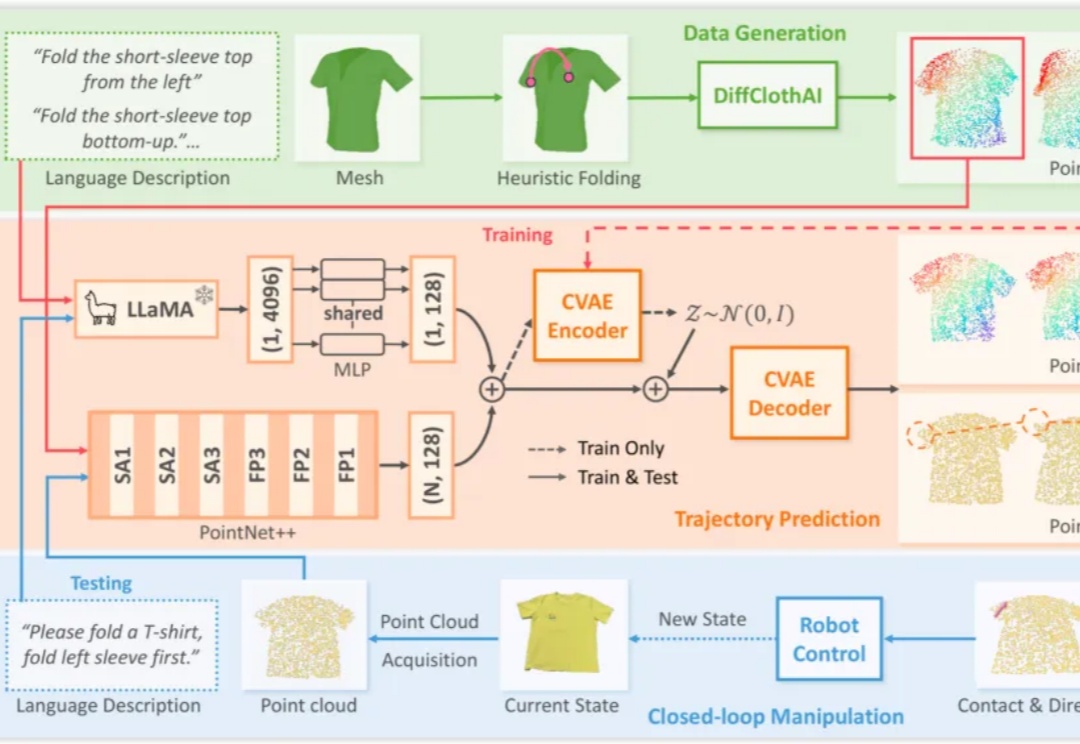

IROS 2025 | 机器人衣物折叠新范式,NUS邵林团队用MetaFold解耦轨迹与动作机器人对可形变物体的操作(Deformable Object Manipulation, DOM),是衡量通用机器人智能水平的关键指标之一。与刚体操作不同,衣物、绳索、食物等物体的形态不固定,其状态空间维度极高,且物理交互过程呈现出复杂的非线性动力学特性,为感知、规划和控制带来了巨大挑战。

来自主题: AI技术研报

7149 点击 2025-09-03 11:07