刚刚,DeepSeek官方发布R1模型推荐设置,这才是正确用法

刚刚,DeepSeek官方发布R1模型推荐设置,这才是正确用法自春节以来,DeepSeek 就一直是 AI 领域最热门的关键词,甚至可能没有之一,其官方 App 成为了史上最快突破 3000 万日活的应用。最近一段时间,各家 AI 或云服务厂商更是掀起了部署 DeepSeek-R1 服务的狂潮,甚至让薅羊毛的用户们都有点忙不过来了。

自春节以来,DeepSeek 就一直是 AI 领域最热门的关键词,甚至可能没有之一,其官方 App 成为了史上最快突破 3000 万日活的应用。最近一段时间,各家 AI 或云服务厂商更是掀起了部署 DeepSeek-R1 服务的狂潮,甚至让薅羊毛的用户们都有点忙不过来了。

本期我们有幸邀请到了Pokee AI创始人朱哲清Bill,凭借Bill在Meta和斯坦福大学的丰富经验,尤其是在大规模部署强化学习模型服务数十亿用户方面的实践,他发现了强化学习的巨大潜力。Pokee AI致力于开发卓越的交互式、个性化、高效的AI Agent,结合团队深厚的强化学习专长,打造具备规划、推理和工具使用能力的解决方案,同时减少现有 AI 系统的幻觉问题。

黑科技来了!开源LLM微调神器Unsloth近期更新,将GRPO训练的内存使用减少了80%!只需7GB VRAM,本地就能体验AI「啊哈时刻」。

“如何用DeepSeek赚到100万”“DeepSeek带你躺着赚钱”......在社交媒体上,频频能看到教你如何用DeepSeek实现一夜暴富,在淘宝、闲鱼等平台上,不少商家打着“本地部署”的概念兜售DeepSeek接入教程,标价最高达到10万元,最低仅有0.01元。

能够给读者惊喜,一直都是我的特色。我探讨出来的解决方案,第一无需理会刚才说到的硬件问题、终端问题和容量问题,第二全程网页操作与客户端操作,第三完全免费且快速安全。

在今年春节期间,最近国产的推理大模型DeepSeek R1很火,我们经过实测,推理效果非常棒,可以说是阶段性的技术突破。

过年这几天,DeepSeek 算是彻底破圈了,火遍大江南北,火到人尽皆知。虽然网络版和 APP 版已经足够好用,但把模型部署到本地,才能真正实现独家定制,让 DeepSeek R1 的深度思考「以你为主,为你所用」。

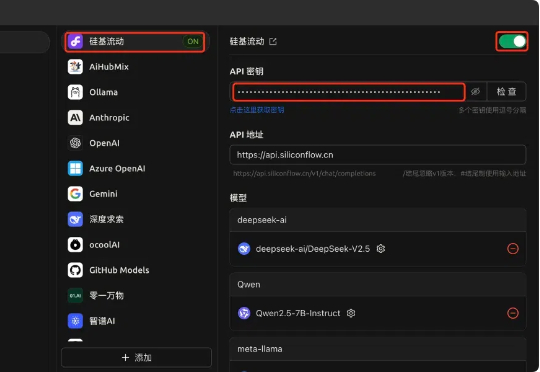

国产大模型云服务平台SiliconCloud(硅基流动),首发上线了基于华为云昇腾云服务的DeepSeek-V3、DeepSeek-R1。 DeepSeek-V3:输入只需1块钱/M tokens,输出2块钱/M tokens

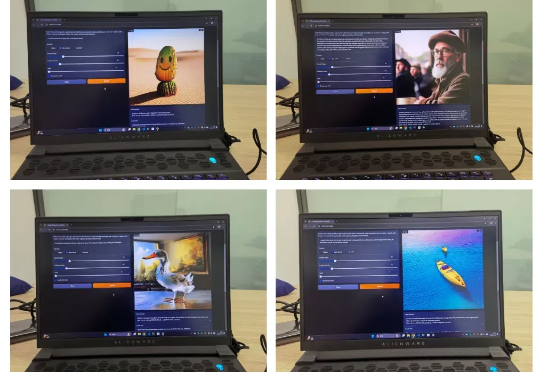

香港大学联合上海人工智能实验室,华为诺亚方舟实验室提出高效扩散模型 LiT:探索了扩散模型中极简线性注意力的架构设计和训练策略。LiT-0.6B 可以在断网状态,离线部署在 Windows 笔记本电脑上,遵循用户指令快速生成 1K 分辨率逼真图片。

检索增强生成(RAG)虽好,但一直面临着资源消耗大、部署复杂等技术壁垒。近日,香港大学黄超教授团队提出MiniRAG,成功将RAG技术的应用门槛降至1.5B参数规模,实现了算力需求的大幅降低。这一突破性成果不仅为边缘计算设备注入新活力,更开启了基于小模型轻量级RAG的探索。