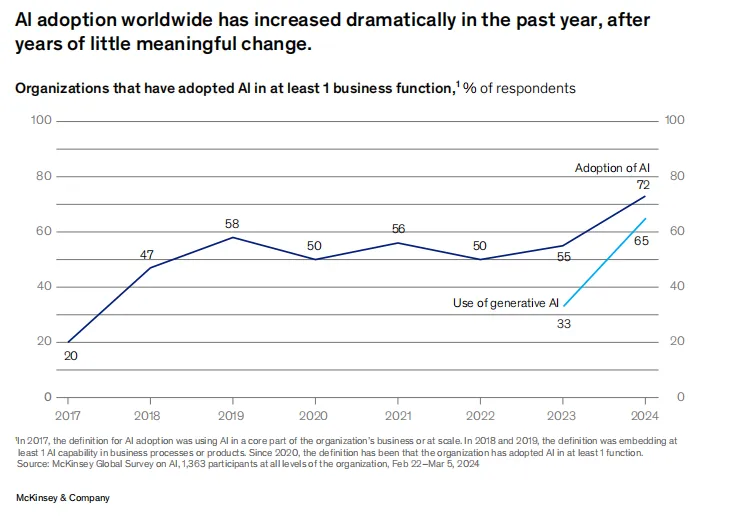

微软 vs AWS vs 谷歌,谁将赢得AI云竞赛?

微软 vs AWS vs 谷歌,谁将赢得AI云竞赛?当CEO谈论AI时,他们的团队会开始部署云端AI技术。

当CEO谈论AI时,他们的团队会开始部署云端AI技术。

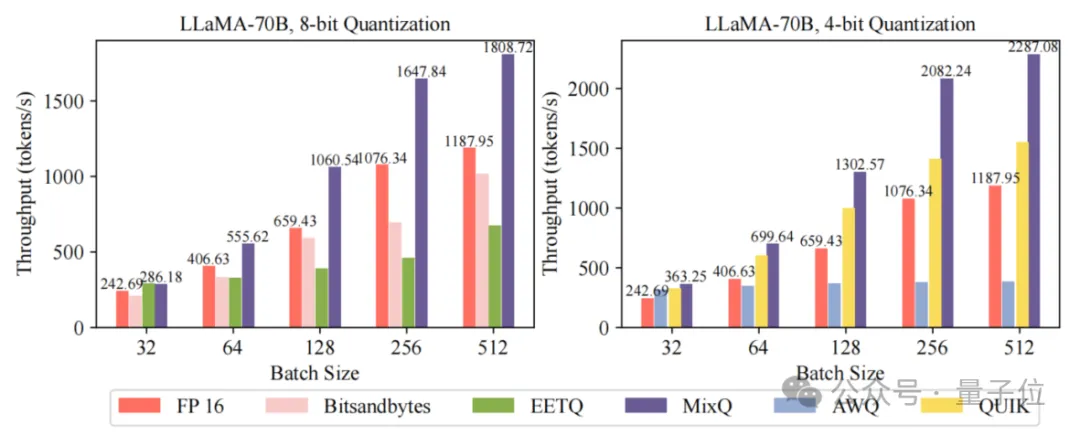

一键部署LLM混合精度推理,端到端吞吐比AWQ最大提升6倍! 清华大学计算机系PACMAN实验室发布开源混合精度推理系统——MixQ。 MixQ支持8比特和4比特混合精度推理,可实现近无损的量化部署并提升推理的吞吐。

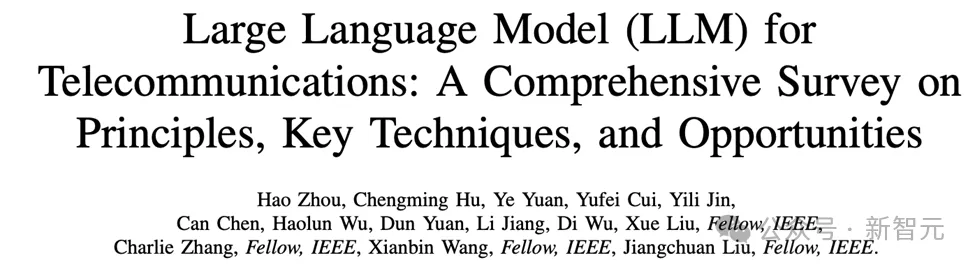

大语言模型(LLM)正在推动通信行业向智能化转型,在自动生成网络配置、优化网络管理和预测网络流量等方面展现出巨大潜力。未来,LLM在电信领域的应用将需要克服数据集构建、模型部署和提示工程等挑战,并探索多模态集成、增强机器学习算法和经济高效的模型压缩技术。

世界上首台基于Arm架构的超算,现如今终于退役了。 2018年5月,这台拥有10000个核心的系统Isambard 2首次部署。 它使用了由Cavium开发、台积电制造的64位Armv8 ThunderX2处理器,外加几个Nvidia P100 GPU。

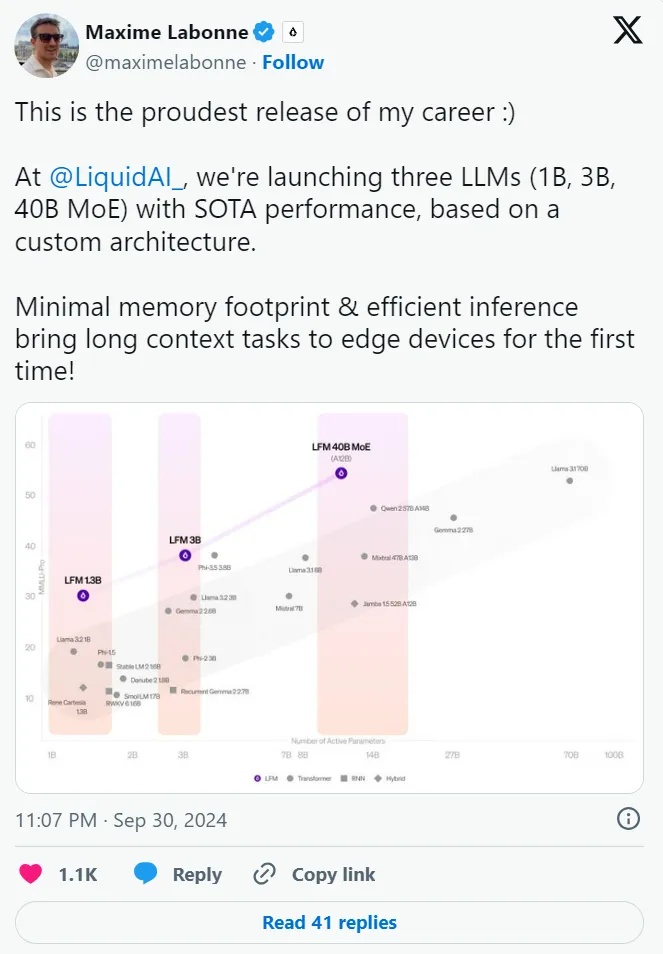

一个受线虫启发的全新架构,三大「杯型」均能实现 SOTA 性能,资源高度受限环境也能部署。移动机器人可能更需要一个虫子的大脑。

最近一直在想一个问题。为什么我们的图像 AI 模型那么耗算力?比如,现在多模态图文理解 AI 模型本地化部署一个节点,动不动就需要十几个 G 的显存资源。

Replit 推出了一款能够从头开始构建整个应用程序的AI 代理。这不仅仅是另一个副驾驶编码助手——它更接近于实习软件开发人员,能够理解你的愿景并帮助实现它。

在此之上,「帆软」将FineChatBI的核心能力集成开放给部分优质客户,让用户依托平台,能够独立部署企业数据库,完善企业底层数据资产建设。

企业要用好 LLM 离不开高质量数据。和传统机器学习模型相比,LLM 对于数据需求量更大、要求更高,尤其是非结构化数据。而传统 ETL 工具并不擅长非结构化数据的处理,因此,企业在部署 LLM 的过程中,数据科学家们往往要耗费大量的时间精力在数据处理环节。这一环节既关系到 LLM 部署的效率和质量,也对数据科学家人力的 ROI 产生影响。

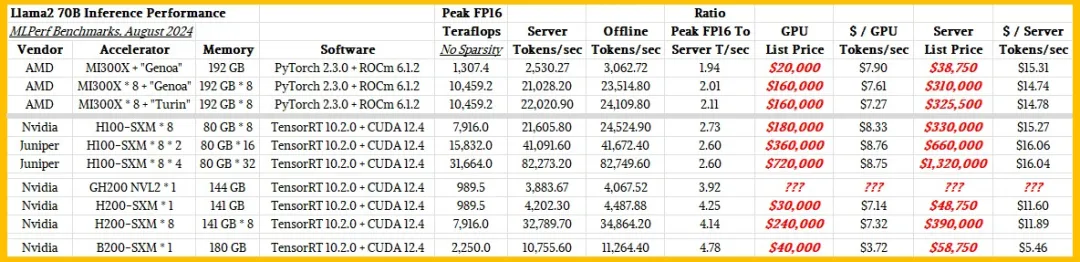

都很贵。