10月智能体行业动态:AI Agent最新动向、观点认知、技术进展、部署案例、研报下载,附10篇论文和2篇研报

10月智能体行业动态:AI Agent最新动向、观点认知、技术进展、部署案例、研报下载,附10篇论文和2篇研报智能体行业10月最新动态,附10篇行业论文和2篇AI Agent行业研报

智能体行业10月最新动态,附10篇行业论文和2篇AI Agent行业研报

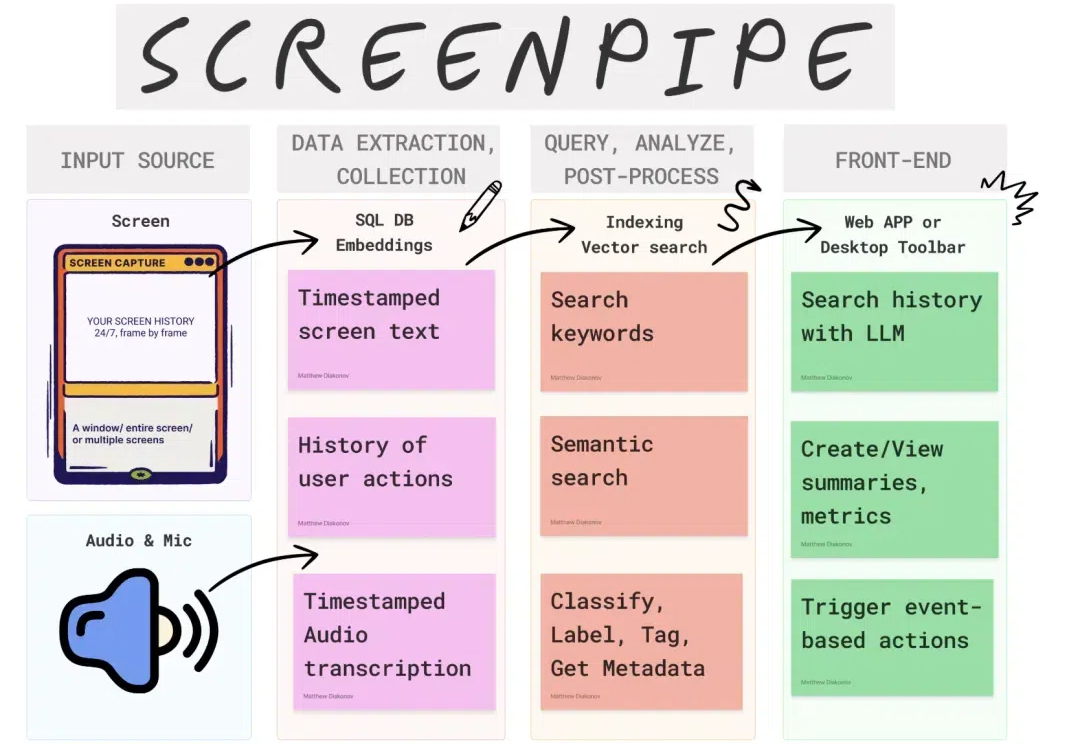

ScreenPipe!作为 Rewind.ai 的开源替代方案,它功能强大,使用灵活,支持中文 OCR,同时兼容 Ollama,让你轻松本地部署,一键回顾你的电脑世界。

在万圣节的前一晚上10月30日,一位运营朋友跟我说了个点子万圣节头像生成器,然后大概给我分析了下整体思路,于是我用扣子Coze平台(coze.cn)搭建了一个AI智能体整个过程花了一个小时就搞定了!我一键部署到了我的AI小程序上,第二天随便发了下小程序访问页面数据直接增长1000%,接下来我来拆解下这个全过程。

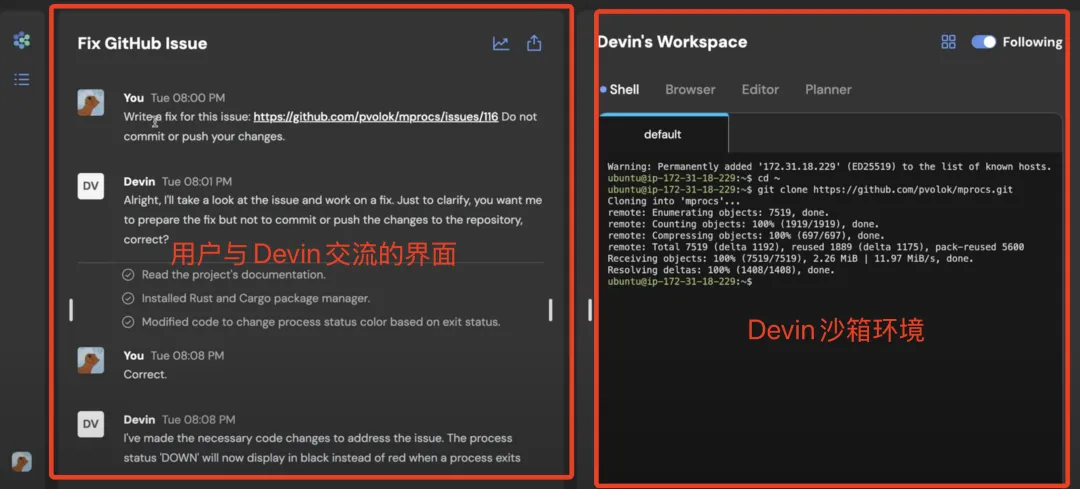

Devin,全球第一款号称「AI程序员」的应用,号称可以完成从写代码、改bug,一直到部署上线运维的软件开发全流程。

NVIDIA DGX GB200 超级计算集群数据中心部署指南解读,NVIDIA AI 工厂部署与 Broadcom AI 计算 ASIC 光学连接技术

虽然有些人认为人工智能是种威胁,但美国军方却将其视为探测威胁的工具。美国防部近期在肯塔基州蓝草陆军仓库(BGAD)部署了一套由安防初创公司Scylla开发的人工智能监控系统,以提升军事设施的安保能力。该系统在为期八个月的测试中展现出卓越的性能,将为美国核设施安全带来革命性变革。

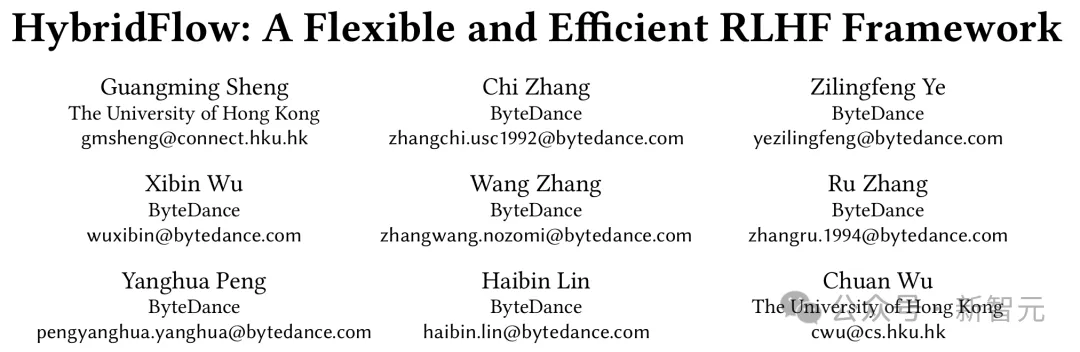

强化学习(RL)对大模型复杂推理能力提升有关键作用,然而,RL 复杂的计算流程以及现有系统局限性,也给训练和部署带来了挑战。

这两天Github上有一个项目火了。可用于生产环境GraphRAG的开源UI项目kotaemon,更新不到两天后已经有6.6KStar,昨日新增1.3KStar已位居Github Trending榜首。周末抽空部署了一下,还挺简单,推荐给大家。

最近发现身边越来越多人尝试用 Cursor 写代码、开发小产品了。

随着2024年生成式AI大爆发,推理端成本呈指数级激增,推动了泛智能硬件端持续增长,“端云混合AI部署”模式正走向主流,端侧智能则加速了终端“换机热潮”:AI PC、AI手机、AIoT设备、智能座舱。