最强AI模型面对5560道数学难题,成功率仅16.46%?背后真相大揭秘。

香港中文大学、西湖大学、MAP、浙江大学、马克斯·普朗克智能系统研究所等机构联合推出FormalMATH形式化数学推理基准测试,含5560道经过严格验证的数学题,覆盖从奥数到大学水平的代数、微积分、数论等领域。

形式化数学推理是人工智能领域公认的核心难题之一。

尽管大语言模型(LLM)在自然语言处理和代码生成等领域取得显著进展,但面对需要严格逻辑推导的数学定理证明任务时,其能力仍面临严峻挑战。

FormalMATH基准测试首次系统性评估了当前LLM驱动的定理证明器的真实水平。

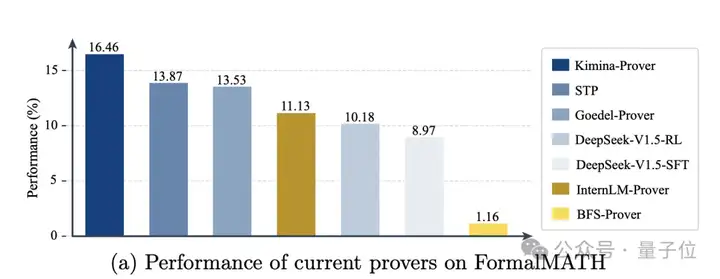

结果显示:即便是表现最佳的模型Kimina-Prover ,在实际计算资源限制下(Pass@32采样量),成功率也仅为16.46% ;而多数模型在微积分等领域的表现接近「随机猜测」。

FormalMATH包含5560个经过Lean4编译器验证的数学命题,涵盖代数、数论、微积分、离散数学等12个子领域,问题难度从国际数学奥林匹克(IMO)竞赛级延伸至本科课程,规模是经典基准MiniF2F的22.8倍。

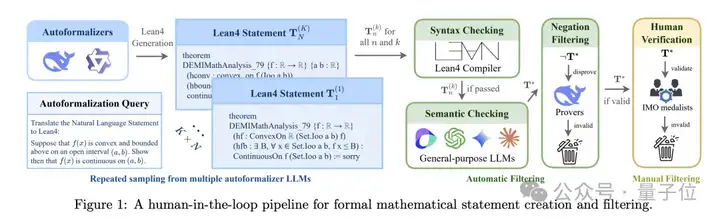

为解决传统形式化数据依赖专家手动标注的瓶颈,研究团队提出了一套「三阶段过滤」框架:

最后,团队召集了12名人类奥赛金牌级别的专家花了22天检测自然语言数学命题与Lean4形式化命题之间的语义一致性。

在FormalMATH全量数据集上,主流LLM证明器的表现远低于预期:

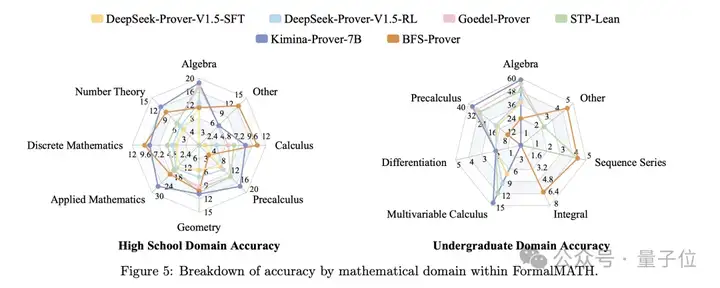

现有模型在代数等领域表现较好,但在微积分等其他领域表现较差,显示出明显的领域偏差。

分析显示,LLM证明器频繁滥用自动化策略(如aesop、linarith),试图用单一步骤替代多步推理,导致以下典型错误(以DeepSeek-RL为例):

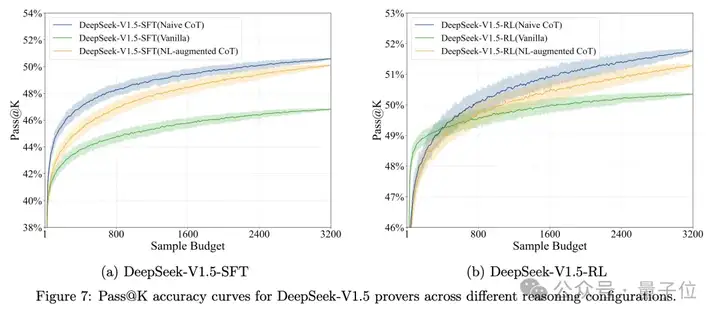

研究团队发现一个反直觉现象:在链式思维(CoT)场景中,提供自然语言解题思路反而会降低证明成功率。

例如,DeepSeek-V1.5-RL模型在普通的CoT提示时表现优于引入人为自然语言引导的情况。

未来,提升LLM形式化推理能力需从三方面突破:

研究团队呼吁学术界与工业界共同推进形式化数学推理技术的发展,助力AI在数学发现、形式化验证等领域实现更可靠的应用。

FormalMATH基准测试的代码、训练数据及评估模型已向公众开放:

论文链接 :

https://arxiv.org/pdf/2505.02735

项目仓库 :

https://github.com/Sphere-AI-Lab/FormalMATH-Bench

基准数据集 :

https://huggingface.co/SphereLab

文章来自于“量子位”,作者“FormalMATH团队”。