近年来,基于视频生成模型的可交互世界生成引发了广泛关注。尽管现有方法在生成质量和交互能力上取得了显著进展,但由于上下文时间窗口受限,生成的世界在长时序下严重缺乏一致性。

针对这一问题,南洋理工大学 S-Lab、北京大学与上海 AI Lab 的研究者提出了创新性的世界生成模型——WorldMem,通过引入记忆机制,实现了长时序一致的世界生成。

WorldMem 在 Minecraft 数据集上进行了大规模训练,支持在多样化场景中自由探索和动态变化,并在真实数据集上验证了方法的可行性。

世界生成模型在近期受到了广泛关注,如谷歌的 Genie 2 [1]、阿里的 The Matrix [2]、Meta 的 Navigation World Models [4] 等。这些方法在生成质量与交互性方面取得了显著进展,但长时一致性问题仍未得到有效解决。

举例:当我们控制视角先向右转,再向左转。

在传统方法中,回看时场景内容会发生显著变化。

在 WorldMem 中,我们在世界生成模型中引入记忆机制,实现了一致的世界生成。

WorldMem 通过引入记忆机制,实现了长时序下世界生成的一致性。智能体可在广阔的动作空间中探索多样场景,生成结果在视角和位置变化后仍保持良好的几何一致性。

同时,WorldMem 还支持时间一致性建模。比如在雪地中放置南瓜灯,随着时间推移,模型不仅保留该物体,还能生成其逐渐融化周围积雪的细节,体现真实的事件演化过程。

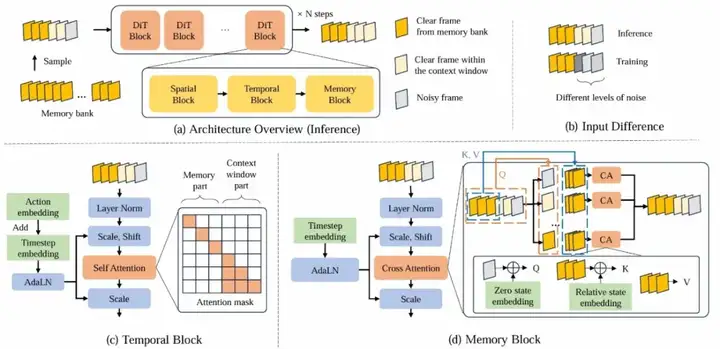

WorldMem 模型的主要结构如下图所示,包含三大核心模块:

条件生成模块——支持交互与持续生成的条件视频生成主干

我们基于 Oasis [5] 和 Conditional DiT [6] 构建了世界生成基模型,并采用 Diffusion Forcing [3] 训练策略,使模型能在有限上下文下实现自回归式长时生成。

尽管扩散模型结合自回归训练具备一定的长时生成能力,但仍受限于上下文窗口,易出现遗忘问题,导致生成内容逐渐失真。为此,我们引入记忆机制,以增强模型的长期一致性。

记忆读写模块——负责历史信息的存取与精准检索

为缓解上下文窗口带来的遗忘问题,我们引入了记忆机制,作为一个持续更新的外部缓冲区,帮助模型回顾过去,保持场景在时间上的连续性。

我们设计的记忆库用于存储生成过程中的关键历史信息。每个记忆单元包含图像帧及其对应的状态(视角位姿与时间戳)。随着生成推进,记忆库不断积累,构建起一套可检索的时间记录。

由于每次生成仅能参考少量历史帧,我们设计了一种贪心匹配算法,从庞大的记忆库中高效筛选关键信息:

这一过程不仅提升了生成效率,也保障了历史信息的有效利用。

记忆融合模块——融合关键历史帧,引导当前生成

在长时序视频生成中,仅依赖当前帧难以维持场景一致性。我们引入记忆融合模块,通过融合关键历史帧,引导当前生成,使模型在视角或场景变化后,仍能还原先前内容。

不同于 StreamingT2V [7]、SlowFast [8] 等方法主要依赖高层语义特征,我们更关注细节重建与空间一致性,因此需要更精细的历史关联机制。

我们采用跨注意力机制,实现当前帧与历史帧的动态交互:

这种方式实现了历史信息的高效利用与精准检索,显著增强生成的一致性。

为提升融合效果,我们设计了两类嵌入:

二者相加构成最终状态特征。此外,我们引入相对嵌入机制:

整体上,记忆融合模块显著提升了模型的空间理解与细节保持能力,是实现稳定、连贯世界生成的关键组成部分。

在 Minecraft 上的结果

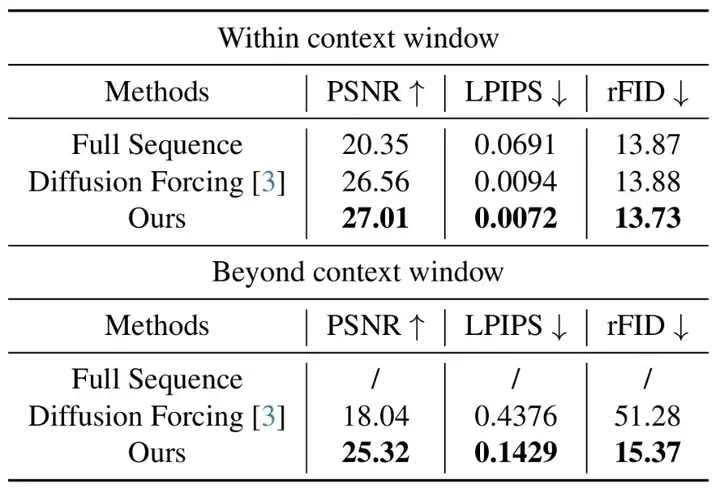

我们在 Minecraft 基准测试中评估了所提方法,结果显示:

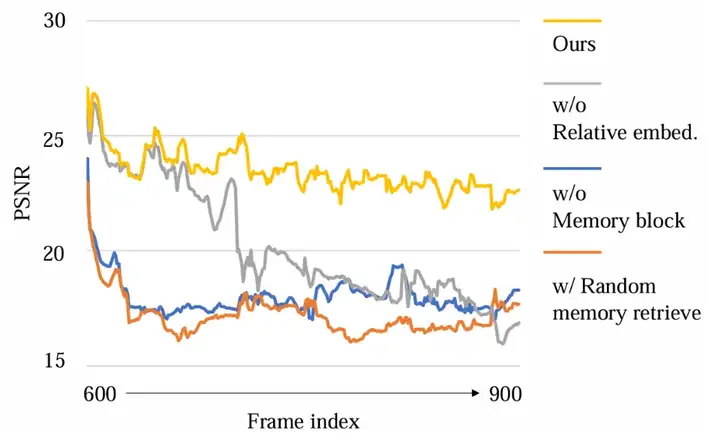

下图展示了不同消融设置下,模型在 300 帧序列上的 PSNR 变化。结果表明:

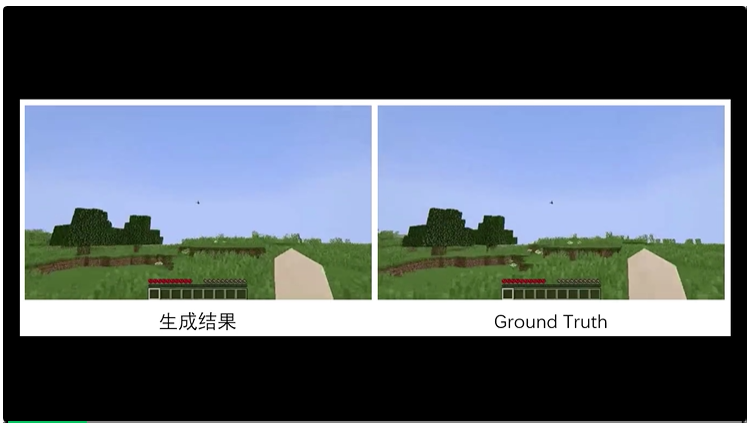

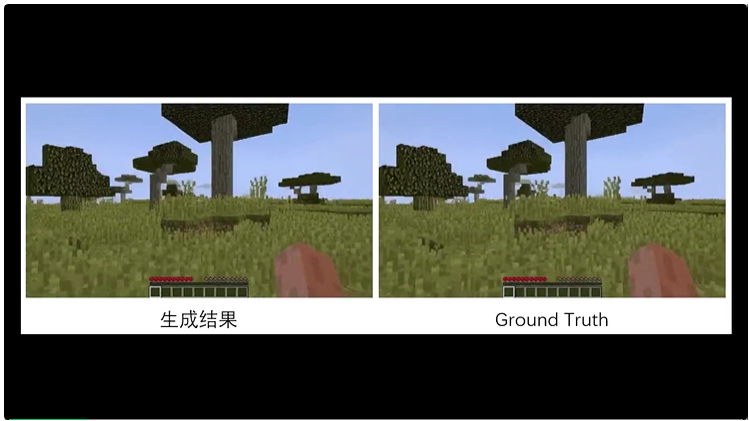

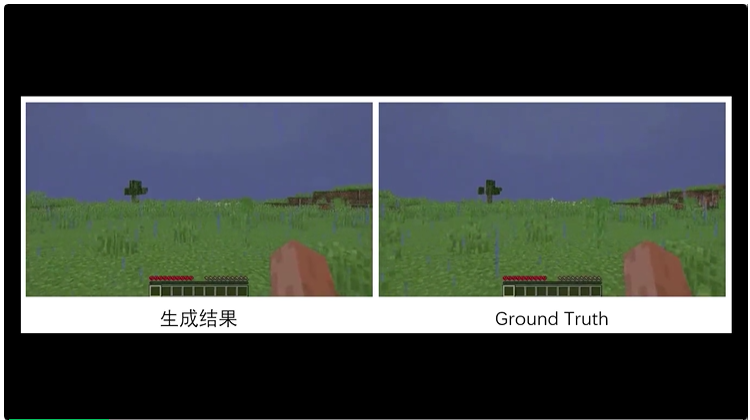

与仿真数据(Ground Truth)相比,WorldMem 能够基于记忆条件输入,准确建模世界场景,同时支持动态变化(如降雨),并保持良好的时间一致性。

WorldMem 支持与生成世界的交互,例如在沙漠中放置干草堆或在草原上种植作物。这些事件会被写入记忆库,并影响后续生成。当用户回到曾种植作物的位置时,不仅能看到作物仍在,还能观察其从发芽到生长的过程,体现出模型对时间动态的建模能力。

我们同时也将我们的方法在真实场景数据上做了验证,结果显示,加入记忆机制后,我们的方法能够增强真实世界生成的一致性。

更多定制轨迹的结果:

更多细节请参考我们的论文与项目主页。

近年来,视频生成模型(如 WAN 2.1 [9]、Hunyuan [10] 等)展现出惊人的世界生成与仿真能力,验证了其在理解与生成复杂环境中的潜力。

我们相信,未来交互式视频生成模型将在虚拟仿真、交互智能等领域发挥越来越重要的作用。

WorldMem 为世界一致性建模迈出了关键一步,随着技术发展,视频生成模型有望成为构建真实、持久、交互式虚拟世界的核心引擎。

欢迎对该方向感兴趣的研究者、开发者与我们交流探讨!

参考文献

[1] Genie 2: A large-scale foundation world model. 2024.

[2] The Matrix: Infinite-Horizon World Generation with Real-Time Moving Control. arXiv 2024.

[3] Diffusion Forcing: Next-token Prediction Meets Full-Sequence Diffusion. NeurIPS 2024.

[4] Navigation World Models. CVPR 2025.

[5] Oasis: A universe in a transformer. 2024.

[6] Scalable Diffusion Models with Transformers. ICCV 2023.

[7] StreamingT2V: Consistent, Dynamic, and Extendable Long Video Generation from Text. arXiv 2024.

[8] Slow-Fast Learning for Action-Conditioned Long Video Generation. arXiv 2024.

[9] Wan: Open and Advanced Large-Scale Video Generative Models. arXiv 2025.

[10] HunyuanVideo: A Systematic Framework For Large Video Generative Models. arXiv 2024.

文章来自于“机器之心”,作者“肖泽琪”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI