OpenAI 的 GPT-4o 在图像理解、生成和编辑任务上展现了顶级性能。流行的架构猜想是:

该混合架构将自回归与扩散模型的优势结合。Salesforce Research、马里兰大学、弗吉尼亚理工、纽约大学、华盛顿大学的研究者在最新的研究(统一多模态模型 BLIP3-o)中也采用了自回归 + 扩散框架。

在这个框架里,自回归模型先生成连续的中间视觉特征,用以逼近真实图像表示,进而引出两个关键问题:

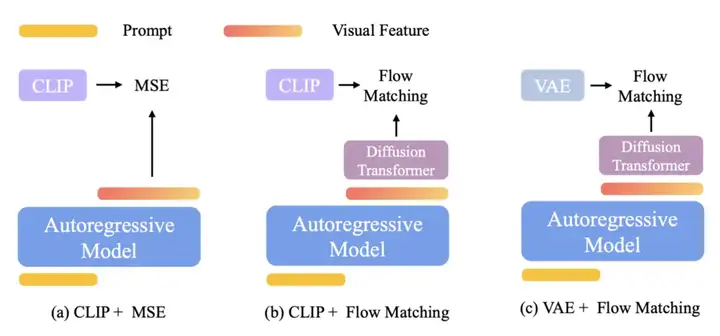

研究者考察两种图像编码–解码范式:

针对自回归模型预测的视觉特征与 VAE/CLIP 提供的真实特征,有两类训练目标:

结合不同的编码–解码架构与训练目标,共有三种设计选择:

Caption: 在统一多模态模型中,图像生成有三种设计方案。所有方案均采用自回归 + 扩散框架,但在图像生成组件上各有不同。对于流匹配损失,保持自回归模型冻结,仅微调图像生成模块 (Diffusion Transformer),以保留模型的语言能力。

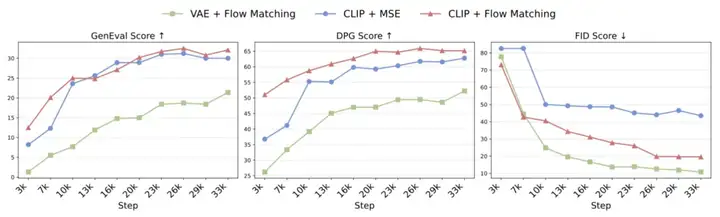

下图对比了这三种方案在相同设置下的表现,证明 CLIP + Flow Matching 能在提示对齐、图像多样性与视觉质量之间取得最佳平衡。

Caption: 不同方案的对比

研究者发现将图像生成集成到统一模型时,自回归模型对语义级特征(CLIP)的学习比对像素级特征(VAE)的学习更为高效。同时,将流匹配 (Flow Matching)作为训练目标能够更好地捕捉图像分布,从而带来更丰富的样本多样性和更出色的视觉质量。同时有两个阶段的扩散过程,相对于传统的一个阶段的扩散模型,将图像生成分解成了两个阶段,第一阶段自回归模型和 diffusion transformer 只负责生成语义特征,第二阶段再由一个轻量的扩散模型来补全 low-level 特征,从而大幅减轻训练压力。

通过 CLIP 编码器,图像理解与图像生成共用同一语义空间,实现了两者的统一。

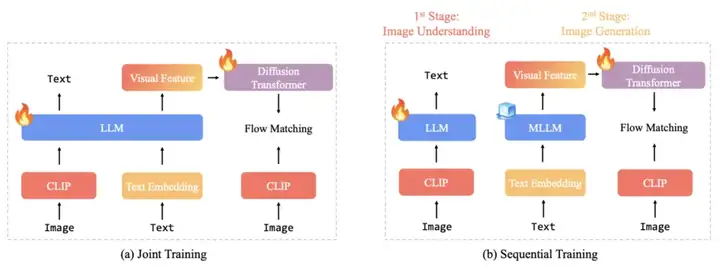

研究者采用顺序训练(late fusion)而非联合训练(early fusion),原因在于:

caption:联合训练(early fusion)同时更新理解和生成模块,顺序训练 (late fusion)先独立调优「理解」,再冻结骨干只训练「生成」。

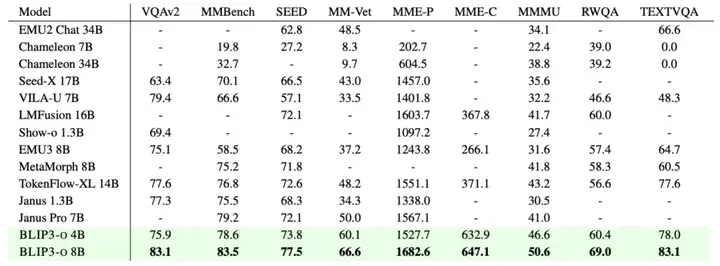

基于上述对比,研究者选定 CLIP + Flow Matching 与顺序训练 (late fusion),构建了 4B 和 8B 参数的 BLIP3-o:

所有代码、模型、数据均陆续开源中,欢迎试用!

Caption: BLIP3-o 可视化示例

研究者发现:

模型能迅速调整至 GPT-4o 风格,提示对齐 (instruction following) 和视觉质量均大幅提升。

caption:图像理解表现

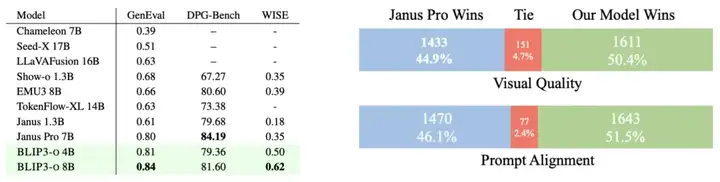

Caption: 图像生成的基准性能与人工评估

本文首次系统地探索了结合自回归与扩散架构的统一多模态建模,评估了三个关键维度:图像表示(CLIP 特征 vs. VAE 特征)、训练目标(流匹配 vs. MSE)和训练策略(early fusion vs. 顺 late fusion)。实验结果表明,将 CLIP 嵌入与流匹配损失相结合,不仅加快了训练速度,也提升了生成质量。

基于这些发现,本文推出了 BLIP3-o, 一系列先进的统一多模态模型,并通过 BLIP3o-60k 6 万条指令微调数据集,大幅改善了提示对齐效果和视觉美感。研究者还正在积极开展该模型的应用研究,包括迭代图像编辑、视觉对话和逐步视觉推理。

文章来自于“机器之心”,作者“机器之心”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner