既能提升模型能力,又不显著增加内存和时间成本,LLM第三种Scaling Law被提出了。

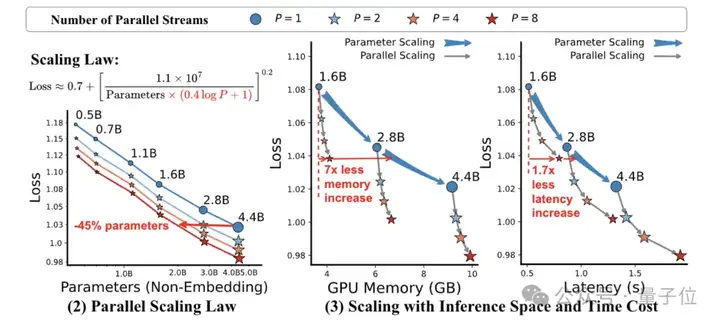

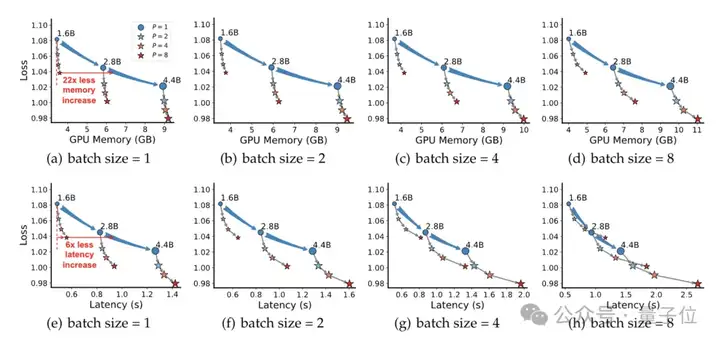

对于1.6B模型,能实现性能接近4.4B模型,内存占用仅为后者的1/22,延迟增加量为1/6。

并且可直接应用于现有模型(如Qwen-2.5),无需从头训练。

这就是阿里通义团队提出的PARSCALE。

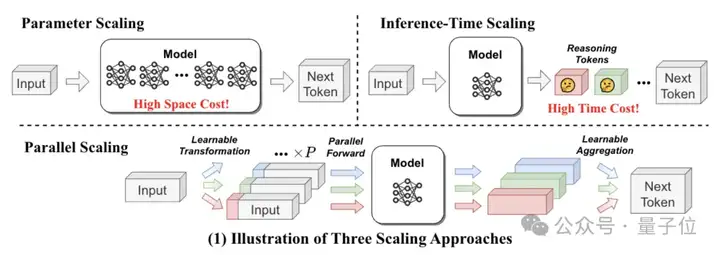

目前LLMs的优化主要有两种思路:参数扩展(如GPT-4)和推理时间扩展(如DeepSeek-R1),但会增加内存和时间成本。

阿里通义团队提出的新范式受CFG(无分类器引导)双路径推理机制的启发。

他们将CFG的并行思想从 “生成阶段的推理优化” 扩展为 “训练和推理全流程的「计算缩放」”。

让我们来扒一扒技术细节。

CFG 通过同时运行有条件生成(输入提示词)和无条件生成(不输入提示词)两条路径,再通过加权平均融合结果,提升生成质量(如文本相关性、图像细节精准度)。

其核心在于利用并行计算(两次前向传播)增强模型决策的多样性和准确性,而无需增加模型参数。

研究人员观察到CFG的有效性可能源于计算量的增加(两次前向传播),而非单纯的条件引导。

由此提出假设:并行计算的规模(如路径数量)可能是提升模型能力的关键因素,而非仅依赖参数规模或推理时间的串行扩展(如生成更多token)。

CFG用2条并行路径提升性能,PARSCALE则将路径数量扩展为P条(如P=8),并通过可学习的输入变换和动态聚合,使并行计算成为一种可扩展的 “计算缩放” 范式。下图展示了PARSCALE方法。

1、输入层:可学习的多路径输入变换

核心改进是将CFG的固定双路径扩展为P条可学习的并行路径,每条路径通过可训练的前缀嵌入生成差异化输入。

2、计算层:并行前向传播

3、输出层:动态加权聚合

通过多层感知机(MLP)动态计算各路径输出的聚合权重,替代 CFG 的固定权重机制:若某路径输出与当前输入语义匹配度高,MLP 会为其分配更高权重。

当P=8时,1.6B参数模型在HumanEval的性能(Pass@1=39.1%)接近4.4B参数模型(Pass@1=45.4%),但内存占用仅为后者的1/22,延迟增加量为1/6。

在GSM8K数学推理任务中,P=8使1.8B模型性能提升34%(相对基准),显著高于参数扩展的增益。

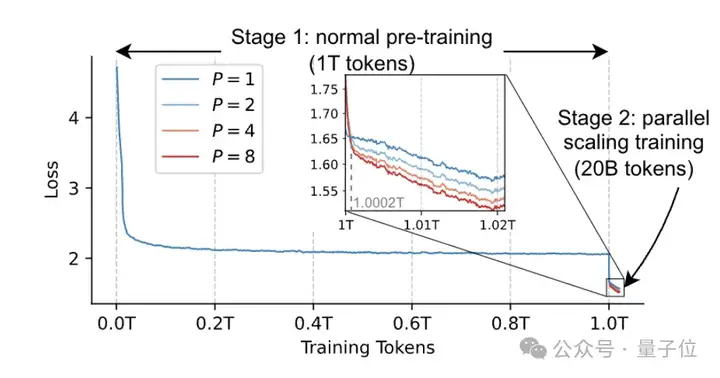

阶段1:用传统方法预训练模型至收敛(1Ttokens)。

阶段2:冻结主体参数,仅训练前缀嵌入和聚合权重(20Btokens,占总数据的 2%)。

P=8模型在GSM8K上提升34%,且与从头训练效果相当,证明少量数据即可激活并行路径的有效性。且该策略使训练成本降低约 98%

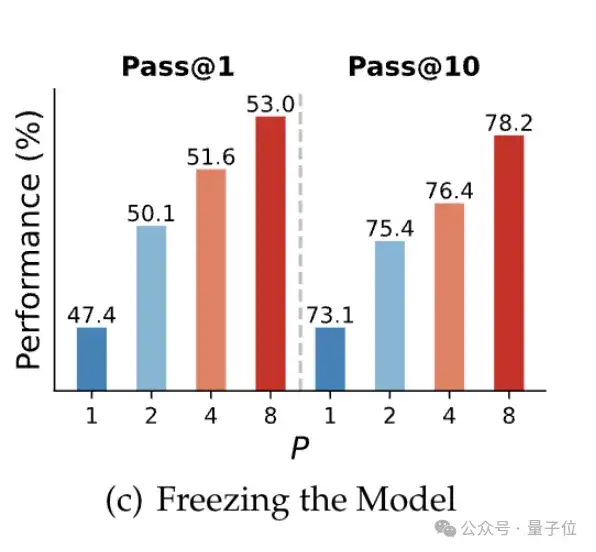

研究团队在Qwen-2.5-3B模型上进行持续预训练和参数高效微调(PEFT),仅调整前缀和聚合权重。

结果显示,在代码生成任务(HumanEval+)中PEFT 方法使Pass@1提升15%,且冻结主体参数时仍有效,证明动态调整 P 的可行性。

PARSCALE通过可学习的多路径输入、动态聚合权重、全流程并行优化,将CFG的 “双路径启发” 升级为一种通用的计算缩放范式。

感兴趣的朋友可到官方查看更多细节~

论文链接:https://arxiv.org/abs/2505.10475

代码地址:https://github.com/QwenLM/ParScale

参考链接:https://x.com/iScienceLuvr/status/1923262107845525660

文章来自于“量子位”,作者“闻乐”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0