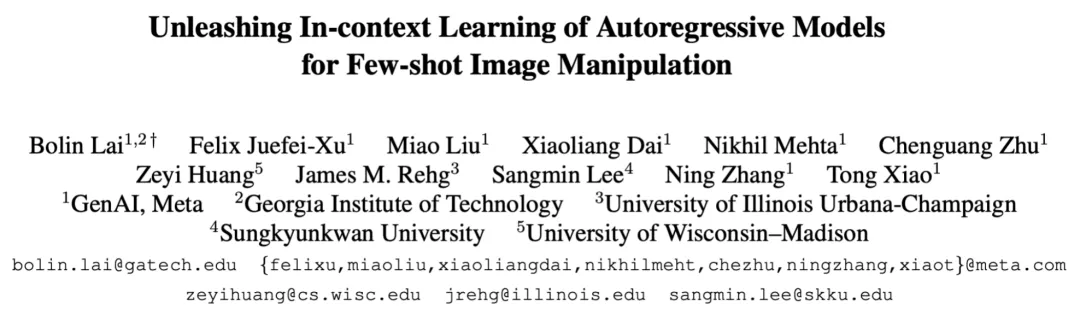

本文作者主要来自 Meta 和多所美国高校。第一作者是佐治亚理工机器学习专业的博士生赖柏霖(目前也是 UIUC 的访问学生),导师为 James Rehg 教授(已转入 UIUC),主要研究方向是多模态学习、生成模型和视频理解,并在 CVPR、ECCV、ACL 等会议发表相关论文。本文工作是赖柏霖在 Meta 的 GenAI 部门实习时完成。

近期扩散模型(diffusion model)的发展推动了基于文字引导的图像编辑(text-guided image editing)算法的快速进步,然而当用户想要的编辑方式难以用语言准确描述或者严重偏离训练集的分布时,当前模型的性能会有很大程度的下滑。

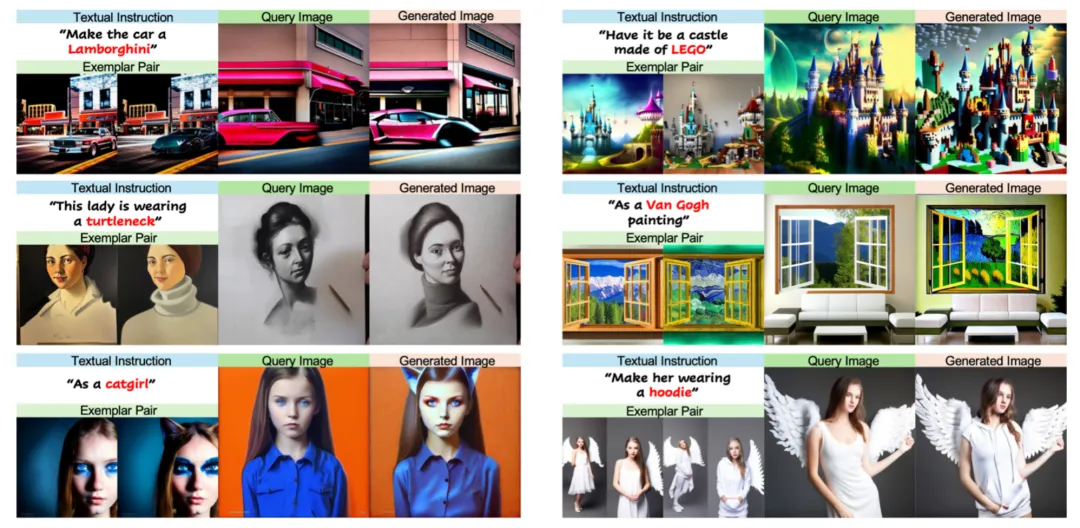

例如:我们需要模型将一辆普通的汽车变换为兰博基尼,如果训练集中没有包含类似的数据,模型很难仅通过「兰博基尼」四个字推断出其对应的形状、纹理等视觉特征,同时兰博基尼的特征也很难通过语言来详尽地描述。如今网络的快速普及导致大量新的概念不断涌现,这些没有被包含在训练数据中的新概念对于目前图像编辑模型的泛化能力是个很大的挑战。

为了解决这一难题,一个直接有效的方法是在文字指令的基础上额外提供一组或多组变换前后的图片作为样例,让模型从中学习用户想要的图像变换,即 few-shot 图像编辑。目前已有的模型都是基于扩散模型开发,然而从图片样例中学习潜在的图像变换需要模型有很强的推理能力,扩散模型生成能力很强但推理能力依然较弱。

相反地,自回归模型(autoregressive model)已经在文字、图像和语音理解等多个领域展现出强大的推理能力,尤其是基于上下文的学习能力(in-context learning)。不过目前针对于视觉生成的自回归模型只是使用最基础的自注意力机制(self-attention)来对输入输出之间进行建模,这种简单直接的方式并没有充分释放自回归模型基于上下文学习的能力,如果能针对 few-shot 图像编辑的任务来改进模型结构,那模型在这一任务上的性能会得到进一步提升。

在今年 CVPR 接收的 Highlight 论文中,来自 Meta、佐治亚理工(Georgia Tech)、伊利诺伊大学香槟分校(UIUC)、成均馆大学(SKKU)和威斯康辛大学麦迪逊分校(UW-Madison)的研究者针对 few-shot 图像编辑提出一个新的自回归模型结构 ——InstaManip,并创新性地提出分组自注意力机制(group self-attention),在此任务上取得了优异的效果。

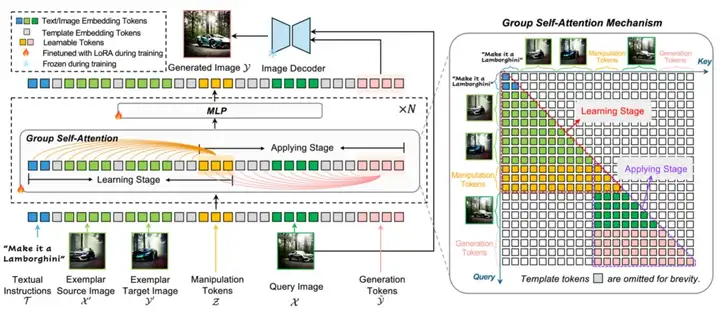

图 1:本文提出的 InstaManip 模型可以同时从文字和图片样例中学习用户想要的图像变换的特征,并能够对新的输入图片进行同样的的编辑。

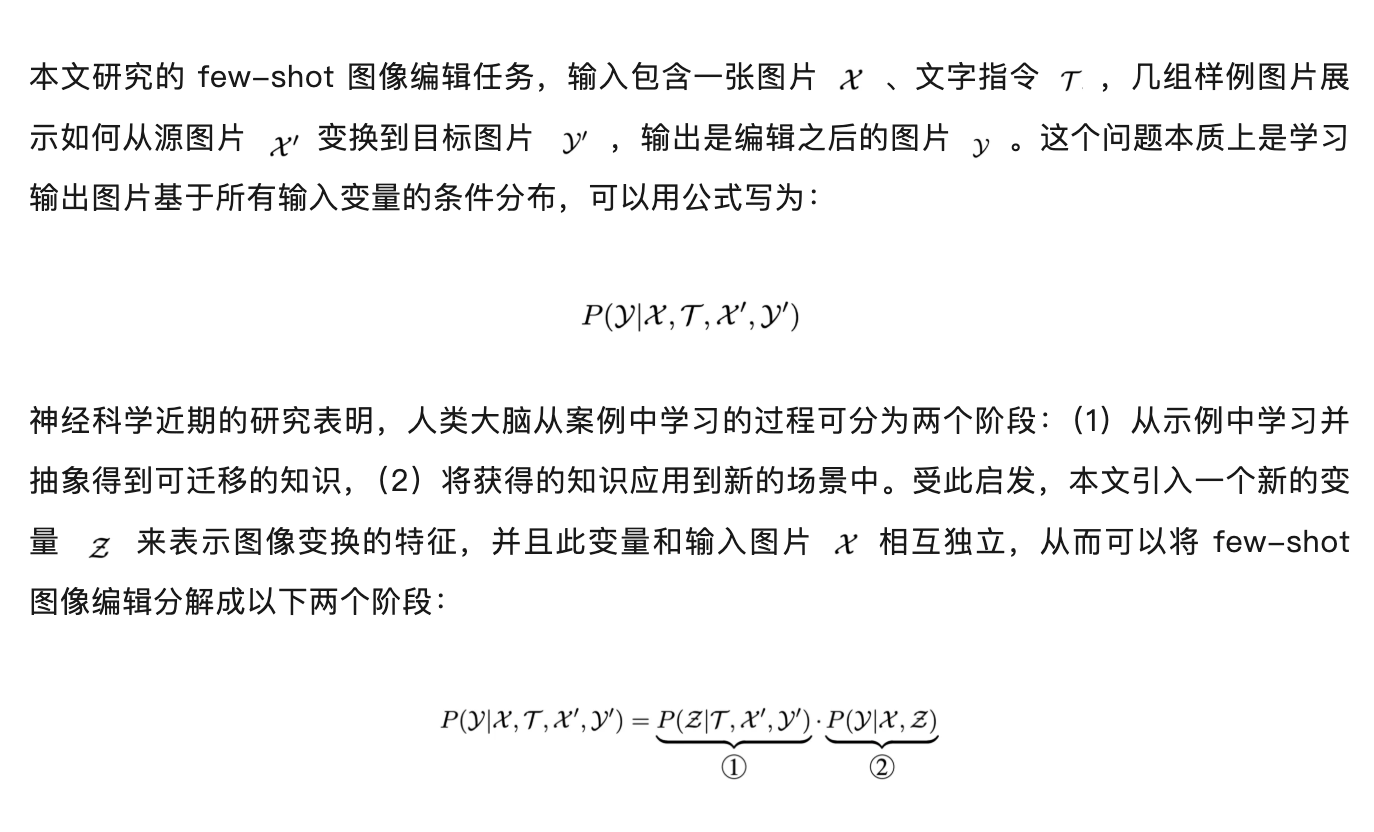

方法的理论基础

这里第一项表示学习阶段,第二项表示应用阶段,刚好和大脑的学习机制相吻合。本文提出的分组自注意力机制就是通过分别对这两个阶段进行建模,从而将这一复杂问题分解为两个更简单的子问题分而治之,因此取得更好的效果。

模型结构和方法

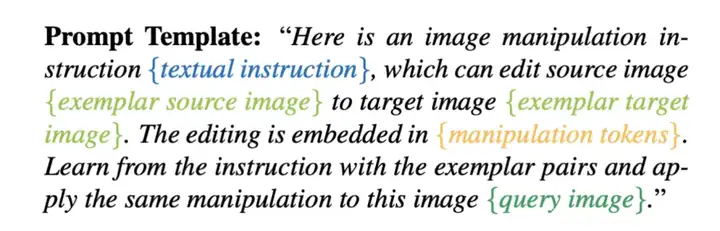

本文首先使用编码器将所有输入图片和文字转换为 token,并且嵌入到预先设定好的模板之中:

这里引入额外的 manipulation tokens 来学习并存储之前文字指令和图片示例中传递的图片编辑的特征,之后将此序列输入本文提出的模型,模型结构如图 2 所示:

图 2:模型结构(左)和分组自注意力机制(右)。

本文提出的模型为 InstaManip,核心为分组自注意力机制,同时本文作者还提出关系正则化来进一步提升性能。

分组自注意力机制

本文提出的模型结构包含多个重复的分组自注意力机制(group self-attention)层,通过引入 manipulation tokens,输入序列被分为两个组。

其中第一个组包含文字指令、示例图片和 manipulation tokens,模型在这个组中计算自注意力并更新每个 token,从而学习文字和示例图片所传递的关于图像编辑的特征,并存储在 manipulation tokens 中,即学习阶段。第二个组包含 manipulation tokens,输入图片(query image)和用于生成编辑后图片的 tokens,模型在这个组内计算自注意力来使用前一阶段存储在 manipulation tokens 的知识对新的输入图片进行变换,即应用阶段。

关系正则化

研究者发现,用户提供的示例图片可能存在噪声,在学习阶段模型可能会被示例图片中一些无关的信息误导,将这些噪声也误认为是变换的一部分而加入到生成图片中。

针对这一问题,本文提出关系正则化(relation regularization),具体做法是利用学习到的存储在 manipulation tokens 中的图像变换特征,在一批(batch)训练数据中,通过做内积得到不同变换之间两两的相似性,这种相似性可以同样通过文字指令的特征计算内积获得,之后通过 MSE 损失函数来让学习得到的相似性和通过文字指令获得的相似性趋于一致,从而驱使模型排除和当前变换无关的视觉特征的干扰。更多细节请阅读论文原文。

对比及消融实验

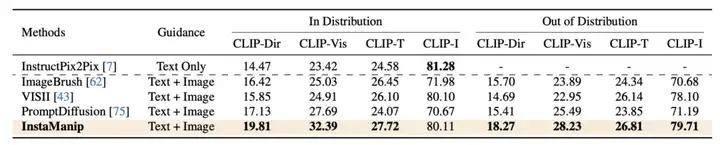

本文使用 instructpix2pix 收集的数据集,并使用两种设定和之前最好的模型进行对比。一个是 in distribution 设定,即示例图片和输入图片有类似的风格和视觉内容,另一个是 out of distribution 设定,即示例图片和输入图片的内容不同(比如一个是室内另一个是室外),这相比于前一种设定更加困难。

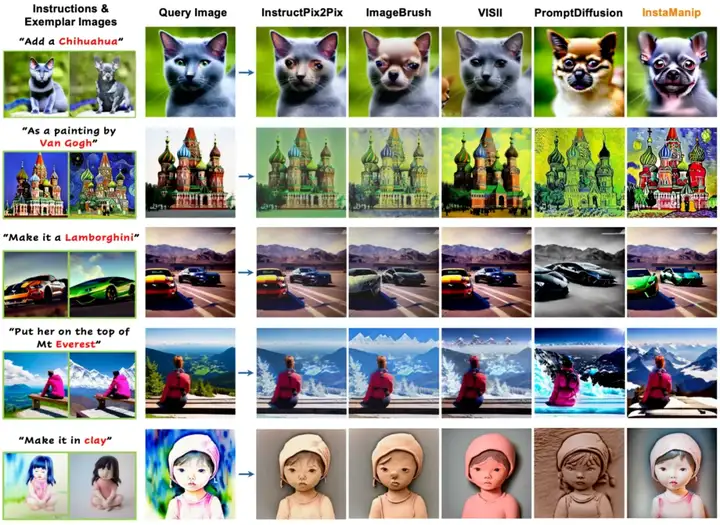

实验中,本文提出的 InstaManip 模型在两个设定下的多个指标均超过了之前最好的模型,成为新的最优方法(state of the art)。同样的优势在图 3 可视化定性对比中也同样的到体现。

表 1:本文模型和之前基于示例图片的图像编辑方法对比。

图 3:本文方法和之前模型的可视化对比。

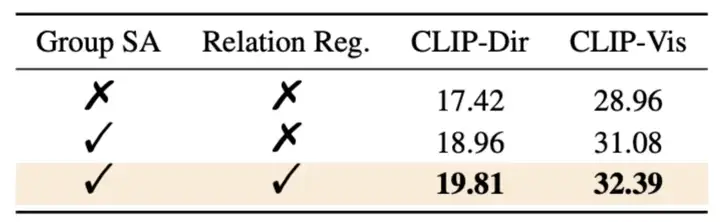

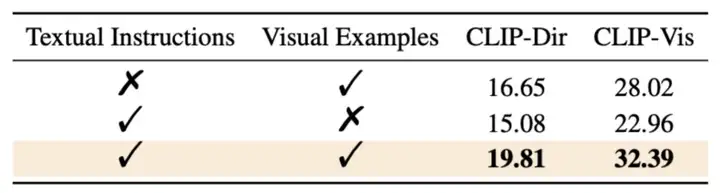

在表 2 的消融实验中,分组自注意力机制可以大幅提升自回归模型的性能,再加上关系正则化,模型的效果进一步提升,这充分验证了每个模块的有效性和必要性。在表 3 的实验中,单独使用文字指令和示例图片会导致模型性能大幅退化,说明这两种模态在图像编辑中各有优势,联合使用可达到最好的效果。

表 2:关于模型中重要模块的消融实验。

表 3:关于文字指令和样例图片的消融实验。

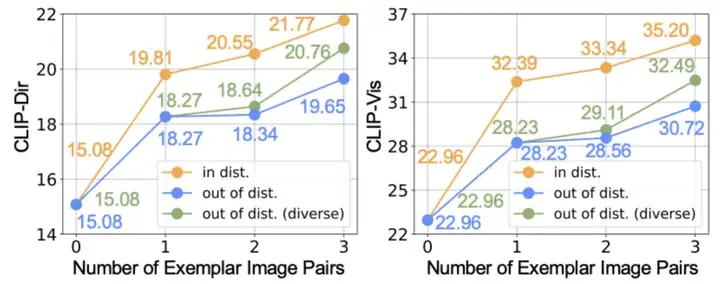

本文还对示例图片的数量和多样性进行分析,在这里研究者引入第三种实验设定 out of distribution (diverse),在此设定下多组示例图片的风格内容有显著差异,而普通的 out of distribution 设定下多组示例图片的视觉内容有很高的相似度。图 4 的实验结果说明,本文提出的模型性能可以通过增加示例图片的数量,或者提高示例图片的多样性来进一步提升。

图 4:模型性能关于示例图片数量和多样性的分析。

总结

文章来自微信公众号 “ 机器之心 ”