translate.js(https://github.com/xnx3/translate)是面向开发者打造的一个简单而强大的前端国际化工具,专注于提供极简高效的多语言切换能力。项目完全开源并允许商业使用。

仅需两行 JavaScript 代码,translate.js 即可实现 HTML 页面全自动翻译。它支持 100+ 种语种一键切换,无需修改现有页面结构或准备语言配置文件,还提供数十个微调扩展指令,可以对网页内容进行精准控制,满足一切个性化翻译需求。另外,它对 SEO 非常友好。

translate.js 现已默认支持硅基流动 SiliconCloud 平台的大模型 API 服务,开发者可免费使用 Qwen3-8b。同时,translate.js 也支持企业用户私有部署翻译 API 服务,并可自由选择 SiliconCloud 平台上的 DeepSeek-R1 & V3、Qwen3-32B 等多种大模型,提供更精准的多语言翻译能力和更智能的上下文理解。SiliconCloud 提供极速响应、稳定可靠的 API 服务,可充分满足线上场景的使用需求。

针对个人开发者,translate.js 已对硅基流动进行了深度集成,你只需在网页端 HTML 底部增加以下代码,即可使用硅基流动的 Qwen3-8b 免费模型对网页进行翻译。

<script src="https://cdn.staticfile.net/translate.js/3.15.6/translate.min.js"></script><script>

translate.service.use('siliconflow'); //设置采用硅基流动的翻译通道

translate.execute(); //触发翻译</script>

针对企业用户,translate.js 支持私有部署翻译 API 服务,以保障数据隐私及安全保密,极大提升使用体验。私有部署翻译 API 服务主要包括以下特点:

1. 一键部署

执行以下 shell 命令进行一键部署。

yum -y install wget && wget https://raw.githubusercontent.com/xnx3/translate/refs/heads/master/deploy/service.sh -O ~/install.sh && chmod -R 777 ~/install.sh && sh ~/install.sh

注:部署服务器相关规格可参考:https://translate.zvo.cn/391129.html

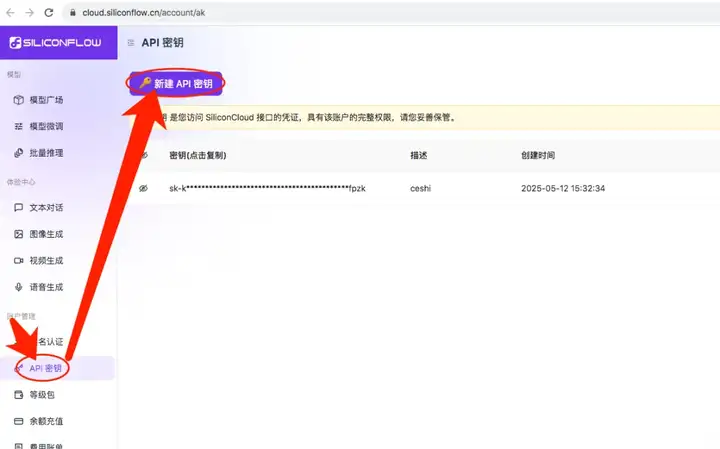

2. 获取 API 密钥

注册并登录硅基流动 SiliconCloud 平台(https://cloud.siliconflow.cn/models),新建 API 密钥。

3. 配置 API 密钥

首先,找到配置文件 /mnt/service/config.properties 进行编辑。

translate.service.leimingyun.domain=http://api.translate.zvo.cn

将上述代码注释掉(默认体验),然后增加以下配置。

# 这个url固定填写,无需改动

translate.service.openai.url=https://api.siliconflow.cn/v1/chat/completions

# 使用哪个大模型。比如你这里可以填写 Qwen/Qwen3-32B , 具体模型可以通过 https://cloud.siliconflow.cn/models 获得

translate.service.openai.model=Qwen/Qwen3-32B

# 硅基流动的 API 密钥,你上一步获取到的,填到这里

translate.service.openai.key=sk-kqpnpfhlikgacrmdab2946d28eb00ede7acd9b3axfiIadf4P81

# 进行大模型API调用线程池的程数。不懂可设置100即可。此参数的具体说明可参考 http://translate.zvo.cn/396728.html

translate.service.thread.number=100

4. 重启项目

操作完毕后,重启 translate.service 服务,执行重启命令。

/mnt/service/start.sh

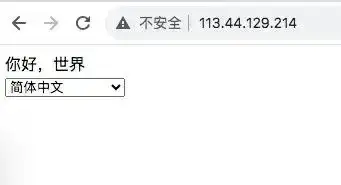

5. 访问测试

直接访问服务器 IP,选个语种切换后能被翻译,说明可正常使用了。日志等详情请查看:https://docs.siliconflow.cn/cn/usercases/use-siliconcloud-in-translate-js#%E4%BD%BF%E7%94%A8

本文展示了如何结合 translate.js 使用硅基流动 SiliconCloud 的大模型 API 服务来做网页前端的多语种翻译。

更多 SiliconCloud 使用场景与应用案例:https://docs.siliconflow.cn/cn/usercases/awesome-user-cases

文章来自于“硅基流动”,作者“SiliconCloud”。