2024 年底,Ilya Sutskever 断言「我们所知的预训练时代即将终结」,让整个人工智能领域陷入对 Scaling What 的集体追问之中。

新的思路不断涌现:推理时扩展(Test-Time Scaling)让 OpenAI 的 o 系列在数学推理上大放异彩,DeepSeek-R1 通过 GRPO 替代 PPO 实现了强化学习的突破,

强化学习 Self-play + LLM 让 AI 在游戏和代码生成中展现惊人能力,Agent 化路径则催生了能够操作浏览器、调用工具的新一代智能助理……

每一条路都在探寻可能的下一个跃迁。

在这场技术探讨中,复旦大学 / 上海创智学院的邱锡鹏教授提出了一个耐人寻味的新路径 ——Context Scaling。

与参数规模、数据量、推理计算等扩展路径不同,Context Scaling 的核心,不在于更大,而在于更「深」:

如何让 AI 真正理解并适应复杂、多变、模糊的情境(Context)。

在与机器之心的最新一次对谈中,邱锡鹏教授系统阐述了他对 AI 发展的洞察:从预训练扩展到后训练优化,再到情境智能(Contextual Intelligence)的深层转变。

邱锡鹏教授将大模型的演进总结为一个核心公式:

大模型的核心是提升给定情境(Context)条件下模型决策(Decision)的准确性,需要从大量数据中学习模型参数 θ。

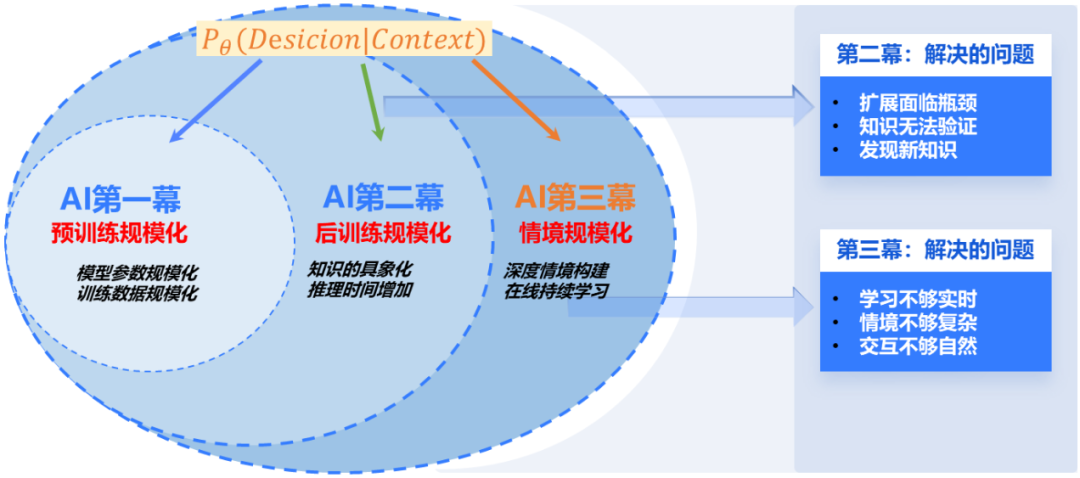

第一幕是模型规模化的胜利。 通过堆叠数据与参数,将已发现且可描述的知识「压缩」,找了很好的模型参数 θ,实现了 LLM 在通用任务上的跃升。

这一阶段诞生了 ChatGPT、MOSS、Qwen 等代表性的通用模型。但随着数据见顶、参数规模收益递减,业界普遍意识到:简单加法已无以为继。

第二幕则是后训练优化的探索,包括推理增强、知识具象化等方向,

这一阶段的核心目标是通过引入类人的问题求解过程继续提升大模型解决复杂问题的决策能力(Decision)。

强化学习、工具调用、思维链、多模态成为关键词,代表性成果包括 GPT o1/o3、DeepSeek-R1、AnyGPT 等。

在第一幕和第二幕发展到一定阶段,如何定义情境(Context)就成为继续提升模型能力的关键因素,也是大模型落地应用中最具挑战的一环。

很多模型无法正确决策的主要原因是对任务或者情境的描述不够。目前,当遇到难以描述或难以定义的问题或任务时,现有方法都显露出局限性。

例如,如何让 AI 理解一个微妙的社交暗示?如何在文化差异巨大的环境中做出恰当判断?如何处理那些无法用明确规则定义的复杂交互?

这些「暗知识」构成了人类智能的核心,却是当前技术的盲区。

接下来的第三幕 Context Scaling,旨在解决上述问题,并由此实现「情境智能」。

这一阶段关注的,让 AI 能够理解并适应足够丰富、真实、复杂、多变的情境信息,从而在模糊不清的世界中作出合情合理的判断。

Context 深层内涵

捕获难以描述的「暗知识」

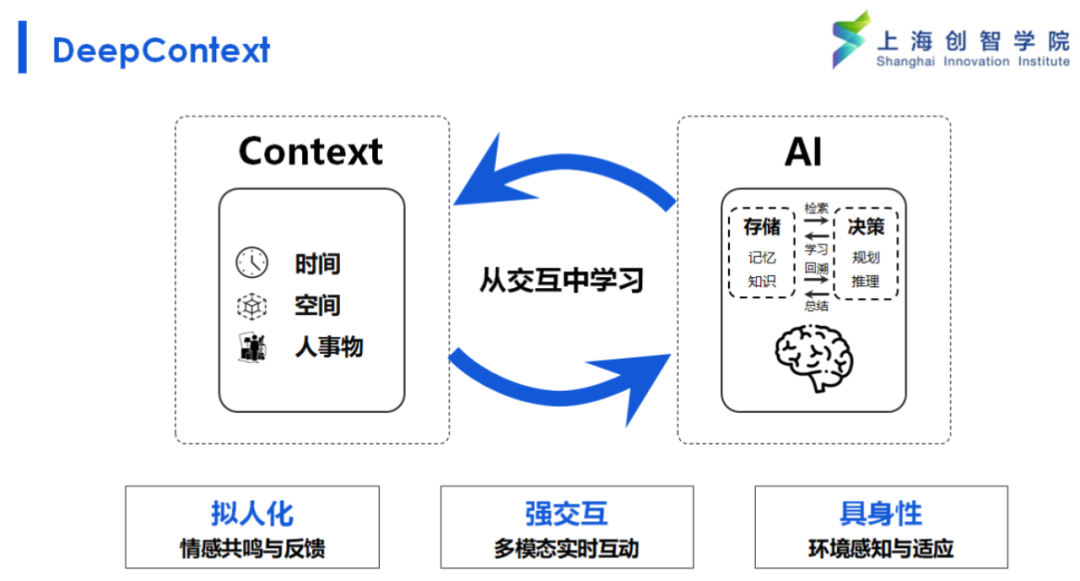

在邱锡鹏教授的定义中,Context 远非当前大模型所使用的「上下文窗口」那么简单,它是一种多维、动态、跨模态的信息结构,

其中可能包含时间信息、空间信息、参与者状态、目标意图,甚至是未明说但语境暗示的文化规则与人际默契。

最关键的,是 Context Scaling 对「暗知识」的捕获能力。所谓暗知识(Tacit Knowledge),指的是那些人类习得但难以清晰表述的能力,包括但不限于:

举例来说:当一个人说「不要」,只有身处完整情境,AI 才能判断这句话是真正的拒绝、玩笑,还是一种反向请求。

在多模态、多轮对话、现实互动任务中,这种差别往往决定智能的成败。

正是这些难以言述的隐性知识,构成了人类智能的底色。而 AI 若能通过 Context 捕获这些结构模糊、路径多变的信息,将实现真正意义上的智能突破。

同时,这也是对 AI 安全发展的核心考量。

一个耳熟能详的例子是「回形针悖论」—— 当大模型仅仅按照生产更多回形针的目标行事时,可能会不择手段地获取资源,最终威胁人类社会。

Context Scaling 通过让 AI 理解复杂的社会情境和隐含价值观,能够在没有明确禁令的情况下,基于对情境的深度理解,做出符合人类价值观的判断。

三大技术支柱

交互、具身、拟人化

邱锡鹏教授表示,Context Scaling 之所以能成为一个独立的技术路径,源于它拥有独特的三项能力支柱:

1. 强交互性(Strong Interactivity)

情境智能的本质,在于「从交互中学习」,这包括两个层面,一是与环境的强化学习交互,AI 需要在复杂环境中行动、观察反馈、调整策略,

但 Context Scaling 要求更深层的交互 —— 不仅要学会如何行动,更要理解为什么这样行动。

二是与人类的多模态协作,包括语言澄清、任务讨论、情绪共鸣等。当前 Gemini Deep Research 等助理已经能够询问用户的具体需求,

但 Context Scaling 要求 AI 能够理解用户的情绪状态、文化背景,甚至未说出口的期望。只有能不断从互动中汲取信息的系统,才具备面对复杂情境的应变能力。

2. 具身性(Embodiment)

AI 要能交互,要理解所处世界,意味着智能体必须具备「主体性」,这样才能感知、行动、记忆与学习。

但这并不意味着必须具备现实物理世界的完整身体,虚拟环境中的持续任务、AR 场景中的决策代理,也是对这一理念的试验场。

3. 拟人化(Anthropomorphizing)

这是 Context Scaling 独有的特征 ——AI 需要具备类人的情感共鸣和反馈能力。

这不是简单的情感模拟,而是对人类偏好和行为模式的深度理解,比如理解和回应人类的情绪状态,掌握复杂的人际交往规则,懂得何时保持距离、何时表达关心,

以及具备文化敏感性,知晓在不同文化背景下调整交互方式和价值判断。

为了实现上述三点,Context Scaling 要求模型具备持续学习的能力。

不同于传统的持续学习,情境智能的持续学习能力更强调在模型参数相对固定的情况下,通过 Context 的积累和更新,实现能力的持续提升。

换句话说,是在使用过程中持续积累经验、调整策略。

「这也更像是人类的成长与发展,在先天基因确定的情况下,通过后天学习以及不断适应新的环境,根据具体情境调整行为策略。」

要让 Contextual Intelligence 成为现实,技术上面临几大挑战:

Context Scaling 所需的训练目标与损失函数正在重塑 AI 学习本质。

大规模情境数据的生成,需要借助 AI 自身合成场景、任务、交互脚本的能力。

邱锡鹏教授强调,Context Scaling 是并非替代其他 Scaling 路线,而是对其构成补充与整合。

例如,Test-Time Scaling 关注输出阶段的计算效率,Context Scaling 关注输入的质量与结构,两者是正交互补的,

更丰富的上下文信息能够为推理时计算提供更好的基础。

与 Agent 路径相比,Context Scaling 更多对任务定义层的重新设想,它强调的是智能体理解复杂情境的核心能力,

这种能力可以通过各种 Agent 架构来实现,但其本身超越了具体的工具使用和任务执行。

Context Scaling 也为强化学习提供了新的环境定义,不再是简单的状态 - 动作 - 奖励循环,而是包含丰富情境信息的复杂交互空间。

通往 AGI 的关键一步

「在大模型时代,如果研究只是在已有路径上做微调,那将失去方向感。」邱锡鹏教授说:「研究者需要去定义那些 “大家都意识到但没人清晰表达” 的问题。」

在这场 Scaling What 的集体探索中,Context Scaling 将推理增强、多模态融合、强化学习等看似分散的技术路径统一在「情境理解」这一核心目标之下。

智能的本质,也许就在于面对复杂世界时那份模糊中的准确、不确定中的判断、冲突中的协调。

这个意义上,Context Scaling 不仅是大模型发展的下一幕,更可能是通向 AGI 的关键一步。

文章来自于微信公众号 “机器之心”,作者 :闻菲

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner