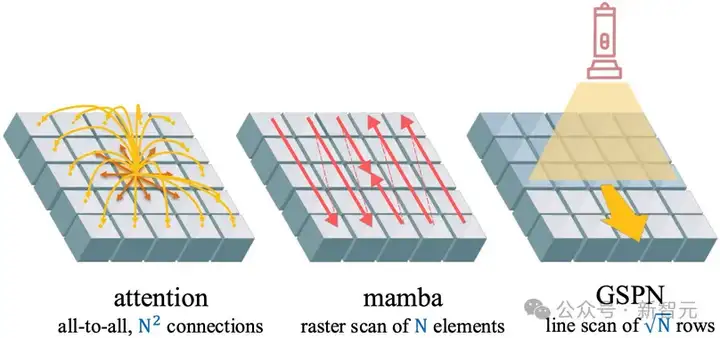

GSPN是一种新型视觉注意力机制,通过线性扫描和稳定性-上下文条件,高效处理图像空间结构,显著降低计算复杂度。通过线性扫描方法建立像素间的密集连接,并利用稳定性-上下文条件确保稳定的长距离上下文传播,将计算复杂度显著降低至√N量级。

Transformer 及其核心的注意力机制在自然语言处理和计算机视觉等领域带来了革命性进展,展现出强大的深度上下文建模和数据间复杂依赖关系捕捉能力。

然而,其在处理视觉数据时面临两大核心挑战:

为克服效率瓶颈,近期研究如线性注意力和状态空间模型(如 Mamba) 致力于将复杂度降低至线性。

然而,这些方法在提升效率的同时,依然未能有效保留和利用图像的关键二维空间结构信息,本质上仍是序列化处理。

尝试将一维光栅扫描(raster scan)扩展至二维的线扫描方法(line scan)是增强空间连贯性的一种思路。

但二维线性传播面临严峻挑战:标量权重变为连接像素与前序邻居的矩阵权重。在传播过程中累积的矩阵乘法极易导致稳定性问题——矩阵特征值过大引发指数增长(不稳定),过小则导致信号迅速衰减(信息消失)。

因此,在二维空间中同时实现稳定性和维持长距离上下文的有效传播,是一个亟待解决的难题。

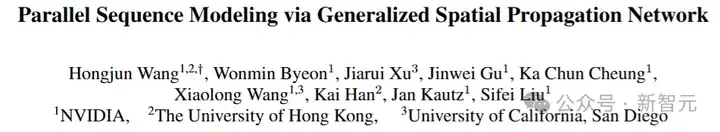

针对上述挑战,来自英伟达、香港大学和UCSD的研究人员提出广义空间传播网络(GSPN),一种专为视觉任务优化的新型注意力机制,其核心优势在于直接操作空间连贯的图像数据,通过高效的线扫描方法建立密集的像素间连接。

论文地址:https://arxiv.org/abs/2501.12381

项目主页:https://whj363636.github.io/GSPN/

代码:https://github.com/NVlabs/GSPN

GSPN成功的关键在于其提出的稳定性-上下文条件(Stability-Context Condition),该条件确保了跨二维序列的稳定长上下文传播,并将具有N个元素的图像的复杂度显著降低至√N 量级。

因此,GSPN能够在保持卓越空间保真度的同时,实现极高的计算效率,并在ImageNet分类、类引导图像生成及文本到图像生成等任务中达到先进性能。例如,在生成16K图像时,GSPN相比基于softmax注意力的SD-XL加速超过84倍。

论文第一作者为王弘焌,香港大学统计系博士三年级学生,目前为NVIDIA research intern,研究方向包括高效基础模型、开放世界理解。

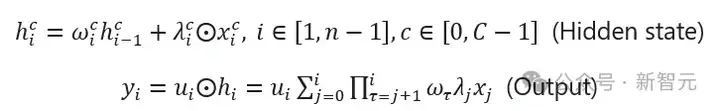

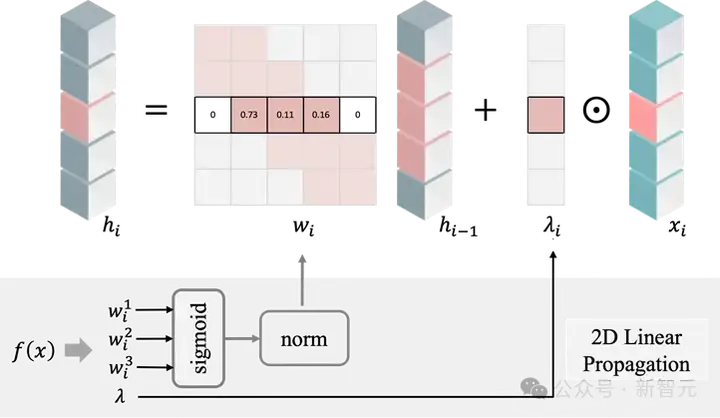

二维线性传播

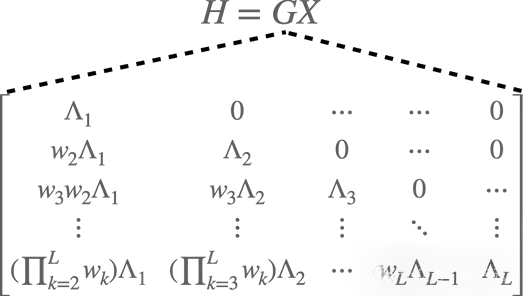

二维线性传播通过逐行或逐列的顺序处理进行。对于二维图像,其遵循线性循环过程,隐藏层通过前一行的隐藏状态和当前输入计算得出。

将隐藏状态和输入的行向量连接成序列后,可表示为输入与一个下三角矩阵的乘积,输出则为输入的加权和,该公式可类比为带因果掩码的非归一化线性注意力机制,其中额外的传播矩阵调制注意力强度。

稳定性-上下文条件

在传播过程中上述累积的矩阵乘法极易导致稳定性问题。

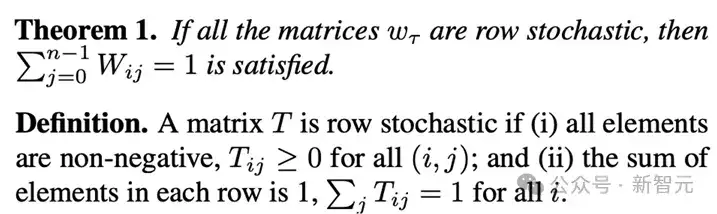

为实现稳定且有效的长距离传播,研究人员引入定理1和定理2(统称为稳定性-上下文条件)。

定理1指出,若所有矩阵均为行随机矩阵,则满足各元素加权和为1

定理2表明,行随机矩阵可确保传播过程的稳定性。行随机矩阵的定义为元素非负且每行元素之和为1,乘积仍为行随机矩阵,这为稳定传播提供了数学基础。

传播层的关键实现

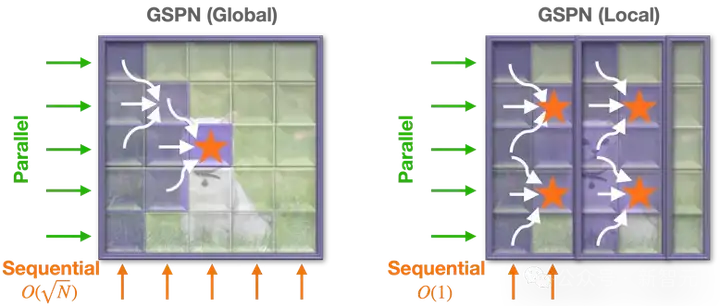

对于二维线性循环过程,研究人员对前序状态的三邻居连接来计算当前时刻的隐藏层(每个像素连接前一行的三个相邻像素)以提高参数效率。

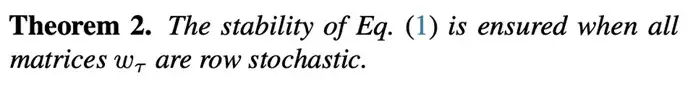

文中同时还提出GSPN的两种变种,全局GSPN和局部GSPN:

全局GSPN捕捉整个序列的长距离依赖,局部GSPN通过将空间维度划分为非重叠组来限制传播序列长度,提高效率。

最后,通过四方向集成确保全像素连接,形成密集成对连接。

对每个传播方向的矩阵元素应用 sigmoid 函数并归一化,以保证行随机性。

通过定制的CUDA内核实现线性传播层,采用并行化结构,在批量、通道和与传播方向正交的行/列上实现全并行化,有效减少内核循环长度,实现高效可扩展的线性传播。

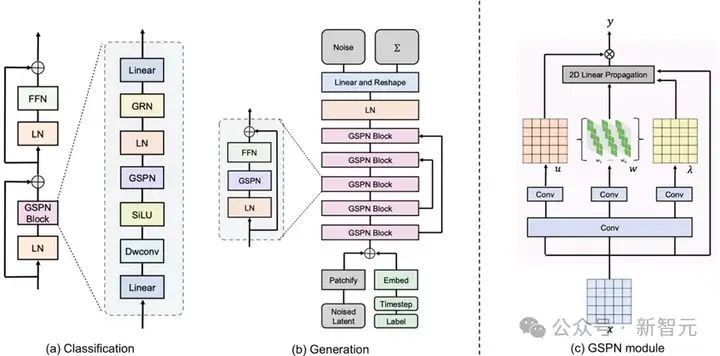

GSPN架构

GSPN是一个通用序列传播模块,可无缝集成到各种视觉任务的神经网络中。针对判别任务和生成任务设计了不同的GSPN块,均基于核心GSPN模块构建:

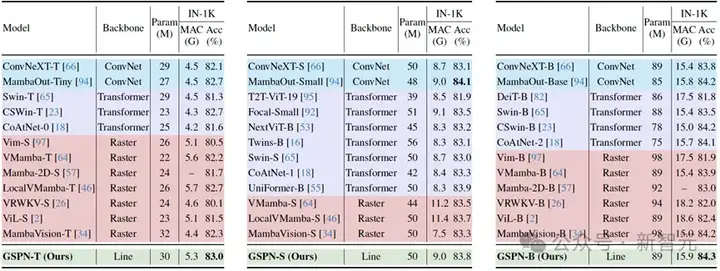

图像分类

在ImageNet-1K分类任务中,GSPN在参数数量相当的情况下优于现有序列模型,GSPN在从小型到基础配置的模型规模上表现出一致的性能提升,证明了其可扩展性。

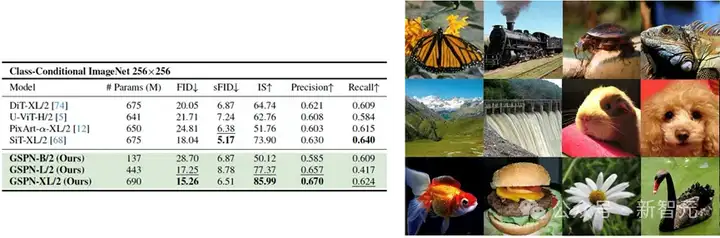

类条件图像生成

与多种基线方法相比,GSPN-XL/2在ImageNet 256×256类条件生成任务中建立了新的最先进性能,GSPN-L/2仅使用先前模型65.6%的参数就获得了更优的FID和IS分数,GSPN-B/2在收敛时仅使用DiT-XL/2 20.3%的参数就实现了有竞争力的性能,验证了GSPN的效率和可扩展性。

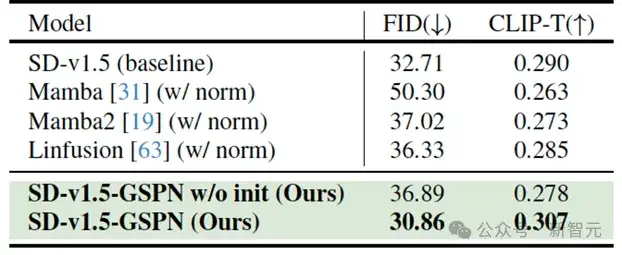

文本到图像生成

GSPN由于其归一化权重满足稳定性-上下文条件,无需额外归一化即可适应任意分辨率,在不使用任何预训练权重且在相同训练轮数内达到了与baseline相当的性能。

此外,GSPN在单块A100 GPU上生成16K×8K分辨率图像可实现约84倍的加速。

研究人员提出了广义空间传播网络(GSPN),这是一种用于视觉任务中并行序列建模的新型注意力机制。

通过稳定性-上下文条件确保稳定且上下文感知的传播,GSPN在保持效率的同时将序列复杂度减少到√N

实验表明,GSPN在多个视觉任务中实现了最先进的结果和显著的加速,展示了其在视觉任务中的效率和潜力。

未来,GSPN有望在更多视觉领域及视觉多模态模型中发挥重要作用,推动下一代视觉理解和生成基础结构的发展。

参考资料:

https://arxiv.org/abs/2501.12381

文章来自于“新智元”,作者“LRST”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI