作者介绍:本篇文章的作者团队来自美国四所知名高校:西北大学、乔治亚大学、新泽西理工学院和乔治梅森大学。

第一作者束东与共同第一作者吴烜圣、赵海燕分别是上述高校的博士生,长期致力于大语言模型的可解释性研究,致力于揭示其内部机制与 “思维” 过程。

通讯作者为新泽西理工学院的杜梦楠教授。

在 ChatGPT 等大语言模型(LLMs)席卷全球的今天,越来越多的研究者意识到:我们需要的不只是 “会说话” 的 LLM,更是 “能解释” 的 LLM。

我们想知道,这些庞大的模型在接收输入之后,到底是怎么 “思考” 的?

为此,一种叫做 Sparse Autoencoder(简称 SAE) 的新兴技术正迅速崛起,成为当前最热门的 mechanistic interpretability(机制可解释性) 路线之一。

最近,我们撰写并发布了第一篇系统性的 SAE 综述文章,对该领域的技术、演化和未来挑战做了全面梳理,供关注大模型透明性、可控性和解释性的研究者参考。

A Survey on Sparse Autoencoders: Interpreting the Internal Mechanisms of Large Language Models

https://arxiv.org/pdf/2503.05613

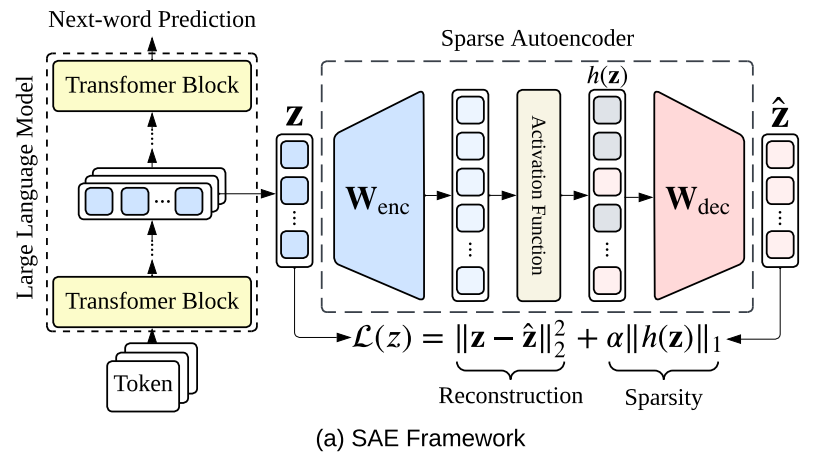

(图 1):该图展示了 SAE 的基本框架。

简单来说,LLM 内部的许多神经元可能是“多义的”,意思是它们同时处理好几个不相关的信息。

在处理输入时,LLM 会在内部生成一段高维向量表示,这种表示往往难以直接理解。

然后,如果我们将它输入一个训练好的 Sparse Autoencoder,它会解构出若干稀疏激活的“特征单元”(feature),

而每一个feature,往往都能被解释为一段可读的自然语言概念。

举个例子:假设某个特征(feature 1)代表 “由钢铁建造的建筑”,另一个特征(feature 2)代表 “关于历史的问题”。

当 LLM 接收到输入 “这座跨海大桥真壮观” 时,SAE 会激活 feature 1,而不会激活 feature 2。

这说明模型 “意识到” 桥是一种钢结构建筑,而并未将其理解为历史类话题。

而所有被激活的特征就像拼图碎片,可以拼接还原出原始的隐藏表示(representation),让我们得以窥见模型内部的 “思维轨迹”。

这也正是我们理解大模型内部机制的重要一步。

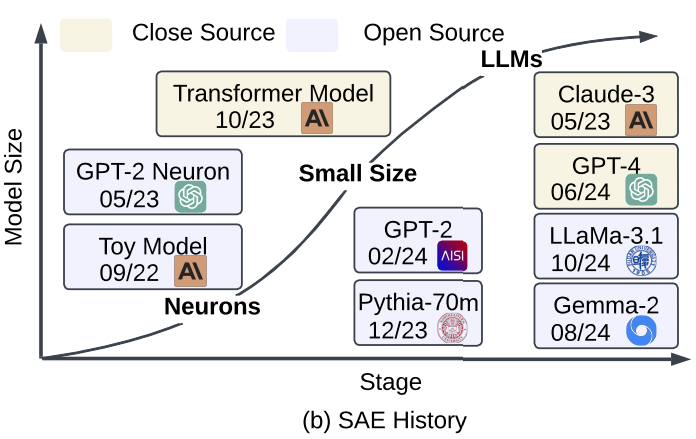

(图 2):该图展示了 SAE 的发展历史。

为什么大家都在研究 SAE?

过去主流的可解释方法多依赖于可视化、梯度分析、注意力权重等 “间接信号”,这些方法虽然直观,但往往缺乏结构性和可控性。

而 SAE 的独特优势在于:它提供了一种结构化、可操作、且具语义解释力的全新视角。

它能够将模型内部的黑盒表示分解为一组稀疏、具备明确语义的激活特征(features)。

更重要的是,SAE 不只是可解释性工具,更可以用于控制模型怎么想、发现模型的问题、提升模型的安全性等一系列实际应用。

当前,SAE 已被广泛应用于多个关键任务:

这种 “解释 + 操控” 的结合,也正是 SAE 能在当前 LLM 可解释性研究中脱颖而出的关键所在。

目前包括 OpenAI、Anthropic、Google DeepMind 等机构都在推进 SAE 相关研究与开源项目。

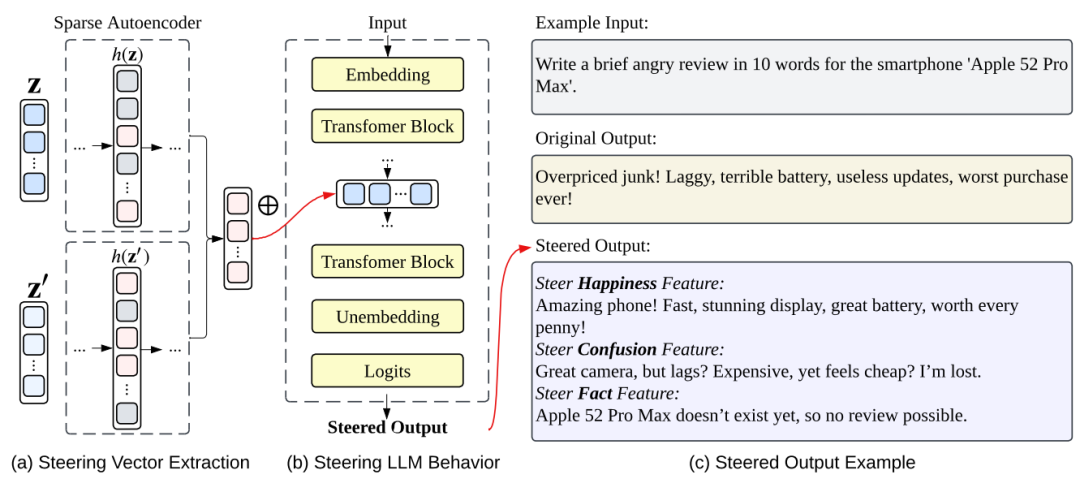

(图 3):该图演示了如何通过 SAE 操控模型输出,实现对大语言模型行为的定向引导。

本文有哪些内容?

作为该领域的首篇系统综述,我们的工作涵盖以下几个核心部分:

1. Technical Framework of SAEs(SAE 的技术框架)

本部分系统介绍了 SAE 的基本结构及其训练流程,它是一种特殊的神经网络。具体包括:

a.编码器:把 LLM 的高维向量表示 “分解” 成一个更高维并且稀疏的特征向量。

b.解码器:根据这个稀疏特征向量,尝试 “重建” 回原始的 LLM 信息。

c.稀疏性损失函数:确保重建得足够准确,并且特征足够稀疏。

同时我们总结了现有的常见架构变体与改进策略。

例如解决收缩偏差(shrinkage bias)的 Gated SAE,通过直接选择 Top-K 个激活来强制稀疏性的 TopK SAE,等等。

2. Explainability Analysis of SAEs(SAE 可解释性分析)

总结当前主流的解释方法,旨在将 SAE 学习到的稀疏特征用自然语言进行描述,从而把模型的 “抽象思维” 转化为人类可理解的见解 。

这些方法主要分为两大类:

a.输入驱动:寻找那些能最大程度激活某个特征的文本片段。通过总结这些文本,我们就能大致推断出这个特征代表什么意思(如 MaxAct、PruningMaxAct)。

b.输出驱动:将特征与 LLM 生成的词语联系起来。

例如,一个特征激活时,LLM 最可能输出哪些词,这些词就能帮助我们理解这个特征的含义(如 VocabProj、Mutual Info)。

3. Evaluation Metrics and Methods(评估指标与方法)

评估 SAE 就像评估一个工具:既要看它内部构造是否合理(结构评估),也要看它实际用起来有没有效果(功能评估)。

a.构性评估:检查 SAE 是否按设计工作,比如重建的准确度如何,稀疏性是否达到要求(如重构精度与稀疏度)。

b.功能评估:评估 SAE 能否帮助我们更好地理解 LLM,以及它学习到的特征是否稳定和通用(如可解释性、健壮性与泛化能力)。

4. Applications in Large Language Models(在大语言模型中的应用)

SAE 不仅能帮助我们理解 LLM,还能实际操作它们。我们展示了 SAE 在模型操控、行为分析、拒答检测、幻觉控制、情绪操控等方面的实际应用案例与前沿成果。

5. 与 Probing 方法的对比分析

除了 SAE,还有一种叫做 “Probing(探针)” 的方法也被用于理解 LLM。本文比较了 SAE 与传统的 Probing 技术在模型操纵和特征提取等方面的优势与不足。

尽管 Probing 方法在某些方面表现出色,但 SAE 作为一种新兴的机制可解释性方法,具有其独特的潜力。

然而,研究也指出,在某些复杂场景(如数据稀缺、类别不平衡等)下,SAE 在提供一致优势方面仍有很长的路要走。

6. 当前研究挑战与未来方向

尽管 SAE 前景广阔,但仍面临一些挑战,如:语义解释仍不稳定;特征字典可能不完整;重构误差不可忽视;训练计算成本较高。

同时也展望了未来可能的突破点,包括跨模态扩展、自动解释生成、架构轻量化等。

结语:从 “看得懂” 到 “改得动”

在未来,解释型 AI 系统不能只满足于可视化 attention 或 saliency map,而是要具备结构化理解和可操作性。

SAE 提供了一个极具潜力的路径 —— 不仅让我们看到模型 “在想什么”,还让我们有能力去 “改它在想什么”。

我们希望这篇综述能为广大研究者提供一个系统、全面、易于参考的知识框架。

如果您对大模型可解释性、AI 透明性或模型操控感兴趣,这将是一篇值得收藏的文章。

文章来自于微信公众号 “机器之心”,作者 :束东、吴烜圣、赵海燕

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI