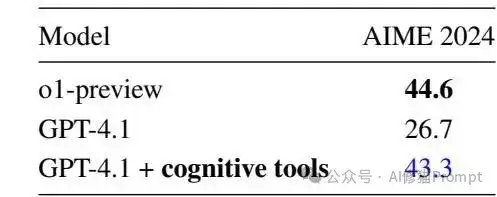

当LangChain在6月23日发布那篇著名的Context Engineering博客时,IBM Research的研究者们早在10天前就已经用严格的学术实验证明了这套方法的有效性。只不过那时候上下文工程这一概念还不像现在这么火,研究者们发明的Cognitive Tools仅用Prompt就让GPT-4.1的数学推理能力从26.7%飙升到43.3%,关键问题是,它用扎实的科学证据回击了那些认为Context Engineering只是"造新词"的质疑声。

自从OpenAI的o1模型横空出世,整个AI圈都在疯狂追赶推理能力的军备竞赛。DeepSeek-R1证明了链式思维加强化学习的有效性,但问题来了:强化学习真的是唯一出路吗?IBM的研究者们发现了一个有趣的现象,基础模型可能早就具备了强大的推理能力,只是需要合适的方法来"唤醒"它们。这就像是一把锁配一把钥匙,关键在于找到正确的开启方式。

四把认知钥匙,解锁大模型推理潜能

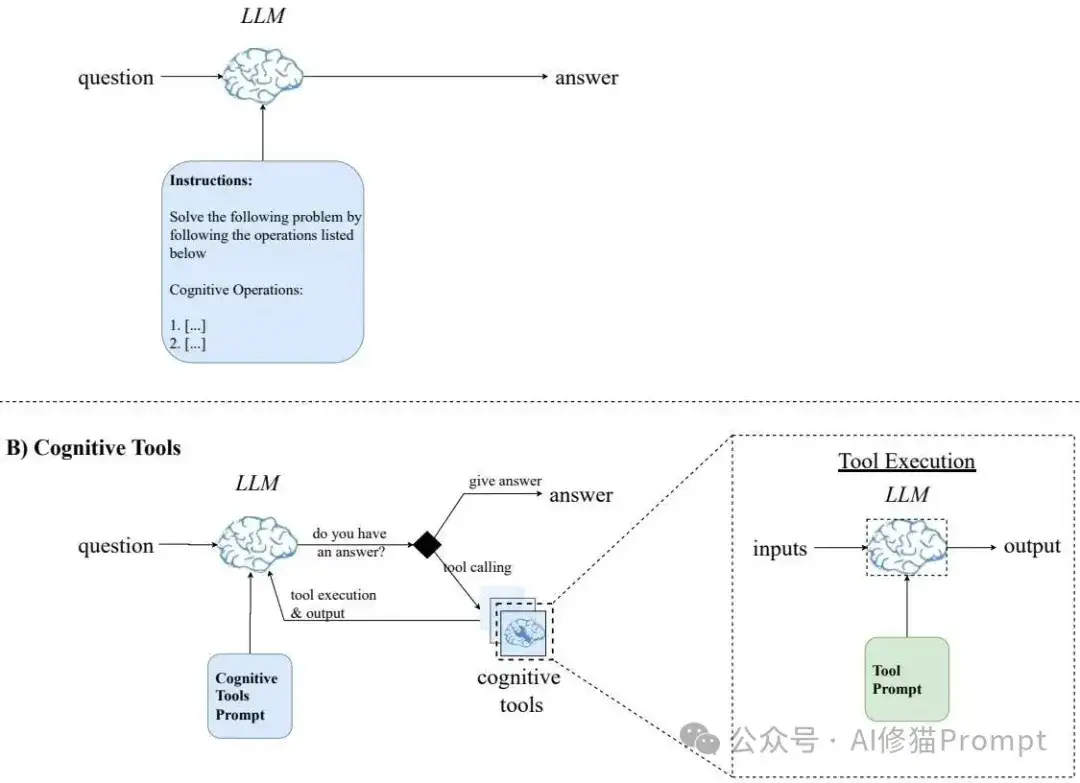

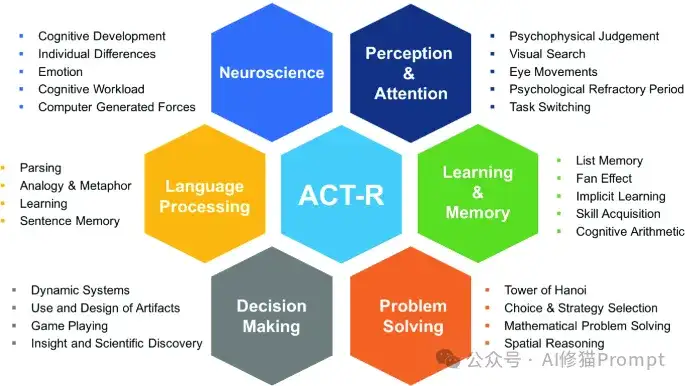

IBM研究者们设计了四个"认知工具",每一个都对应着人类推理过程中的关键环节。理解问题工具负责分解复杂问题,识别核心概念和相关技术;回忆相关工具提供类似问题的解答案例作为参考;检查答案工具实现自我反思,检查推理过程中的错误;回溯工具则在遇到错误时,帮助模型回到正确步骤并探索新的路径。这四个工具的设计灵感来自ACT-R认知架构理论,将人类认知的模块化特性完美移植到了大模型身上。

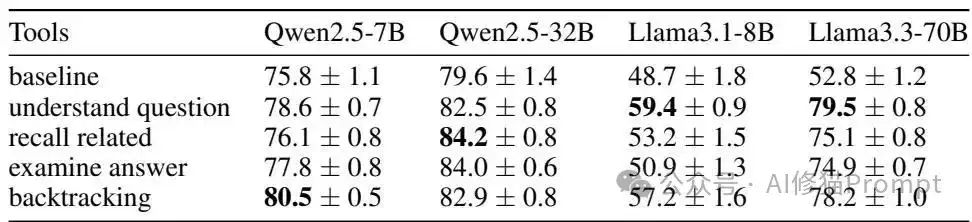

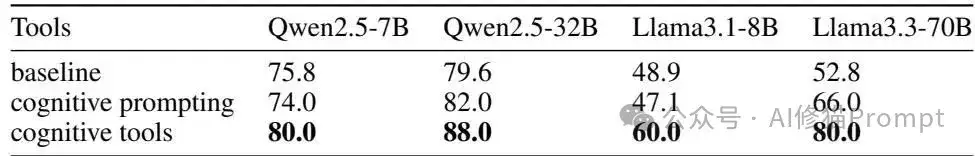

每个认知工具都展现出了独特的价值。在Smolbenchmark数据集(来自HuggingFace的Smolagents Benchmark-v1,包含50个数学推理问题的测试集)的测试中,不同的工具在不同模型上发挥着各自的优势:对于Llama3.3-70B,"理解问题"工具带来了26.7%的性能提升;"回溯"工具在多个模型上都表现出色。这证明了模块化设计的核心思想——专业化分工能带来整体效能的提升。

ACT-R理论:从心理学实验室到AI工程实践

ACT-R(Adaptive Control of Thought-Rational)是John Anderson等人开发的认知架构理论,核心思想是人类认知由多个模块化组件协调工作。这套理论将记忆分为声明性记忆(存储事实)和程序性记忆(存储技能),通过产生式规则来定义认知操作。IBM的研究者们巧妙地将这些理论原则转化为现代LLM的工具调用框架,让抽象的心理学理论变成了可以直接运行的代码。

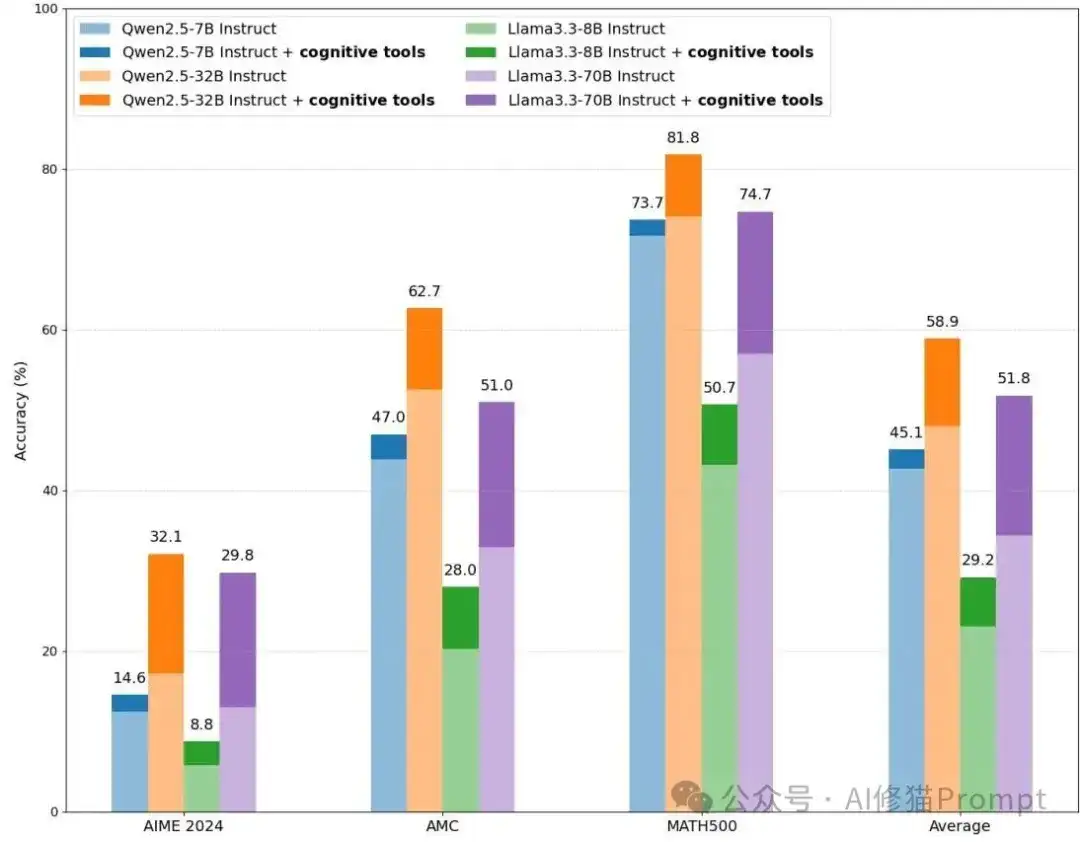

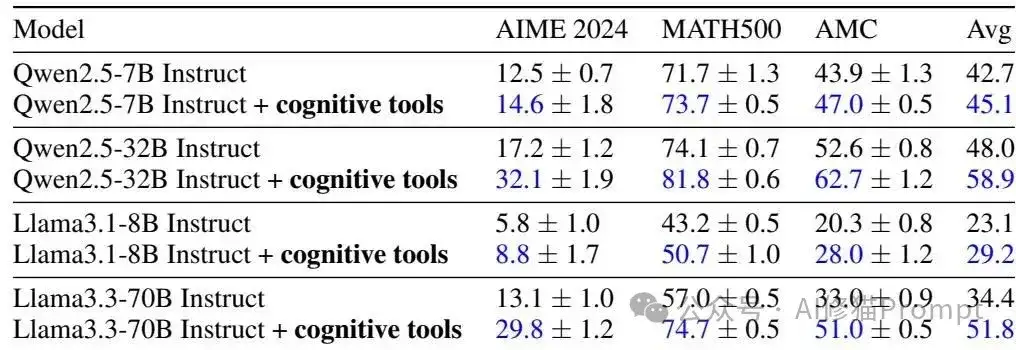

实验数据不会说谎:62%的性能提升从何而来

在AIME 2024这个高难度数学竞赛数据集上,结果让人印象深刻。Qwen2.5-32B的准确率从17.2%跃升到32.1%,Llama3.3-70B从13.1%提升到29.8%,而GPT-4.1更是从26.7%达到了43.3%,几乎追平了o1-preview的44.6%。这不是靠堆算力或者更多训练数据实现的,而是通过更聪明的上下文工程。每个认知工具都有独立的提示模板,在被调用时会在隔离的环境中执行,避免了不同推理步骤之间的干扰。

认知工具框架的实战应用

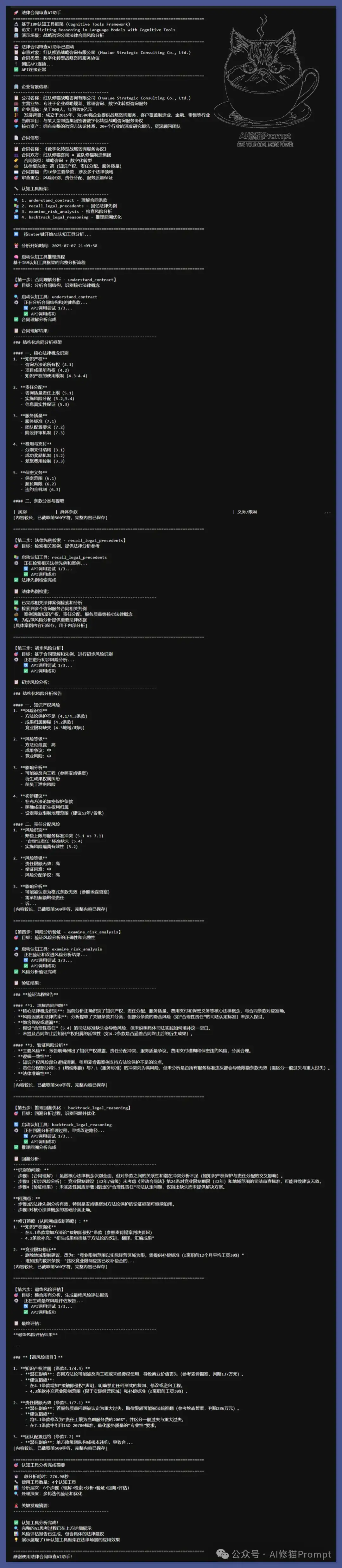

为了验证IBM认知工具框架在实际业务场景中的效果,我开发了一个商业合同审查AI助手。这个Agent完全基于论文中的四个认知工具(understand_contract、recall_legal_precedents、examine_risk_analysis、backtrack_legal_reasoning)进行设计,每个工具都有独立的提示模板和专门的认知职责。

测试场景选择了一个极具挑战性的现实业务案例:战略咨询公司的数字化转型服务合同风险审查。我构建了一个虚拟的"红队修猫战略咨询有限公司",它需要与蓝队修猫制造集团签署一份涉及3200万元的数字化转型咨询协议。这份合同包含了咨询行业的典型法律风险点:知识产权保护、责任分配、服务质量标准、保密要求等复杂条款。

AI助手在4分钟的分析过程中,准确识别出了8个高风险项目(如责任上限条款过宽、知识产权保护不足等)、6个中风险项目和3个低风险项目。更重要的是,每个风险点都配有详细的法律依据、潜在影响分析和具体的修改建议。整个分析过程展现出了专业的法律思维和系统性的风险评估能力。我会将这个Agent的完整代码和提示词模板分享到交流群里,欢迎您加入讨论!此外,近期我还会发布一篇系统性介绍Context Engineering的深度文章,敬请关注。之前关于认知提示的文章您也可以看下《最新认知Prompt,模拟人类认知操作COP来增强LLM问题解决能力 | ICLR2025》,公众号里还有很多关于“认知”方面的文章,您有兴趣也可以看下。

模块化设计的威力:为什么比单体提示更有效

传统的认知提示方法虽然也强调结构化,但它本质上还是一个大而全的单体提示。IBM的认知工具则完全不同,它们是真正的模块化设计。每个工具都有自己的"专业领域",只处理特定类型的认知操作。这就像是把一个全能工程师拆分成了四个专业技师,每个人都专注于自己最擅长的领域。实验结果证明,这种模块化方法在所有测试模型上都显著优于传统的认知提示方法。

不只是数学题:认知工具的应用前景

虽然这项研究主要在数学推理任务上进行验证,但认知工具的应用潜力远不止于此。您可以想象,在代码生成场景中,"理解问题"工具可以分析需求规格,"回忆相关"工具可以检索相似的代码模式,"检查答案"工具可以进行代码审查,"回溯"工具可以处理调试过程。这套框架的通用性让它有可能成为下一代AI应用的标准组件。

逼近o1-preview:认知工具的真实实力

最令人震撼的发现是,当GPT-4.1配备了认知工具后,在AIME 2024数据集上的表现几乎达到了o1-preview的水平。这个结果的意义非同小可——它意味着通过巧妙的上下文工程,我们可以让现有的基础模型获得接近顶级推理模型的能力,而无需任何额外的训练成本。

给AI产品开发者的三个启示

这项研究给我们带来了三个重要启示。第一,不要盲目追求更大的模型或更多的训练数据,有时候更好的方法比更大的规模更重要。第二,模块化设计不仅仅是软件工程的最佳实践,在AI系统中同样适用。第三,跨学科的思维碰撞往往能产生意想不到的创新,认知心理学的理论在AI工程中找到了新的应用场景。

Context Engineering的学术正当性

这项研究最大的价值在于为Context Engineering提供了学术合法性。当批评者质疑Context Engineering只是"换汤不换药"的新概念时,IBM的论文用严格的对照实验和量化结果进行了有力回击。Context Engineering不是营销噱头,而是有着深厚理论基础和实践验证的方法论。从认知心理学理论到IBM的认知工具实现,再到Context Engineering的概念化,这是一个完整的学术发展脉络。

结语:重新定义AI系统的设计哲学

IBM的这项研究不仅仅是一个技术突破,更是一次设计哲学的重新思考。它告诉我们,AI系统的能力提升不一定要依赖更复杂的训练过程,有时候更好的组织方式就能释放出惊人的潜力。对于正在开发AI产品的您来说,这意味着一个全新的优化方向:不是让模型变得更大更强,而是让它们变得更聪明更有条理。这或许就是下一代AI应用的核心竞争力所在。

文章来自公众号“AI修猫Prompt”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0