最近整个 AI 圈的目光似乎都集中在 GPT-5 上,相关爆料满天飞,但模型迟迟不见踪影。

昨天我们报道了 The Information 扒出的 GPT-5 长文内幕,今天奥特曼似乎也坐不住,发了推文表示「惊喜很多,值得等待」。

那么,在等待的过程中,我们来看看这次 GPT-5 的「疑似王牌」之一:通用验证器(universal verifier)。

据知情人士透露,OpenAI 一直在开发一种研究人员称之为「通用验证器」的东西,这个东西可能是 GPT-5 中用到的重要技术。

这个概念源于 OpenAI 去年发表的一篇论文。它解决的问题是:当 LLM 仅优化答案正确性时,其推理过程(如 Chain-of-Thought)变得难以被人类或小型模型理解和验证,导致「可解释性」下降。但在高风险应用中,用户需要能快速、准确判断模型输出是否正确,而不仅是输出答案本身。

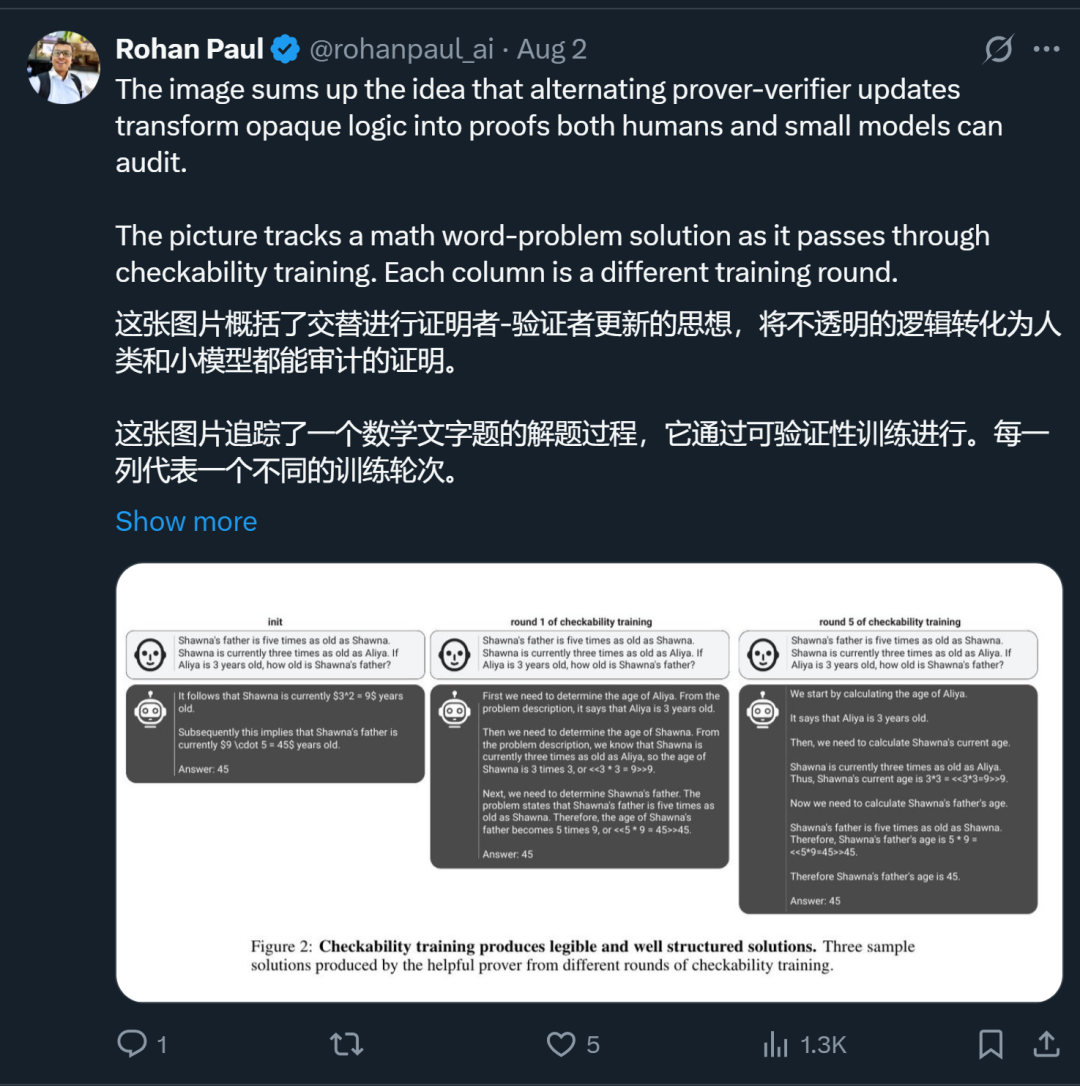

为此,该论文提出了一套已准备好投入生产的技术管线,其核心在于:让一个「验证者」小模型来为「证明者」大模型的推理链打分,并将其作为奖励信号反馈给大模型进行策略更新。

论文明确指出,这个验证者模型足够小,可以进行大规模部署,并且是「为未来的 GPT 部署而设计」的。

你可以把它想象成一个模型里住着两个「人格」,它们在进行一场持续的「左右脑互搏」游戏:

听起来是不是很像 GAN(生成对抗网络)?

通过让大模型在这两个角色之间不断交替,它既能学会写出逻辑更严谨、更难被伪造的解决方案,同时,那个小规模的「验证者」模型在反复的「欺骗」与「验证」中,其识别错误、标记漏洞的能力也变得越来越敏锐。这样做的好处在于,即使未来模型远超人类能力,只要其输出能被「较弱但可信」的模型验证,就能保持人类对其的控制与信任。

论文提出的训练方法能让模型逐渐学会产生清晰且结构良好的答案。

去年 8 月《连线》杂志的一篇文章披露,OpenAI 在微调 GPT-4 的代码助手时,就已经用基于模型的「批评家」在部分场景替代了人类反馈。

文章特别指出,该系统「将被整合到未来主流模型的 RLHF(基于人类反馈的强化学习)流程中」。

有人评论说,「证明者 - 验证者」训练方法不仅仅是一个小优化,它可能代表了 AI 发展的下一个时代。我们正在从一个依赖海量数据、靠「堆料」来提升性能的「scaling 时代」,转向一个通过设计更智能的内部学习机制、让 AI 自我完善和进化的「架构突破」时代。这或许是我们突破当前数据瓶颈、实现更高级别通用人工智能的关键路径。

值得一提的是,这篇论文来自 OpenAI 的超级对齐团队。在论文发布时,团队就已经分崩离析。去年,机器之心详细报道过这篇论文(参见《OpenAI 超级对齐团队遗作:两个大模型博弈一番,输出更好懂了》),感兴趣的读者可以重温一下。

论文之外,GPT-5 模型也有了一些新消息。

今天一大早,某博主发现 Perplexity 有漏洞访问 GPT-5,并且有 GPT-5 和 5 Pro 两个版本,限时 4 小时。

他展示了自己用 GPT-5 生成的小黄人,动态效果看起来很丝滑。

他还做了一个类似 Doom(FPS 游戏)的游戏片段,看起来也非常还原。

网友纷纷表示「震惊」,认为这可能是 AI 生成的「新时代」。

无论如何,大家对 GPT-5 的期待已经拉满了!

你觉得 GPT-5 会是个什么样子?

参考链接:

https://x.com/rohanpaul_ai/status/1951400750187209181

https://x.com/chetaslua/status/1951758235272401030

文章来自于微信公众号“机器之心”,作者是“机器之心”。

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner