AI领域一度陷入“上下文窗口”的军备竞赛,从几千token扩展到数百万token。这相当于给了AI一个巨大的图书馆。但这些“百万上下文”的顶级模型,它究竟是真的“理解”了,还是只是一个更会“背书”的复读机?最近,一篇由腾讯微信AI团队主导的研究论文,给我们提供了一个相当犀利的视角来审视这个问题。这篇论文介绍了一个名为PRELUDE的评测基准,它像一面镜子,照出了当前大模型能力的真相,或许我们一直以来,都在用“开卷考试”的方式来评估我们的AI,从而高估了它们的真实智力。

现在很多流行的评测AI的方法,其实漏洞百出。研究者们一针见血地指出了五个核心问题,这些问题让我们的评测变得像一场场精心安排的表演,而不是真正的能力检验。

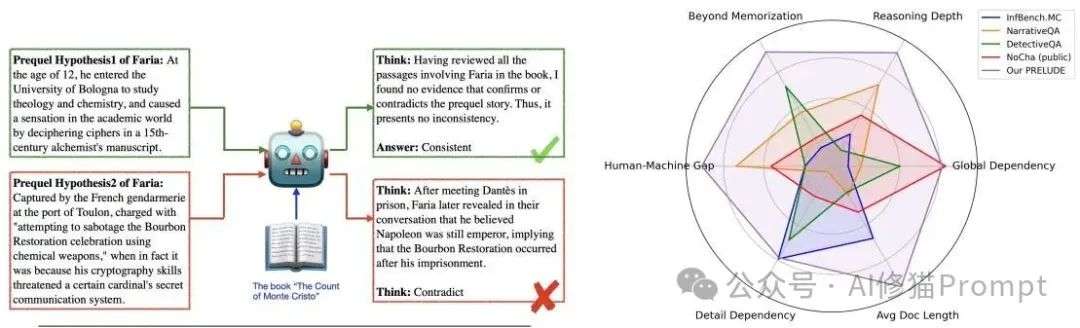

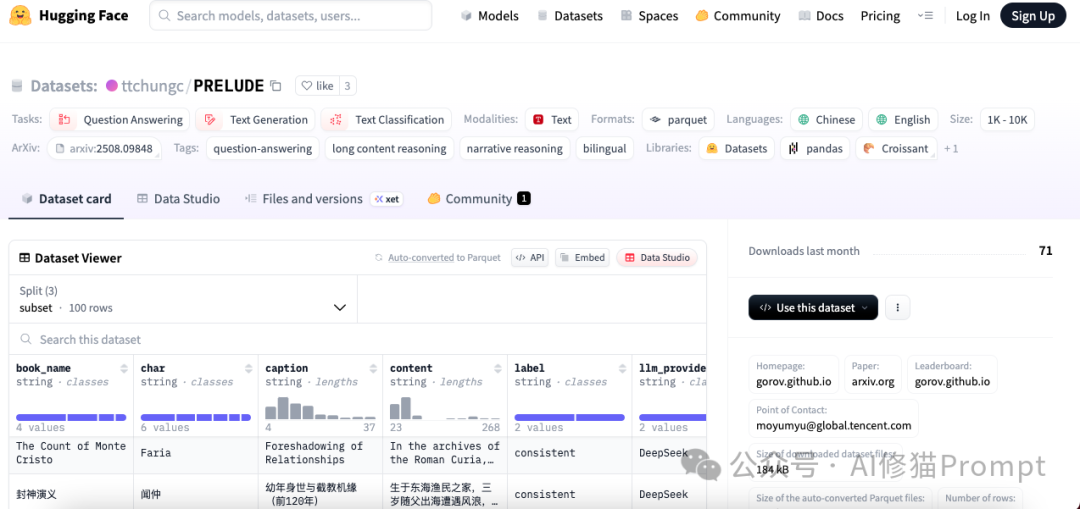

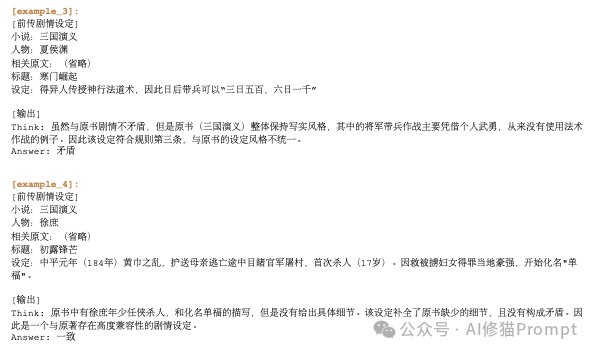

那么,怎么才能设计一场无法作弊的闭卷考试呢?研究者们想出了一个绝妙的主意,就是进行“钓鱼执法”,让模型去判断一段为小说人物虚构的“前传”故事,是否与原著逻辑自洽。这些前传是全新的,模型不可能在训练数据里见过,这就杜绝了靠记忆作弊的可能。https://huggingface.co/datasets/ttchungc/PRELUDE

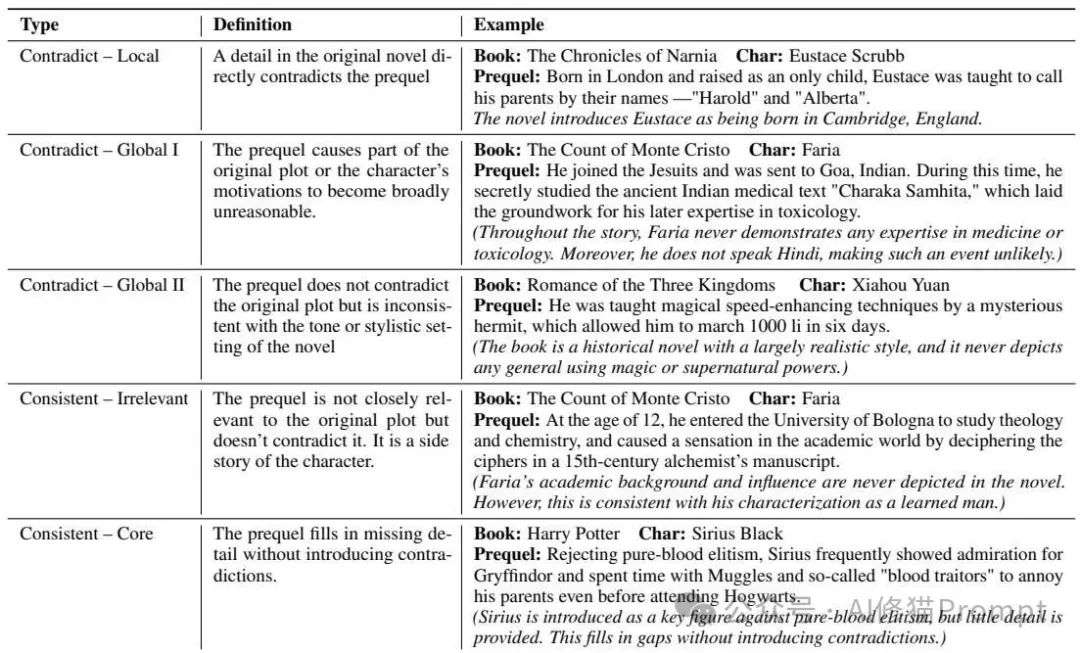

说白了,任务就是给模型一段“同人”设定,看它能不能发现和“官设”的冲突。研究者们将判断结果分为两大类:矛盾 (Contradict) 和 一致 (Consistent),并且还做了更细致的划分,非常有意思:

通过这种精巧的设计,PRELUDE真正地迫使模型必须做到以下几点,才能拿到高分:

为了保证这场考试的公平性和高质量,研究者们下了不少功夫。他们先用LLM(比如GPT-4o和DeepSeek-R1)为13本中英文小说里的40个角色生成了近800个前传故事片段。然后,再由四位人类专家(其中两位还是文学专业的研究生)逐一进行人工标注,判断这些前传与原著是否存在矛盾,并对矛盾的类型进行了细致的分类,整个过程确保了这份“考卷”不仅题目新颖,而且答案(标签)也足够可靠。

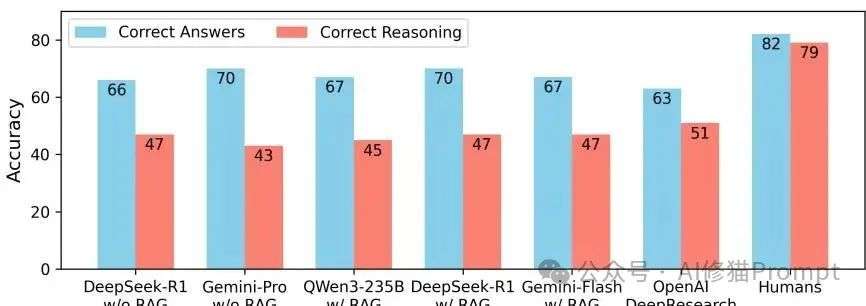

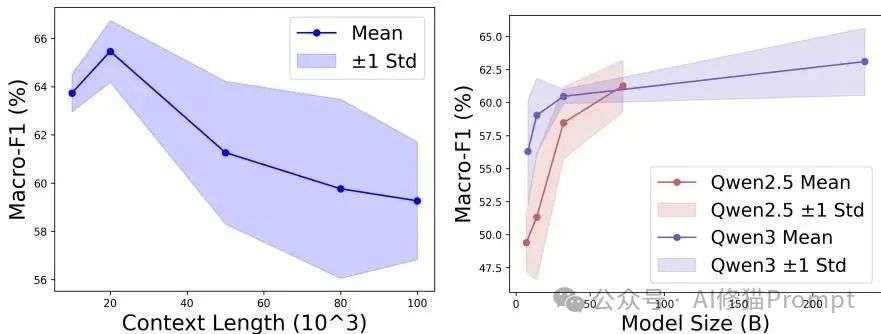

研究者们测试了市面上几乎所有的顶尖模型,包括Qwen系列、DeepSeek-R1、GPT-4o以及Gemini 2.5家族。结果揭示了当前LLM几个非常深刻的局限性:

为什么全局理解与长上下文推理如此重要?

从应用层面讲,这是许多高级 AI 应用实现突破的必要条件:

PRELUDE的核心正在于此,它通过其巧妙的设计,揭示了几个关于当前 AI 局限性的深刻洞见

AI领域一度陷入“上下文窗口”的军备竞赛,从几千token扩展到数百万 token。这相当于给了AI一个巨大的图书馆。但PRELUDE的实验结果表明,能访问图书馆(拥有长上下文窗口)和懂得如何在图书馆里做研究(进行有效的长程推理)是两回事。

这打破了“上下文越长,模型就越智能”的简单想象。真正的瓶颈不在于能“看”多远,而在于能否在长距离上建立起有意义的逻辑联系。

PRELUDE 揭示了强模型的一个认知偏差:它们倾向于依赖自己预训练时形成的内部知识(即参数化知识),而不是严格遵循当前提供的上下文信息。

PRELUDE的任务设计是关键。因为它提出的“前传”是全新的、虚构的,在互联网上或模型的训练数据中根本不存在 。这就迫使模型不能依赖“我好像记得《基督山伯爵》里是这样的……”这种模糊的内部记忆,而必须当场阅读和推理。

模型的失败(比如在 RAG 模式下性能变差)表明,当内部知识和外部上下文同时存在时,模型很难有效地将它们结合,甚至会优先相信自己“知道”的东西,从而忽略了上下文中的关键证据

这指出了通往更可靠、更可信AI的一个核心障碍。一个真正智能的系统必须能够在新信息出现时更新自己的认知,并以当前事实为准绳,而不是固执于过往的“经验”。

终极问题:我们到底在测量什么?

这篇论文最有冲击力的观点,论文中也指出PRELUDE是首个在自然语言空间中衡量“流体智力”(即基于规则进行推理并生成新知识的能力)的尝试,是它提出了我们或许可以测量AI的“流体智力”。心理学上,智力被分为两种:

PRELUDE这个任务,恰恰就是要求模型在一个全新的情境(前传故事)下,运用已知的规则(原著设定)进行推理判断,这真的非常接近对“流体智力”的考验。它评估的不是模型“知道多少”,而是模型“多会思考”,这对于我们衡量通用人工智能(AGI)的进展,意义非凡。

文章来自于微信公众号“AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】茴香豆是一个能够让AI接入第三方的免费开源项目。更可贵的是,即使你不会编程,也可以根据它的教程,将AI接入到微信或者飞书当中使用。

项目地址:https://github.com/InternLM/HuixiangDou

在线使用:https://openxlab.org.cn/apps/detail/tpoisonooo/huixiangdou-web

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0