近年来,以多智能体系统(MAS)为代表的研究取得了显著进展,在深度研究、编程辅助等复杂问题求解任务中展现出强大的能力。现有的多智能体框架通过多个角色明确、工具多样的智能体协作完成复杂任务,展现出明显的优势。然而,现阶段的 MAS 依然面临一些关键限制:

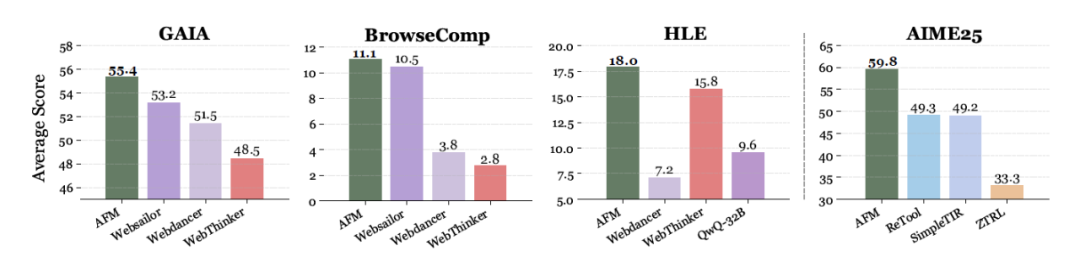

同时,近期兴起的工具融合推理(TIR)模型,通过显式地将工具使用融入推理过程,显著提升了单智能体框架(如 ReAct)在信息检索任务中的表现。然而,传统的 TIR 模型,无法直接支持多智能体系统的原生训练与协作。

针对上述瓶颈,本文提出了一种全新的智能体推理范式——Chain-of-Agents(CoA)。与传统的 TIR 模型仅支持单一智能体的「思考-行动-观察」模式不同,CoA 框架能够灵活定义多个角色和工具的智能体,在单一模型内动态激活,实现端到端的多智能体协作。

与传统的 MAS 相比,CoA 无需复杂的 prompt 和工作流设计,降低了智能体间的通信开销,并支持端到端训练,显著提升了系统的效率和泛化能力。经过训练后,具备原生 CoA 问题求解能力的模型称为 Agent Foundation Model(AFM)。

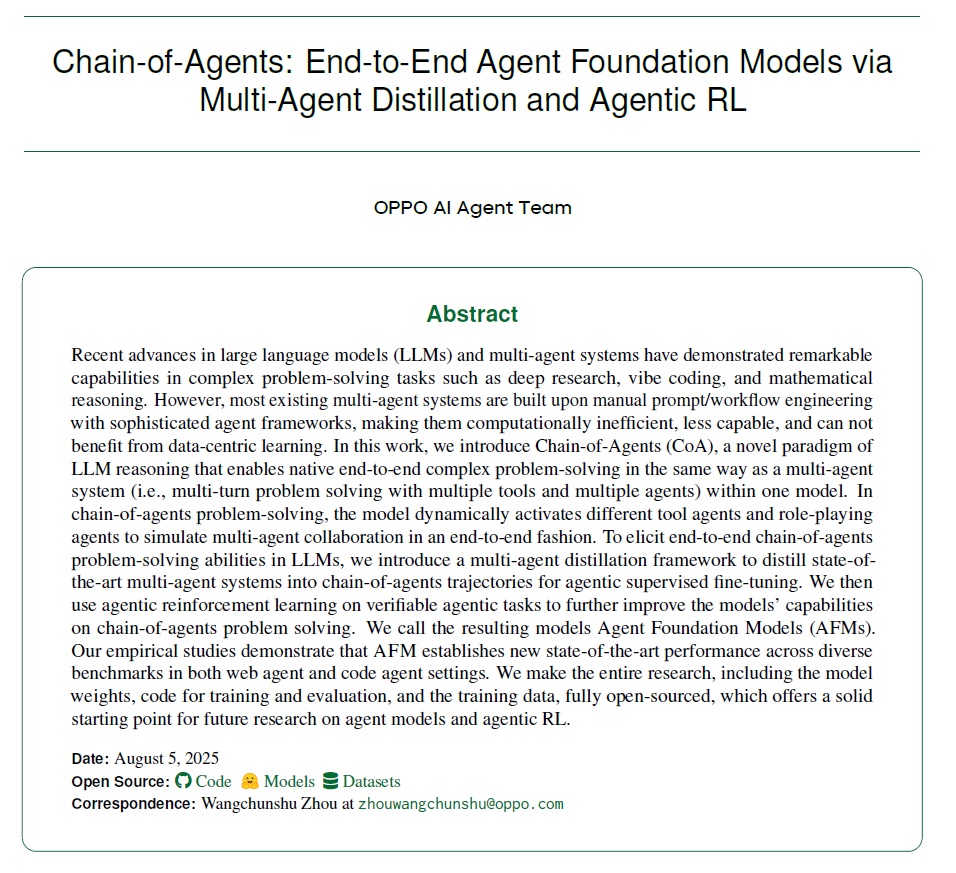

在实验上,AFM 展示了卓越的性能和高效的推理能力,在近 20 项复杂任务和基准测试中全面刷新记录:在 Agentic 任务中,其在 GAIA 基准上以 32B 模型实现了 55.4% 的 Pass@1 成功率;在代码推理方面,AFM 在 LiveCodeBench v5 上的 47.9% 准确率和在 CodeContests 上的 32.7% 成绩均显著超越现有 TIR 方法。同时,它将推理成本(token 消耗)减少高达 85.5%,在保持领先性能的同时大幅提升效率。

CoA 采用了一种层次化的智能体架构,包括两个核心组成部分:

在 CoA 范式下,模型可以支持更多类型的智能体的推理和调用。

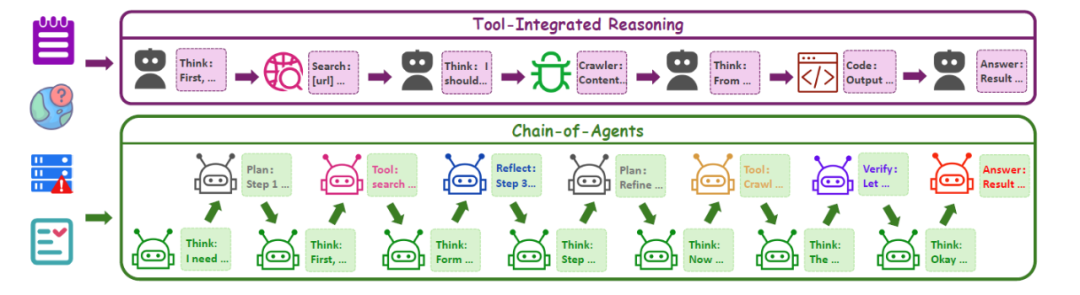

为了实现 LLMs 的原生多智能体协作推理能力,本文开发了一套专门的 CoA 微调框架,用于构建 AFM,该方法具体包括以下流程:

任务采集

为了构建丰富且多样的训练数据,本文首先从网页任务、数学和代码推理两大方面采样任务数据,并用于后续轨迹生成:

SFT 轨迹生成

为了采集 CoA 适配的数据用于 SFT,本方法基于先进的多智能体系统 OAgents,建立了一套统一的轨迹采集框架,生成结构化的任务求解轨迹。具体来讲,本方法利用 OAgents 执行采集到的任务,并通过设定的规则产生反思和验证等行为,例如:按执行成功率对数据进行难度分级,对于难题引入反思机制,对于更难的题目基于答案引入规划生成的引导等。执行轨迹中有效的内容将通过规则转换的方式,以 CoA 要求的轨迹格式保存。最终产生约 87k 条 SFT 轨迹数据。

RL 数据筛选

为了进一步提升智能体的多工具协作策略,在强化学习(RL)阶段,本方法进一步利用约 85k 条高质量的 Agentic 任务、数学问题和代码任务数据,通过严格的数据质量筛选与策略抽样,确保强化学习专注于最具挑战的任务,防止过拟合。

为了验证 CoA 范式与微调框架的有效性,本方法在多跳问答、智能体任务以及代码生成和数学推理等多个智能体基准上开展了全面的实验评估。

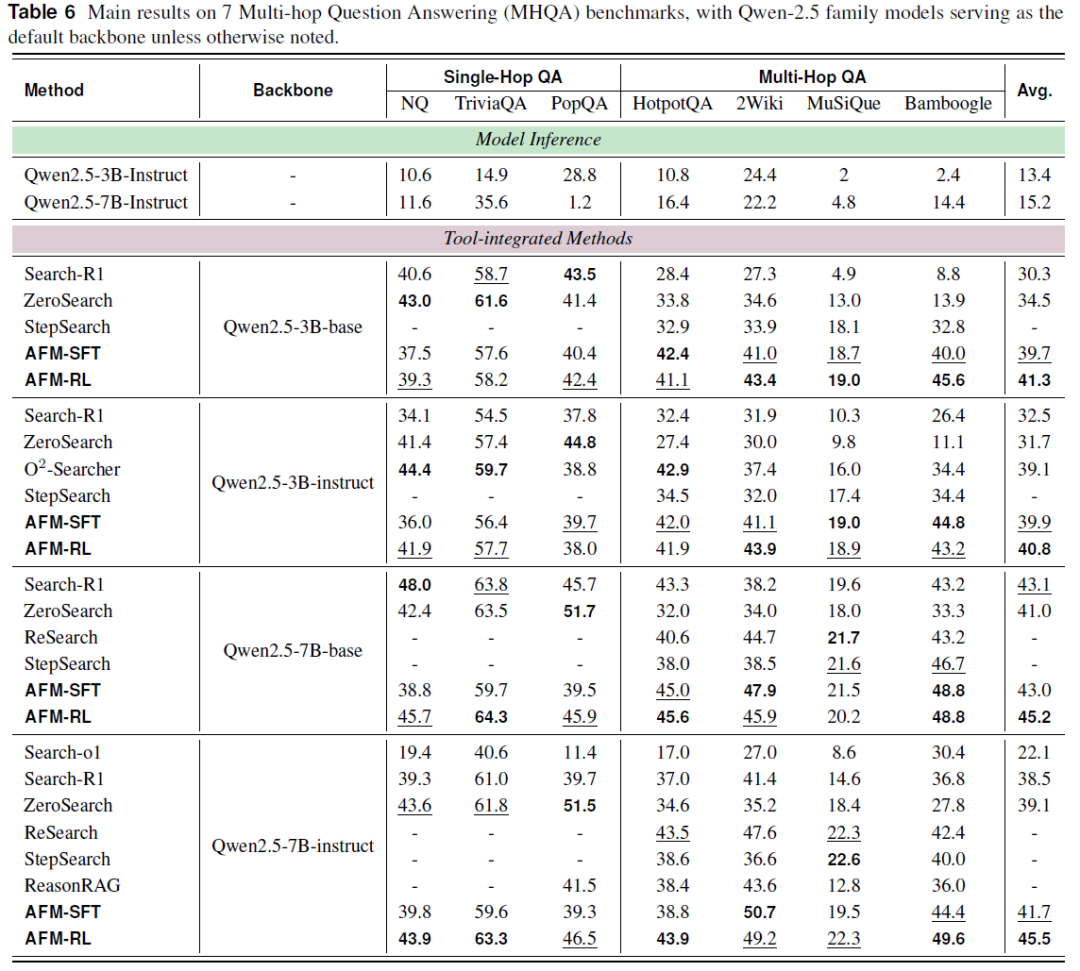

多跳问答(MHQA)任务评估

本文训练的 AFM 模型在 MHQA 基准任务的单跳与多跳问答测试集中展现出稳健且优异的性能,相较于同规模模型保持一致的有效性,且整体表现更为突出。具体而言,AFM-SFT 在多个数据集上接近或者超越了先前的 SOTA 方法,有效验证了多智能体蒸馏技术在协同智能迁移方面的优势。经过策略优化后的 AFM-RL,在七个数据集上达成了平均性能的新高,树立了当前任务中的新标杆。

在同类型且同规模的模型对比中,AFM 在不同的模型设置下都取得了领先成绩(例如以 Qwen-2.5-7B-instruct 为基准模型,平均准确率达到了 45.5%,相较 ZeroSearch 提升 6.4%)。

AFM 在多跳问答任务中的提升尤为显著,说明其在任务分解与工具使用方面具有更强的能力。并且在处理跨领域数据集时,AFM 的性能增益更加明显,表明通过该框架训练的模型具备更强的泛化能力与适应性。

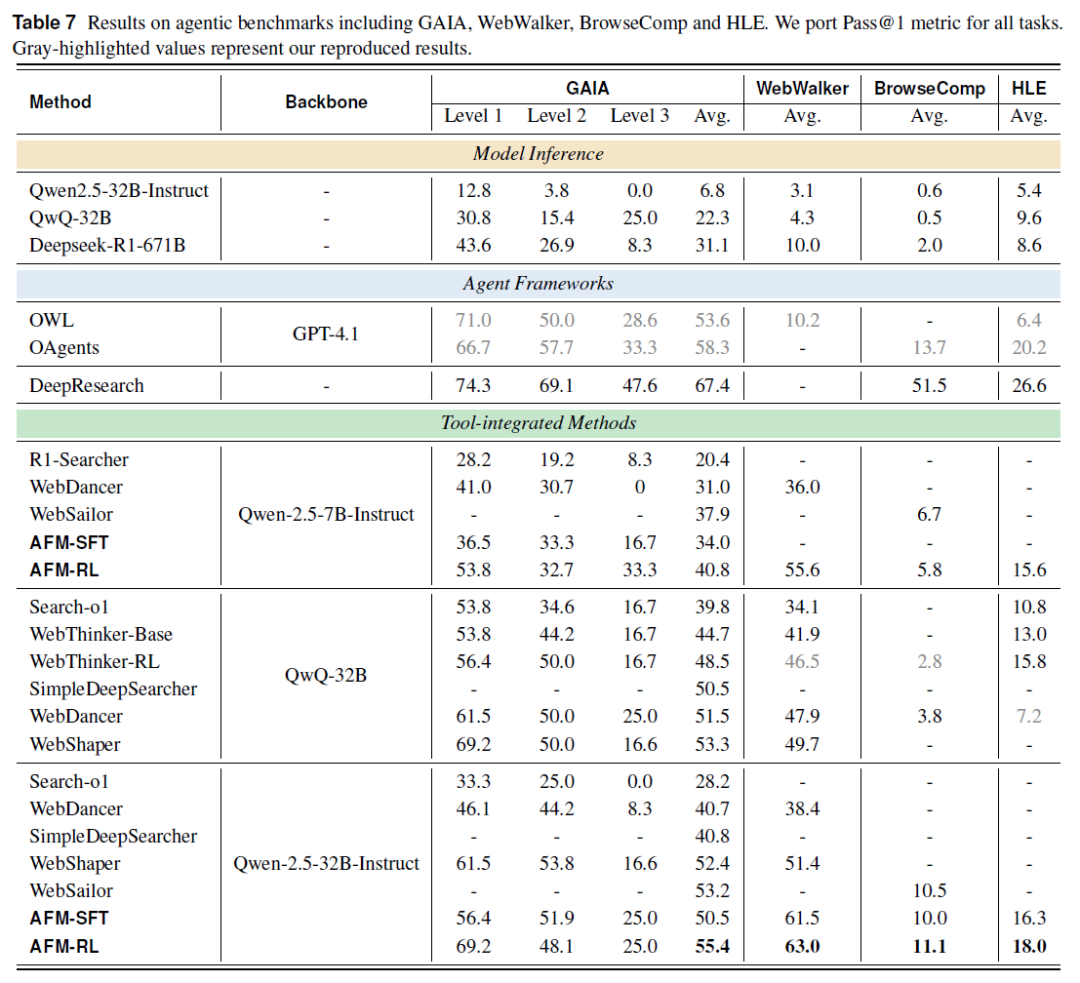

复杂网页搜索任务评估

AFM 在多个复杂知识密集型任务中刷新性能纪录:

即使使用更小的 Qwen-2.5-7B-Instruct 主干,AFM 仍在 HLE 任务中取得 15.6% 的成绩,仅略低于采用更大主干的 WebThinker-RL(15.8%),同时在多个基准任务中超越其他集成工具的 32B 模型。进一步验证了 AFM 在智能体问题求解中的高效性,以及多智能体蒸馏策略在跨模型尺度中稳定迁移协作智能的能力。

除此以外,本文还发现,单独 SFT 的模型也能取得优异的结果:

这些结果均验证了 AFM 在工具协同、推理迁移和跨模型尺度上的卓越表现。

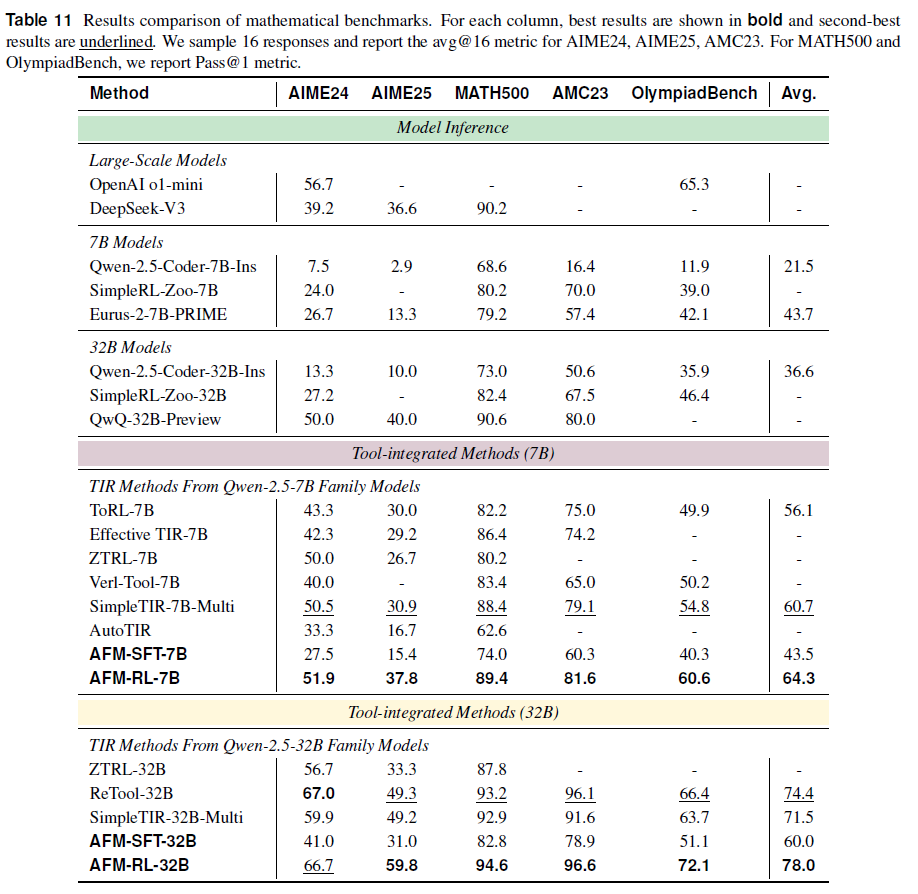

数学能力

AFM 在数学推理任务中展现出显著优势:

进一步分析训练过程中的阶段贡献:

综合来看,AFM 通过多智能体蒸馏过程在 SFT 阶段获得了链式推理能力,如规划、反思和工具调用;RL 阶段进一步强化了这些能力,造就了其在数学推理任务中的全面优势。

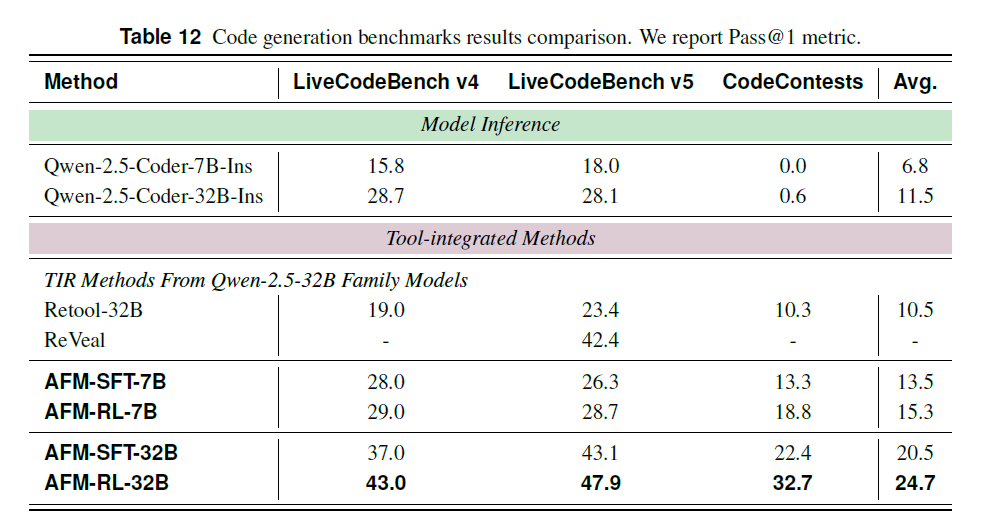

代码基准

AFM 在代码生成任务中同样表现优异,显著超越多个基线模型:

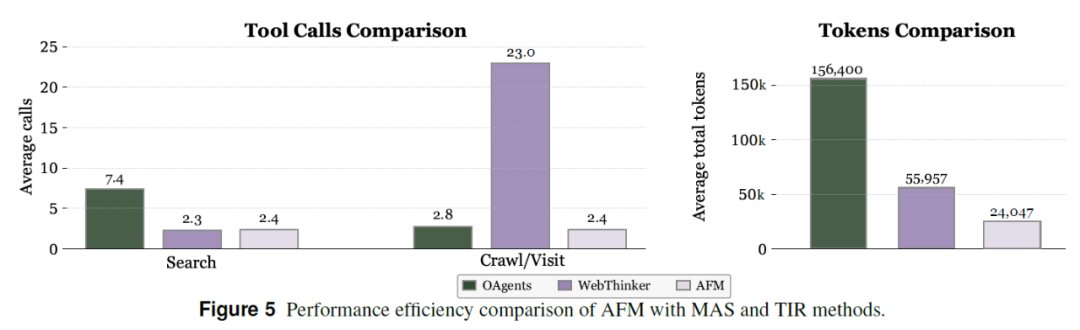

效率分析

AFM 在工具调用效率和推理成本方面展现出显著优势,基于 GAIA 数据集的 10 个实例,对比 AFM 与三个主流框架(OAgents、WebThinker 和 AFM)在工具调用和 token 消耗上的表现。结果显示:

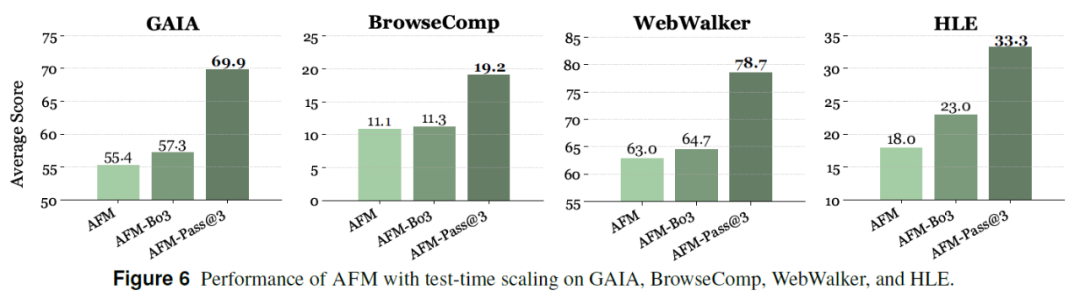

Test-Time Scaling 分析

此外,AFM 在 Test-Time Scaling 方面表现卓越,并在多项智能体基准中展现稳健性能。通过对 GAIA、WebWalker、BrowseComp 和 HLE 四个任务的深入分析,AFM 及其变体:AFM-Bo3 与 AFM-Pass@3,在测试阶段进一步验证了模型的泛化与推理效能。AFM-Bo3 采用三选一优化策略,通过 Qwen-2.5-72B-Instruct 模型评估三个候选答案以选出最优路径;AFM-Pass@3 则采用三次尝试中至少一次正确的机制以提升任务完成率。

在与其他主流智能体模型对比中,这三种方式均在多项任务中展现出领先优势,证明了 AFM 具备优越的策略组合能力与稳健的跨任务适应性,也体现出该方法在训练后仍可通过推理策略扩展进一步提升表现。

CoA 范式与 AFM 模型的突破,本质上是通过层次化智能体架构与端到端训练,解决了传统多智能体系统(MAS)在通信效率、泛化能力与 LLM 原生协作支持上的核心矛盾。其技术价值不仅体现在近 20 项基准测试的性能跃升,更在于构建了一套可扩展的智能体推理框架——角色型智能体(思考、计划、反思、验证)与工具型智能体(搜索、爬取、代码)的动态激活机制,使 LLM 首次具备无需外部工作流配置即可完成复杂协作的能力。

从技术细节看,AFM 的优势源于两点:一是多智能体能力蒸馏过程中,将 OAgents 的成功轨迹转化为 CoA 兼容格式,实现了协作策略的高效迁移;二是 RL 阶段针对高难度任务的策略优化,显著增强了工具调用的精准性(如数学推理中 7B 模型经 RL 后准确率提升 20.8%)。这种「蒸馏-微调-强化」的技术路径,为其他智能体框架提供了可复用的训练范式。

然而,作为一项突破性工作,CoA 与 AFM 仍存在待探索的技术方向:

这些待解问题,既是 CoA 范式向更通用智能体系统进化的必经之路,也为研究者提供了明确的技术探索方向。随着开源模型、数据集与代码的开放,AFM 有望成为智能体协作领域的重要基线,推动多智能体技术从「任务适配」走向「通用协作」。

文章来自于微信公众号“机器之心”。

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0