大语言模型正加速重塑软件工程领域的各个环节,从需求分析到代码生成,再到自动化测试,几乎无所不能,但衡量这些模型到底「好不好用」、「好在哪里」、「还有哪些短板」,一直缺乏系统、权威的评估工具。浙江大学、新加坡管理大学、加拿大渥太华大学等机构的研究团队,首次对291个用于评估LLMs在软件工程任务中的Benchmark进行了系统综述,为AI4SE社区绘制了一份详尽的「基准地图」与方法指南。

近年来,ChatGPT、Llama等大语言模型在软件工程领域的能力突飞猛进,从需求分析、代码生成到测试与维护几乎无所不能。但一个核心问题是:我们如何客观评估这些模型在不同软件工程任务中的表现?

在SE领域,Benchmark既是分数卡,让不同模型在同一标准下比拼;也是方向盘,引导技术改进与未来研究方向。

然而,现有LLM-SE Benchmark存在三大痛点:

这使得开发者和研究者在选择评估方法时常陷入「信息孤岛」,甚至可能被不全面的评估结果误导。

为填补这一空白,来自浙江大学、新加坡管理大学、渥太华大学等机构的团队开展了一项系统文献综述,首次全面梳理了291个用于评估大语言模型在软件工程任务中的Benchmark,并从任务覆盖、语言分布、构建方式到未来趋势进行了深入分析。

论文链接:https://arxiv.org/pdf/2505.08903

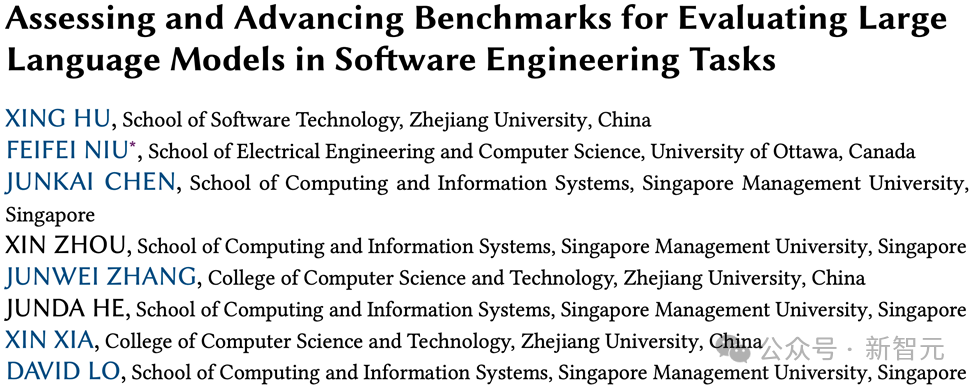

图1 综述框架总览

研究聚焦三大核心问题:

为了确保全面、系统,研究人员开展「地毯式搜索」:

数据来源:覆盖IEEE Xplore、ACM DL、ScienceDirect、Springer Link等八大数据库;

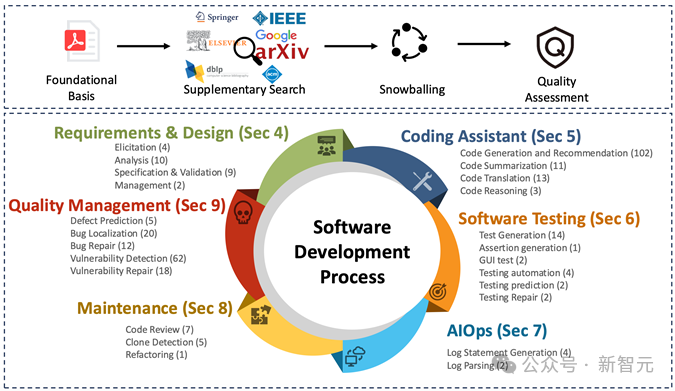

图2 Benchmark年份分布

统计显示,自2022年起Benchmark数量快速增长,2023和2024年分别新增近70个,增长势头迅猛。

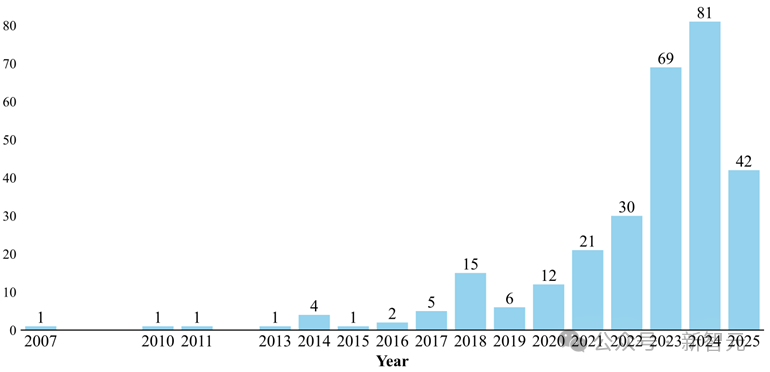

图3 Benchmark语言分布

Python在评估Benchmark中一骑绝尘,主要用于代码生成与推荐类任务;Java、C++、C语言在质量分析与维护任务中占有重要地位;Go、PHP、Ruby等小众语言的Benchmark仍然稀缺。

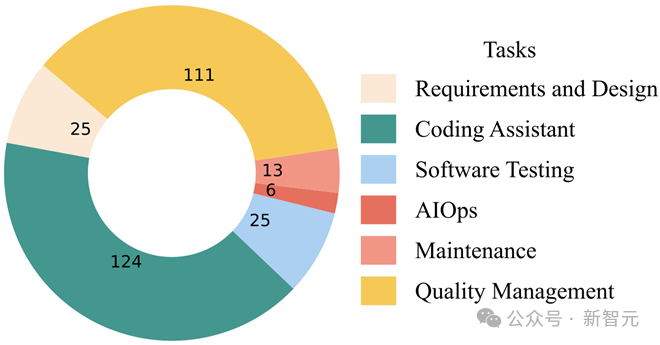

图4 Benchmark任务分布

其中「编码辅助」任务相关Benchmark数量最多,占比超过40%,其次是质量管理类任务,占比达38%。

研究指出,当前Benchmark建设存在五大瓶颈:

团队提出了五大改进方向:

正如作者所言——当前LLM在软件工程中的应用正处于「黄金发展期」,但真正能驱动其走向工业落地、提升工程可信度的,是那些更真实、更多维、更动态的Benchmark体系。

这项研究不仅填补了LLM软件工程评估的综述空白,也为AI4SE研究者、开发者和企业提供了清晰的「下一步方向」。

如果说模型是「马达」,Benchmark就是「方向盘」。谁能把握住它,谁就能在AI软件工程的未来之路上走得更远。

参考资料:

https://arxiv.org/pdf/2505.08903

文章来自于微信公众号“新智元”。