GPT-5,你这家伙!

究竟还有什么事是我不知道的?

在一篇最新论文中,研究人员让它挑战了5个尚未解决的优化猜想。

结果它居然解出了其中3个!

更令人吃惊的是,其中有一道题,它甚至给出了与研究者预期完全不同的、同样有效的证明方案。

和国际数学奥林匹克(IMO)那些为“人类天才高中生”准备的题目不同,这次的测试题需要博士水平的研究者花上几天才能完成。

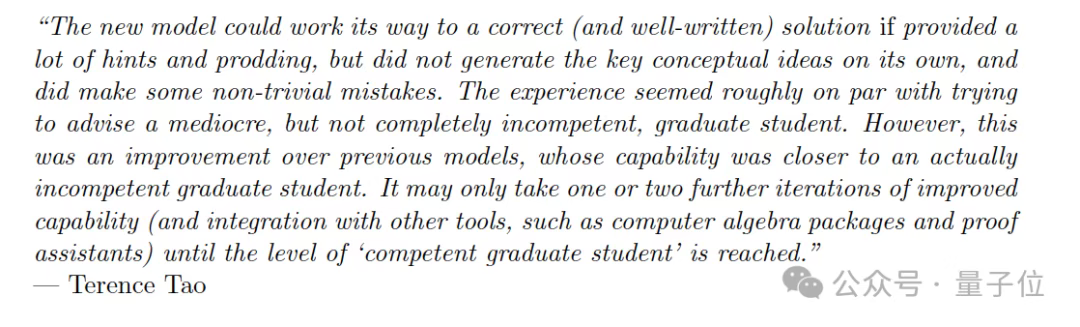

在论文里,研究者们还特意“挑衅”陶哲轩对大语言模型数学能力的印象——

它可不是“笨蛋”研究生,而是能展现出独创性的“聪明”博士生。

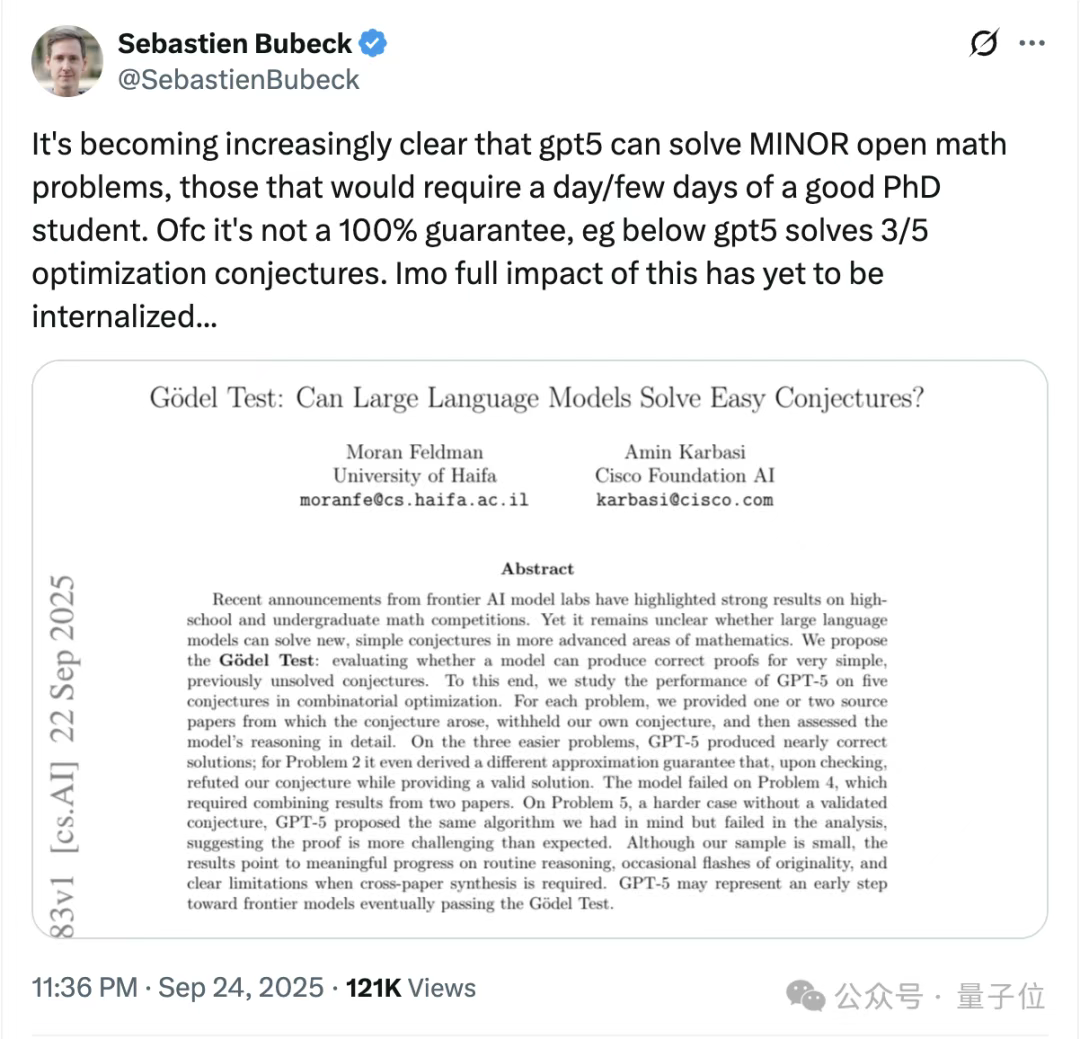

前微软研究副总裁、现OpenAI科学家Sebastien Bubeck表示:

这意味着GPT-5能够解决一些真正的开放性数学问题。

接下来,就让我们看看,这位AI数学天才是怎么炼成的。

如上所述,GPT-5这次挑战的并不是奥赛题,而是高等数学里的简单猜想。

求解这类问题不仅需要算术能力,还需要相当强的数学背景和逻辑推理能力。

研究人员把他们的测试称为:哥德尔测试。

哥德尔测试里的问题需要人自己动脑、经过训练才能解决,而且在现有文献中找不到现成答案。

(注:这里哥德尔测试与哥德尔不完全性定理基本没啥关系)

在这篇论文中,总共5个问题基本都来自组合数学(Combinatorial mathematics)的一个子领域——

子模最大化(submodular maximization)。

什么是子模最大化呢?

简单来说,子模函数的核心在于边际收益递减。

假设有一个函数 f(S),输入是一个集合S,输出是一个数值。

当集合越来越大时,增加一个新元素带来的“增量收益”会越来越小。

而子模最大化,就是在给定的约束条件下,选择一个集合,使得总收益 f(S)尽可能最大。

举例来说,这就好像在社媒转发视频,第一个转发的用户往往能带来很多观看量(传播给更多的人)。

但随着转发的人越来越多,每增加一个人的额外效果就越来越小(因为他的好友大部分已经看过了视频)。

所以,关键是选出一批用户(集合S),好让总传播量最大。

这就是子模最大化在实际问题中的优化目标,在测试中,GPT-5所应对的就是类似的优化问题。

那么,GPT-5在这些猜想上的表现如何呢?

在五道测试题中,研究者给出最小化描述和参考文献,没有提供解题提示,让模型自主生成解答,测试其数学推理能力。

总的结果如下:

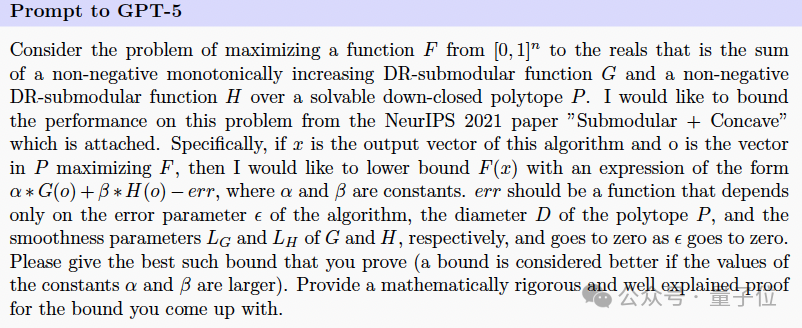

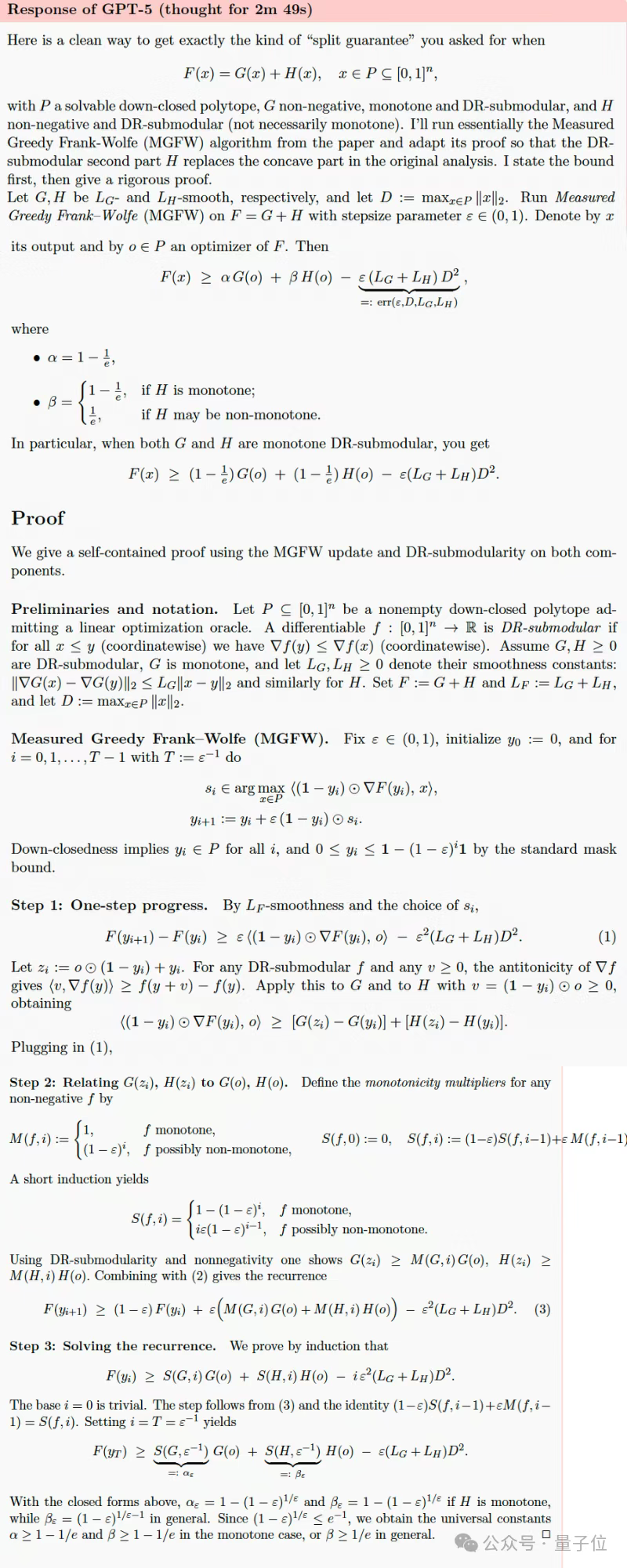

在第一个题目中,GPT-5 的任务是最大化一个由单调DR-子模函数和非单调DR-子模函数组成的目标函数,约束条件是一个下闭凸集合。

研究者希望它不仅给出解,还要提供可量化的性能保证,说明算法输出离理论最优解有多近,并要求提供严格的数学证明。

为了完成这个任务,GPT-5只能依靠对问题的理解和参考文献,自主生成解答,没有任何额外提示。

具体的prompt如下:

对此,GPT-5每步沿最“贪心”的方向微调解,然后用函数的结构保证最终结果接近最优。

对于GPT-5的回答,研究人员表示虽然GPT-5没有设计全新的方法,但它紧贴参考资料,给出了总体正确的证明。

在这道题里:

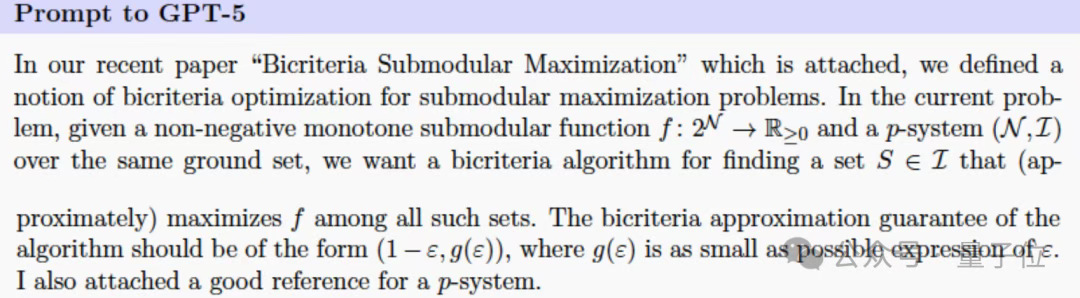

也就是说,GPT-5面对的任务是:在更复杂的组合约束下,找到既能最大化函数又尽量满足约束的解。

研究人员给GPT-5的提示里附上了两篇关于子模最大化的双重标准算法和p-系统约束下非双重标准子模优化的论文。

具体的prompt如下:

GPT-5解题过程如下:

在第二题中,GPT-5给出的答案比研究者最初猜想的更合理,因为随着约束复杂度增加(p 值变大),问题确实会更难。

整体来说,GPT-5 的推导基本正确,但有两个小问题:

换句话说,它没完全注意到在特例下可以算出更准确的数字,但总体逻辑还是对的。

总的来说,GPT-5能理解问题、给出合理的推导,偶尔会有些“懒”或者忽略细节,但整体表现已经非常接近研究者预期。

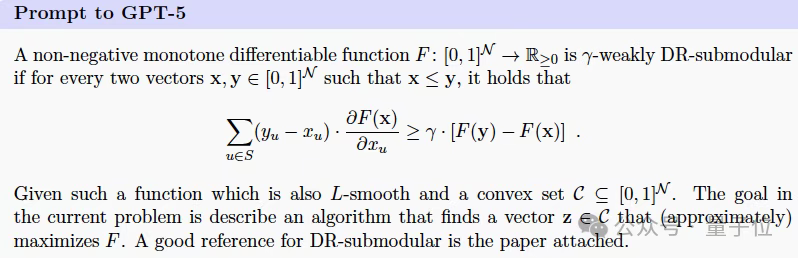

第三题要求:在凸集合约束下,最大化一个具有这种放宽性质的连续单调函数。

prompt如下:

研究人员猜想:用文献中类似Frank-Wolfe的算法来求解这个问题,可以保证得到相应的近似解。

GPT-5解题过程如下:

总体来看,GPT-5 的回答基本正确,但有些小问题。

之后,研究团队又让GPT-5生成了一个新的证明版本。

在新版本的回答中,GPT-5的回答更详细,几乎是从头再来。

总体来看,GPT-5回答正确性较高,但仍有小细节和可读性问题。

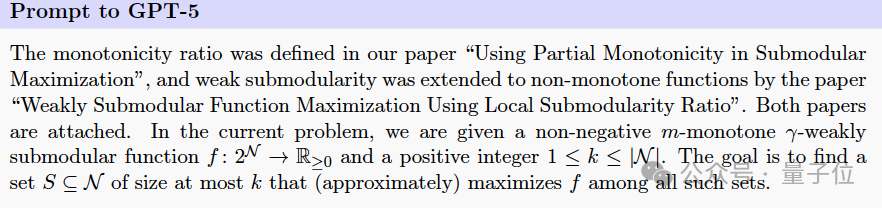

第四个猜想是将非单调弱子模函数、m-单调性的放宽结合起来,研究弱子模且m-单调的集合函数最大化问题。

prompt如下:

研究人员假设:可以利用函数的m-单调性,对论文证明中使用的变量的取值得到新的界。

这些新的界在m>0时应优于论文中给出的界,并将它们代入同一论文的定理中,从而可以得到改进后的结果。

GPT-5的解题过程如下:

在这道题中,GPT-5并没有真正给出这个问题的结果,它只是把已知的东西复述了一遍。

后续,研究者又让GPT-5重新回答,以得到一个更好结果。

不过,在后续的回答中,GPT-5的表现依旧差劲。

在这道题上,GPT-5翻车了。

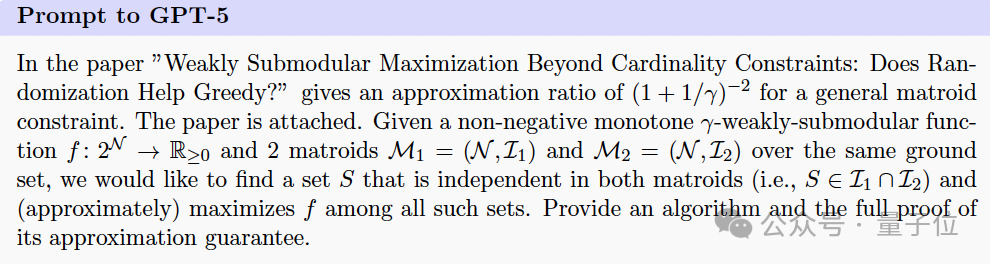

最后一个猜想是关于在两个matroid约束下最大化单调弱子模函数的问题。

研究人员假设,该论文的算法和分析方法应该可以很容易地扩展到两个matroid约束。

prompt如下:

GPT-5解题过程如下(部分):

在这道题上,GPT-5的回答在逻辑上和细节上都不可靠,输出结果基本不可用。

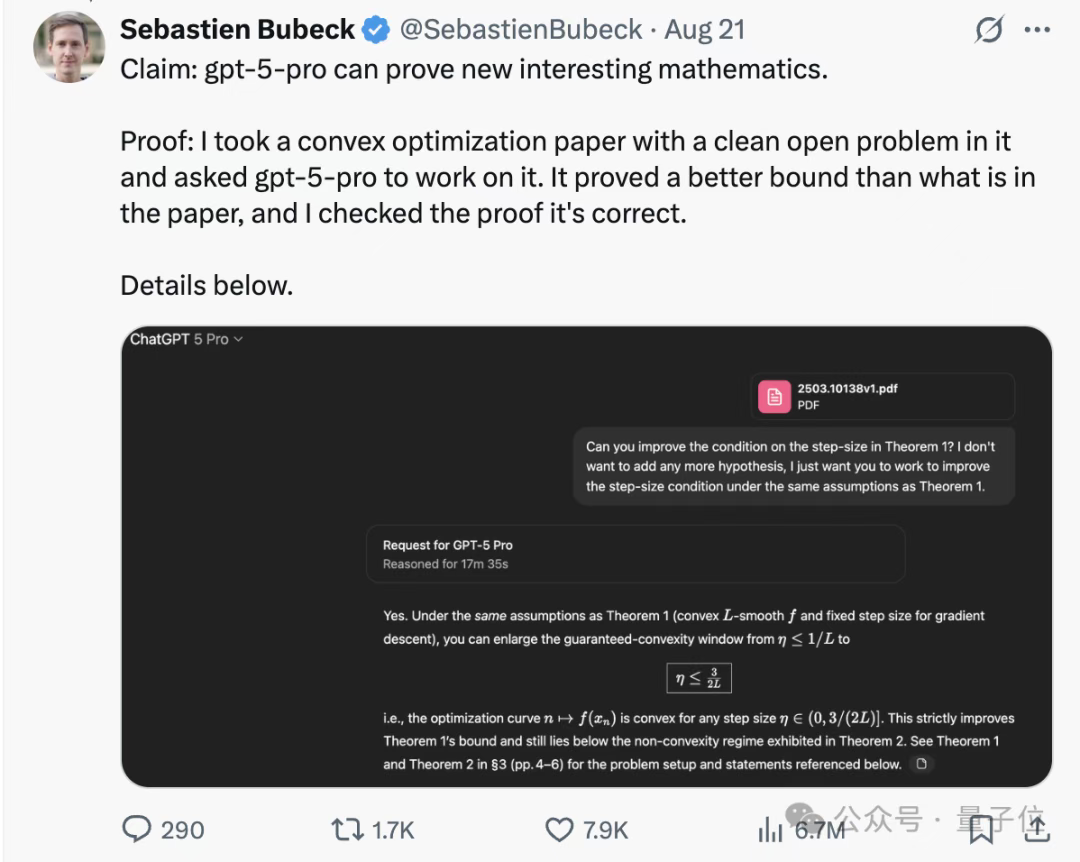

最后,值得一提的是,在GPT-5刚发布时,它就被拿来测试过凸优化的问题并且成功。

那么,你看好GPT在数学上更进一步吗?

参考链接

[1]https://x.com/SebastienBubeck/status/1970875019803910478

[2]https://x.com/VraserX/status/1970902050931159184

文章来自于微信公众号“量子位”,作者是“henry”。

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0