本文作者团队来自 Insta360 影石研究院及其合作高校。目前,Insta360 正在面向世界模型、多模态大模型、生成式模型等前沿方向招聘实习生与全职算法工程师,欢迎有志于前沿 AI 研究与落地的同学加入!简历投递邮箱:research@insta360.com

在虚拟现实、自动驾驶、具身智能等新兴应用中,全景视觉正逐渐成为不可或缺的研究方向。相比于常规透视图像(正常平面图像,也是大部分 CV 任务使用的标准输入),全景图像捕捉的是 360°×180° 的完整球面视域(包含四周、头顶天空与脚下地面),仿佛将站立点周围的整个空间展开成一张“大照片”。正因两者在几何投影、空间采样与边界连续性上的本质差异,直接把基于透视视觉开发的算法迁移到全景视觉往往失效。

本文基于 300+ 篇论文、覆盖 20+ 代表性任务,首次以 “透视-全景 gap” 为主线,系统梳理了三大 gap、两条核心技术路线与未来方向展望,既帮助研究者 “按任务选解法”,也为工程团队 “按场景落地” 提供清晰坐标。

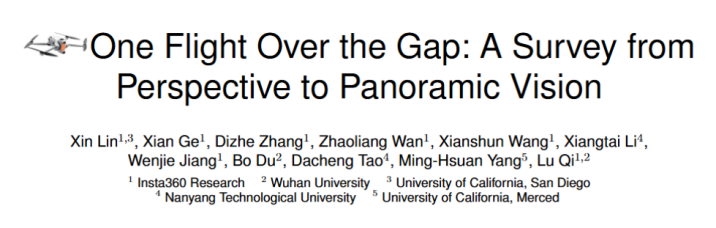

左侧展示了由全景相机获取的球面影像,经过投影后变成常见的等距矩形投影 (ERP) 全景图像。相比下方的透视图像,虽然能完整覆盖 360° 场景,却引入了三大核心挑战:

这三大 gap 正是透视方法难以直接适配全景场景的根源,也构成了后续研究创新的出发点。相较现有的全景视觉综述多沿 “单一任务线” 纵向梳理,本文以 “透视→全景” 的 gap 为问题原点进行分类与分析,从数据、算法到应用层面揭示两者差异及全景研究滞后的原因,这是一个更具动机张力、且现有综述未充分展开的创新视角。

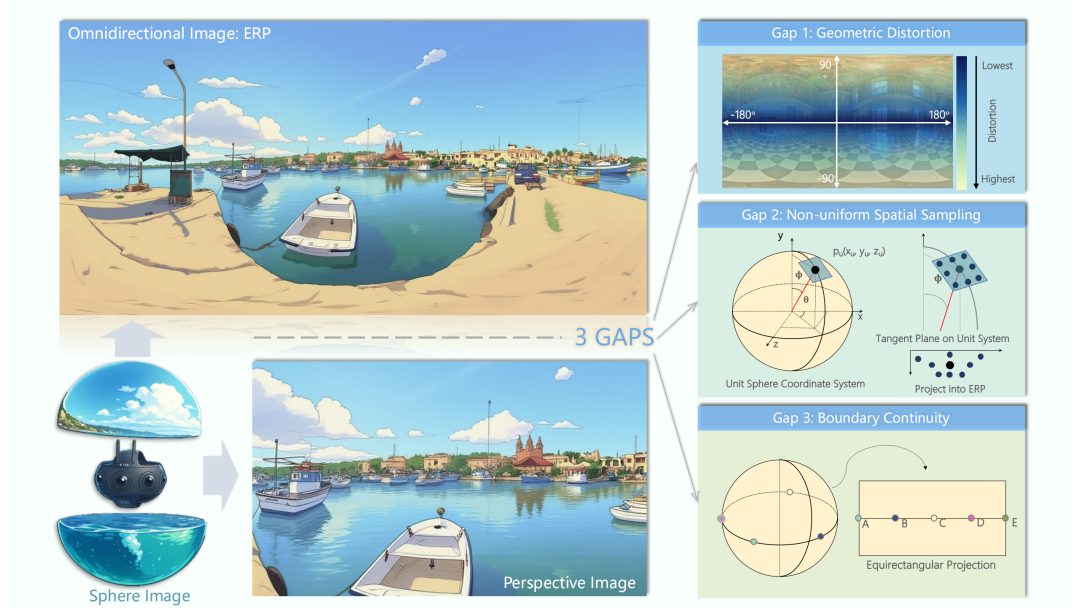

在全景视觉中,分割/修复等依赖全局语义一致性,而深度/光流等强调局部几何精度,因此形成了不同策略谱系。图(c)给出跨方法(cross-method)纵向对照:明确 Distortion-Aware / Projection-Driven / Physics-/Geometry-based 的适用分工,并与代表性任务逐一进行策略适配。其价值在于提供一个统一参考:研究者可从整体视角理解任务需求,快速选型或设计最合适的方法,也为多策略融合与后续创新奠定基础。

图(a)和图(b)分析了两种典型的策略:

① Distortion-Aware(失真感知方法):直接在 ERP 全景格式上建模,通过畸变设计、畸变图权重或自适应注意力来补偿极区问题。

② Projection-Driven(投影驱动方法)

③选型分析:

两大策略的交叉适配:

Physics-driven 适配:一些特异性的任务依赖物理先验(如光照估计、反射去除、布局检测)。

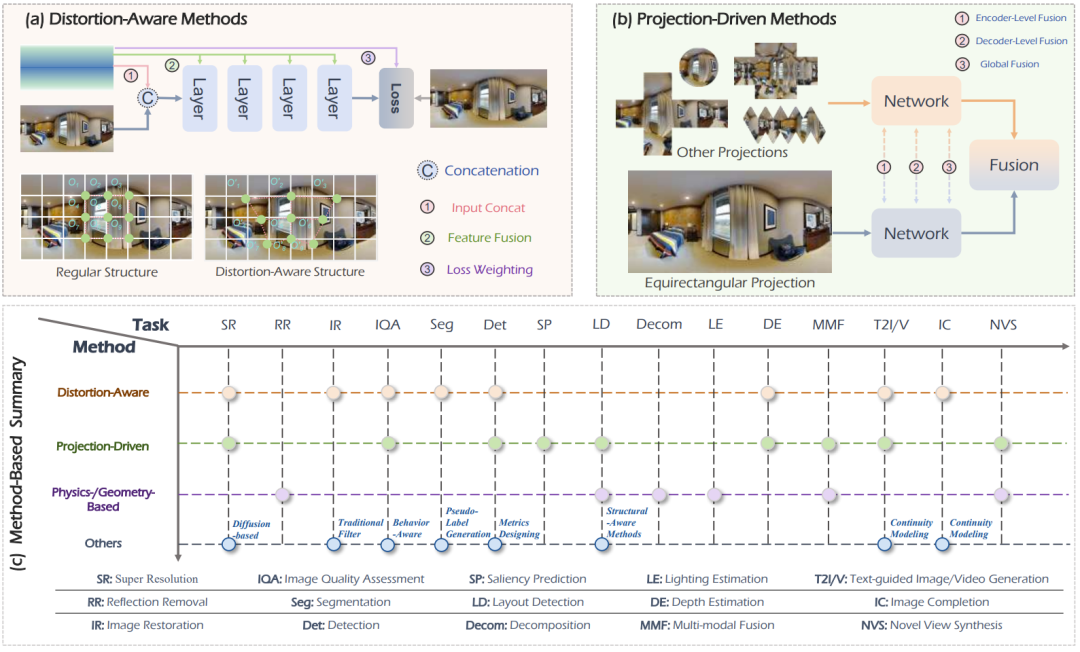

这是全文的横向 cross-task 对照表:将全景视觉的 20+ 代表性任务按四大板块归类(增强与评估、理解、多模态、生成),并在每个任务下标注了具有代表性的方法路线与代表工作。它与前一张 “cross-method” 图形成互补:前者 “纵向看方法→适配哪些任务”,这张表 “横向看任务→常用哪些策略 / 里程碑工作”。

具体地,左侧是任务清单。每一行右侧列出该任务的主流路线及典型论文。这让读者可以反向索引:从任务入手,快速定位合适的技术路线与关键文献。值得一提的是关于新范式加速渗透的整理:Diffusion / 生成式模型在 T2I/V、IC、NVS 与世界模型方向快速涌现,强调语义一致与可控性;3DGS:在 NVS / 场景重建中带来高效高保真渲染;多模态对齐尤其是音频 / 文本 / LiDAR 与全景的对齐成为新热点。

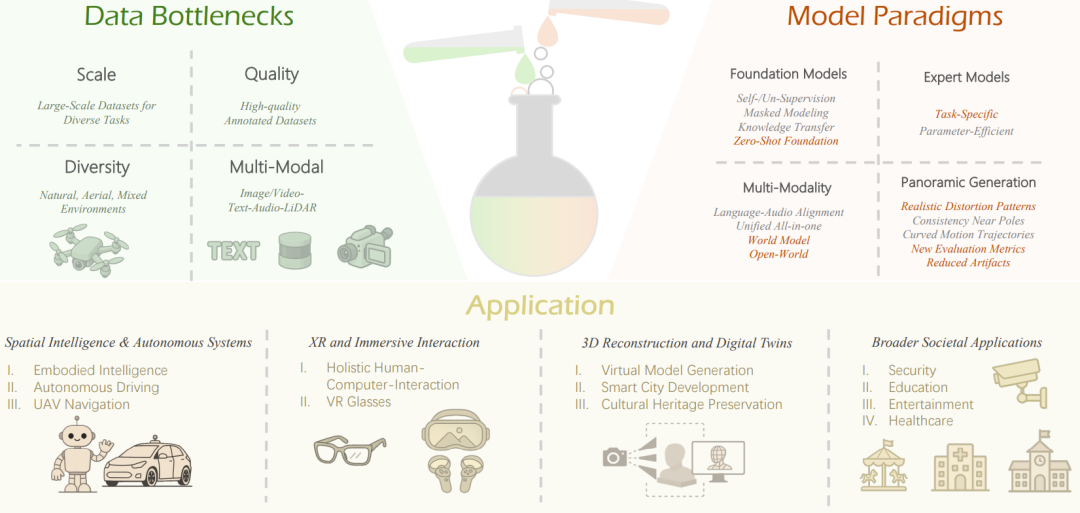

关于全景视觉的未来,要想从 “可用” 走向 “好用”,需要在数据—模型—应用三条主线上同步推进:

(1) 数据瓶颈(图左上)

(2) 模型范式(图右上)

(3) 下游应用(图下)

透视到全景并非一次简单的 “投影转换”,而是一场贯穿数据、模型与应用的系统性升级。本综述以 “透视—全景 gap” 为主线,梳理挑战、方法与未来应用,为研究者与工程团队提供按任务选型的 “路线图”。我们也欢迎社区共同完善基准与数据,推动全景视觉在 XR、机器人系统与数字孪生等关键场景中真正 “好用、可用、可落地”。

更多细节与完整方法清单,请查阅论文与项目主页。

文章来自于微信公众号 “机器之心”,作者 “机器之心”