我们被「黑箱」困住了!深度生成模型虽能创造逼真内容,但其内部运作机制如同「黑箱」,潜变量的意义难以捉摸。埃默里大学团队提出LatentExplainer框架,巧妙地将潜在变量转化为易懂解释,大幅提升模型解释质量与可靠性。

如今,深度生成模型(Deep Generative Models),如变分自编码器(VAE)和扩散模型,已成为图像、音频乃至视频生成领域的核心技术。

它们通过学习数据的潜在分布,赋予AI强大的「想象力」,能够创造出以假乱真的新内容。

然而,这些模型内部运作的机制却如同一个巨大的「黑箱」。

我们只知道输入指令,得到输出结果,但对于模型内部的「思考过程」——也就是那些被称为潜在变量 (latent variables) 的抽象表示——我们知之甚少。

这带来了三大难题:

面对上述挑战,美国埃默里大学的研究团队提出了一个通用、创新的框架LatentExplainer,旨在自动为深度生成模型中的潜在变量生成人类可理解的、语义丰富的解释。该研究已被CIKM 2025大会接收。

论文链接:https://arxiv.org/abs/2406.14862

代码链接:https://github.com/mengdanzhu/LatentExplainer

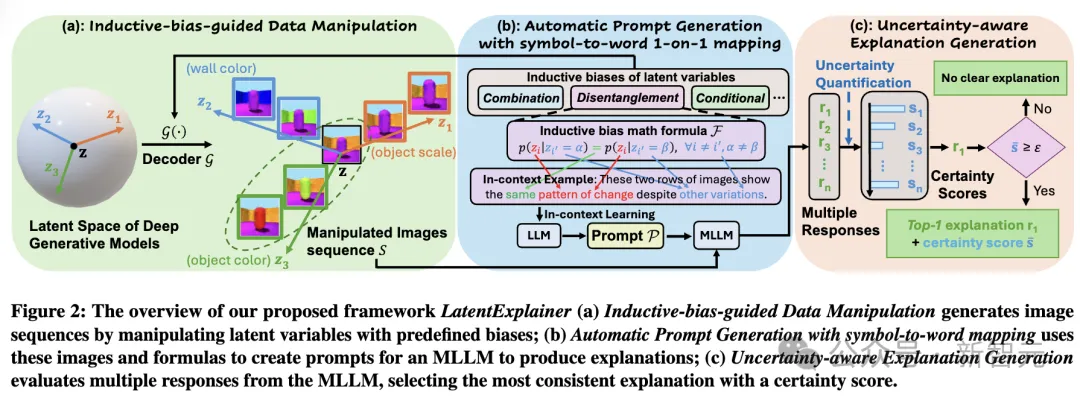

整个流程可以分为三步:

1. 归纳偏置引导的数据扰动 (Inductive-bias-guided Data Manipulation)

不是盲目地改变潜在变量,而是根据模型预设的「归纳偏置」(如解耦、组合、条件偏置)来设计扰动策略。

例如,对于一个要求「解耦」的模型,会同时扰动两个不同的潜在变量,确保它们之间的变化是相互独立的,从而更准确地捕捉每个变量的独立语义。

2. 自动智能提示生成(Automatic Prompt Generation)

研究者们将复杂的数学公式(代表归纳偏置)转化为自然语言提示(prompt),并建立了一个「符号-词语」映射表,让大模型能够理解并遵循模型的内在逻辑。

这种「数学到语言」的转换,极大地减少了大模型在解释时的「幻觉」,保证了解释的准确性。

利用预训练的语言模型作为coding agent,结合需要解释的潜变量,将自然语言提示自动生成一段修改生成模型解码器(decoder)代码的指令。

3. 感知不确定性的解释生成 (Uncertainty-aware Explanation Generation)

为了应对「并非所有变量都可解释」的问题,LatentExplainer引入了不确定性量化。它会多次向大模型(如GPT-4o)提问,然后计算所有回答之间的相似度(一致性得分)。

只有当解释足够稳定可靠(得分超过阈值)时,才会给出最终解释;否则,它会诚实地说:「无清晰解释」。

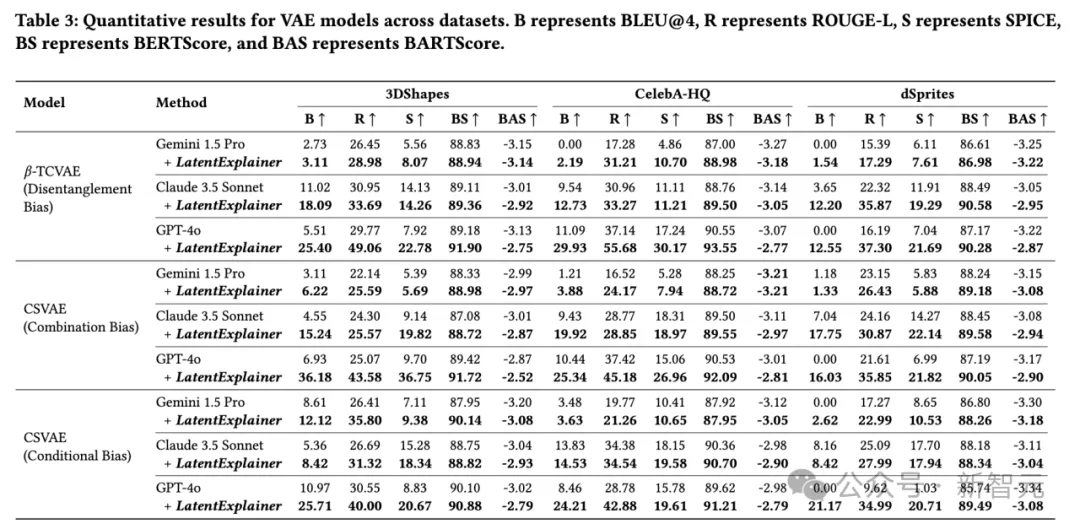

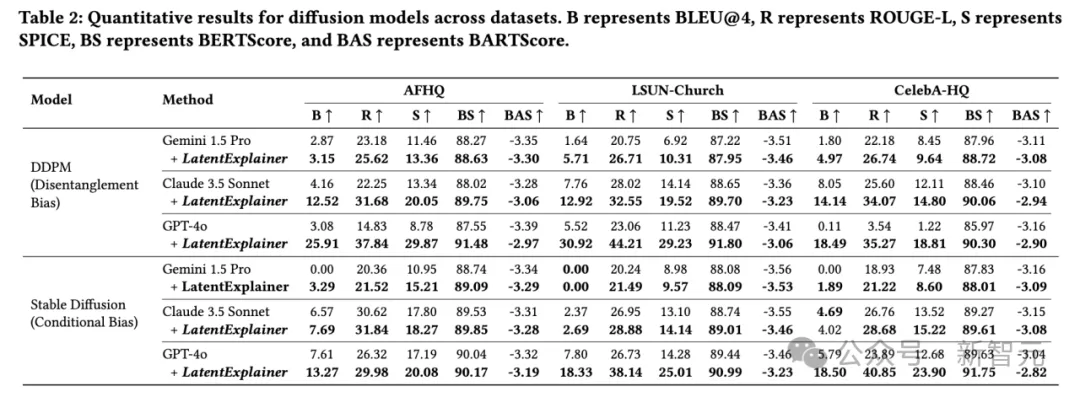

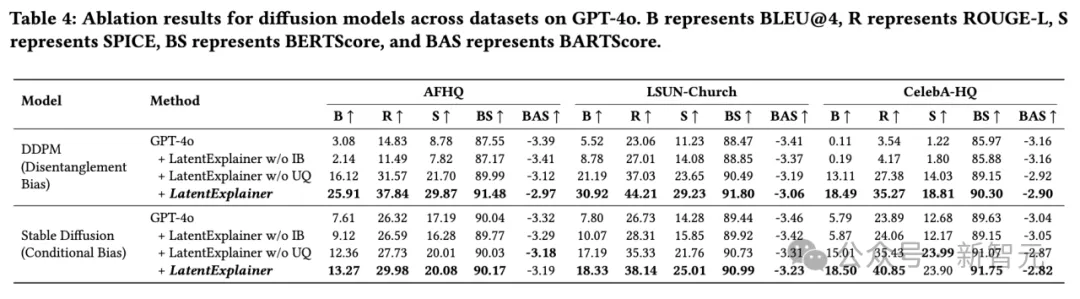

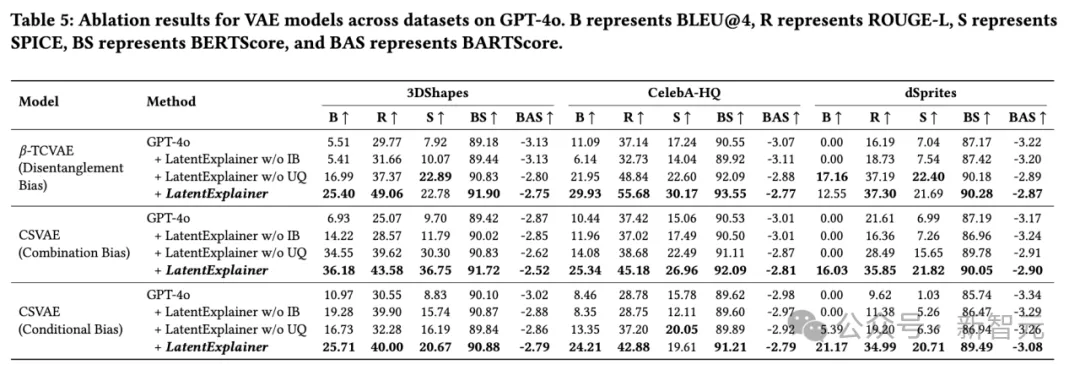

研究团队在CelebA-HQ、LSUN-Church、3DShapes等多个真实和合成数据集上进行了广泛实验,涵盖了VAE和扩散模型两大类主流生成模型,并针对三种不同的归纳偏置(解耦、组合、条件偏置)进行了评估。

全面超越基线: 无论是使用GPT-4o、Gemini 1.5 Pro还是Claude 3.5 Sonnet作为基础大模型,加入LatentExplainer后,其生成的解释在BLEU、ROUGE-L、SPICE、BERTScore、BARTScore等所有自动化评估指标上均取得显著且一致的提升。

质的飞跃: 以GPT-4o在CelebA-HQ数据集上翻译Stable diffusion潜变量为例,BLEU分数从5.79飙升至18.50,ROUGE-L从23.89提升至40.85,几乎翻倍!这表明LatentExplainer不仅能「说」,还能「说得更好、更准」。

消融实验证明核心价值: 移除「归纳偏置提示」或「不确定性量化」组件后,性能都会出现明显下降,尤其是移除归纳偏置提示,性能损失巨大。这充分证明了这两个设计是LatentExplainer成功的关键。

LatentExplainer的核心突破,在于它不再让大模型「凭空猜测」,而是将生成模型自身的归纳偏置转化为大模型能听懂的「操作指令」。

通过「数据扰动+智能提示+不确定性评估」三步走,它成功地为VAE、Diffusion等模型的潜变量生成了准确、可信的人类可读解释,性能提升近2倍。

LatentExplainer为打开生成模型的「黑箱」提供了一把强有力的钥匙,让模型不仅会生成,更能解释与对齐,为未来构建更透明、更可控、更值得信赖的生成式AI系统奠定了坚实基础。

参考资料:

https://arxiv.org/abs/2406.14862

文章来自于微信公众号“新智元”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0