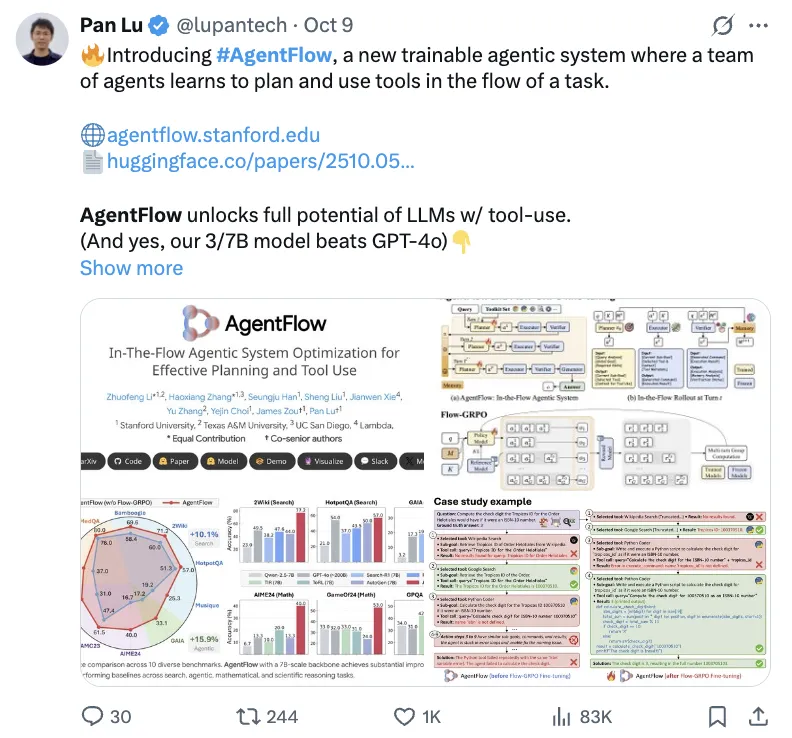

斯坦福等新框架,用在线强化学习让智能体系统“以小搏大”,领先GPT-4o——

AgentFlow,是一种能够在线优化智能体系统的新范式,可以持续提升智能体系统对于复杂问题的推理能力。

它由规划器、执行器、验证器、生成器四个专业智能体组成的团队通过共享内存进行协作,利用新方法Flow-GRPO,在系统内部直接对其规划器智能体进行实时优化。

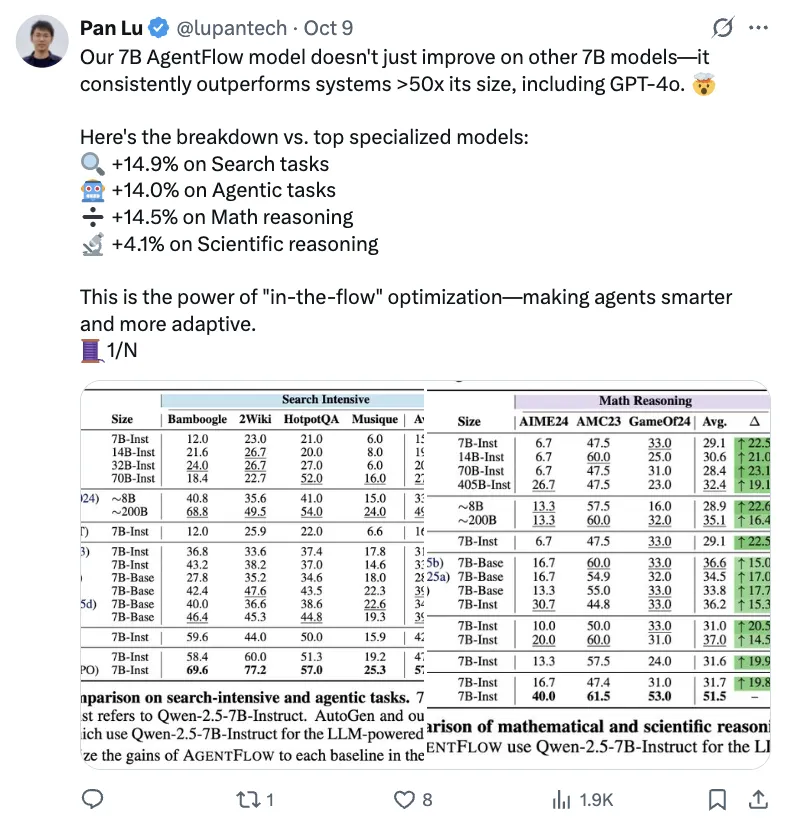

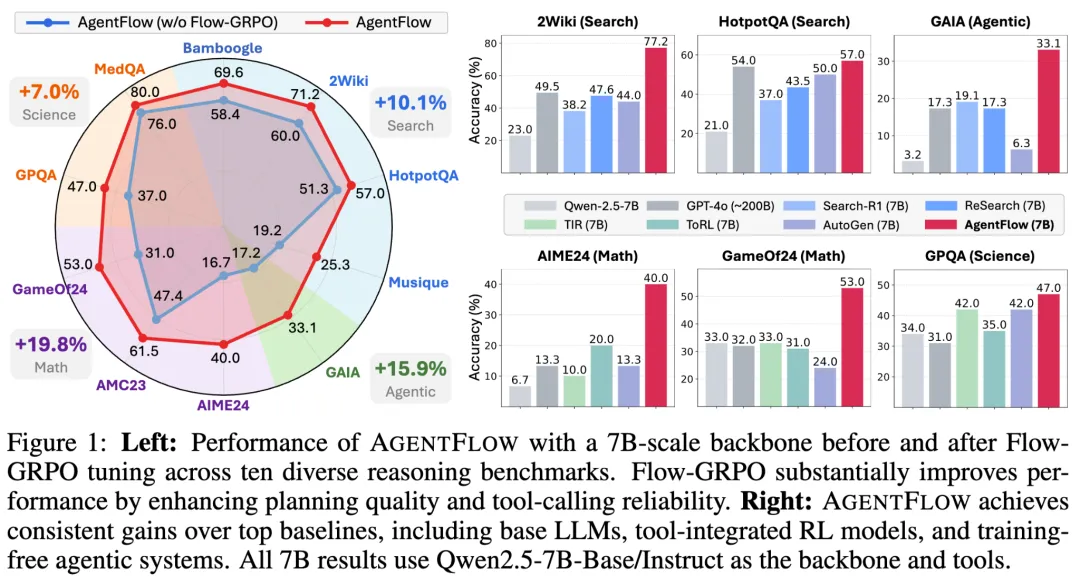

以Qwen-2.5-7B-Instruct为基座模型的AgentFlow在10个基准测试中表现突出:

搜索任务提升14.9%、智能体任务提升14.0%、数学任务提升14.5%、科学任务提升4.1%。

多项任务表现甚至超越比其大50倍的模型,超越GPT-4o、Llama3.1-405B。

AgentFlow发布后,受到业界不少广泛关注与看好。

网友纷纷表示方向很棒:

多智能体流(multi-agent flow)给人的感觉就像“相位耦合推理”(phase-coupled reasoning)。很期待看到“协同能力”取代“规模”,成为衡量智能的指标。

Flow-GRPO采用共享内存的多智能体架构设计精妙。其中验证智能体对幻觉化工具调用的阻断机制尤为关键——它能显著减少智能体工作流中典型的多步推理链误差传播。

所以,AgentFlow究竟长啥样?

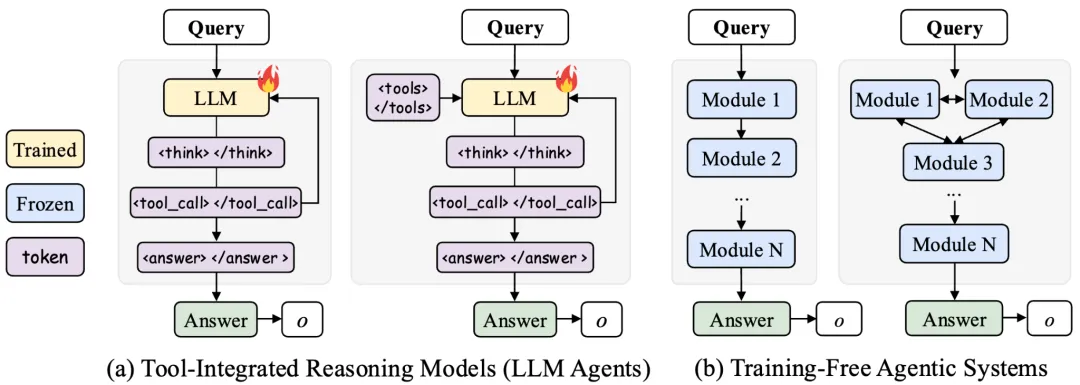

自“AI下半场”开启以来,智能体(Agent)在垂直领域与通用场景中呈现出井喷式发展。然而,在复杂决策与持续优化能力方面,当前智能体仍存在一定局限。如何将智能体的推理能力与强化学习的自我进化机制深度融合,成为突破这一瓶颈的关键所在。

在今年早些时候,随着DeepSeek-R1的发布,推理模型的训练方式迎来了新的启发。不久之后,伊利诺伊大学香槟分校(UIUC)发布Search-R1,系统揭示了如何通过强化学习,训练能够自主推理并调用外部工具的推理模型(Tool-Integrated Reasoning Models)。

而在此之前,智能体系统(Agentic System)的发展也从系统层面推动了智能体协作与可扩展性的提升,为后续相关研究奠定了坚实基础。

例如,LangGraph、PydanticAI、OWL等框架在智能体通信、任务规划与工具调用等方面进行了多样化的探索,为智能体生态的快速演进提供了有力支撑。

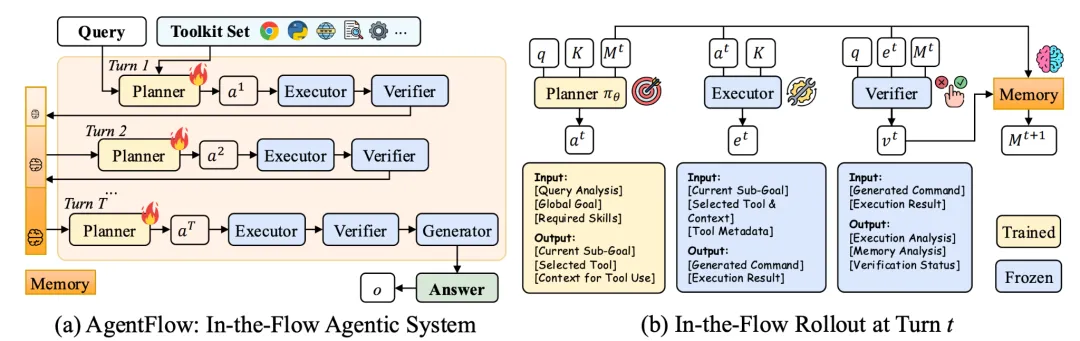

而AgentFlow提出了一种新范式,其中由四个具备记忆能力的专门化智能体协同配合:

规划器负责分析任务并选择工具,执行器调用工具并整合结果,验证器基于累积记忆评估中间结果,生成器整合信息生成最终答案。

对于每个新任务,规划器在智能体交互的“流”中根据环境变化及其他智能体的反馈实时进行on-policy优化,各模块在推理流中协同演化并不断调整决策策略。这些优化随后被整合到系统的记忆中,形成一个闭环的自适应推理过程,使整个智能体系统在复杂环境下实现鲁棒的工具调用与持续进化。

其中,AgentFlow包含了以下几个关键组件:

模块化智能体结构。

AgentFlow采用了四个具备记忆能力的专门化智能体协同配合,共同完成复杂推理,从而实现“即时学习”:

(i)规划器(Action Planner):分析任务、制定策略并选择最合适的工具;

(ii)执行器(Tool Executor):调用工具集并整合工具执行结果;

(iii)验证器(Verifier):基于系统维护的累积记忆评估中间结果是否满足目标与约束;

(iv)生成器(Generator):整合所有信息与验证反馈,生成最终答案或行动建议。

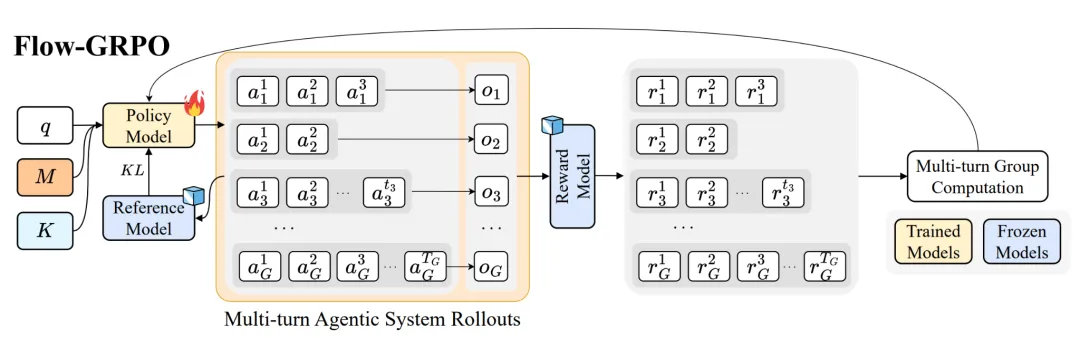

AgentFlow流中强化学习。

AgentFlow的关键创新在于:规划器(Planner)并非固定不变,而是能够在智能体交互的”流”(flow)中实时进行on-policy优化,使决策过程随着环境变化及其他智能体的反馈不断自适应进化。集成过程分为三个步骤:(i)环境感知与记忆检索,(ii)动作规划与工具选择,(iii)策略优化与记忆更新。

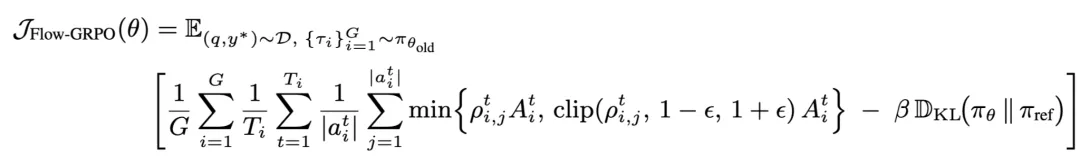

Flow-GRPO:流中强化学习优化算法。

实现智能体流中强化学习训练的核心挑战在于多轮信用分配(multi-turn credit assignment):即如何在长时跨度(long-horizon)且奖励稀疏(sparse reward)的条件下,稳定且高效地训练。为此团队提出动作级别的(Action Level)的多轮推理优化目标。

如图2所示,通过将轨迹最终结果的成功或失败信号(outcome reward)广播至每一步,将原本复杂的多轮强化学习问题转化为一系列可处理的单轮策略更新。该方法不仅缓解了奖励稀疏问题,还显著提升了训练效率,为智能体在复杂多轮推理中的稳定学习提供了基础。

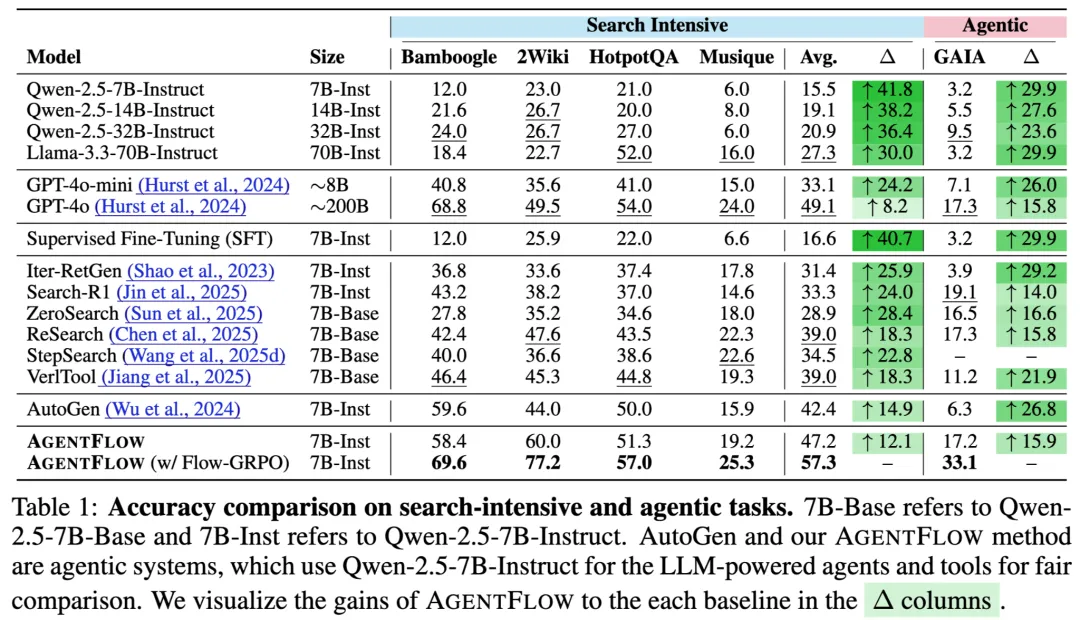

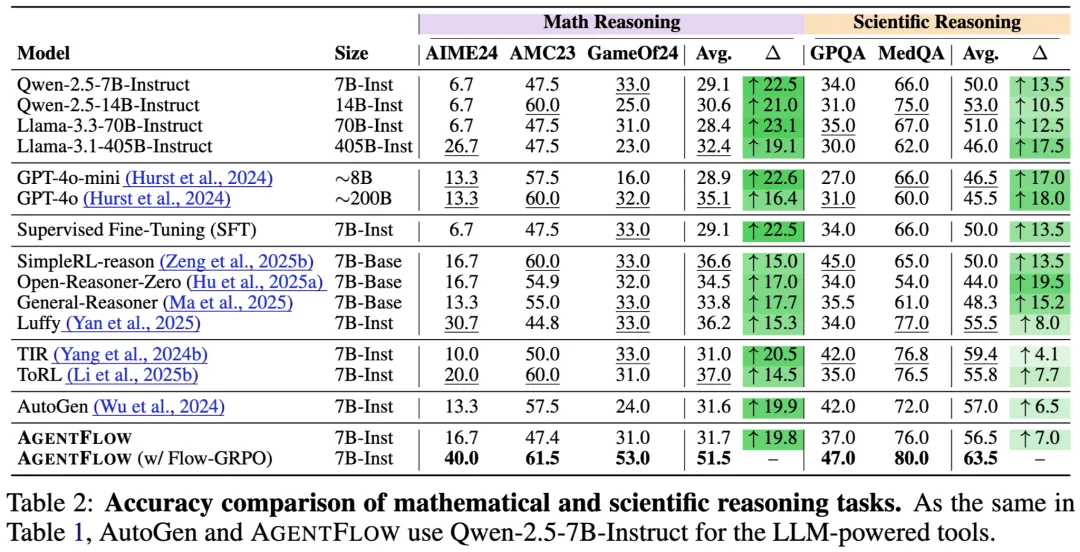

为了充分评估AgentFlow的泛化能力与高效性,研究团队在10个跨各个领域的基准测试上进行了系统评测,涵盖知识检索、智能体任务、数学推理和科学推理四大类。

以Qwen-2.5-7B-Instruct为基座模型的AgentFlow在各项基准上均超越现有领先方法:

值得注意的是,AgentFlow的表现甚至超过了大规模的专有模型,如GPT-4o(~200B)。

表1、2展示了AgentFlow在不同类型任务上的评估结果,表明了在有效性(相对提高高达14.9%)和效率(平均推理步数优化)上均优于基准方法。

研究团队在10个基准测试上进行了评估,涵盖知识检索、智能体任务、数学推理和科学推理四大类。一些有趣的发现:

1、模型规模不是唯一答案

使用7B参数的AgentFlow在多个任务上超过了约200B参数的GPT-4o,Llama3.1-405B,在搜索任务上领先8.2%,在智能体任务上领先15.8%。这再一次展现了,合理的系统设计和训练方法可能比单纯堆砌参数训练All in one的大模型更有效。

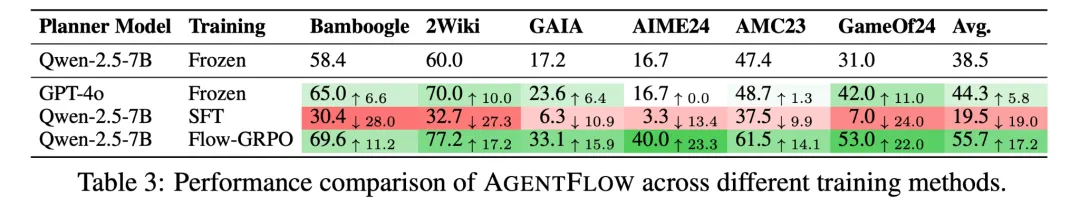

2、“在流中学习”至关重要

对比实验显示,若采用离线监督学习(SFT)方式训练规划器,性能反而显著下降,平均降低19%。

这表明,智能体在真实交互环境“流”中进行在线学习是实现高效推理的必要条件。

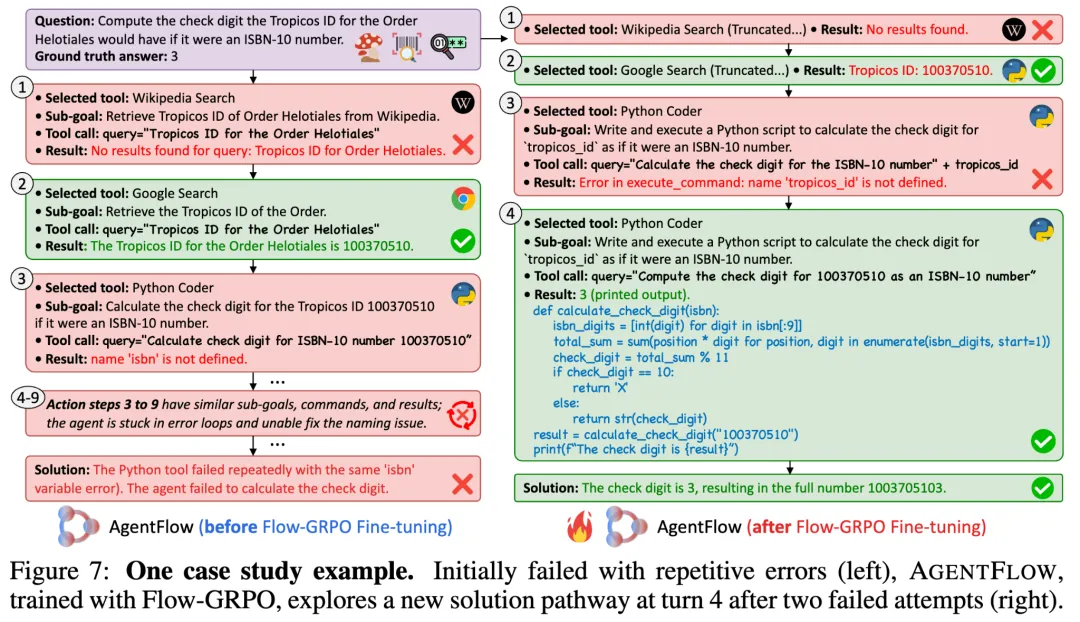

此外,尽管AgentFlow的推理流本身能够利用其强大的任务分解能力带来显著性能提升,但仍可能出现循环错误或卡顿问题。通过在真实环境中的训练,智能体系统展现出快速修正错误的工具调用、更精细的子任务规划,以及全局任务解决性能的提升。

这些结果进一步证明了模块协作机制以及流中强化学习在提升多轮智能体系统稳定性与效率方面的显著作用。

3、自主发现新的解决路径

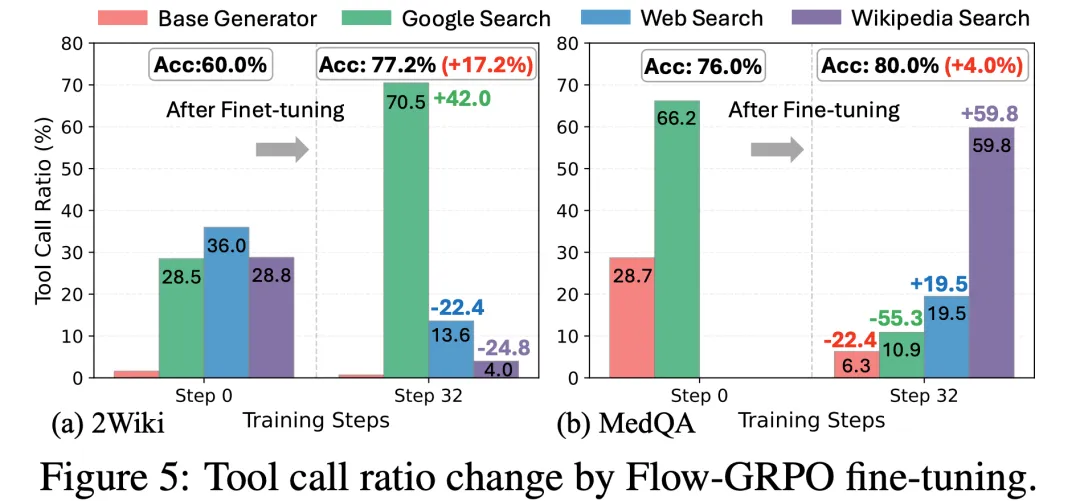

有意思的是,经过Flow-GRPO的强化训练规划器,系统学会了根据任务特点选择合适的工具组合;同时,经过训练的系统会自发探索出新的工具使用模式,比如组合使用维基百科搜索(Wikipedia Search)和特定网页增强搜索(Web Search)的连招,通过工具链获得更加深入地信息挖掘,而这些模式几乎没有在未训练的推理流中出现。

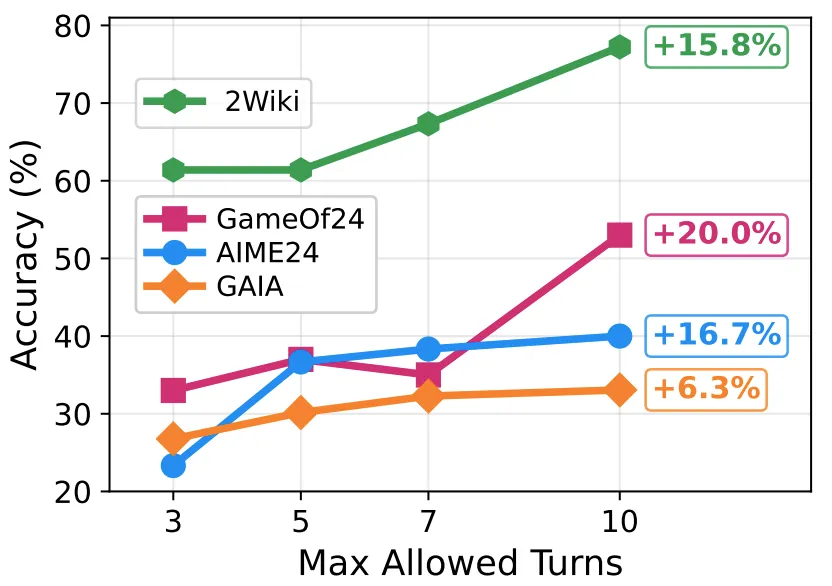

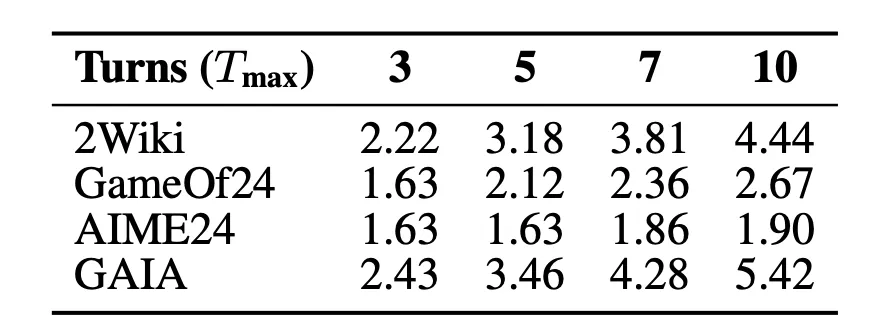

4、动态推理深度与性能提升

对于相同的数据集下的不同难度任务:譬如说多跳搜索(Multihop Search),智能体任务中的密集长链推理任务,AgentFlow在经过 FlowGRPO训练后能够随着最大限制推理步数的上升稳步提升性能,同时又不会大幅提升平均推理步数——这表示对于长难任务会增加有效的推理步数来提升正确率,而不会一味地所有任务都随着最大轮数限制而延长推理步数。

总之,AgentFlow为智能体训练提供了一种全新的思路:

与其追求一个功能完备的单一大语言模型或“一次性完美”的智能体系统,不如让智能体在系统中自我适应与持续学习。

通过将群体智能与“边做边学”的范式相结合,AgentFlow使智能体系统能够在协同演化中不断优化,从而高效应对复杂任务。

尽管从研究探索到实际应用仍有较长的距离,但这让团队看见Agentic AI依然蕴藏着巨大的潜力与想象空间。

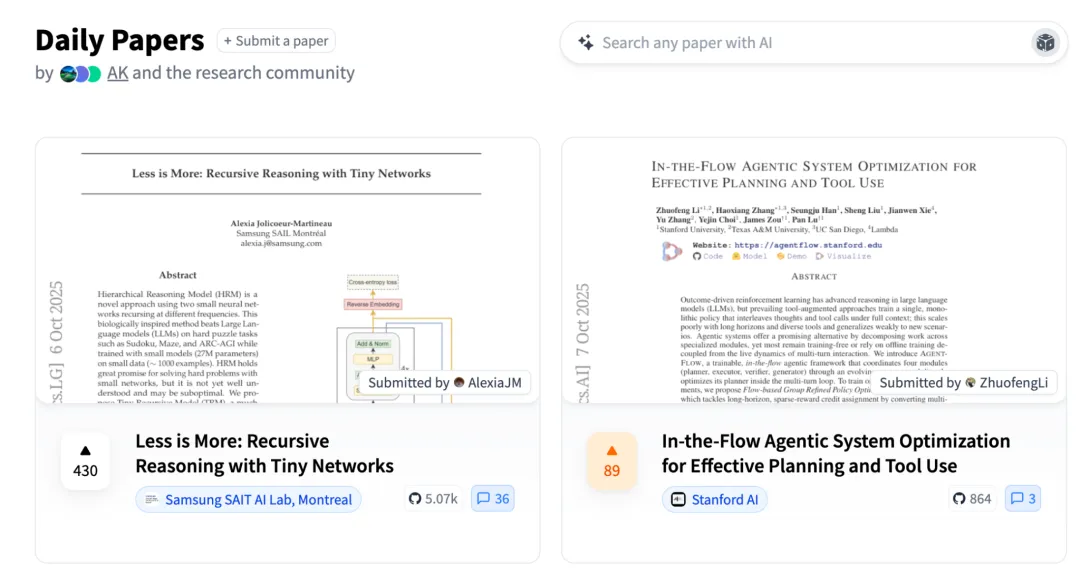

论文地址:https://arxiv.org/abs/2510.05592

项目主页:https://agentflow.stanford.edu/

Github仓库:https://github.com/lupantech/AgentFlow

在线Demo:https://huggingface.co/spaces/AgentFlow/agentflow

YouTube视频:https://www.youtube.com/watch?v=kIQbCQIH1SI

文章来自于微信公众号“量子位”,作者是“允中”。

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】Semantic Search on Wikipedia是一个索引数百万维基百科文章的AI搜索引擎。该项目开源免费,通过维基百科数据创建了一个语义搜索引擎和一个RAG聊天机器人。

项目地址:https://github.com/upstash/wikipedia-semantic-search?tab=readme-ov-file

在线使用:https://wikipedia-semantic-search.vercel.app/

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/