能看懂相机参数,并且生成相应视角图片的多模态模型来了。

来自S-Lab、新加坡南洋理工大学、商汤科技、美国密歇根大学、德国马普所的研究员提出了Puffin统一多模态模型。它能整合理解相机参数(如角度、视野)与按相机参数生成对应视角图片的能力。

通过用相机思考(将参数转摄影术语、分析空间线索)和400万组数据训练,解决了此前模型两者分离的问题,统一了以相机为中心的多模态理解与生成,支持空间想象,并实现灵活的跨视角应用如世界探索等

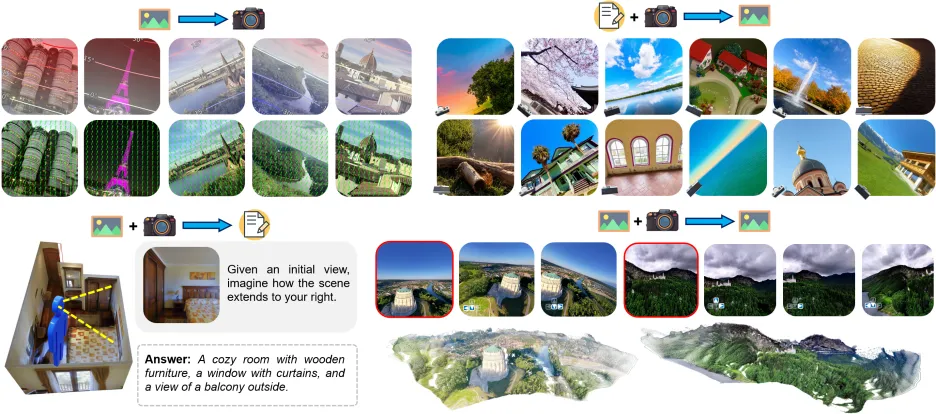

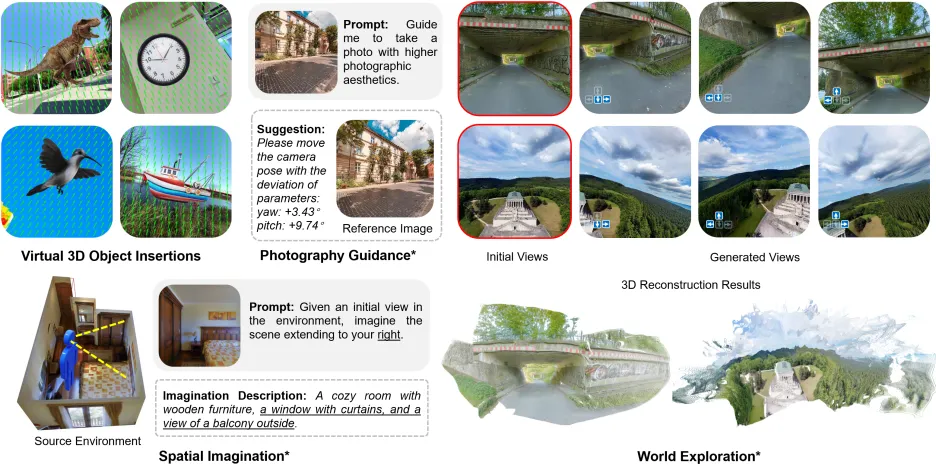

△展示模型多样化能力的示意图

下面具体来看。

人类如何观察并理解世界?我们会根据环境线索在空间中动态调整视觉系统,通过改变三维朝向和焦距,保持对周围环境的灵活感知。

这样的能力使我们能够从任意视角中理解场景、猜想视野外的环境,并在脑海中重现一个具备自由视点的真实世界。

对机器而言,相机是与物理世界交互和实现空间智能的重要接口。

一方面,通过图像理解相机几何,机器能够从二维投影中恢复复杂的三维结构,进而指导下游的自主定位和导航任务;

另一方面,通过调节内外参数,相机还能提供灵活的物理控制,帮助空间内容的生成,从任意视角模拟世界的样貌。

然而,目前上述两类任务大部分都是被独立研究,两者之间潜在的有效关联尚未被充分探索。

此外,现有的统一多模态大模型往往受限于固定视角的约束,只能在简单的前视视角(front-view)条件下生成和理解场景,难以在视角多变的真实世界中应用。

为此,团队首次尝试在统一框架下融合以相机为中心(camera-centric)的理解与生成任务,将统一多模态大模型这一范式拓展至专注相机几何的空间智能领域。

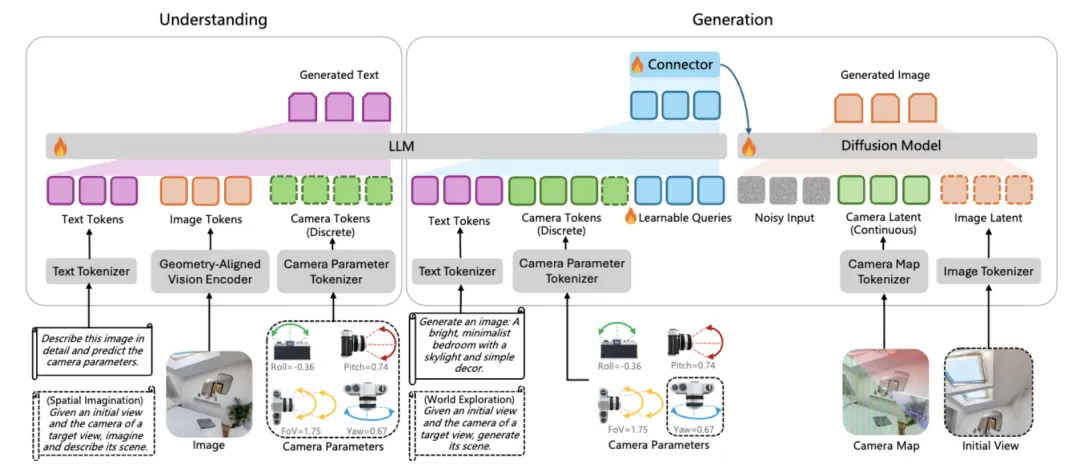

如下图,团队提出的Puffin模型结合了语言回归与基于扩散模型的生成能力,能够从任意视角和方向理解并创造场景。通过团队设计的指令微调阶段,Puffin还能灵活拓展至复杂的跨视角理解与生成任务。

△虚线框内的部分表示在指令微调阶段进行的跨视角理解与生成过程,例如空间想象与世界探索等能力

在理解任务的网络设计方面,一种直接的方法是对包含视觉编码器与语言模型的现有多模态大模型进行微调,但这种朴素策略存在两点局限性:

为解决上述问题,团队引入了一个几何对齐的视觉编码器,通过语义教师网络(如 CLIP、SigLIP)与视觉教师网络(如 DINO、SAM)的双重蒸馏获得。

该编码器能够在保持几何保真度的同时,兼具强语义理解能力。随后,团队采用渐进式解冻与联合微调的方式,将该编码器与语言模型逐步对齐。

这种分阶段优化策略使得模型在底/中层结构线索与高层语言推理之间建立紧密联系。

在生成任务的网络设计方面,团队沿用MetaQueries架构并设计了一个连接模块,通过一组可学习的queries,将文本描述和相机参数对应的LLM 隐式状态映射为可被扩散模型理解的条件信号。

为更好地利用相机几何信息,除了由数值参数离散化得到的相机离散token外,团队还引入了像素级的相机透视场作为连续的相机潜在变量,从而在图像生成中实现更精细的空间控制。

与语言或图像不同,相机模型及其物理参数抽象且不直观——它们以数值形式描述视场、方向或投影关系,而非语义内容。这种差异导致在多模态模型中融入相机信息时会出现模态鸿沟(modality gap)。

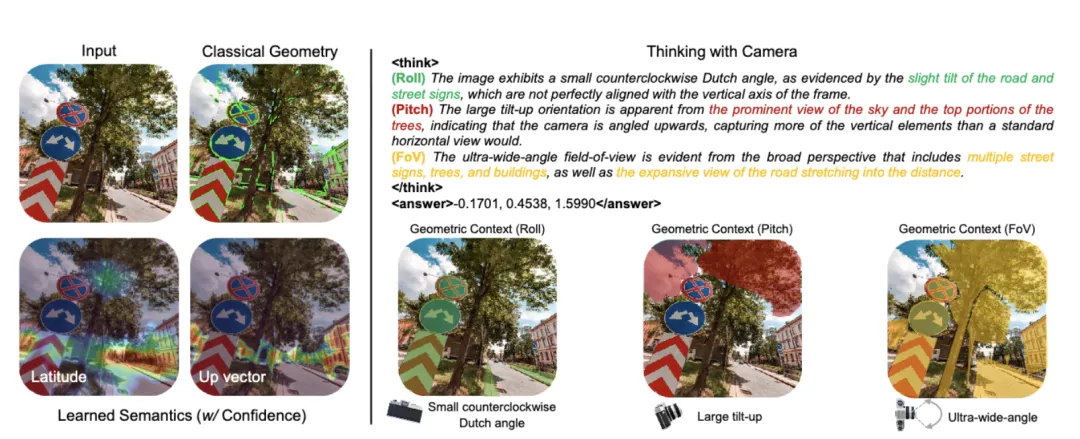

△“与相机共思(thinking with camera)”概念

如图(左)所示,以往的视觉方法主要通过提取或学习几何结构或语义信息等表征来从图像中估计相机几何。然而,上述表征往往侧重于局部的低层或中层视觉特征,难以捕捉到整体且连贯的空间概念。

本研究并非追求更优的表征设计或学习,而是从另一角度出发——将相机理解为语言。如图(右)所示,团队提出了通过多模态大模型“与相机共思”(thinking with camera)的概念。

该方法在几何语境下对不同相机参数进行解耦,并在空间约束的视觉线索与专业摄影术语之间建立关联。随后,模型在空间推理过程 中进行分析和思考,并将相机理解结果输出在 标签中。

“与相机共思”(thinking with camera)空间推理过程中的三大核心要素:

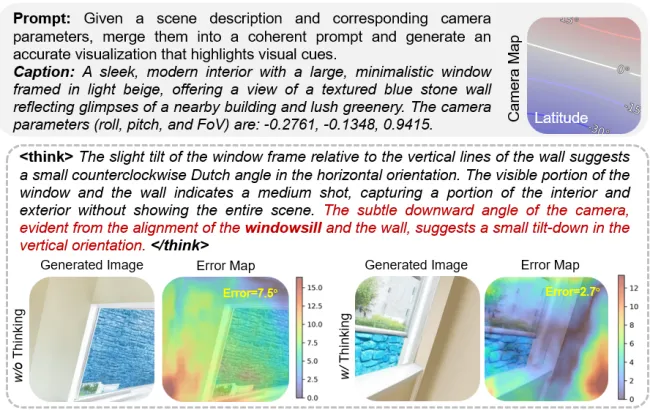

与理解任务不同,可控图像生成需要更复杂的跨模态对齐与精细的视觉细节合成。

如上所述,相机参数数值对于当前多模态大模型而言过于细粒度,难以有效解析,从而无法准确捕捉相机可控生成所需的真实空间分布。

为此,团队设计了一种结合视觉细节分析与推理的分步生成流程:模型首先根据给定的相机空间信息从原始文本描述中推断潜在的视觉线索,然后将这一文本推理阶段作为语义规划,用于引导图像生成。

此外,数值化相机参数被转化为更适合模型理解的专业摄影术语。

团队发现,上面的步骤与相机理解中的推理过程自然对齐。因此,团队在可控生成与理解之间引入了共享的思维链机制,统一了多模态任务之间的思考方式。

如下图所示,当给定较小的俯仰角和“室内”描述时,团队的模型会将参数角度值转化为摄影术语(如small tilt-down),并推测出窗台等潜在的视觉线索,从而辅助生成更精确的空间结构。

△在可控图像生成任务中引入与理解任务共享的思维链机制,同样可以进行 “与相机共思“(thinking with camera)

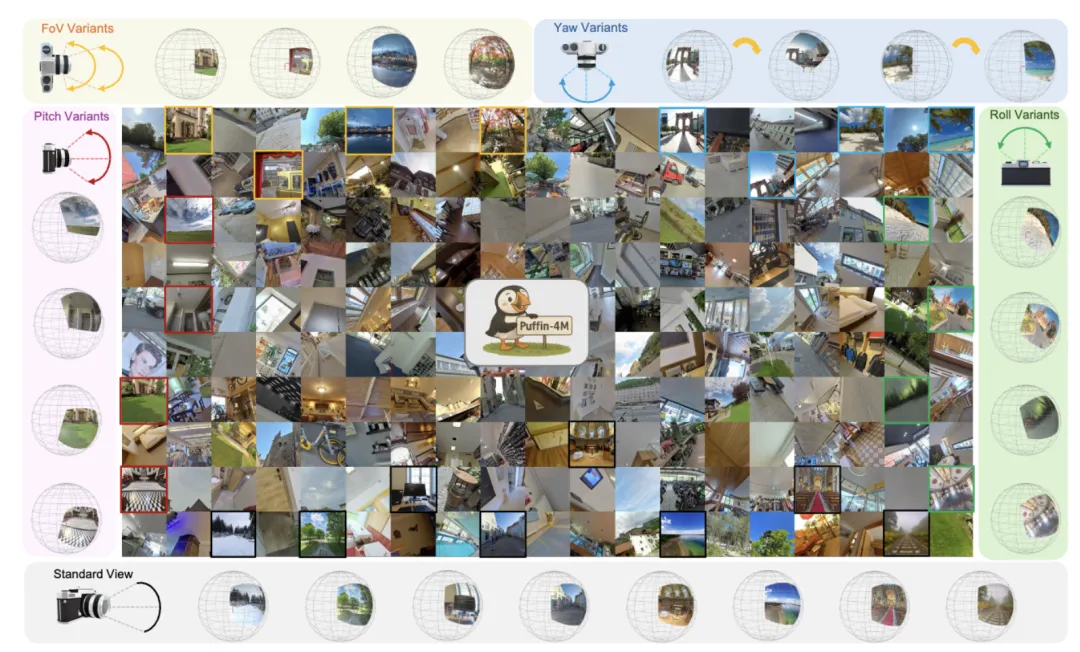

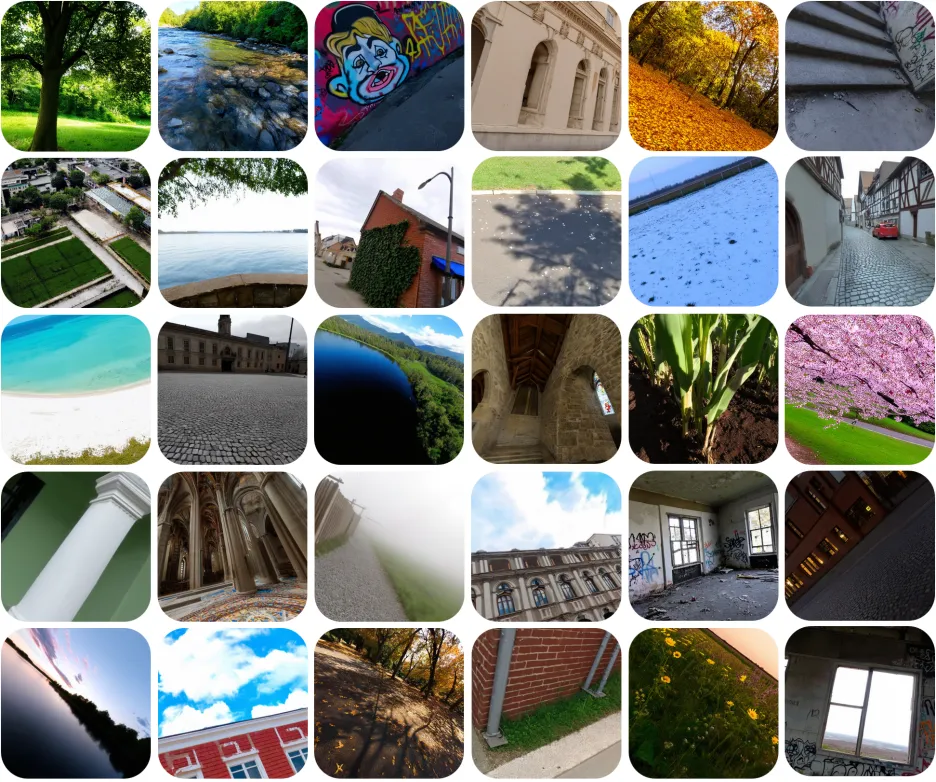

在多模态空间智能领域,能够同时覆盖视觉、语言与相机模态的数据集与基准仍极为稀缺。为弥补这一空缺,团队提出Puffin-4M——一个包含约400 万图片-语言-相机三元组的大规模高质量数据集。

数据集的示例图如下所示,其中相机配置部分团队考虑了常用小孔相机模型下的标准内外参数(roll, pitch, yaw, FoV)。

△Puffin-4M示例图

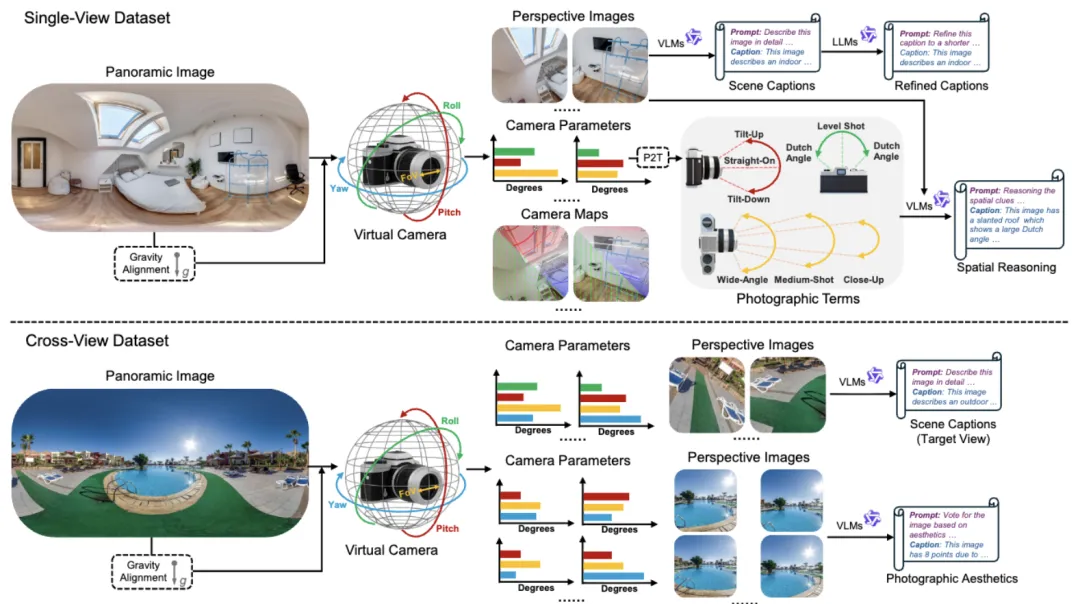

下图展示了Puffin-4M数据集的构建流程,其中包括四个阶段:360°全景数据的收集与预处理、2D透视图像的渲染生成、场景描述与空间推理打标,以及跨视角场景的扩展。

△Puffin-4M数据集构建流程

除了上述训练集以外,团队还构建了两个评测基准数据集:Puffin-Gen和Puffin-Und,分别为相机可控生成和相机理解提供更加具备挑战性和综合性的验证标准,均已开源。

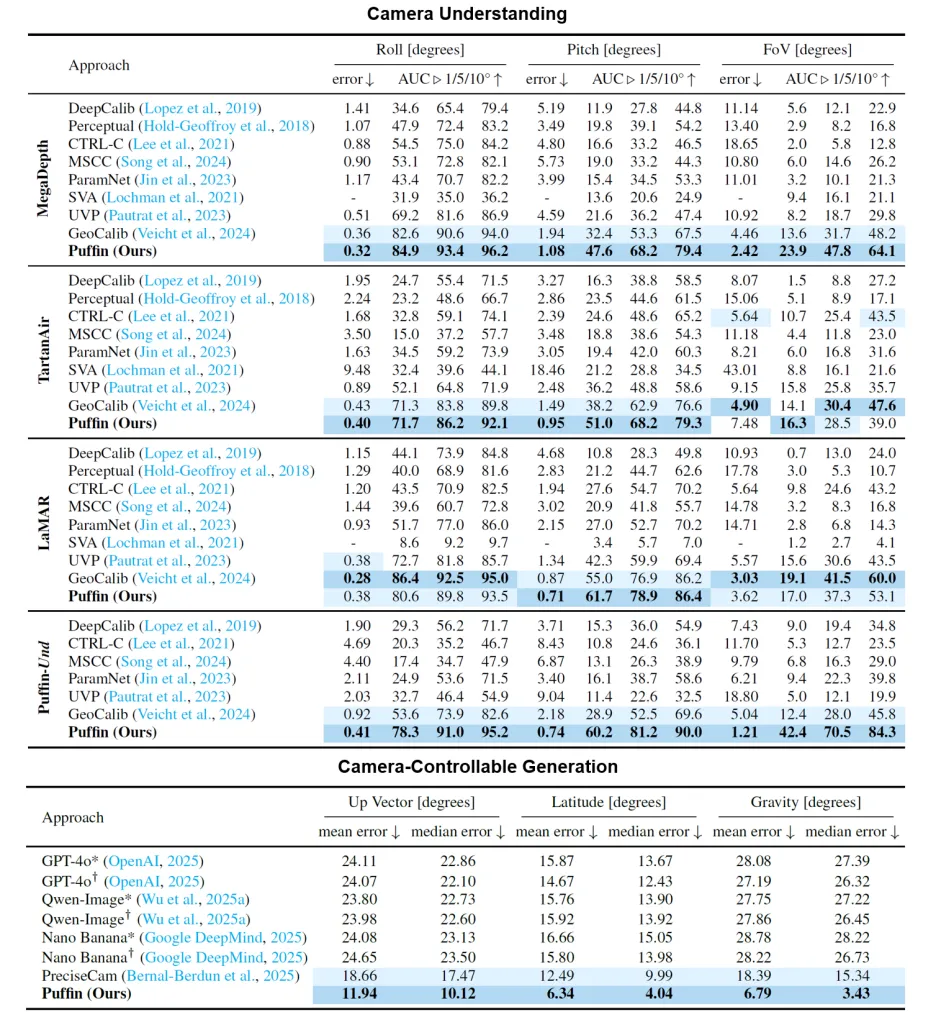

如下所示,团队以相机为中心的统一多模态大模型Puffin与现有的专业级理解或生成模型相比,在多个数据集上表现出极具竞争力的性能,并在大部分数据集上超越现有模型。

△与现有方法的定量对比结果

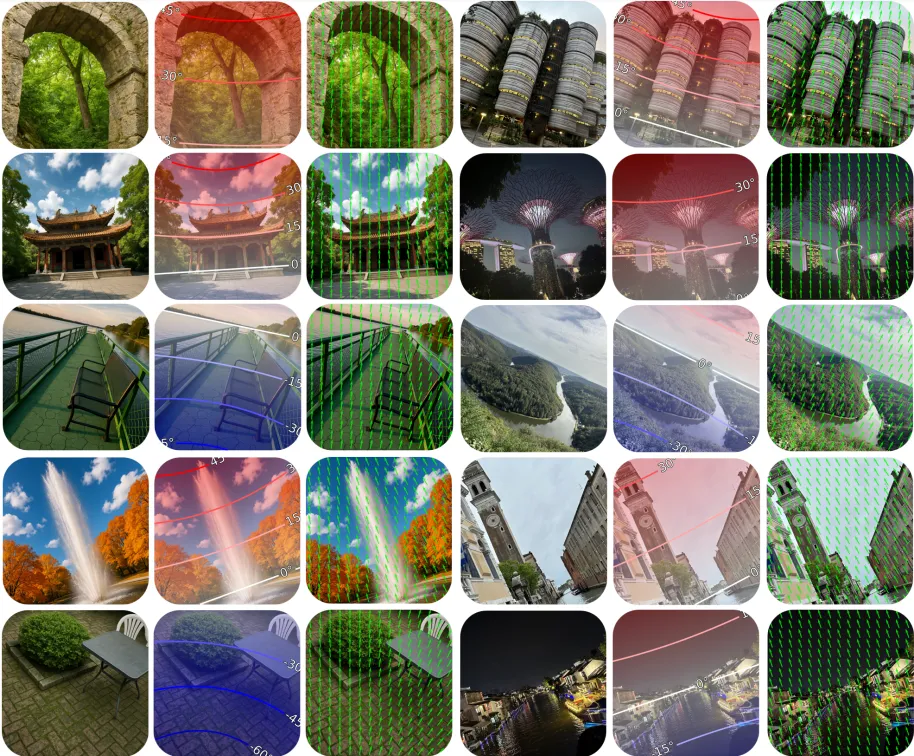

团队的相机理解结果及其相机透视场可视化如下:左侧为AIGC 图像(GTP-4o),右侧为真实世界的摄影图像。其中,相机透视场(latitude和up vector)由预测的相机参数转换得到。可以看出,团队的方法在各类场景中表现出不错的鲁棒性。

△相机理解可视化结果

团队的相机可控生成结果如下。可以看出,团队的方法在各类相机配置和场景描述中均表现出合理的空间生成能力。

△相机可控生成可视化结果

首先,Puffin能够通过精确预测相机参数,在自然场景图像中辅助虚拟三维物体的插入。

此外,通过指令微调(Instruction Tuning),团队的模型可以灵活扩展至多种跨视角任务,如空间想象、世界探索和摄影指导等。

其中在世界探索任务中,团队对初始视角与生成视角进行了三维重建并可视化(利用VGGT),结果显示生成结果在空间结构上保持了良好的一致性。更多拓展应用结果请参考论文的附录部分。

Puffin通过“将相机理解为语言”并引入“与相机共思(thinking with camera)”的理念,消除了视觉-语言-相机模态间的鸿沟。

在未来,团队计划进一步提升Puffin的跨视角能力,并将其扩展至以相机为中心的视频生成与理解,以促进在动态与沉浸式场景中的更广泛应用。

感兴趣的朋友可到原文查看更多细节~

论文链接:https://arxiv.org/abs/2510.08673

项目主页:https://kangliao929.github.io/projects/puffin/

代码链接:https://github.com/KangLiao929/Puffin

百万级图片-文本-相机三元组数据集:https://huggingface.co/datasets/KangLiao/Puffin-4M

文章来自于“量子位”,作者“Puffin团队”。