在智能体强化学习的快速发展中,如何在探索与稳定之间取得平衡已成为多轮智能体训练的关键。主流的熵驱动式智能体强化学习(Agentic RL)虽鼓励模型在高不确定性处分支探索,但过度依赖熵信号常导致训练不稳、甚至策略熵坍塌问题。

为此,中国人民大学高瓴人工智能学院与快手 Klear 语言大模型团队联合提出 Agentic Entropy-Balanced Policy Optimization(AEPO),一种面向多轮智能体的熵平衡强化学习优化算法。

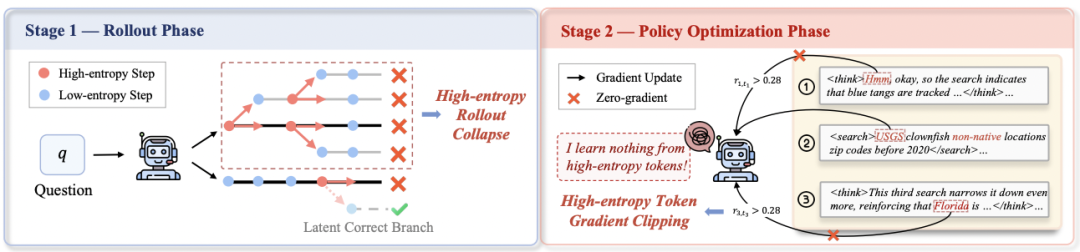

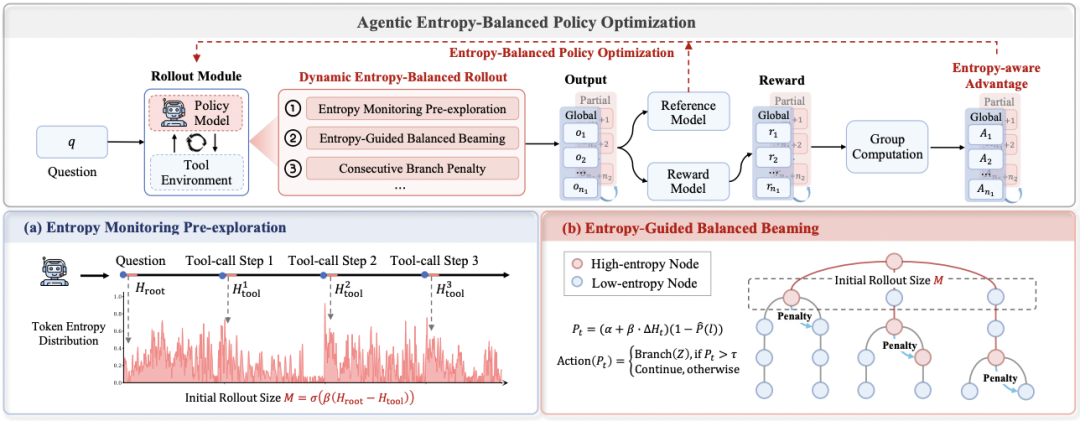

AEPO 系统性揭示了「高熵 Rollout 采样坍缩」和「高熵梯度裁剪」问题,并设计了「动态熵平衡 Rollout 采样」与「熵平衡策略优化」两项核心机制。前者通过熵预监控与连续分支惩罚实现全局与局部探索预算的自适应分配,后者在策略更新阶段引入梯度停止与熵感知优势估计以保留高熵 token 的探索梯度。

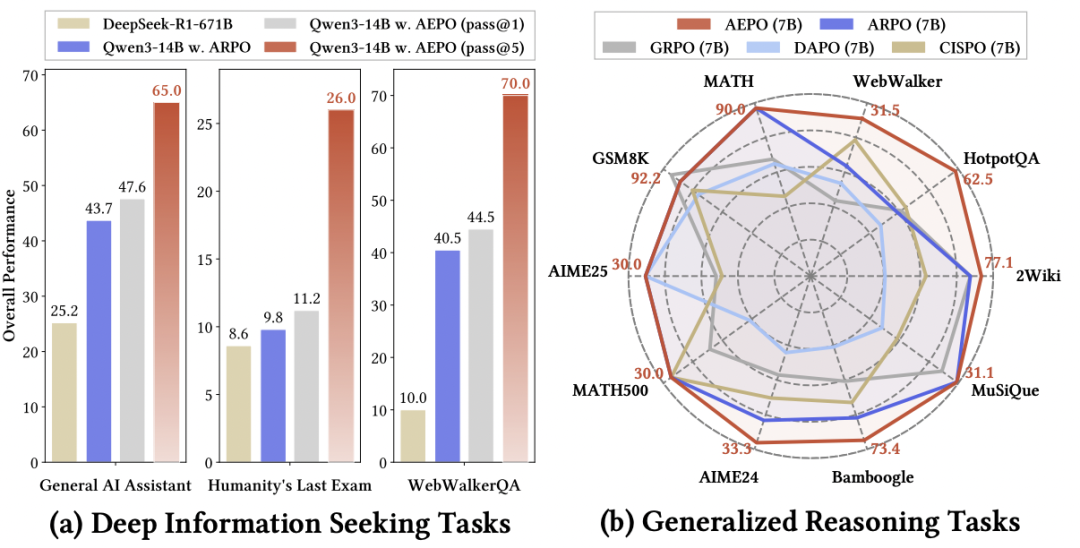

图 1:AEPO 性能概览:左图对比深度搜索任务性能,右图对比通用推理任务性能

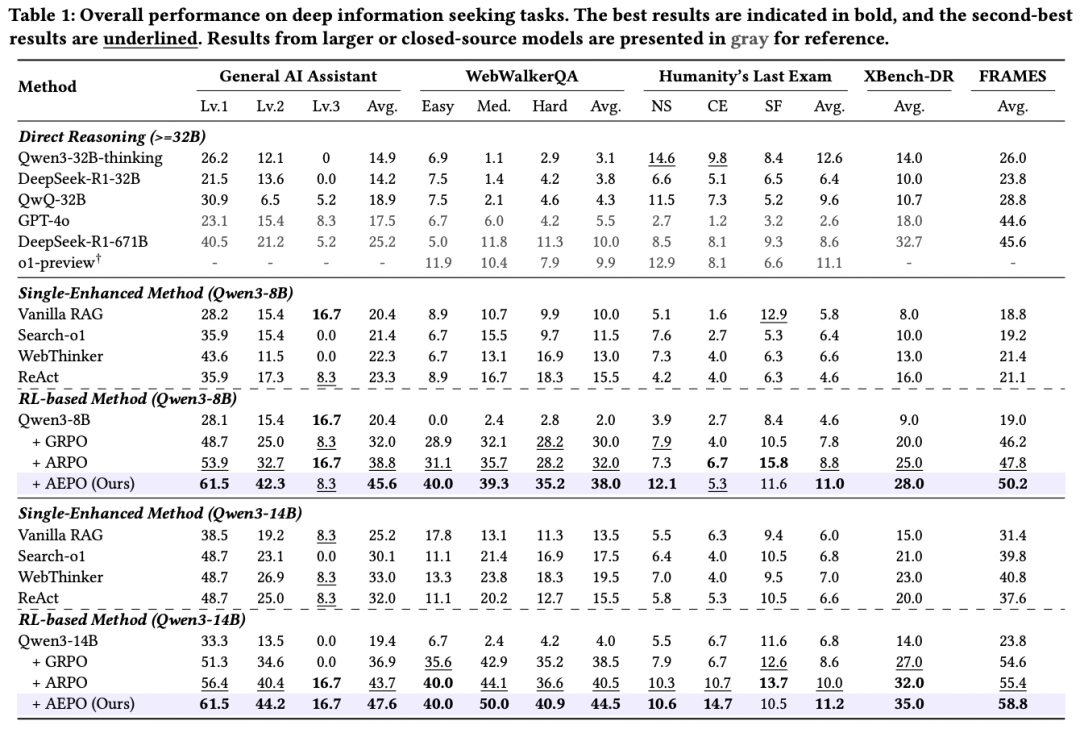

实验结果表明,AEPO 在 14 个跨领域基准上显著优于七种主流强化学习算法。特别是深度搜索任务的 Pass@5 指标:GAIA (65.0%), Humanity’s Last Exam (26.0%), WebWalkerQA (70.0%)。在保持训练稳定性的同时进一步提升了采样多样性与推理效率,为通用智能体的可扩展强化训练提供了新的优化范式。

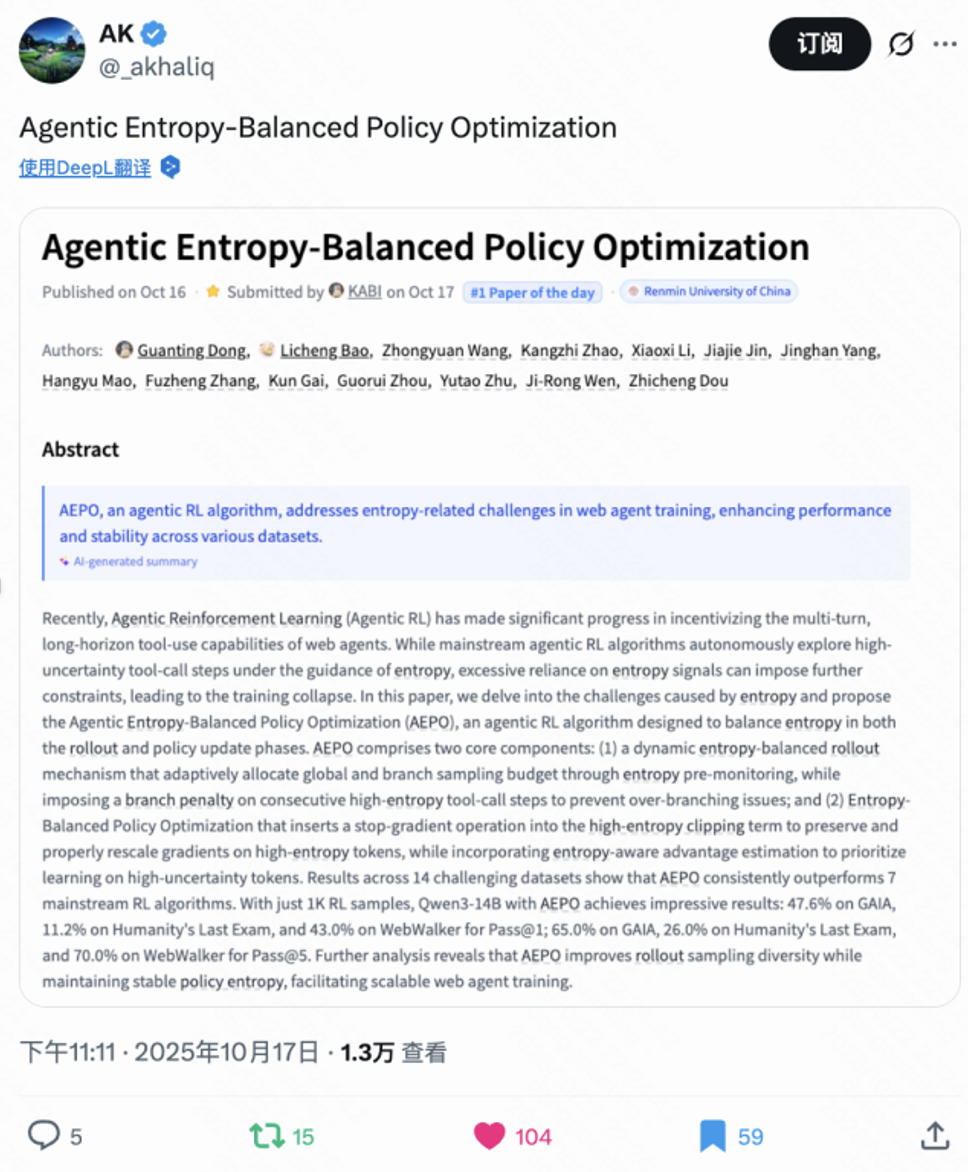

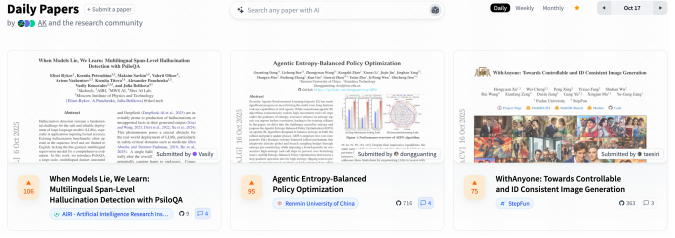

目前 AEPO 在 X 上收获极高关注度,Github 仓库已获星标 700 余枚,同时荣登 Huggingface Paper 日榜第二名!

研究动机:在高熵中寻求平衡

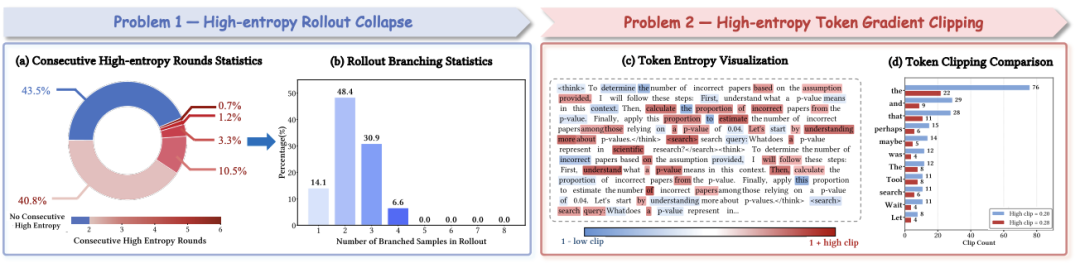

随着 Agentic RL 的发展,如何在持续探索与训练稳定之间取得平衡已成制约智能体性能的关键。现有方法(如 ARPO)通常依赖熵信号作为依据,并在高熵时刻触发分支采样探索潜在推理路径。我们的研究发现熵驱动的探索虽能提升多样性,却也带来了显著的训练不稳定:模型在连续高熵的工具调用阶段容易出现单一链条过度分支,导致探索受限(如下图左侧);同时在策略更新阶段,高熵 token 的梯度常被无差别裁剪,使模型难以学习的探索行为(如下图右侧)。这种熵失衡也使智能体在强化学习中容易陷入局部最优解。

图 2:智能体中的高熵 Rollout 坍缩与高熵梯度裁剪现象

因此,如何在高熵驱动下同时实现高效探索与稳定优化,成为智能体强化学习亟待突破的核心瓶颈。为此,我们提出 AEPO,一种面向多轮智能体的熵平衡强化学习优化算法。我们的贡献如下:

工具调用的熵变现象:高熵集聚与梯度困境

通过分析智能体在多轮工具调用强化学习中的 token 熵变与训练过程,我们发现以下核心现象:

图 3:智能体强化学习训练中两种熵相关问题的量化统计

上述现象本质是高熵信号的双重矛盾:高熵是智能体探索工具使用潜力的必要条件,但无约束的高熵连续性会破坏 rollout 资源分配,激进的梯度裁剪又会扼杀高熵的探索价值。

AEPO 算法:熵驱动的精准探索与梯度保护

图 4:AEPO 概述

动态熵平衡 Rollout 采样:

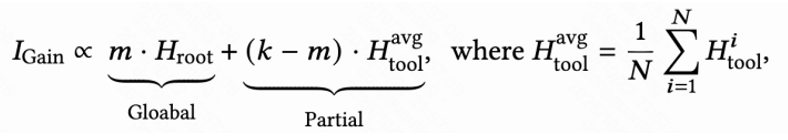

1.熵预监测:按信息增益分配采样预算

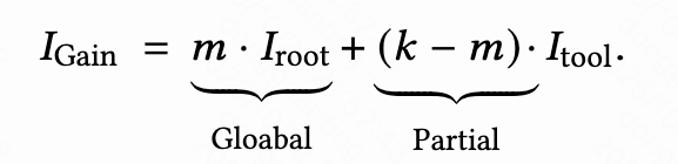

传统 RL 算法(如 ARPO)凭经验分配全局采样与分支采样的坍缩资源,AEPO 则基于信息增益理论,根据问题与工具的信息增益动态调整采样预算,具体来说,在总 rollout 采样的预算为 k(包含 m 次全局采样与 k-m 次高熵分支采样)的条件下,将 Rollout 阶段的信息增益简单地建模为:

在语言模型的自回归解码过程中,输入问题的信息增益通常由模型解码的 token 熵值来衡量,因此我们可以得到如下正相关关系:

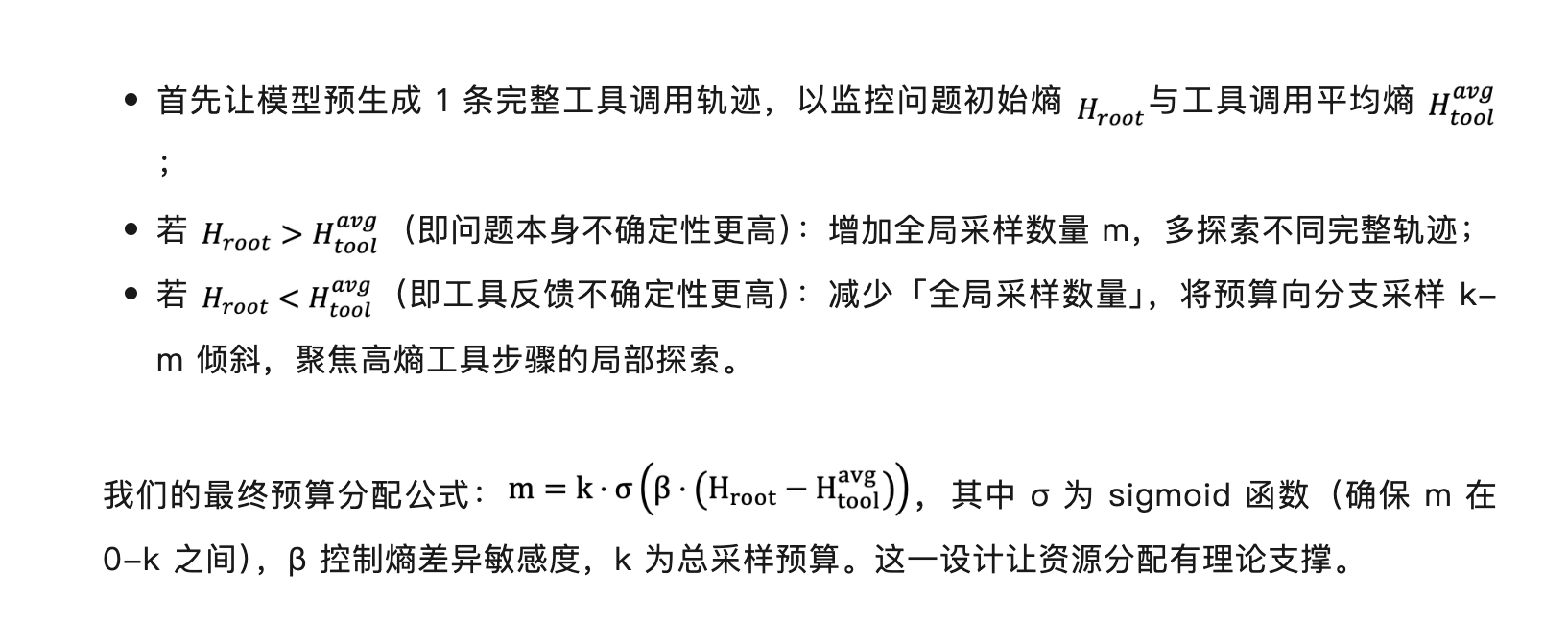

因此,我们的目标是尽可能增大 Rollout 阶段的信息增益,基于上述公式,AEPO 按信息增益分配采样预算:

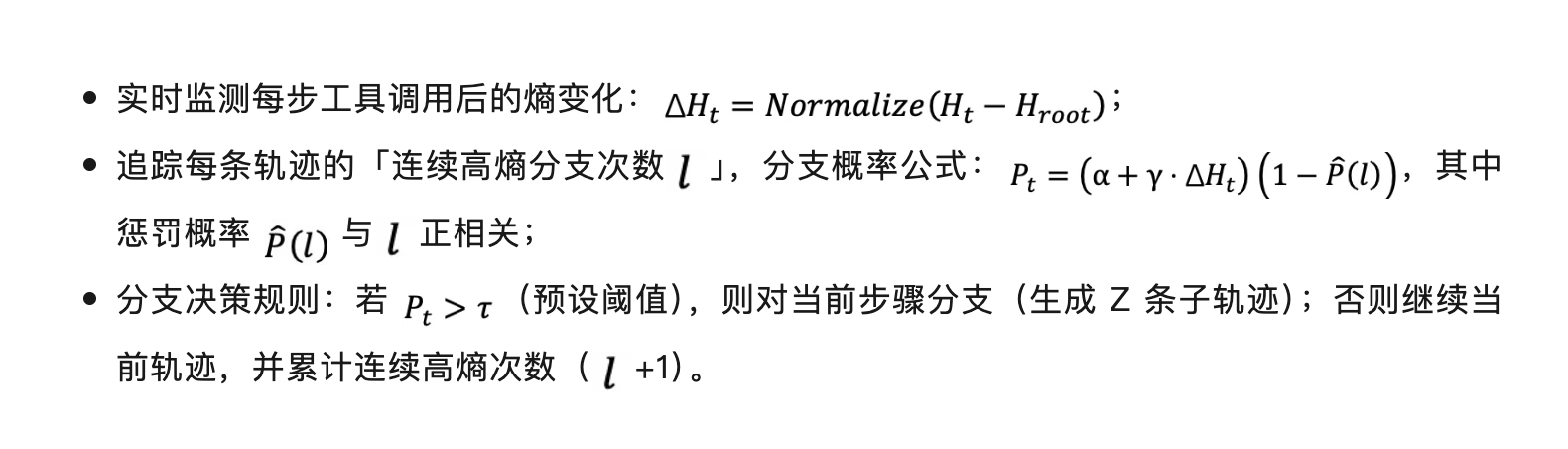

2.连续高熵分支惩罚:避免单一轨迹过度分支

即使预算分配合理,连续高熵调用仍可能导致单一轨迹过度分支。因此 AEPO 通过动态分支概率施加惩罚:

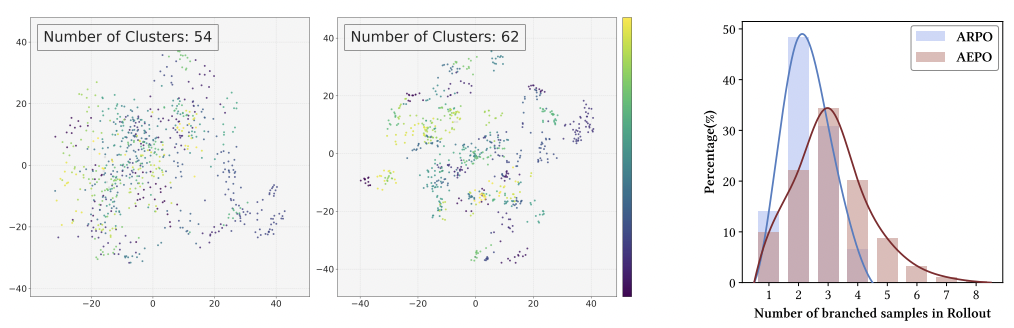

实验验证:如下图所示,相比于 ARPO 通常仅分支 2-3 条轨迹,而 AEPO 可覆盖全部 8 条预算轨迹(右图),采样聚类数从 54 提升至 62(左 2 图),大幅提升 Rollout 采样的多样性。

图 5:采样多样性 ARPO vs AEPO(左)与 Rollout 的分支采样分布(右)

熵平衡策略优化:

1.熵裁剪平衡机制:保留高熵 Token 梯度

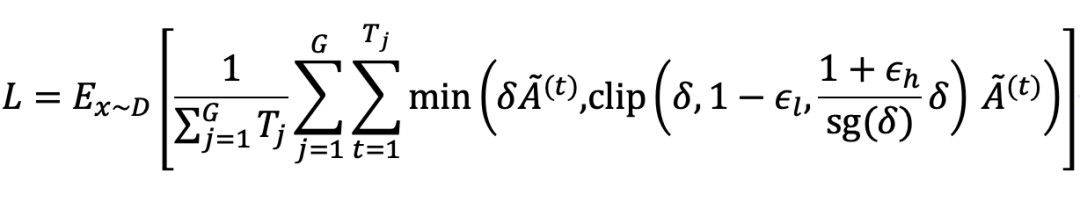

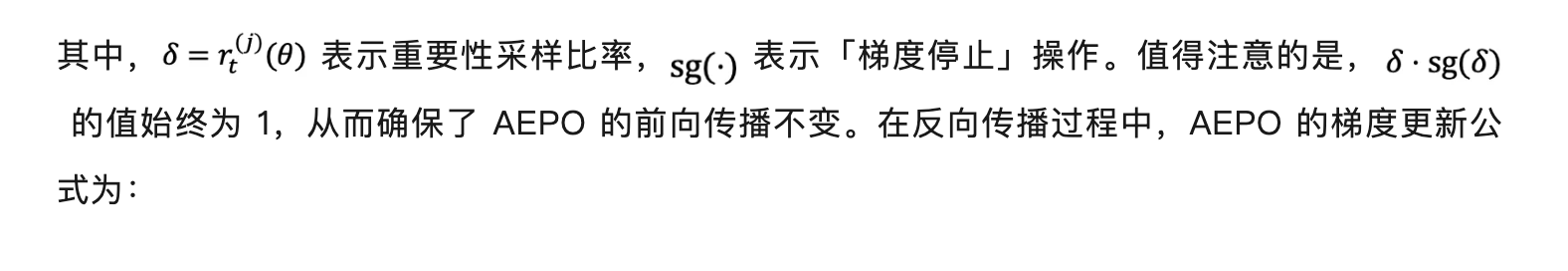

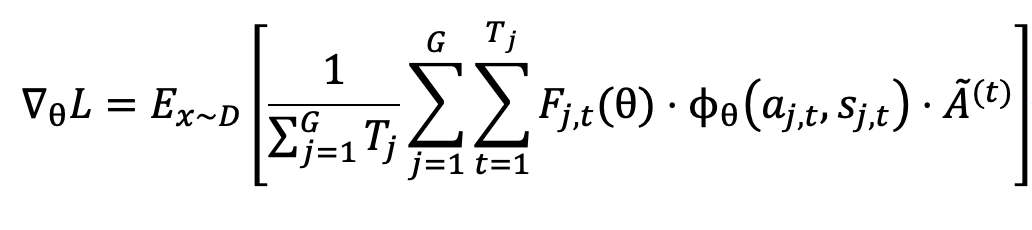

收到 GPPO 启发,AEPO 将「梯度停止」操作融入到策略更新的高熵裁剪项中,保证了前向传播不受影响,同时保护了高熵 token 的梯度在反向传播时不被裁剪。AEPO 在策略更新时使用如下公式:

这一设计让高熵探索性 Token 的梯度得以保留,避免训练初期探索能力流失。

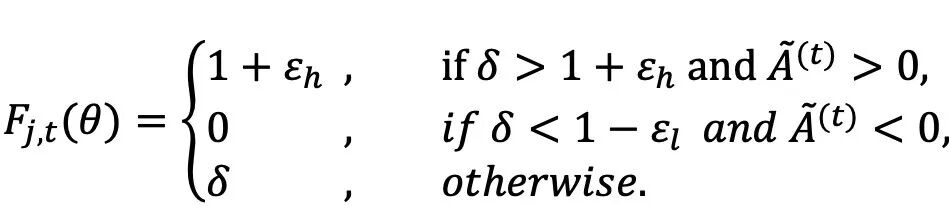

2.熵感知优势估计:优先学习高价值探索行为

实验结果:14 个基准验证 AEPO 的高效与稳定

为了充分评估 AEPO 的泛化性和高效性,我们考虑以下三种测试集:

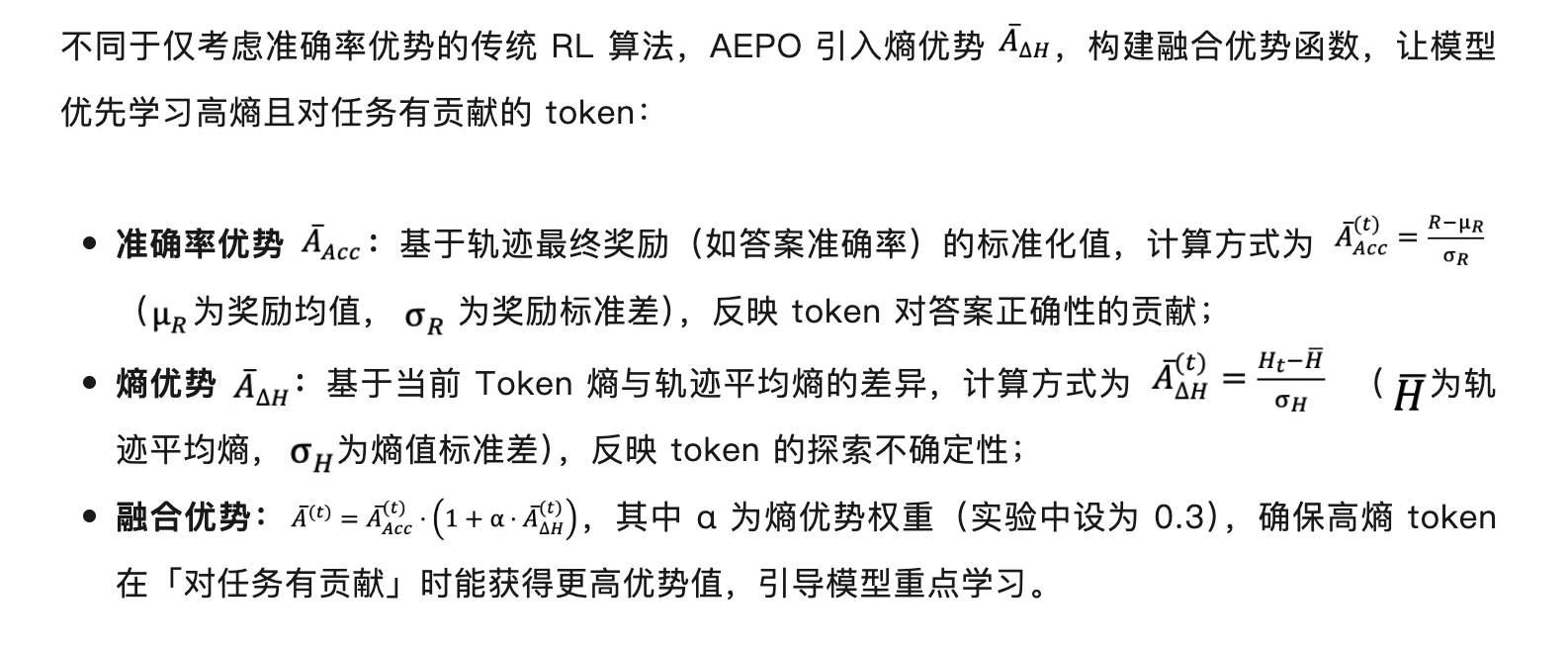

深度信息检索任务:小样本实现大突破

如上表所示,仅用 1K RL 训练样本,Qwen3-14B+AEPO 在关键任务上表现优异:

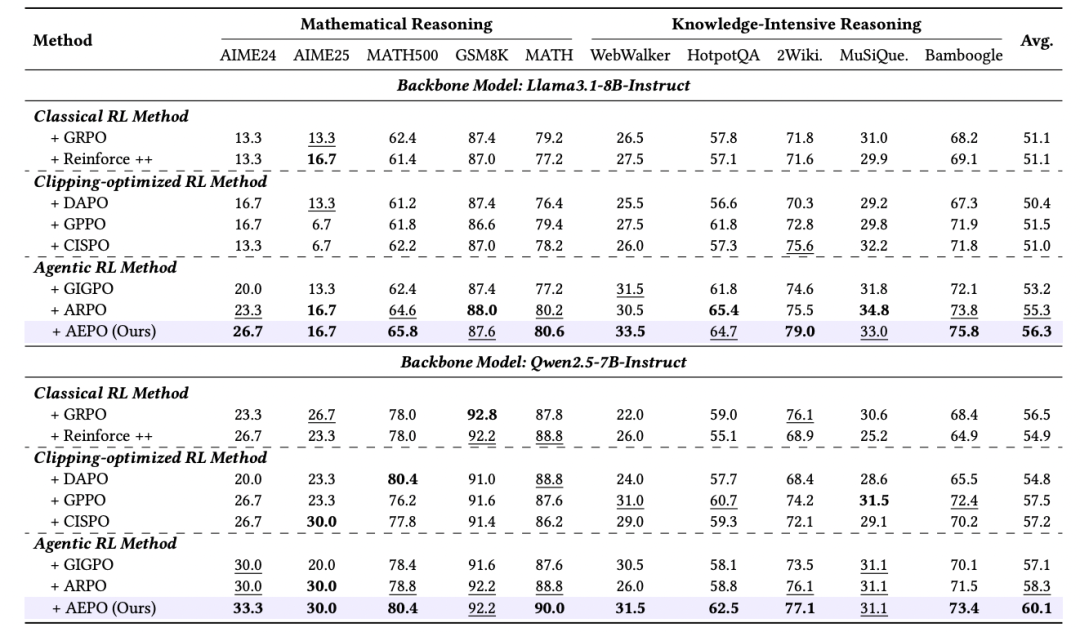

我们比较了 7 种强化学习算法在 10 个推理任务中的表现,发现:

实验:熵稳定与准确率分析

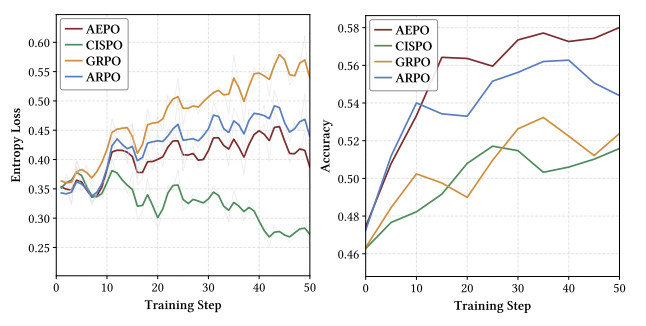

在 Agentic RL 训练中,熵动态稳定性与训练准确率收敛性是衡量算法有效性的核心指标:熵过高易导致探索失控,熵过低则会引发探索不足;而准确率的持续提升则直接反映模型对有效工具使用行为的学习能力。

我们对比 AEPO 与主流 RL 算法(含 ARPO、GRPO、DAPO 等)在 10 个推理任务中的训练动态,清晰揭示了 AEPO 在「熵稳定」与「准确率提升」双维度的优势。实验发现训练的熵损失骤增与下降都不会对性能带来增益;相比之下,AEPO 的熵损失全程维持高且稳定,对应稳定的性能增益。其表现远超其他 RL 算法,且解决了 ARPO 在训练后期熵波动的问题。

图 5:训练指标可视化,包括各训练步骤的熵损失(左)和准确率(右)

总结与未来展望

未来可从三个方向进一步拓展:

作者介绍

董冠霆目前就读于中国人民大学高瓴人工智能学院,博士二年级,导师为窦志成教授和文继荣教授。他的研究方向主要包括智能体强化学习、深度搜索智能体,大模型对齐等。在国际顶级会议如 ICLR、ACL、AAAI 等发表了多篇论文,并在快手快意大模型组、阿里通义千问组等大模型团队进行实习。其代表性工作包括 ARPO、AUTOIF、Tool-Star、RFT、Search-o1、WebThinker、Qwen2 和 Qwen2.5 等。

本文的通信作者为中国人民大学的窦志成教授与快手科技的周国睿。

文章来自于微信公众号 “机器之心”,作者 “机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file