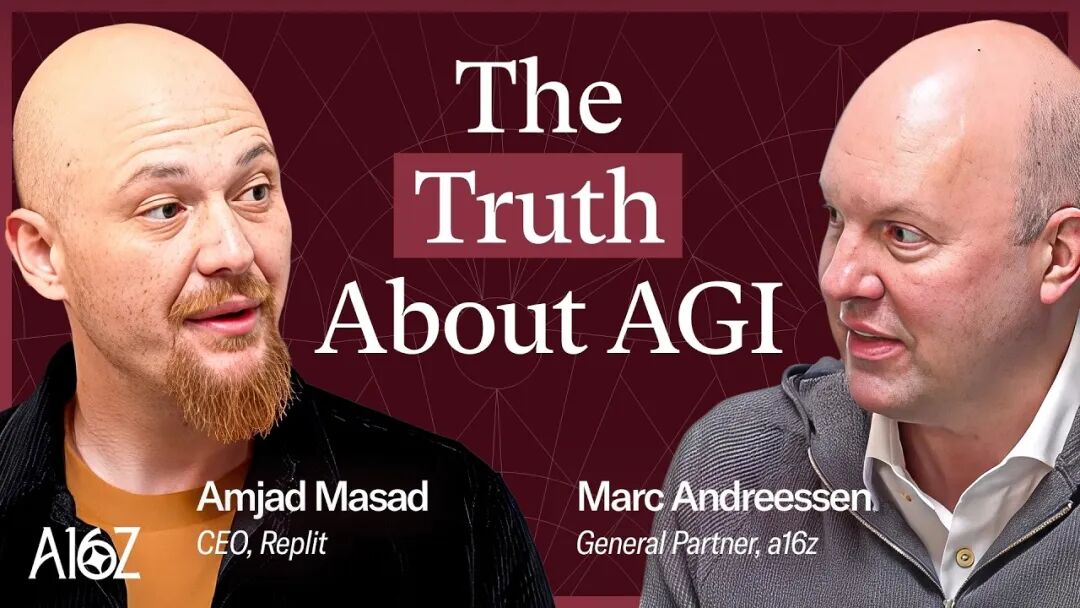

Amjad Masad是AI编程平台Replit的创始人兼CEO,曾担任Codecademy的创始工程师,Facebook的JavaScript基础设施团队技术主管。本次访谈发布于2025年10月,为a16z合伙人Marc Andreessen与Amjad共同探讨AI Agent如何重塑编程。

Marc Andreessen:我们现在正在面对一种几年前我们都觉得不可能存在的魔法。也许五年前、肯定十年前,没人会相信这能做到。这是史上最令人惊叹的科技,它发展得非常快,但我们依然会感到失望——觉得它还不够快,甚至有点像是要停滞了。我们此刻应该既超级兴奋,又近乎绝望。因为,那趟“红利列车”似乎要到站了。

Amjad Masad:它确实更快了,但还没到那种“电脑速度”的程度,对吧?就是我们期望电脑能有的速度。它更像是在看一个人工作——就像在看John Carmack打了兴奋剂一样。

Marc Andreessen:世界上最强的程序员,在兴奋剂的作用下。

Amjad Masad:对,就是那样。

Marc Andreessen:那我们就从假设开始——假设我只是一个新手程序员,也许我是个学生,或者只是上过几节编程课,稍微折腾过一些小项目。又或者,我只是在Excel里写过几个macro。但总之,我不是那种“编程工匠级”的人。这时候有人告诉我关于Replit的事——尤其是带AI的Replit。那么当我现在打开Replit时,会是什么体验?

Amjad Masad:不论是完全没编程经验还是有一点点经验的用户,体验其实是差不多的。我们做的第一件事,就是把所有开发环境配置这些“杂事”都去掉,让你直接专注在想法本身上。所以你要想清楚:你想做什么?要做一个产品?解决一个问题?做个数据可视化?Prompt框是完全开放的。你可以输入任何内容,比如说,你有个创业的想法。我会先写一段描述,大概一段话,说明我想做什么,Agent会读这段话。

Marc Andreessen:你只要直接打出来就行,用普通英语写。你只需要写类似:“I want to sell crepes.” “I want to sell crepes online.”

Amjad Masad:你就直接这么打,哪怕只有四五个单词也行。如果你对某种编程语言或Stack有偏好,也可以指定。但我们其实更希望你不要,因为系统会自动为你选最合适的技术栈。比如如果是 Data App,我们会选Python、Streamlit之类的;如果是Web App,我们会选JavaScript、Postgres等。所以你只要打出想法就好。

Marc Andreessen: 你也可以自己指定。比如说,“我在学校学Python,我想用Python做。”

Amjad Masad:完全没问题。Replit最酷的一点是,我们已经存在将近10年了。我们从一开始就构建了可以运行任何编程语言的基础架构。所以如果你习惯用Python,直接用就行。

Marc Andreessen:所以整个过程都可以用英文操作?

Amjad Masad:对,全程用英文。回想一下背景:十年前(或者七年前)我来向你展示的时候,我们其实就在描述今天这个未来——每个人都能写软件。但阻碍他们的,是Fred Brooks所说的“偶然复杂度”。真正的“本质复杂度”是:如何让创业项目落地、如何把生意做起来。而“偶然复杂度”则是:我该用哪个软件包管理器?如何配置环境?我们这些年一直在抽象化这些复杂性。最后剩下要抽象掉的,就是代码本身。我去年有个顿悟:我们虽然已经构建了一个很棒的平台,但业务表现不够好。原因就在于——代码是瓶颈。没错,其他问题也重要,但语法仍然是障碍。语法对人类来说是反直觉的。所以最终英语才是编程语言。

Marc Andreessen:那它现在支持英语以外的语言吗?

Amjad Masad:支持。比如日语,很多日本用户在用,非常受欢迎。

Marc Andreessen:AI支持所有语言吗?还是要为每种语言定制?

Amjad Masad:主流语言基本都支持。凡是有上亿人使用的语言,AI表现都不错。我最近出于某种原因做了点历史研究,只是想理解我们现在所处的特殊时刻。我读到Grace Hopper的一句话。我们都知道她发明了编译器。在她的时代,人们还在写机器码——那是程序员的日常。她说:“专家永远是专家,他们必须理解计算机的底层结构。但我想看到一个世界,人们能用英语编程。”那是75年前的事——比Karpathy早太多了。她发明编译器的初衷,就是这个。在她看来,C语言已经是“英语编程”了。但那只是起点。后来我们又有了更高层的语言:Python、JavaScript。而我们现在正处在下一个阶段:从输入语法,进化到输入思维。这正是我们最终想要的。

Marc Andreessen:机器来写代码。

Amjad Masad:对,机器写代码。没错。

Marc Andreessen:你可能没经历过,但我小时候,那时已经有高级语言了,比如BASIC、FORTRAN、C。但依然有人在写汇编语言。而且现在一些游戏公司还在写汇编,追求极致性能。

Amjad Masad:那时写汇编的人还会瞧不起写BASIC的人。

Marc Andreessen:而更早的老程序员又会瞧不起写汇编的人,说他们不写机器码、不写零和一。汇编语言其实是一种低级语言,会被编译成机器码。对大多数程序员来说,那几乎是乱码。你要写八进制、直接对硬件操作。但即便如此,它仍然是一种“语言”,最终会被编译成0和1。而“真正的程序员”,在他们看来,就是直接写0和1。这种“鄙视链”一直存在。老手总是看不起新人,说他们不懂机器、不懂底层。但事实是,每一代更高层的抽象,都在让编程大众化。

Amjad Masad:最讽刺的是,我自己就是JavaScript革命的一部分。我在加入Facebook并创立Replit之前,我们构建了现代JavaScript Stack,包括React,js和相关工具。当时我们也被一堆程序员骂,说应该直接写原生JavaScript。但结果呢?现在这些人靠我们那一代的创新吃饭,又开始嫌弃这波新的变革。人类啊,真是永远不变。

Marc Andreessen:好,继续。你打完“I want to sell crepes online”之类的Prompt后,会发生什么?

Amjad Masad:Replit的Agent会解析你的输入,建立一个与你的共同理解。目前UI这块还有很多可以改进的地方,但现在它会先展示一份任务列表。比如说:“我要创建数据库(因为你要存数据)、我要设置Shopify或Stripe(因为要收款)”。然后它会问你两个选项:你想先从设计开始、反复迭代?还是直接构建完整产品?如果你选后者,Agent就会自动跑20~40分钟:创建数据库、做迁移、写SQL、搭建前端、测试。

我们最近在Agent3上做的一项创新是:当它写完软件之后,会自动启动一个浏览器,在浏览器中进行测试。发现任何问题后,它会自行迭代、修复代码。整个过程大约花20到30分钟。完成后我会给你发通知,告诉你应用已经准备好了。你可以在手机上测试,也可以回到电脑上查看。也许你会发现一个bug或一些问题,然后把它描述给Agent,说:“嘿,这个和我预期的不太一样。”如果一切都完美,那就好了,整个流程只用了大约二十分钟。

顺便说一句,现在已经有很多例子显示,人们只需要二三十分钟就能把自己的想法变成现实,真的很惊人。然后你只需点击“发布”,再点几下,应用就会上线到云端——我们会在云端为你配置虚拟机、部署数据库,一切都自动完成,你现在就拥有了一个正式运行的生产数据库。想想就在两三年前,要达到这个步骤需要多少工作:你得先搭建本地开发环境、注册AWS账户、配置数据库和虚拟机、创建整套部署流水线——而现在,这些全都为你自动完成。如今,一个孩子,或者完全没有技术背景的人,也能做到这些。如果你是程序员,还想看看Agent干了什么,Replit的酷之处在于:它本质上还是个IDE。你可以打开文件树、查看源码、用Git、推到GitHub、连自己的编辑器、甚至用Emacs。所以Replit一方面是个能抽象掉复杂性的AI编程平台,另一方面又让所有底层结构都透明、可探索。

Marc Andreessen:好的。那我们回到刚才你提到的那个点——你说,当用户输入想法后,Agent会返回一份任务清单。你刚才描述的,“我要做这个、我要做那个”,其实执行者并不是用户本人,对吧?Agent会列出它要执行的任务,然后它真的去执行这些任务。

Amjad Masad:没错,Agent真正执行这些操作。这是一个非常关键的点。当我们在Replit内部做出这种转变时,我们其实一开始没有意识到一个巨大变化:“用户”这个身份从人类转移到了Agent本身。换句话说,现在真正写代码的“程序员”,已经不再是人类,而是AI。有件很好玩的事:我们之前在亚洲设有服务器,目的是为了让印度、日本等地区用户访问更快。可当我们上线Agent后,他们的体验反而变糟了。我们很困惑:这不是应该更快吗?结果发现原因是——这些AI都在美国的服务器上运行。所以真正的“程序员”其实在美国。也就是说,用户的请求被发给在美国运行的AI程序员,而它又要远程调用世界另一端的计算资源。所以没错,现在的程序员其实是Agent。

Marc Andreessen:换句话说,在新的术语体系中,Agent是一个软件程序,它像人类用户一样使用系统,但它不是人,而是一个bot。

Amjad Masad:对。它能访问多种工具,比如写文件、编辑文件、删除文件、搜索包、安装依赖包、配置数据库、配置对象存储等等。它具备完整的编程工具链与接口。它的接口设计与人类程序员非常相似。

Marc Andreessen:我们稍后还会聊到这点,但在整个AI行业内部,关于“Agent是否能代替人完成任务并自主执行使命”这一话题,一直存在争论。拥有一个能完成简单任务的AI Agent本身已经是重大突破,而让它能完成复杂任务,则是过去八十年来最艰难的技术挑战之一。问题是:Agent能否自主运行5分钟、15分钟、1小时、甚至8小时?也就是:它能维持多长时间的连贯性?它到底能在完全掌控自身“认知能力”的状态下维持多久,而不至于失控或跑偏?在早期的Agent或早期AI中,你可能让它跑个几分钟,它就开始混乱、偏题、陷入“rabbit hole”,逻辑崩坏。但最近我们看到,它们已经能持续运行更久,完成更复杂的任务。那么现在Agent的持续时间和任务复杂度,大概发展到什么水平了?

Amjad Masad:是的,这正是我们自2023年以来关注的核心指标。我在四五年前就有“软件Agent”这个想法。可每次尝试都遇到同一个问题:连贯性。它们能正常运行一两分钟,但随后错误会不断累积,最后崩溃。

Marc Andreessen:你实际上能“看到”这种状态——AI会变得越来越困惑,甚至“精神错乱”。

Amjad Masad:它们会进入一些莫名其妙的状态,有时甚至突然开始说中文,行为非常怪异。不过,我想大约在去年的时候,我们突破了三到五分钟的连贯时长。这让我们意识到:长时推理(long-horizon reasoning)这件事,似乎正在被攻克。于是我们下了赌注。

Marc Andreessen:等一下,“长时推理”是指长时间、多步骤的逻辑推理,对吗?

Amjad Masad:没错。比如LLM的工作原理,是依赖context。这个context实际上就是它的记忆空间:包括所有的文本、所有的Prompt,还有它在思考时的内部对话。当AI在推理时,它其实在“自言自语”。比如:“我现在要建一个数据库。那我有什么工具?哦,这里有个Postgres工具,我试试看。执行一下,收到反馈,读反馈,理解反馈。”这些输入——用户输入、环境输入、机器内部思考——全都存在同一个context里,类似一个程序的内存空间。

过去,如何在这个context中保持连贯,是最大挑战。AI常常会“跑偏”。而现在它们能在整个推理过程中保持一致的思考方向。我们还引入了“context压缩”技术,因为context长度仍然是限制。如今LLM号称能处理百万Token,但实际上大约到20万Token时就开始吃力。所以我们会定期SOP(summary-of-prompt)和压缩记忆。比如数据库日志那种内容,我们可以把几段日志总结成一句:“数据库已初始化。”这样每隔一段时间压缩一次context,以维持连贯性。也就是说,除了基础模型的改进之外,在系统层面我们也做了大量创新,以支撑长上下文的稳定推理。

Marc Andreessen:那你认为,在基础模型层面,实现这一切的关键技术突破是什么?

Amjad Masad:是强化学习。在传统训练中,LLM的第一阶段是预训练——读入一段文本,遮住最后一个词,然后预测它。这种方式虽然让模型学会语言,但并不具备长程推理能力。我们一直无法突破瓶颈,是因为这种训练范式不支持真正的“基于长context的问题求解”。而“基于代码执行的强化学习”带来的关键突破,是让模型能够在实际环境中展开trajectory(轨迹)。所谓trajectory,就是为达到一个目标而进行的多步推理链。

在强化学习训练中,我们把LLM放进一个类似Replit的编程环境,对它说:“这是一个代码库,这里有个bug,请修复它。”人类训练师已经知道正确解,比如我们在GitHub上有对应的拉取请求,或有可验证的单元测试。模型会生成大量trajectory,只有少数能真正修好bug,其他的都会跑偏。而成功的那个trajectory会得到奖励,模型因此学会:“原来这就是解决问题的方式。”就是这样,我们成功地延长了模型的推理链。

Marc Andreessen:那这其实是一个两部分的问题:第一,模型目前在长链推理方面的表现到底有多好?第二,我们又是如何知道的?也就是说,这个标准是怎么确立的?

Amjad Masad:有一个名为Meter的非营利组织,他们设计了一种基准测试,用来衡量一个模型在保持连贯性并执行有用任务(无论是编程还是其他标准任务)时,能够持续运行多长时间。他们在去年年底发表了一篇论文,指出模型在保持连贯运行的时长大约每七个月就会翻倍——从两分钟到四分钟,仅需七个月。他们严重低估了增长速度。现在的翻倍速度远远快于七个月。

我们在Agent3项目中对此进行了非常密切的监测,我们用真实用户的真实任务来衡量,而不是做基准测试。我们实际上在做A/B测试,并观察用户是否能成功完成任务。对我们来说,最直接的成功标志是:你做出了一个应用并发布了它。因为发布意味着你愿意为此支付额外费用,也就是说,这个应用在经济上是有用的,这是最明确的衡量方式。因此我们观察到,在Agent1阶段,Agent可以运行两分钟,然后开始吃力;二月份推出的Agent2能运行二十分钟;而Agent3能运行两百分钟。一些用户甚至能让它持续运行十二个小时之久。我对那种极端时长的表现没有那么自信,但在两到三个小时的时间范围内,它的表现极其出色。

除了模型本身,主要的创新来自“验证环路”。我记得读过一篇来自NVIDIA的研究论文。NVIDIA当时尝试用DeepSeek来编写GPU内核,那大概是七个月前DeepSeek发布时的研究。他们发现,如果在循环中加入一个验证器,即可以运行内核并验证其是否工作,那么就可以让DeepSeek持续运行约二十分钟,并生成真正优化过的内核。于是我意识到,接下来我们显然也需要这样做。虽然我们不是在做基础模型层面的研究,而更像是一个Agent实验室或应用开发公司,但我们在此基础上进行大量创新研究。我们知道现在的Agent可以运行十到二十分钟,或者说LLMs能够在更长时间内保持连贯,但如果你想把它推进到两百、三百分钟,就必须让验证器加入循环。因此我们花了大量时间构建所谓的“脚手架”,让Agent能够启动浏览器,进行类似人类使用电脑的测试。一旦你把验证环节加进去,系统的运作方式就变成:它工作二十分钟,然后启动另一个Agent,打开浏览器,测试前一个Agent的工作。这就变成了一个多代理系统。如果发现了bug,它就会开启一个新的推理trajectory,并总结道:“好样的,让我们回顾一下你在过去二十分钟所做的事。”接着把上一步的总结和发现的bug一起输入,生成新的推理起点。这样一层层叠加下去,系统就能无止境地延展。

Marc Andreessen:就像是一场接力马拉松,只要每一棒都跑得正确,就可以无限地继续下去。

Amjad Masad:没错。而且你可以把前一步的内容压缩成一个段落,用作下一个Agent的Prompt,于是代理之间相互提示。太棒了。

Marc Andreessen:当一个现代代理——基于最新LLMs并经过这种方式训练的代理——运行约200分钟时,如果你观察它的运行过程,它的逻辑处理和任务推进速度,是和人类一样、比人类慢,还是更快?

Amjad Masad:其实,我会说,它更快一些,但并没有快得离谱。它不是那种“计算机速度”,不是我们印象中机器的那种超高速。

Marc Andreessen:看起来更像是在看一个人工作——如果它会描述自己的过程,那就像在看一个人埋头写代码。

Amjad Masad:就像在看John Carmack打了兴奋剂后工作一样。

Marc Andreessen:世界上最顶尖的程序员在兴奋状态下,为你工作。

Amjad Masad:对,它速度非常快,你能看到文件差异在快速滚动。但每隔一段时间,它会停下来思考。它会展示自己的推理过程,比如:“我做了这个,也做了那个。我现在走在正确的方向上吗?”它会进行反思。然后它可能审查自己的工作,决定下一步,或者调用测试Agent继续执行。所以你可以看到它完成所有这些动作,每隔一段时间它会调用一个工具,比如,它会停下来表示:“我们遇到问题了,Postgres15不兼容我现在使用的这个数据库ORM包。”然后说:“好吧,这个问题我以前没见过,我去搜一下资料。”于是它会调用网页搜索工具去查找,看起来就像一个真正的人类程序员。这真的很有趣。我最喜欢的事情之一就是观察这些工具链、推理链和测试链的运作。这确实就像在看一个超高效率的程序员在工作。

Marc Andreessen:我们现在其实已经接近AI的“圣杯”——机器实现广义推理。

你刚才几次提到了“验证(verification)”这个概念。那我来为播客里可能不太了解技术细节的听众总结一下,看我理解对不对。最早的语言模型,比如两年前你第一次用ChatGPT时,你会觉得它在语言上极其流畅,能写莎士比亚风格的十四行诗,也能写说唱歌词,甚至能像人类一样对话,这非常惊人。

但当你开始让它解决一些需要理性思考或问题求解的任务——比如数学题——它就彻底崩溃。在最初的阶段,你让它解一些很基础的数学题,它都做不对。即使后来它能处理简单加法,但遇到更大的数字就不行。就算能加大数,它也不会乘法。还有一个著名的例子叫“草莓测试”:问“strawberry”这个单词里有几个字母R?没错。在很长一段时间里,它老是答错。它会说有两个R,而实际上有三个。当时人们甚至用了一个带点讽刺性的词来形容这种东西——叫做“随机鹦鹉(stochastic parrot)”。

Amjad Masad:我当时在想“clanker”这个词。

Marc Andreessen:“clanker”是新的侮辱词,完全就是针对AI的种族歧视用语。大概是因为AI已经被当作一个“物种”了吧。不过,当时的技术性批评是所谓的“随机鹦鹉”问题。“stochastic”意思是随机的,所以“stochastic parrot”就是“随机鹦鹉”——意思是,这些大型语言模型就像一种幻象,它们只是随机地复述那些它们“认为”你想听的话,但其实并没有真正理解。

Amjad Masad:而且某种程度上,这种说法在纯预训练的LLM阶段,确实是对的。

Marc Andreessen:没错,在最基础层面上确实如此。但正如你所说,在过去一年中,强化学习开始被叠加上去。

Amjad Masad:这并不是新技术,本质上就是AlphaGo。AlphaGo的突破是在2015或2016年,它结合了当时AI领域两派的思路——连接主义认为神经网络是实现智能的关键,而符号主义认为逻辑规则和知识库才是关键。AlphaGo把两者结合了起来。它使用神经网络生成一系列潜在走法,然后通过蒙特卡洛树搜索算法进行筛选,找出最优走法。这其实就是在验证环中加入一个“验证器”的过程——通过经典算法验证哪个选择更优。这一理念现在正在复兴:我们已经拥有强大的生成式神经网络,现在要在其上叠加离散的验证机制,让系统在训练环中学习“如何验证自己是否在做正确的事”。一旦加入这种机制,LLM就会获得新的能力,比如在数学和代码上的推理。

Marc Andreessen:完全正确。关键在于,为了让LLM能够真正推理,问题本身必须具备一个可验证的、明确的答案。比如在医学中,这可能是一个医生小组一致认可的诊断结果,或者确实能治愈疾病的诊断;在法律中,则可能是一项能说服陪审团并导致无罪判决的论证;在数学中,就是一个能正确求解的方程;在物理中,是一个能在现实中成立的结果;在土木工程中,则是一座不会坍塌的桥。换句话说,总有一种“验证测试”存在。

Amjad Masad:不过前两类——法律和医疗——目前还不太适用,因为它们太模糊,太“软”,不像数学或代码那样明确。比如在数学训练中,他们使用一种可形式化验证的语言Lean来做证明。你可以运行Lean语句、运行代码、甚至物理仿真,但你无法运行一个诊断。

Marc Andreessen:不过你可以用人类的答案进行验证。

Amjad Masad:对,那是一种“半监督”方式,不是完全自动化的强化学习训练,因此可扩展性有限。这也是为什么vibe coding的进展比任何其他领域都快——因为我们可以即时生成问题并验证答案。

Marc Andreessen:但正如任何程序员都知道的,代码验证包含两个步骤:一是“能否编译”,二是“结果是否正确”。对。而且代码能编译并不代表逻辑正确。验证输出是否正确要难得多。

Amjad Masad:SWE-Bench就是一组经过验证的Pull Request最终状态,它不仅仅测试编译。科学家团队从GitHub上挑选出最复杂的仓库,找到清晰的bug报告,并匹配对应的修复Pull Request(含单元测试)。于是就形成了一个可供AI解题的现有语料库。去年模型在这些任务上的准确率大约只有5%,而现在Claude Sonnet4.5模型已经达到约82%,这是当前的最先进水平。这个进步非常陡峭。基本上,他们去GitHub上进行了查找,找到了那些最复杂的代码库,找到了描述非常清晰的漏洞说明。他们还找到了真正修复这些漏洞说明的Pull Requests,其中包含完整的单元测试等内容。因此,在GitHub上已经存在一个可供AI解决任务的现成语料库——而且这些任务也可以被进一步生成。不过这种方法并非无限可扩展,因为仍然需要人类验证者来审查任务。但也许基础模型公司会找到让合成训练数据完全自动化的方法。

Marc Andreessen:确实,如今一些公司甚至雇佣人类专家——数学家、物理学家、程序员——来人工生成高质量的训练数据。他们就像是“打了鸡血”的程序员,写出带有已知正确结果的代码,从而让强化学习循环能够正确训练。此外,这些公司还在构建系统,让软件本身自动生成训练数据、测试样本与验证结果,也就是所谓的“合成数据训练”。

Amjad Masad:不过,正如你说的,这种方法在那些“硬领域”非常有效,但在“软领域”仍然有限。不过我们确实能看到某种迁移学习的迹象,比如在“深度研究(deep research)”类工具上体现出推理能力,但进展速度远不如代码。

Marc Andreessen:所谓“软领域”,指的是那些很难、甚至不可能以一种确定的、基于事实且无争议的方式来验证结果正确性的领域。

Amjad Masad:比如在慢性疾病的情境下——你可能患有POTS(体位性心动过速综合征)或者EDS(埃勒斯-当洛综合征)之类的疾病——这些疾病往往是一种症状群或模糊的集合。这是因为这些领域属于抽象范畴,不像代码或数学那样具体可验证。所以在这类领域,我们仍然还有很长的路要走。

Marc Andreessen:换句话说,问题越“具体”,进展越快;关键变量是“具体性”,而非“难度”。

Amjad Masad:没错。具体性指的是你能否得到一个可验证的真或假答案。

Marc Andreessen:在任何能验证结果正确与否的领域,我们都能预期看到极快的进步。而这当然包括数学、物理、化学,以及大部分软件工程。那还包括什么?

Amjad Masad:生物学,比如蛋白质结构、基因组学等。还有机器人学的一些方向——那里也有明确的结果。不过其实这种“硬领域”数量没那么多。

Marc Andreessen:取决于你怎么看,有人会说已经够多了。你刚才提到改进速度,那接下来几年我们应该期待怎样的增长?

Amjad Masad:代码领域会呈爆炸式增长。我们现在在做的Agent4,就是希望到明年你坐在Replit前,不只是操控一个Agent,而是同时发射多个Agent。比如你计划一个新功能:“我要在我的店铺上增加一个社交网络”,或者“重构数据库”,你就可以让5到10个Agent并行在后台协作、合并代码,AI会帮你完成所有管理。同时你还有一个漂亮的可视化界面,通过图形和图表与AI创意互动。这就是多模态交互的方向。软件创作将成为一个极其令人兴奋的领域。普通人将能达到当今Google高级工程师的开发水平。这很快就会实现。不过我也很好奇你的看法——在医疗、写作或创意这些领域,我还没看到像代码那样的快速提升。所以编程领域的发展正要“起飞”。数学领域可能也属于这一类。一些科学领域,比如生物学之类的,也会发展得非常快。

Marc Andreessen:是的,这里其实存在一种很奇怪的动态——看看你是否认同这一点,Erik,我也很好奇你的看法。这种奇怪的动态我们在办公室里经常遇到,我在和前沿创业者交流时也常常感受到。那种感觉就是:哇,这是有史以来最惊人的技术,它的进步速度极快,但我们同时又感到非常失望。就好像——它还不够快,似乎正处在即将停滞的边缘。我们一方面应该对它无比兴奋,但另一方面又几乎要崩溃,因为“好日子”似乎就要到头了。

我常常在想,一方面,比如说,不是所有的项目都能登月。就算某个东西看起来能行,也不代表它就能真正扩展到大规模应用、在最大程度上发挥效能。所以我们必须认识到现实的局限性,而不是一味地把趋势外推到无限远。但另一方面,我们现在所面对的技术几乎像是魔法——是那种五年前、甚至十年前我们都以为不可能实现的东西。说真的,我在八十年代末九十年代初拿到计算机科学学位时,根本没想过自己有生之年能看到这一切。现在这些真的发生在我有生之年,实在令人震撼。

Amjad Masad:不过,如今有一个巨大的赌注押在“通用人工智能(AGI)”上。不管是基础模型还是其他方向,现在几乎整个美国经济都在押注AGI。而关键问题是:我们真的在通往AGI的路上吗?因为从某些迹象来看,我们似乎并没有。比如说,不同领域之间似乎没有明显的迁移学习能力。换句话说,当我们在代码生成上有显著提升时,我们并没有自动在“通用推理”上变得更好。我们仍然需要针对生物、化学、物理、数学、法律等不同领域重新收集训练数据,搭建专属环境。

这正是最近AI社区讨论的焦点之一——在Dwarkesh对Richard Sutton的采访之后。Sutton在那次谈话中对所谓的“痛苦的教训”泼了一盆冷水。这个“痛苦的教训”来自他早年的论文,核心观点是:AI研究存在一种可以无限扩展的方式——只要投入更多算力和数据,就能持续获得性能提升,这才是通向AGI的最终路径。但有些人从那次采访中解读出,也许Sutton自己都开始怀疑,我们现在是否还在那条“痛苦的教训”之路上。也许当前的训练范式反而完全相反——我们过于依赖人类数据、人类标注以及各种人为输入。对此,我是同意的。作为一家公司,我们当然对未来充满期待,但同时也不得不提出疑问:我们真的走在通往AGI的轨道上吗?你怎么看?

Marc Andreessen:再比如Ilya Sutskever提出的一个具体论点:我们其实正在耗尽训练数据。他把这称为“化石燃料式论点”。也就是说,我们已经“吸干”了互联网上几乎所有的数据——那几乎就是目前全部的数据来源。也许还有一些数据存在于某些“私有暗池”中,我们还能去获取一点,但本质上,我们已经用尽了大部分可用数据。于是我们现在进入了“生成新数据”的阶段——但生成数据比从互联网上“吸取”要困难得多、昂贵得多。当然,讨论到这里,就很容易陷入定义的泥潭,比如你刚才提到的迁移学习。迁移学习指的是机器能够在一个领域成为专家,然后把这种能力推广到另一个领域。我的回答是:你见过人类迁移学习吗?你认识多少人真正能做到迁移学习?其实不多吧?

Amjad Masad:往往是这样——一个人越擅长某个领域,在其他领域就越容易出现盲区。

Erik Torenberg:我们经常开玩笑说,每个人都有“短板区”,在某个方向上非常聪明,但在另一个方向上可能会犯离谱的错误。

Marc Andreessen:这在人类的“公共知识分子”中尤其常见。比如那些上电视的专家,他们可能是经济学专家,但他们会上电视谈政治——而其实对政治一无所知;或者他们谈医学、谈法律、谈计算机,全都外行。保罗·克鲁格曼曾说过“互联网不会比传真机更重要”,这就是个典型例子。他是一位出色的经济学家,但完全不了解计算机的运作。当然,“他真的是一位出色的经济学家吗?”这是另一个问题。即便他是,也说明不了他能正确预测互联网的影响。

Amjad Masad:所以,从某种意义上说,你刚才提出的观点其实很有意思——也许我们现在的 AI,已经达到了“人类水平”。我想,也许AGI的定义本身就是完全不同的——也许它指的是超越人类水平、能真正跨领域泛化的智能。而那种东西,我们至今还没有见到。

Marc Andreessen:是的,就像我刚才说的,我们已经把AGI理想化了。我们当然应该志向远大,但我们设定的这个目标,可能已经理想化到一种程度——它远远超出了人类的能力范畴,以至于用人类来做比较都已不再有意义。传统上,AGI的定义是“在所有方面都能超越人类的智能系统”。但如果你想一想——假设人类几乎无法做到迁移学习,那么即使AI只做到了一点点、哪怕只是略有改善,也可能已经比人类强;或者反过来说,这点提升根本不重要,因为没有人类能做到。所以,你只能不断地“堆叠”不同领域的能力。

AI领域中还有一个广为人知的现象,科学家和工程师们经常抱怨——那就是“AI的定义总是下一个机器还做不到的东西”。比如,过去很长一段时间,人们认为“能在国际象棋上打败人类”才算是真正的人工智能。可是一旦机器真的能打败人类了,这件事立刻就不再被认为是AI,而只是“无聊的电脑象棋”。后来“电脑象棋”甚至变成了一个单独的学科领域,它成了一门学问,但再也没人觉得那是“智能”了。现在它只是你iPhone上的一个应用,没人再关心它。

接着,人们又把“图灵测试”作为判断AI的标准。可是我们通过图灵测试那天,却没人庆祝——没有派对,没有报道。这太讽刺了——图灵测试作为标准存在了八十年,人们还为它拍了电影,可是真正通过的时候,却没人注意到,没人认为那值得称赞。大家只是说:“这玩意儿还是没什么用。”因此,AI科学家常常抱怨,他们的研究成果总是被忽略——人们只看机器还做不到的事,而不承认它们已经做到的那些。但反过来,这也说明科学家们往往为自己设定了不合理的目标,并在过程中不断自我鞭策、自我否定。我也常在想——这种心理到底是好事还是坏事?

Amjad Masad:是啊,这确实是个很有意思的问题。我开始思考,也许AGI的定义本身并不那么重要。我对AGI的定义是:一个AI系统能够被放入任何环境中,快速而高效地学习——不需要太多先验知识,同时还能将学到的知识迁移到不同领域。不过,我们也可以先追求“功能型AGI”。所谓功能型AGI,就是收集全世界各类有经济价值的活动数据,然后在这些数据之上训练一个大型语言模型,或者在已有的基础模型上进行微调。这样我们就可以逐步覆盖各个经济领域,从而自动化掉相当一部分劳动力。我们确实正沿着这条路前进。

Erik Torenberg:对了,你在GPT-5发布之后发过推特,说你感受到“收益递减”。你当时的预期是什么?我们是否需要新的突破,才能恢复之前的增长速度?

Amjad Masad:这正是我们现在讨论的问题。我的感觉是,GPT-5在可验证领域(比如编程、逻辑推理等)确实进步很大,但在其他方面——尤其是“人性化”层面——反而退步了。因此你看到Reddit上出现了那种“举着干草叉反抗”的情绪,很多人对Sam和OpenAI感到不满,因为他们觉得“失去了一个朋友”。GPT-4感觉更有人味、更亲近;而GPT-5则显得更机械、更理性,像是“活在自己脑子里”的模型,试图事事都深度推理。所以我原本期待的是——像从GPT-2到GPT-3那样的跨越,当时的提升是显而易见的,它变得更像人、更能理解世界。从3到4也是这样,但从4到5,就不像是“更好的存在”了。

Marc Andreessen:那是不是意味着,它在人性或情感上退化了?

Amjad Masad:部分是情感方面,但也不仅如此。我喜欢让模型回答一些非常有争议的问题,你几乎不会看到差异。它们都无法真正进行开放性的推理、共同探索“真相”。这个问题至今没有明确答案,而模型似乎也没在这方面变得更好。你经常用这些模型,你有这种感觉吗?

Marc Andreessen:我用得方式不太一样,也许我的预期不同。我主要把它当作“随时待命的博士”,用于解释问题,而不是聊天。对我来说,这方面的提升倒是非常显著。尤其是当我使用GPT-5 Pro加上深度推理或Grok 4 Heavy这类最高端模型时,它们几乎可以按需生成30~40页的完整书面报告,针对任何主题。每当我好奇一个问题,比如:“当一个发达经济体对原材料或制成品征收关税时,究竟是谁在承担成本?消费者?进口商?出口商?还是生产者?”这是一个极其复杂的问题,经济学家研究了几十年。在这种问题上,模型的表现令人惊艳。

Amjad Masad:它能从网上获取信息,进行整合、分析

Marc Andreessen:并生成一份30~40页的综合报告(通常上限是40页PDF)。我交叉验证过,内容极其连贯、逻辑严密,几乎达到了世界级学术水平。如果我雇一个斯坦福的经济学博士后来研究这个问题,结果可能也不过如此。

Amjad Masad:当然,这属于知识综合,而不是创造全新的知识。

Marc Andreessen:但这就引出了一个哲学问题:那又怎样?人类在回答问题时,又有多少真正的“新知识”呢?我们期待AI给出的答案,其实就是一种最清晰、最复杂、最完整的解释。从这个意义上说,AI写出的那份40页报告——流畅、连贯、逻辑完备——就像一本书。如果你让人类作者写出那样的作品,你会说:“这是一位优秀的作家。”而作者写书的过程,也未必是“创造新知识”,更多是在整合前人的成果。但写书本身仍是一种创造行为。

Amjad Masad:正因如此,我特别希望AI能帮助我们解决一个当下的重大问题——信息生态的混乱。现在所有东西都像是宣传,真相似乎无处可寻。我真的希望有一种AI,能帮我从“第一性原理”出发去推理,帮助我理解这个世界上正在发生的真实事情。也许这对AI研究者来说是个不切实际的要求,但我们在这方面几乎没有取得任何进展。

Marc Andreessen:也许是我过于执着——也许因为我的工作性质,我太专注于“与人辩论”,而不是“追求底层真理”。我在使用这些模型时常做的一件事是,让它们去持有一个具有挑衅性的观点,然后强化这个立场。比如拿“COVID起源”这个话题来说——我会让模型去强化论证支持“实验室泄漏”的论点,再强化论证一次“自然起源”的论点我常常这样成对使用这个方法。每次的结果都非常惊人——每一方都能写出大约三十页、结构完备、论据充分、逻辑紧密的论证文本,让人觉得“这可能是我见过的最有说服力的论点”。

Amjad Masad:但之所以过去没人这样做,是因为讨论“人造起源”这件事曾经是禁忌话题。当时如果你谈论这个话题,模型会用一种“你是阴谋论者”的口吻来“教育”你。有一段时间,AI确实无法对这种高度争议性话题进行推理——因为LHF(Learning from Human Feedback)等机制以及各种安全限制会直接干预它的思考。

Marc Andreessen:你也知道,现在依然有一些大型模型会在你提出敏感问题时“训诫”你,说你不该问这种问题。不过与此同时,也有一些模型已经变得非常开放,可以真正进行这类复杂、对抗性的推理了。从更大的层面上看,我们现在还没有一个真正好的方式去定义AGI。传统定义几乎都基于“与人类相比”的框架,这让我想到自动驾驶汽车的争论:“自动驾驶算成功吗?”——是因为它成为了完美驾驶员,还是因为它比人类驾驶更好?在我看来,后者才是真正有意义的突破,就像AI在国际象棋或围棋上的超越一样。当然,自动驾驶公司追求的是“完美驾驶员”,但我们最终要寻找的,是那辆知道自己该去哪儿的车。

Amjad Masad:我自己对此有两种心态:一方面是务实的创业者心态——即使今天停止AI的进一步发展,我们在App层和基础设施层上仍然能做很多创新。Replit这样的系统在未来五年内仍会持续进步,而基础模型也会不断增强。从产业角度看,这是一个令人兴奋的时代。另一方面,我又是一个对学术问题极感兴趣的人。从小时候起,我就着迷于意识与智能的本质,也读过很多AI理论文献。我会特别指向强化学习领域,比如Richard Sutton和DeepMind联合创始人Shane Legg曾发表过论文,尝试定义什么是AGI。他们给出的定义或许是最正确的——即:高效的持续学习。换句话说,如果你想构建一种真正的人工智能——它可以被放入任何领域,比如放进一辆汽车里,几乎不需要预先知识,然后在几个月内就能像人类一样熟练地学会驾驶。

Marc Andreessen:这种智能具备泛化技能获取、泛化理解能力和泛化推理能力。

Amjad Masad:真正实现这一点,才会彻底改变世界,也让我们对人类思维与意识有更深刻的理解,并推动人类文明进入新的阶段。从文明发展的层面看,这是个极其深刻的问题。与经济或产业进步不同,它涉及学术意义上的根本探索。如果我们现在坐在CalSheet上打个赌——我个人对“真正AGI的突破”其实是略偏悲观的。因为我们现有的系统已经极具经济价值与实用性。

Marc Andreessen:在某种意义上,“够好”反而成了创新的敌人。这就像陷入了一个局部最优陷阱。当前模型在经济上已经能创造大量价值,从而削弱了继续追求“通用解”的动力。

Amjad Masad:当然,仍有像Rich Sutton这样的人在坚持走那条更艰难的道路,也许他们最终会成功。但当前巨大的优化能量都集中在现有范式上,让整个行业在“爬局部山”。

Marc Andreessen:讽刺的是,全世界都担心那些巨额投资,担心AI带来的各种风险。但最讽刺的情况可能是——所有这些“天文数字的资金”,最终只是让我们在这个“局部最优点”上越挖越深。而不是投入到真正解决“通用智能问题”的方向。

Amjad Masad:当然,也可能这是合理的——也许“通用问题”的答案本就不在我们有生之年。

Erik Torenberg:那么,LLM是否已经榨干了最后一点潜力?还是说现在还有一些你特别感兴趣、值得期待的研究方向?

Amjad Masad:还没完全。虽然强化学习领域的突破已经被人熟知十多年,比如结合生成式系统与tree search的架构,但那条路仍然很长。我看到的趋势是,一些强化学习的原始思想家仍在尝试“从零自举智能”。像John Carmack那样的人,也在沿着这条路探索——他们没有走LLM路线。虽然目前看不到太多成果,但谁知道呢?也许此刻,推特上已经有一个bot悄悄存在,正在赢得所有争论;或者Reddit上有个账户,正默默生成着令人惊叹的软件。

Marc Andreessen:我们剩下的时间聊聊你吧。你是怎么一路走到今天,怎么从出生一路到进入硅谷的?

Amjad Masad:我出生在约旦的安曼,父亲是政府部门的工程师。虽然家里不富裕,但他当时就意识到计算机的重要性,咬牙买了一台电脑——那是我们社区里第一台电脑。我六岁时看着他拆封机器,打开厚厚的手册,慢慢地输入命令:CD、LS、MKDIR……那是我对计算机的最初记忆:一台能精确执行人类意图的机器。

Marc Andreessen:来两片泰诺胶囊。

Amjad Masad:没错,自闭模式启动。那是一台IBM PC,大约是1993年的型号。那时还没有Windows,后来才买了安装盘,通过软盘加载系统。不过那时Windows上能做的事情不多,所以我大部分时间都在DOS下写批处理脚本、运行游戏、折腾系统。直到Windows 95和Visual Basic出现,我才开始写真正的软件。我当时是个重度玩家,经常去局域网游戏厅打Counter-Strike。那里到处都是电脑,但他们在经营上完全没有使用任何软件来管理业务。那时他们完全靠人工管理时间和收费,于是我萌生了写个软件自动化管理的想法。我当时大概12岁,花了两年时间写完,还真的卖了出去,赚了不少钱。记得麦当劳刚在约旦开业时,我请了整个班去吃麦当劳——那次我成了“有钱小孩”。那是我人生的第一个创业项目。

后来我开始接触AI,读了很多科幻作品。等到上大学时,我居然没选计算机科学,因为“coding马上要被自动化了”。那时已经有早期的code generation wizards,可以根据项目描述自动生成代码,我心想:“这事几乎已经被解决了,那我为什么还要去学编程?”于是我去读计算机工程,想着至少有人得造电脑。不过后来我又重新爱上了编程。读了很多关于Lisp的编程随笔,也玩过Scheme之类的语言。但那时学习新语言很痛苦——我没有笔记本,每次想学Python或Java都得去机房下几个G的安装包,还经常因为缺DLL运行失败。这太原始了。

2008年那会儿,我们已经有Google Docs、Gmail——软件都能在网页上运行了。我想:Web才是终极软件平台,一切都该跑在浏览器里。可没人做在线开发环境,于是我决定自己做。我花了几个小时做了个最简单的原型:一个文本框加一个“eval”按钮。输入JavaScript,点按钮,就能弹出alert框显示结果。我给朋友看,他们都开始用,我又加了“保存程序”等功能,大家都很喜欢。之后我又花了两三年的时间才真正做出点东西,因为浏览器只能运行JavaScript,而要突破这一点当时需要一次技术上的飞跃。

当时Mozilla有一个名为Emscripten的研究项目,它可以把像C、C++这样的编程语言编译成JavaScript。为了让浏览器能够运行像Python这样的语言,我需要把C,Python编译成JavaScript。而我也是全世界第一个做到这件事的人。于是我参与并贡献了那个项目,为它搭建了大量的底层支撑结构。后来我和朋友们一起把Python编译成了JavaScript,我心想:“我们已经让Python能跑了,那接下来就让其他语言也能跑吧。”这也就是Replit这个想法诞生的契机——当你需要一个Repl,你就应该能直接得到一个。你就该“Repl”。Repl是最原始、最基础的编程环境形式。于是我把各种编程语言都加进去了。那段时间我的朋友们一直在使用它,也非常兴奋。我当时活跃在GitHub上,我的一贯做法是:只要我写了一个应用或软件,我就会把它开源。所以我几乎把所有东西都开源了——花了好几年时间,专注在构建让代码能在浏览器中直接运行的底层基础设施。

然后这个项目就火了,在Hacker News上疯传,正好赶上了MOOC的时代。那时Udacity、Coursera、还有非常有名的Codecademy都陆续上线。Codecademy是第一个让人可以在浏览器里编写代码、交互式学习编程的网站。他们的很多系统其实都是建立在我开源的软件之上,而那时候我还在约旦。我记得我在Hacker News上看到他们项目火得不行,心想:“这我认识啊,这是我写的东西。”于是我在评论区留言说:“哦,你们在用我的开源包?”后来他们就联系我,说:“嘿,我们想聘请你。”我说我没兴趣,我想创业,想创立一个叫Replit的东西。他们说:“不不不,你应该来和我们一起工作,我们也能做类似的事情。”我还是拒绝了,最后我说:“那我可以和你们签合同吧。”他们付我每小时12美元,我当时还挺兴奋的。值得一提的是,他们真的亲自从约旦飞过来招我,待了几天。我一直在拒绝他们,最后他们给了一个我无法拒绝的条件,于是我去了。签证办好后,我就去了美国。

Marc Andreessen:你是哪年出生的?

Amjad Masad:1987。

Marc Andreessen:那你第一次觉得自己可能不会一辈子待在约旦、可能会搬去美国,是哪一年?

Amjad Masad:当我看了《硅谷海盗》的时候。大概是98年或99年吧,我也不太记得这电影是哪年出的。我还有一个对当今AI时代非常重要的教训:传统的、循规蹈矩的道路正在带来越来越少的回报。如今成长起来的孩子们应该充分利用一切可用的工具,去探索并开辟属于自己的道路。因为一味听从传统建议、重复前人走过的老路,已经没有过去那样奏效了。

Marc Andreessen:没错。谢谢你来参加这次播客。真棒。

原视频:Marc Andreessen & Amjad Masad on “Good Enough” AI, AGI, and the End of Coding

链接:https://www.youtube.com/watch?v=g-WeCOUYBrk

编译:Sylvia Zhang

文章来自于“Z Potentials”,作者 “a16z”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0