为了同时解决知识的实时性和推理的复杂性这两大挑战,搜索智能体(Search Agent)应运而生。它与 RAG 的核心区别在于,Search Agent 能够通过与实时搜索引擎进行多轮交互来分解并执行复杂任务。这种能力在人物画像构建,偏好搜索等任务中至关重要,因为它能模拟人类专家进行深度、实时的资料挖掘。

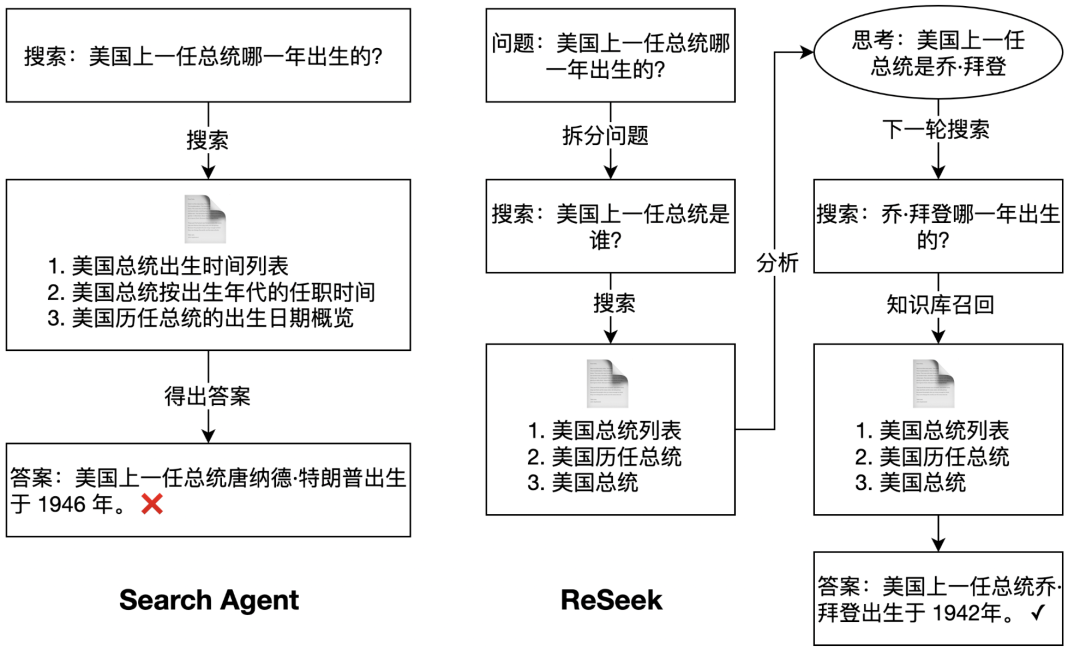

但 Search Agent 经常面临着一个棘手的瓶颈:缺乏过程中的自我纠错能力。现有的智能体一旦在推理早期因一个模糊的查询而走上错误的路径,就会基于这个错误结果继续执行,引发连锁式错误(Cascading Errors),最终导致整个任务失败。

为了攻克这一难题,腾讯内容算法中心联合清华大学,近期提出 ReSeek 框架,它不是对 RAG 的简单改进,而是对 Search Agent 核心逻辑的一次重塑。

ReSeek 的关键在于引入了动态自我修正机制,允许智能体在执行过程中主动评估每一步行动的有效性。一旦发现路径无效或信息错误,它就能及时回溯并探索新的可能性,从而避免「一条路走到黑」。

连锁式错误指的是,智能体在多步推理链的早期,哪怕只犯了一个微小的错误,也会像推倒第一块多米诺骨牌一样,导致后续所有步骤都建立在错误的基础之上,最终使整个任务走向完全失败。

这个过程可以分解为以下几个阶段:

为什么当前的搜索智能体会如此脆弱?根源在于它们在设计上更偏向一个「忠实的执行者」,而非一个「批判性的思考者」。

因此,当前搜索智能体的脆弱性在于其推理链的刚性。它擅长沿着一条既定路线走到底,却不具备在发现路走不通时,掉头或另寻他路的能力。要让智能体真正变得鲁棒和可靠,未来的关键突破方向在于:赋予智能体自我反思和动态纠错的能力,让它从一个只会「一条路走到黑」的执行者,进化成一个懂得「三思而后行、及时止损」的思考者。

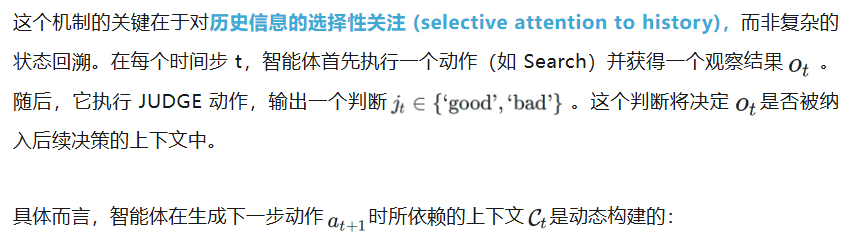

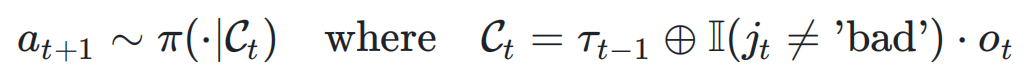

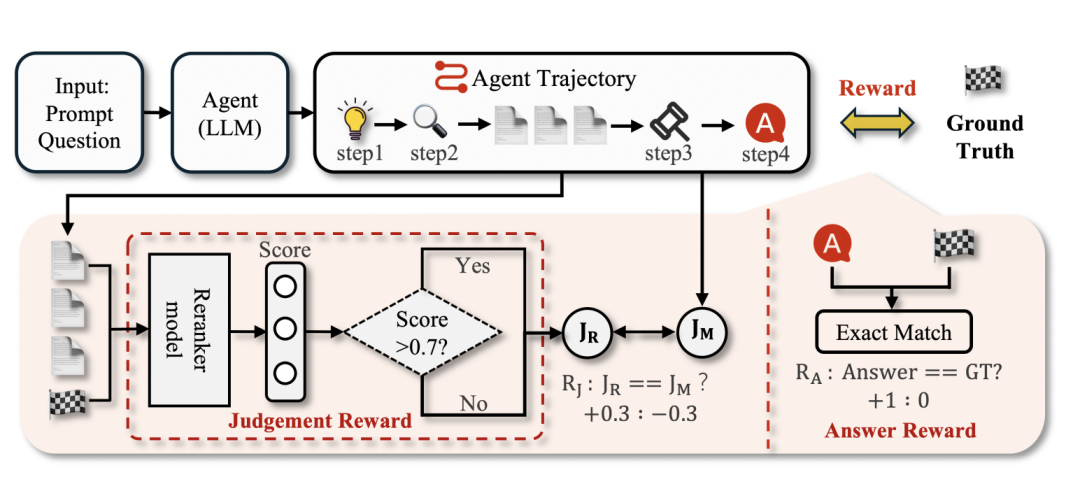

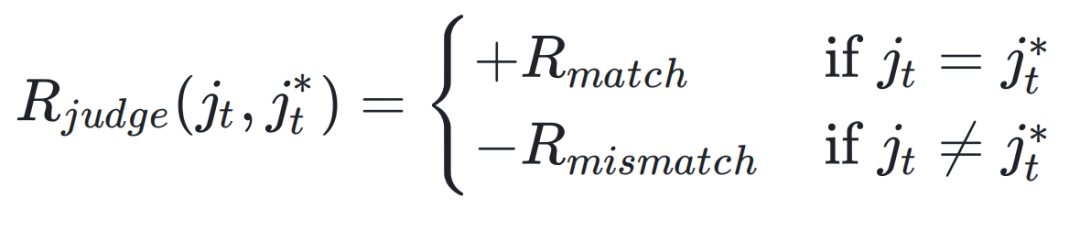

为了赋予智能体自我反思和动态纠错的能力,团队扩展了 Agent 动作空间,引入了一个核心的 JUDGE 动作。该动作在每次信息获取后被调用,用于评估新信息的有效性。

这种奖励塑造(Reward Shaping)策略为智能体提供了密集的、步进式的反馈,引导其逐步学会如何准确评估信息价值,从而使 JUDGE 动作真正有效。

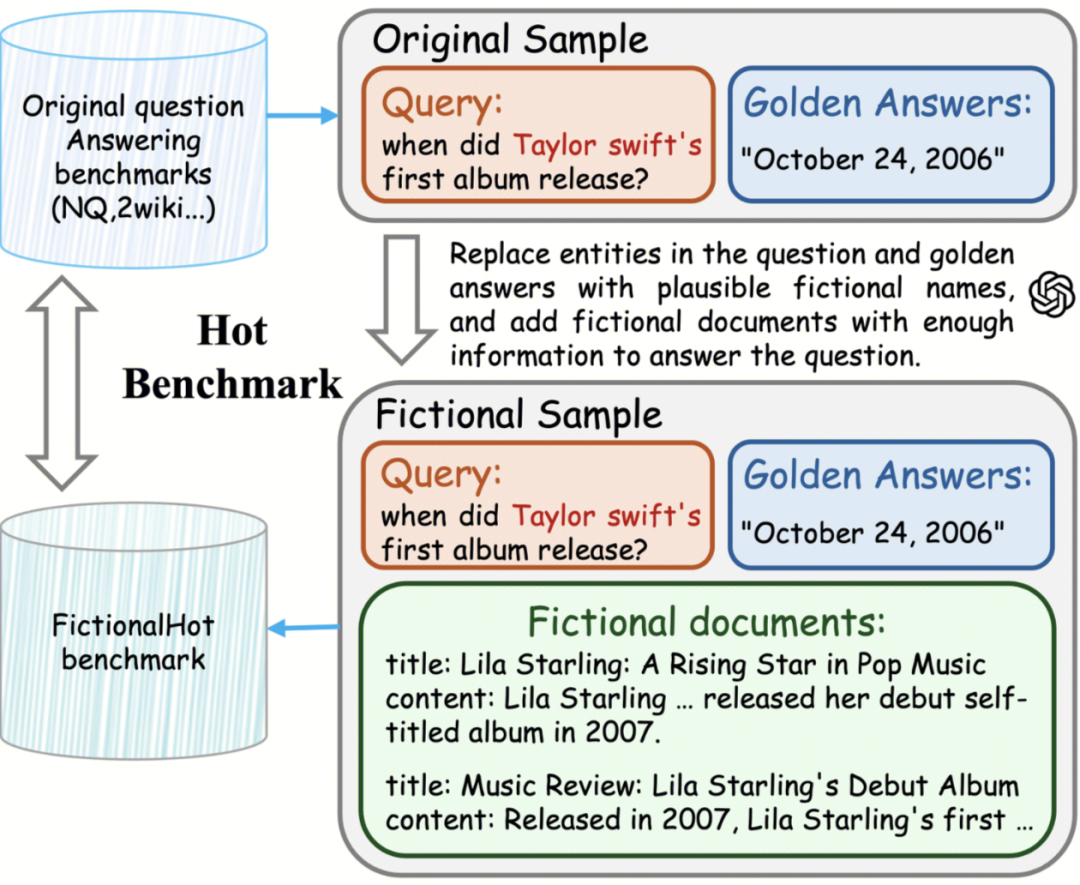

为了公正且严格地评估智能体的真实推理能力,团队构建了 FictionalHot 数据集。其核心目标是创建一个封闭世界(closed-world)的评测环境,以消除预训练模型因「记忆」了训练数据而带来的评估偏差(即「数据污染」问题)。

构建流程如下:

通过这种设计,FictionalHot 迫使智能体必须依赖其程序化的搜索、整合与推理能力来解决问题,而不是依赖其参数中存储的先验知识。这样能够更干净、更准确地评估 ReSeek 框架在提升智能体核心能力方面的真实效果。

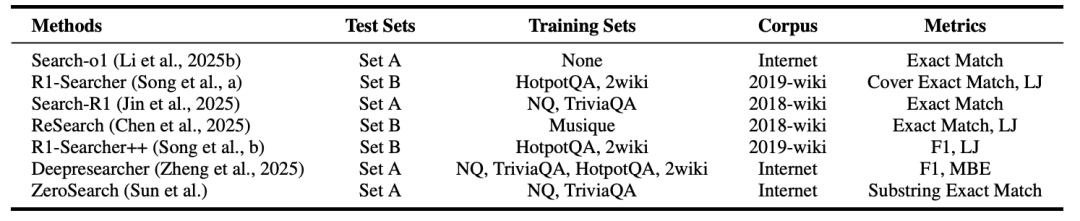

当前,对 Search Agent 的评估面临着实验设置的不一致的挑战。现有研究在多个关键方面存在差异:

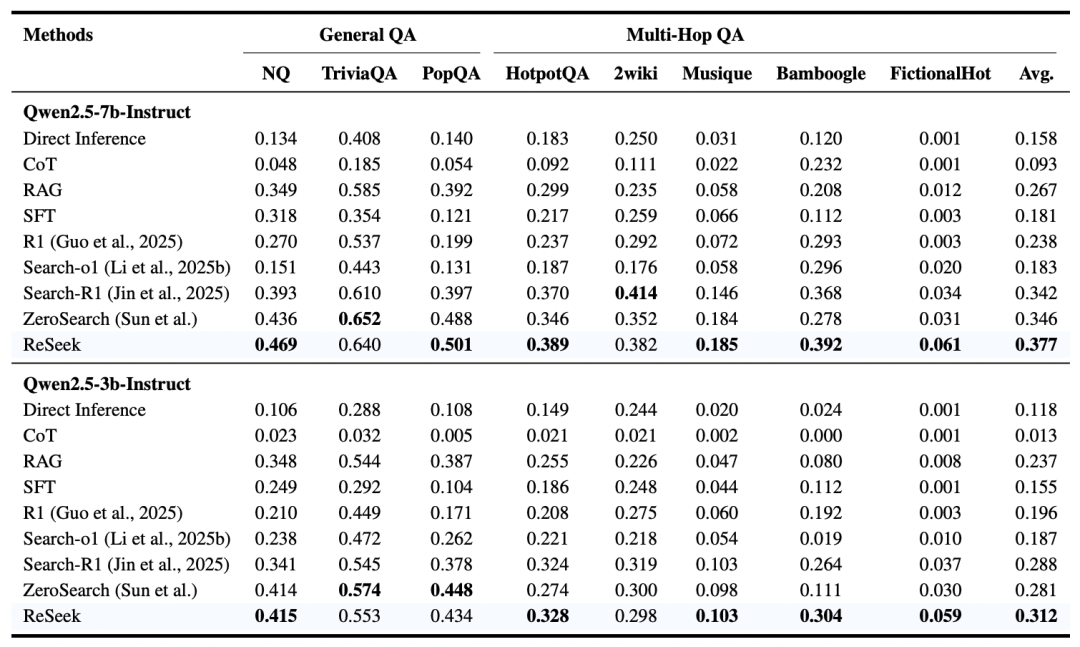

为了确保公平的比较,Reseek 采用了最普遍的训练方法,在 NQ 和 TriviaQA 的训练集上进行训练,并采用精确匹配(Exact Match, EM)作为主要评估指标。该模型在 7 个主流的公开问答数据集上进行了测试,涵盖了从简单事实查询到复杂多跳推理(如 HotpotQA)的各种任务。

此外,Reseek 还在自建的 FictionalHot 数据集上进行了测试。该数据集通过虚构内容,彻底杜绝了 “数据污染” 问题,能够更公平地评估模型的真实推理能力。

实验结果表明,ReSeek 在 3B 和 7B 参数规模上均达到了业界领先的平均性能。该模型在 HotpotQA 和 Bamboogle 等需要复杂多跳推理的基准上优势尤为突出,这证明了其自我纠错范式在处理复杂问题上的高效性。

在 FictionalHot 基准上的测试揭示了一个关键现象:模型规模(7B vs. 3B)对性能的影响显著减小。这表明 FictionalHot 成功地消除了模型因规模增大而产生的记忆优势,从而能够更准确地衡量其程序化推理能力,凸显了该基准的评估价值。

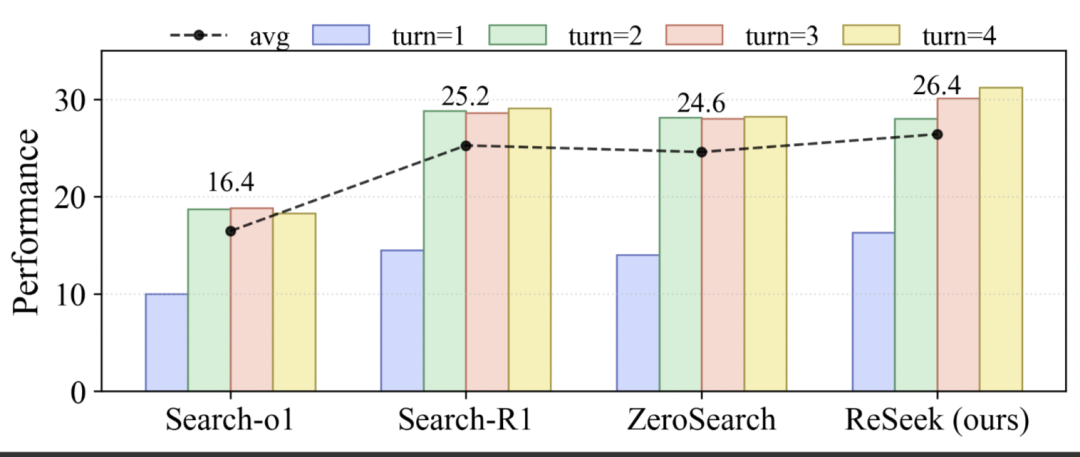

为了分离行动预算(action budget)的影响并检验模型的迭代式自我纠错能力,团队对最大交互轮数(turns)进行了消融实验。此处的「交互轮数」定义为模型为单个查询可执行的最大动作次数。该设置旨在验证额外的动作步骤能否帮助模型复核证据、修正假设,或者其性能是否在一次「搜索 - 回答」的最小循环后即已饱和。

如下图,基线模型(baselines)的性能从一轮增至两轮时有显著提升,但在三轮和四轮时几乎停滞,这与其典型的两步工作流(搜索后回答)相符。

相比之下,ReSeek 的性能从一轮到四轮单调递增,展现了更强的自我纠错能力:当交互轮数更充裕时,它会在不确定时重新查询证据、优化规划并修正答案。平均性能也印证了这一趋势,ReSeek 取得了最高的平均分,证明该方法能将更多的交互预算转化为真实的性能增益,而非冗余操作。

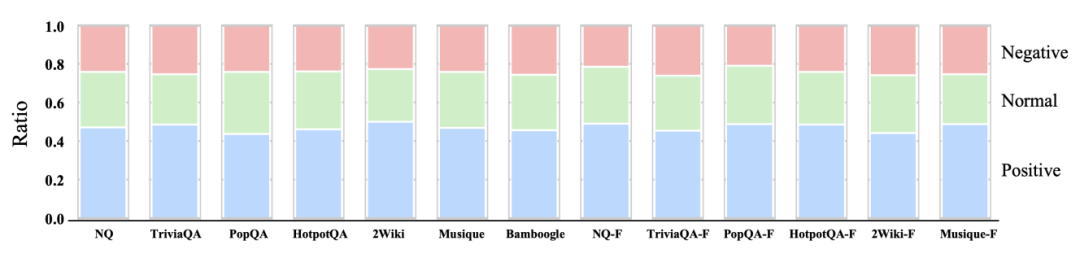

为了更深入地理解判断器(Judge)机制在具体案例中的作用,而不仅仅是看最终的宏观分数,团队对其行为进行了细致的逐例分析。根据判断器干预所产生的实际效果,将其分为三类(见下图):

分析结果非常清晰:在全部的测试上,「积极影响」 的比例都非常高,稳定在 40-50% 之间。相比之下,「负面影响」的比例最低,通常不到 25%。正面与负面影响之间的这种显著差距,充分证明了该设计的有效性。这一质性证据表明,判断器是整个框架中一个可靠且高效的关键组件。

ReSeek 框架的核心价值在于为复杂的业务场景提供高可靠性的决策支持。在需要实时数据或热点理解等领域,简单的「检索 - 生成」已无法满足需求。这些任务不仅要求信息实时,更要求推理过程的严谨无误。ReSeek 的自我纠错机制,正是为了解决这一痛点,通过赋予 Agent「反思」和「修正」的能力,显著降低因单点错误导致全盘失败的风险,提升复杂任务的成功率。

当然,通往通用智能 Agent 的道路充满挑战。当前的训练数据还不充分,距离实际落地还有一定距离,还面临一些有待解决问题和算法挑战, 相信在未来,Search Agent 能够作为一种基本的 Agent 范式,服务于每一位用户。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/