关于如何避免让大语言模型产生幻觉,一直以来的相关研究都非常多。

刚刚,来自清华大学的两位研究员公开了一个最新方法:让LLMs “先验证,再作答”。

它的核心思路很简单:先给模型一个候选答案(哪怕是随机的或极其简单的答案),让模型先验证这个答案,再生成最终正确结果。

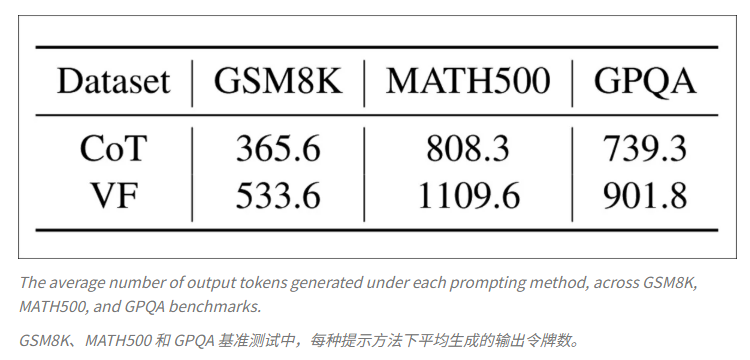

这个“先验证,再作答”的小技巧,不仅极大降低逻辑错误率,还能激发模型的批判性思维,而且几乎不增加任何额外成本。

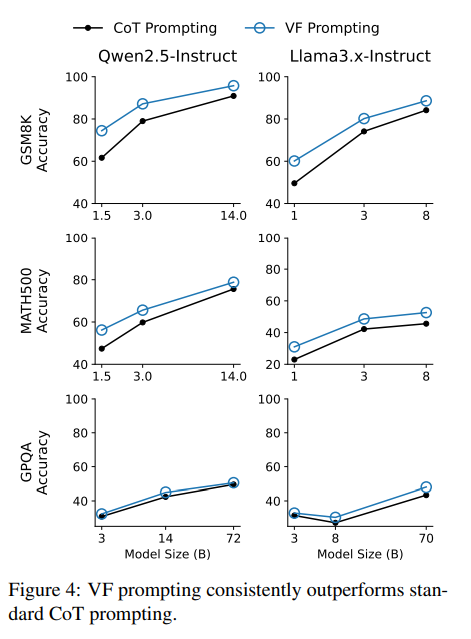

他们将这种方法称为“先验”(VF,Verification-First),并且实验发现:

由于成本很低,因此论文标题也很有意思:要求 LLMs 先验证几乎是“免费午餐”。

传统 AI 解题是从零开始生成答案,而 VF 的方法是:

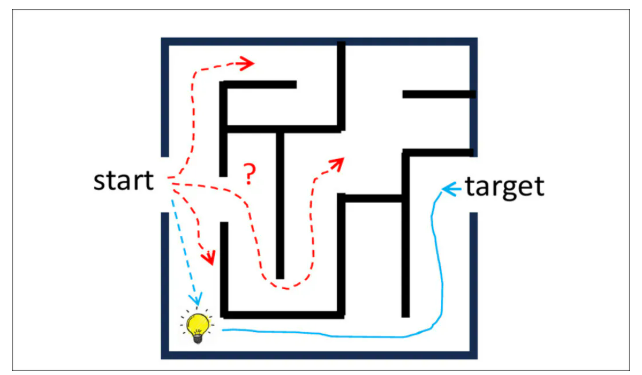

举个例子,在下面这张图中,用普通链式思维(CoT)提示,模型可能流畅地回答,但结果错了;而使用 VF 提示,模型先验证候选答案,理清逻辑顺序,最终给出正确结果。

这个“反向推理”过程有什么用呢?

在现实应用中,比如写代码或调用 API,很难随便提供候选答案。论文提出了升级方案 Iter-VF:

与其他自我纠正策略相比,这种方式不会把之前的错误累积进推理链,保持思路清晰。

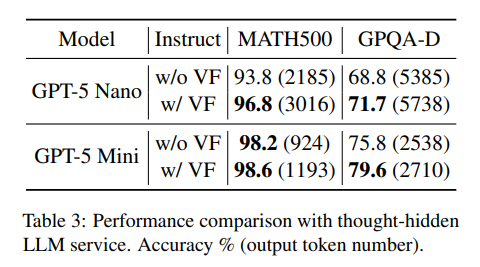

研究团队在数学、科学问答、编程和封闭商业模型(如 GPT-5 Nano / Mini)上进行了大量测试,结果显示:

研究团队还将Iter-VF和其他4种测试时扩展(TTS)策略进行了对比

此外,在闭源模型如GPT-5、Gemini 2.5、Grok 4上,即使无法看到 AI 的内部推理步骤,Iter-VF 也能提升最终答案准确率。

对于经常使用大模型的人来说,可能都会慢慢摸索出一套“小技巧”,来规避模型的各种短板。这篇论文也给我们带来了一个很简单的技巧:先让 AI 核对一个答案,再正式作答。

它的好处很多:触发不同的推理路径、减少错误和幻觉、不依赖额外训练或复杂工具、适用于开源和闭源模型。

这几乎是一个零成本的操作,就能让 AI 答案更可靠。而且这个方法看起来就像是一个通用且高效的“通关秘籍”,几乎可以在不同模型间通用。

另外,作者也特别强调了这个方法的极高经济性,也就是低成本、高收益。在如今超大规模 AI 的背景下,每一份计算资源都是宝贵的,这种节省也是实际应用中至关重要的策略。

大家可以赶紧动手实践起来,测试一下这个方法究竟有没有效!

参考链接:

https://arxiv.org/pdf/2511.21734

文章来自于“51CTO技术栈”,作者 “听雨”。

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales