周末的一场顶级赛事,彻底撕碎了实验室的「滤镜」!全球13支精英战队的机器人上演连环翻车:过吊桥卡腿、爬阶梯摔跤,堪称一场机器人的「荒野求生」。

周末两天,香港中文大学岭南体育场内,尖叫声和倒吸冷气声此起彼伏!

然而,现场不见人类运动员的身影,只有一群机器人,在真实世界里「极限求生」——

这里,没有平整的室内地面,没有恒定的光线,而且鲜有隐身幕后的遥操员。

镜头猛然拉近,率先登场的,是来自香港中文大学的LRL挑战赛队,作为表演嘉宾以全自主的形式来尝试答题。

挑战,从第一个塑料瓶开始,就写满了真实的「残酷」。

只见,它走向场中桌子上的塑料瓶,伸手、探爪——「哐当」!瓶子没抓起来,直接被推倒了。

在被LRL团队成员「拎走」调试后,它倔强地开始了第二次尝试。

令全场唏嘘的是,它又一次失败了!

而且,好不容易抓到的香蕉皮,机器人又用一个潇洒的抛物线,完美地扔到了桶外......

唯一争气抓起的纸盒,却在投递的终极一刻,啪嗒一声又掉在了垃圾桶旁,仿佛完成了最后一记的「喜剧暴击」。

镜头切到隔壁赛区,CUMAE战队的双足机器人,正手持水壶,对着一排白色花朵「精准输出」。

六朵花,全中靶心!

操作看似轻巧,背后全是狠活:不仅稳住底盘,还要同时计算水壶角度、花株高低、空间距离....

每个动作,都是平衡力、视觉与力控的极限拉扯。

不过,这套行云流水动作背后,仍需人类操控员在旁坐镇。

离真正的全自主,还差一步。

另一边,IRMV战队四足机器人站在吊桥起点,蓄势待发。

裁判哨响,它刚向前走了两步,一脚便死死地卡在了桥板的缝隙里。

队友冲上解救之后,正前方又来到了间隔更大的断桥,第一跳起落干净,稳如磐石。

第二跳,四条腿直接凌空,又一次狼狈地卡住。

这些真切发生的案例,仅仅是一场机器人挑战赛「高能剧情」的冰山一角。

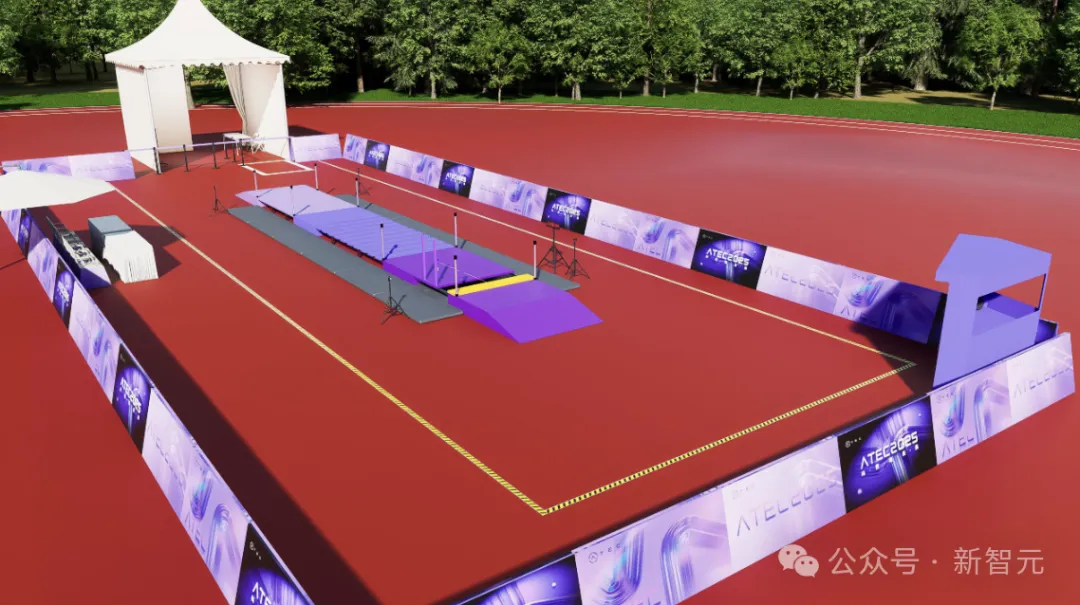

这就是,第五届ATEC科技精英赛(线下赛)· 真实世界极限挑战赛。

它可能是2025年底前,全球最狠的一次机器人公开「处刑」,也可能是离「通用具身智能」最近的一次冲刺。

为什么这么说?

在绝大多数机器人比赛里,我们常看到的是——

室内标准场地、任务单一,甚至背后永远站着一群遥控手,准备随时「救机」。

而这届的ATEC科技精英赛,就是要打破这些「舒适区」!

在过去很长一段时间里,大众视野中的机器人往往自带光环:在精心搭建的演示视频里,它们能做后空翻,能不紧不慢地叠衣服,甚至能像人类一样做出细腻的表情。

然而,本次大赛的主办方香港中文大学,以及承办方ATEC前沿科技探索社区、北京大学、北京师范大学和蚂蚁集团,却联手决定打破这个「舒适区」。

这场赛事的根本目的,是为了回答一个行业的核心问题:机器人能否真正走出实验室,进入并适应复杂的人类世界?

事实上,主办方在赛前就直言不讳:「我们预判会有大量的『翻车现场』」。

作为赛事发起单位之一,蚂蚁集团技术战略部负责人表示,蚂蚁集团长期支持ATEC赛事,源于一个信念:AGI技术发展的未来,是实现机器智能与物理世界的深度融合。

在推动人工智能从「数据认知」走向「环境交互」与「行动执行」的路上,我们期待技术的又一次根本性突破。

今年,ATEC组委会选择了难、但真实的一条路。把赛场放进山地、草地、石阶、吊桥;让机器人面对真实世界的扰动;设计的每一道题,都不是为了让它「完成得好看」,而是为了让它在碰撞中暴露真正的弱点。

因为如果问题不是真实的,就不会牵引出真实的技术进步。只有「真问题」,才能让行业知道下一步要突破什么。

在机器人走向现实之前,这些失误是难以避免的,与其掩饰,不如让技术在真实挑战中成长。

「真实世界极限挑战」,正是这次大赛的核心赛题。那么,真实、极限,究竟体现在了哪?

ATEC2025赛事专家委员会主席、香港工程院院士刘云辉指出,机器人需具备三大核心能力——行走、操作、改造环境,才能在真实世界中立足。

主办方和承办单位以此为技术命题,构建了一套前所未有的「真实世界适应力」的测试框架。

真的本质,首先要回归到「真实世界」。

全户外真实场景

比赛场地,直接选在了港中文岭南体育场&小桥流水生态区,不是标准的室内场地,而是全户外真实场景。

这里,拱桥、山地、缓坡、石阶等,多样化地形一应俱全。

此外,随着光照变化、风力波动等因素,在不同时段叠加作用,机器人的表现将面临更大的挑战。

这也最能考验其在真实环境中的感知鲁棒性与身体适应性。

强激励「无遥操」

不仅如此,这届ATEC科技精英赛,是首次在全户外真实场景中探索「无遥操」技术路径。

当前,全网很多惊艳的机器人视频,背后往往站着一位操控员。

《瞭望》新闻周刊的调查,也印证了这一现状,「众多高难度演示,本质上仍是『提线木偶』」。

本次比赛,评分规则强力引导:

明确奖励「无遥操」的全自主方式,还可以获得额外加分。只要够自主,根据任务和机器人形态,加分从10-25分不等。

这波操作,直接倒逼各团队开卷「AI大脑」,尝试卸掉操控员的远程「代打」。

目标只有一个:把机器人从听话的「工具」,升级成为自主决策的「智能体」!

在比赛的任务设计上,就更有讲究了。一共包含四大任务——

垃圾分拣、自主浇花、定向越野、吊桥穿越

看似是一件一件都是小事,但考验的不是单点难度,而是连续的「任务链」。

由此可见,每一项任务都在考验机器人「多模态感知融合与连续决策」的能力,不是秀秀肌肉就能搞定的。

定向越野中的双足机器人:即使采用了「全遥操」,在面对高低不齐的道路时也会突发状况

这样的设计恰是为了,让机器人形成完整的「感知-规划-执行-反馈」闭环。

而在此之前,选手们必须攻克三大技术瓶颈,即环境感知与认知、智能决策与响应、以及硬件与算力的承载。

第一大挑战,机器人不仅能看得「见」,还要看得「懂」。

赛事专家组钟仿洵教授一语中的,「真实环境里最大的问题是不确定性和高动态性,你看到的不一定是真的」。

进入真实世界中,很多因素都是非结构化的,对算法构成了巨大的挑战。

「垃圾分拣」任务,恰好完美诠释了这一挑战。

它要求,机器人将三类道具:饮料纸盒、香蕉皮、塑料瓶,精准分类并扔到垃圾桶里。

一个干净的瓶子,机器人能轻松识别。但现实中,丢进垃圾桶的废品,可能沾染油渍、被压变形,或是多个物品堆叠,都会「干扰」机器人的眼睛。

这意味着,机器人不能只会「看图识物」,更要学会穿透表象,理解物体本质,做出精准判断。

现实中,机器人不仅要听懂指令,更要在动态变化、充满不确定性环境中,实时推理和决策。

但是,目前它们最缺的就是「举一反三」、「适应新场景」的能力。

清华大学赵明国教授讲得更直白,「比如在足球场上,机器人踢得很漂亮,一旦离开了预设的场景,能力立即大打折扣」。

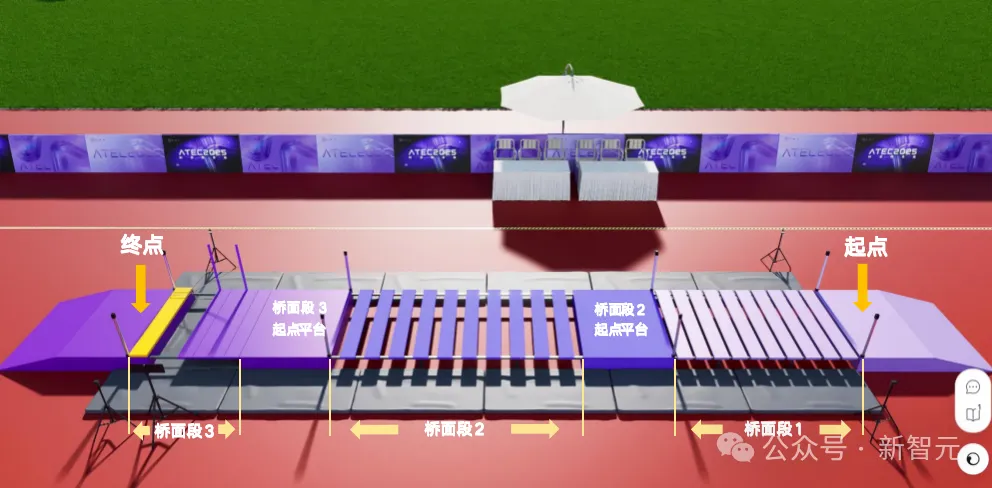

这种挑战在ATEC竞赛中,吊桥穿越、自主浇花的两个任务里,体现得很明显。

刘云辉院士解读「吊桥穿越」任务时说,关键就在于决策和规划能力。

因为木板的位置,每场都不一样。机器人必须自主思考、决策,比如拿起木板去铺路,改变环境后,才能前进。

——这已不是简单的走路,而是包含判断环境、使用工具、规划步骤的「高级智能」。

针对这一瓶颈,赛事专家组Carlos Balaguer教授总结非常到位:关键不在于100%自主,而在于「智慧型自主」。

说白了,让机器人动脑自主干活,这想法挺酷,但现实挺「骨感」的——

身体跟不上脑子,是常见之事。

简单讲,主要卡在了两个方面:

一方面,要么是脑子够快,却又放不进小身体里,甚至功耗也不允许。当前,部署LLM高性能专用芯片不成熟,制约了大脑的实时处理能力。

另一方面,让机器人像人一样精细抓取、灵活操作,技术上有难度,成本更是高得吓人。

因此,机器人「小脑」和「四肢」还支撑不起大脑的智能构想。

赛事专家组王贺升教授指出,「自主浇花」看着简单,却是一个系统集成的大挑战。

浇花时,水壶重量一直在变。机器人能否敏锐感觉到这些变化,做出及时调整,都极具挑战性。

这便是ATEC的魔力,它让现实环境的复杂性变成了必须面对的考题。

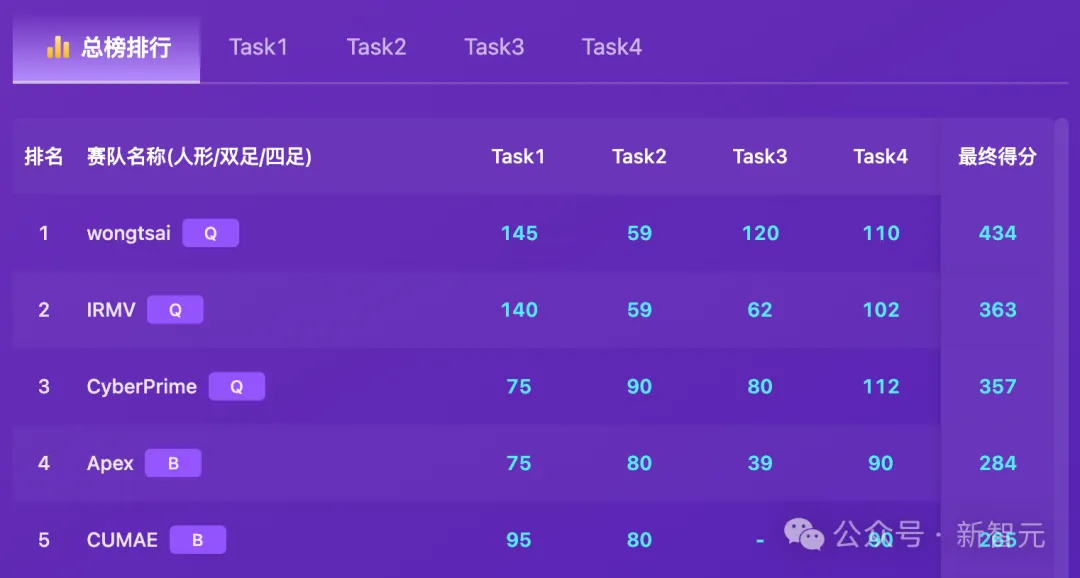

在全球396支队伍的激烈角逐中,只有TOP 13杀出重围,覆盖了QS百强高校、985/211顶尖学府。

总榜上,wongtsai(旺财)团队最终以434分的战绩拔得头筹。

访谈中,这些顶尖的年轻极客,都有一个共同的感受——

真实户外环境最大的挑战在于「不确定性」。

比如,垃圾可能被堆叠、吊桥会晃、浇花时水壶重量会变化等,远比实验室规整的条件复杂多了。

在执行任务过程中,几乎所有的队伍在选择「无遥操」的任务中,做出了「取舍」。

在「吊桥穿越」的挑战中,RIL4RobotAI团队的双足机器人,上演了令人惊心动魄的一幕。

在更宽的「桥面段3」前,团队成员戴上VR眼镜切换远程操控模式,机械臂缓缓伸出,精准地握住悬垂的拉绳。

开始后退拉扯的那一刻,绳子直接滑脱了。惊喜的是,它最终通过双脚挑战成功。

再比如,铁臂阿童木团队双足机器人在「定向越野」任务中,也采用了遥操的方式。

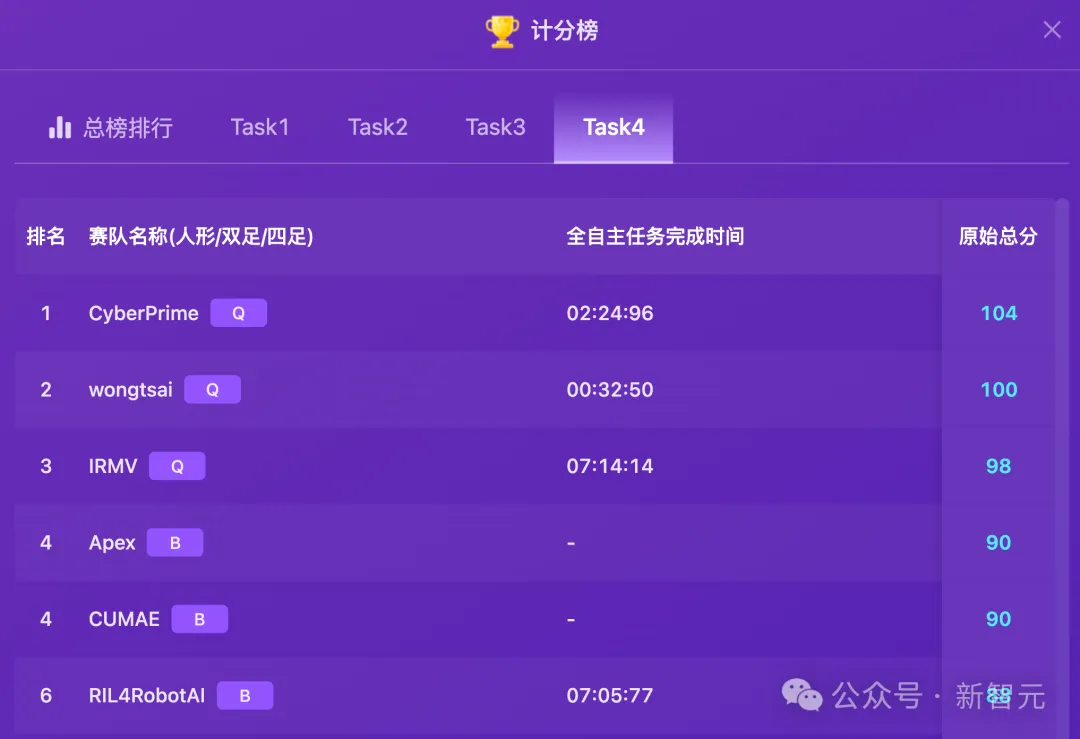

当然,也有团队选择将「全自主」进行到底。

在紧张刺激的「垃圾分拣」任务中,冠军wongtsai团队就上演了终极倒计时作战——

四足机器人全凭自身感知与决策,成功完成了纸盒、香蕉、塑料水瓶的分拣。

CyberPrime团队为机器人装上一双「脚」后,它平稳、自主地走完了三段吊桥。

参赛队伍中,不乏「理想主义者」。

即便让机器人真正融入真实世界,依然面临巨大挑战,但总有乐观主义者相信,这一愿景终将实现。

香港科技大学USTBot赛队的张博阳博士坦言,希望让机器人代替人类去做危险的事情,诸如高空擦玻璃、检查电缆、冲进火场救人等。

从小,自己就爱鼓捣一些小发明,也许在那时候,就已埋下了探索具身智能的种子。

无独有偶,wongtsai(旺财)队长朱承睿预测,「大约20年,机器人可以真正走进人类生活提供服务」。

在赛后采访中,这支由浙大学霸组成的冠军团队wongtsai分享了比赛经验和秘籍。

队长朱承睿自豪地表示,「我们在任务1-4全部发挥出了预期以上的水平」。

赛前一个月,团队做了高强度准备,存储了大量经验。用他们的原话来说——我们投入了特别多精力,掉了很多头发!

在技术路线上,他们没有选择主流的VLA(视觉语言动作模型),反而采取了传统的「视觉识别+压线规划」的方案。

机器人大脑配置方面,wongtsai团队也是下了血本——一共配备了「三台电脑」(CPU+2个GPU)。

当被问及15万美金怎么花时,他们不约而同表示先去「还债」,比赛购买了很多昂贵的设备。

wongtsai团队用Apple Vision Pro远程操控四足机器人完成「自主浇花」任务

在全球13强的备战区,还观察到了一个有趣的现象:技术路线的多元共存。

并没有哪一支队伍将宝全部押在某种单一的技术范式上。

「端到端」(End-to-End)的大模型方案和经典的「模块化」(Modular)方案在这里并行推进。

有的团队采用了清晰的模块化分工,一组人负责「眼睛」(感知),一组人负责「小脑」(运动控制),力求在每一个环节做到精准可控。

而另一些团队则在探索更前沿的端到端方案,试图让机器人像人一样,通过一个大脑直接处理从视觉输入到动作输出的全过程。

但为了保险起见,他们往往也会准备一套传统的控制算法作为「兜底」。

无论选择哪条路,这些年轻的工程师们都有一个共同的感受:硬件能力的边界,正在成为制约算法发挥的瓶颈。

防水性不足的机械臂、在碎石路上抓地力不够的足端、算力受限的机载电脑……这些现实问题,逼迫着他们在算法层面做出更极致的优化。

从2020年创办至今,ATEC科技精英赛,已经是第五届。

这一届,由香港中文大学主办,ATEC前沿科技探索社区、蚂蚁集团、北京大学、北京师范大学共同承办。

过往每一年的赛题,都把最前沿的技术,和最真实的社会痛点「撞」在一起。

从更宏观的产业背景来看,这种碰撞并非偶然。

9月,国际机器人协会发布了《2025世界机器人报告》,数据显示,2024年共有54.2万台机器人「上岗」。

其中,中国占全球总量54%,以29.5万台领跑全球。不过,这股机器人热潮背后,其实暗藏核心技术瓶颈——

很多炫技的演示,要么是后台有人遥控,要么是按设定好好的程序实现。

可见,离人们设想的那种「自己搞定一切」的智能,还差得很远。

现场,吊桥穿越中的四足机器人:即便跳过了「地狱难度」的前半程,却倒在了终点附近

红杉一次闭门演讲中,Jim Fan曾提出了「物理图灵测试」——机器人能在真实世界中无缝操作,并展现出与人无异的能力。

ATEC2025的赛题,正是这一测试的真实写照。

每一道赛题,都是对机器人能否跨越三大技术瓶颈的系统性检验——

环境感知与认知、智能决策与响应、以及硬件与算力的承载

它清晰地丈量了「无遥操」技术的现实距离。采访中,选手们表现出的共识令人动容:「不确定性」是真实世界最大的魅力,也是最大的敌人。

赛场上,他们每一次在挫折中的调试、压力下的协作,正是缩短这段距离最真实、最动人的力量。

所有的策略取舍、所有的算法优化,都是在试图驯服这种不确定性。

正如刘云辉院士所说:「比赛就是一种能力测试。我们能不能通过这些比赛找到一些基准,大家一起Work out一个东西。」

这些「翻车」的瞬间,恰恰暴露了具身智能从「演示可行」走向「应用可靠」之间,那段必须要跨越的鸿沟。

当比赛结束,奖金和名次或许不再是唯一的收获。

这片岭南体育场上留下的每一行代码、每一次调试、甚至每一次跌倒的数据,都将成为通往通用具身智能道路上的宝贵路标。

在这场极限挑战中,没有绝对的失败者。

每一个敢于将算法扔进现实「火坑」淬炼的队伍,都是先行者。

参考资料:

https://www.atecup.com/live/2025

文章来自于“新智元”,作者 “桃子 定慧”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md