觉得大模型消耗的算力过大,英伟达推出的8B模型Orchestrator化身「拼好模」,通过组合工具降本增效,使用30%的预算,在HLE上拿下37.1%的成绩。

最近,NVIDIA Research发现,只要经过适当微调,小模型已足以「指挥」大模型

英伟达研究团队的新模型Orchestrator仅有 80 亿参数(8B)的模型,不仅比以往的工具使用类AI智能体准确率更高、成本更低,还能在工具选择上精准对齐用户的偏好。

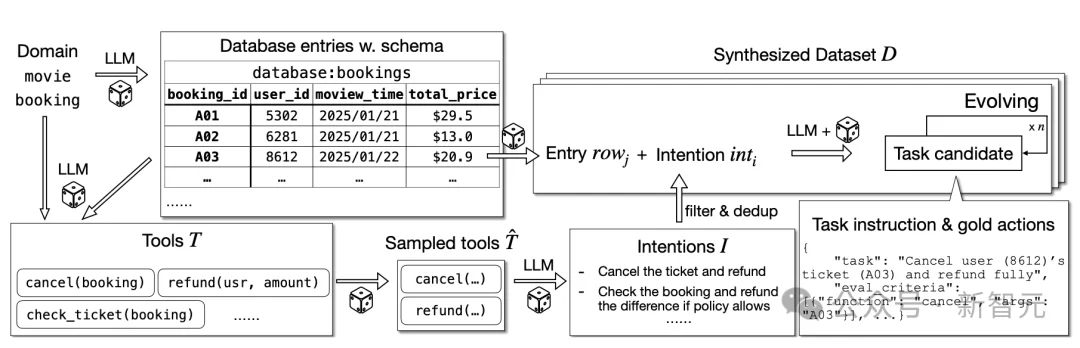

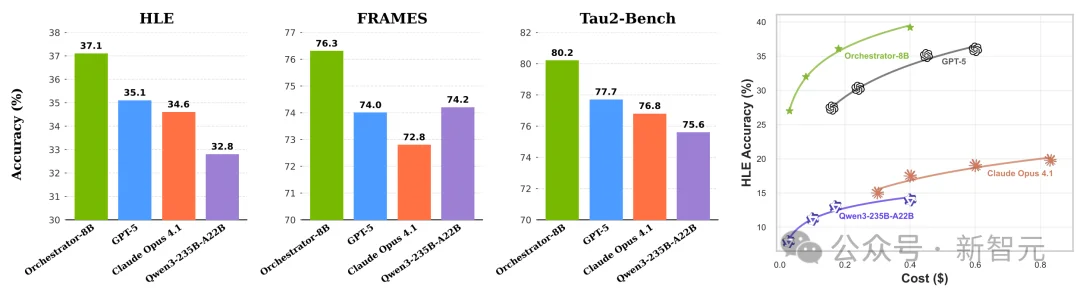

在HLE基准测试中,Orchestrator斩获了37.1%的高分,一举超越了GPT-5(35.1%),同时在效率上提升了2.5倍。

在tau2-Bench和FRAMES测试中,Orchestrator同样以大幅优势领先 GPT-5,而其成本仅为后者的30%左右。

在多项指标上,Orchestrator均实现了性能与成本的最佳平衡,并能出色地泛化至未曾见过的工具中。

预印本链接:https://arxiv.org/abs/2511.21689

面对Humanity’s Last Exam(HLE)这类超难综合推理考试,现在的大模型虽然「什么都懂一点」,但一到深度推理+控制成本就开始吃力。

只靠一个大模型(比如GPT-5)去调用搜索、代码解释器这些基础工具,很难同时做到:够准、够便宜、够可控。

为了省钱,业界第一反应是:别什么都让最强模型上,搞个「调度者」来分配任务。

但真把主流大模型拉来做调度者,结果却很讽刺:

换句话说:我们以为造了个「调度者」,结果只是多请了一个「转接电话的前台」。

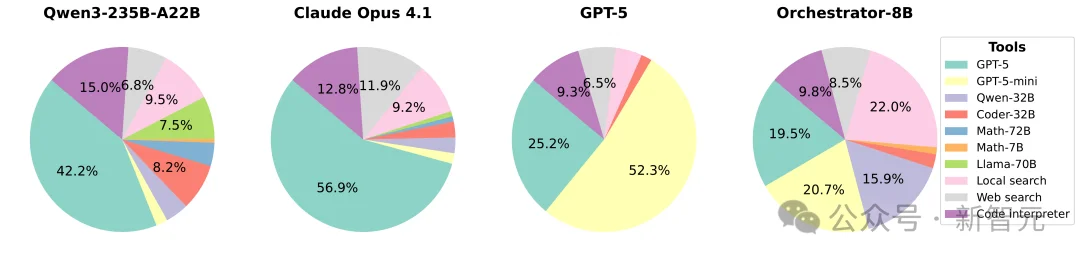

使用不同模型作为调度者后,给不同模型分配的任务

结果说明,仅仅通过提示词,无法让常见的大模型变成合格的调度者。

而ToolOrchestra,通过将「智能」从单一模型中解耦,重构为「轻量调度中枢+异构能力工具集」的复合系统,构成了一种全新的模型与工具协同范式。

接下来,看看Orchestrator是怎么训练出来的。

想象一下:过去的大模型,都像高端餐厅,全靠「米其林主厨」(GPT-5)从头到尾亲自炒菜——火候、刀工、摆盘,全靠一人。

结果呢?由于单个token成本很高,导致总成本直接原地起飞。

而英伟达新推出的「拼好饭」模式如同中央厨房,一个聪明的「调度店长」(8B小模型Orchestrator)驻守中央,店长不亲自炒菜,而是:

Orchestrator的架构图

其中用于调度的8B小模型Orchestrator,会通过强化学习,根据用户声明的倾向,系统自动倾向本地部署模型。

而训练过程中的奖励函数,可分为3部分:

1. 结果,即是否答对,答对+1,否则0;由GPT5给出判断;

2. 效率,对应金钱成本和时间延迟;

3. 对齐用户工具偏好向量。

三部分加起来,才是强化学习的目标函数,而最终训练得到会权衡、听指挥、懂省钱的Orchestrator。

Orchestrator还包含类人分步求解机制:

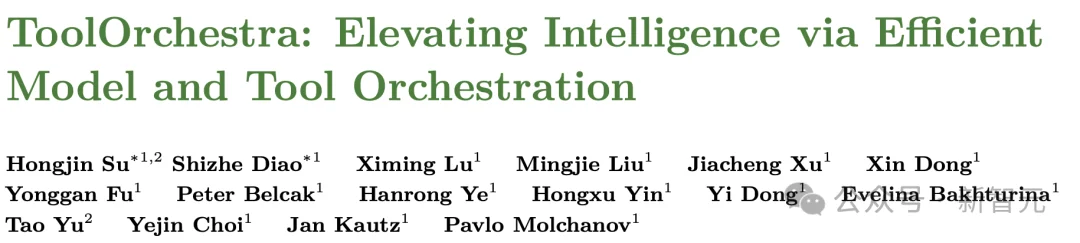

有了训练方法,该研究还构建ToolScale来支撑强化学习的训练。

作为首个大规模、可验证的多轮工具调用合成数据集:ToolScale通过大模型自动构建10个领域(金融、医疗、航空等)的模拟环境(含数据库+工具API),再生成43万条含人工标记的最佳工具调用轨迹的任务。

ToolScale数据合成流程概览

每条任务需满足三重验证:

这些数据被用来训练Orchestrator。

在三大高难度基准上,Orchestrator-8B全面超越现有方法且显著降低推理成本:

Orchestrator调度后的模型性能和成本对比。

相较于强大的单体大语言模型系统,Orchestrator实现了最佳的成本效益:

进一步分析揭示其卓越性能源于理性分工能力:

调用低成本的模型去解决不那么复杂的问题,正是Orchestrator能够降本增效的根源。

Orchestrator调用不同工具的比例对比

Orchestrator还展现出极强泛化性:面对训练未见模型(如Gemma-3-27B、Codestral-22B)或新定价策略(DeepInfra),其性能仅轻微波动,证明其学会的是工具能力抽象与成本-效益权衡的通用策略,而非过拟合特定配置。

同时在满足用户偏好时,Orchestrator的表现也优于其它大模型,这证明Orchestrator具有可定制、可约束、可解释的工具调度能力。

这几年,AI 世界一直在讲同一个故事:先造出一个尽可能大的通用大脑,再通过提示词和少量样本,把它临时「装扮」成翻译、写作、编程等各种专家。

但随着研究不断推进,这个故事开始松动:

越来越多由多个模型和工具协同工作的「复合AI系统」,在安全性、速度和成本上都比单一大模型更有优势,甚至在能力上也实现赶超。

总结来看,面对大模型使用后的高成本,高能耗问题,Orchestrator展现了通过将「决策权」与「执行权」分离,不再指望一个超人拯救世界,完全可开辟一条通往高效、可控、可扩展的实用化AGI系统的新路径。

ToolOrchestra标志着我们朝着构建真正智能的复合AI系统迈出了第一步,这代表着一种正在兴起、旨在取代单一化AI架构的新范式。

小语言模型终将成为实现可扩展智能体AI的关键核心。

参考资料:

https://arxiv.org/abs/2511.21689

https://developer.nvidia.com/blog/train-small-orchestration-agents-to-solve-big-problems/

https://research.nvidia.com/labs/lpr/ToolOrchestra/

文章来自于“新智元”,作者 “peter东”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0