尹博:NUS 计算机工程硕士生、LV Lab 实习生,研究方向是生成式 AI,及参数高效率微调(PEFT)。

胡晓彬:NUS LV Lab Senior Research Fellow, 研究方向是生成式 AI,MLLM Agent 等。

在大模型时代,参数高效微调(PEFT) 已成为将 Stable Diffusion、Flux 等大规模扩散模型迁移至下游任务的标准范式。从 LoRA 到 DoRA,社区不断探索如何用更少的参数实现更好的适配。

然而,现有的微调方法(如 LoRA、AdaLoRA)大多采用「静态」策略:无论模型处于去噪过程的哪个阶段,适配器(Adapter)的参数都是固定不变的。这种「一刀切」的方式忽略了扩散生成过程内在的时序物理规律,导致模型在处理复杂结构与精细纹理时往往顾此失彼。

针对上述问题,新加坡国立大学 LV Lab(颜水成团队) 联合电子科技大学、浙江大学等机构提出 FeRA (Frequency-Energy Constrained Routing) 框架:首次从频域能量的第一性原理出发,揭示了扩散去噪过程具有显著的「低频到高频」演变规律,并据此设计了动态路由机制。

FeRA 摒弃了传统的静态微调思路,通过实时感知潜空间(Latent Space)的频域能量分布,动态调度不同的专家模块。实验结果显示,FeRA 在 SD 1.5、SDXL、Flux.1 等多个主流底座上,于风格迁移和主体定制任务中均实现了远超 baseline 的生成质量。

研究背景:静态微调与动态生成的错配

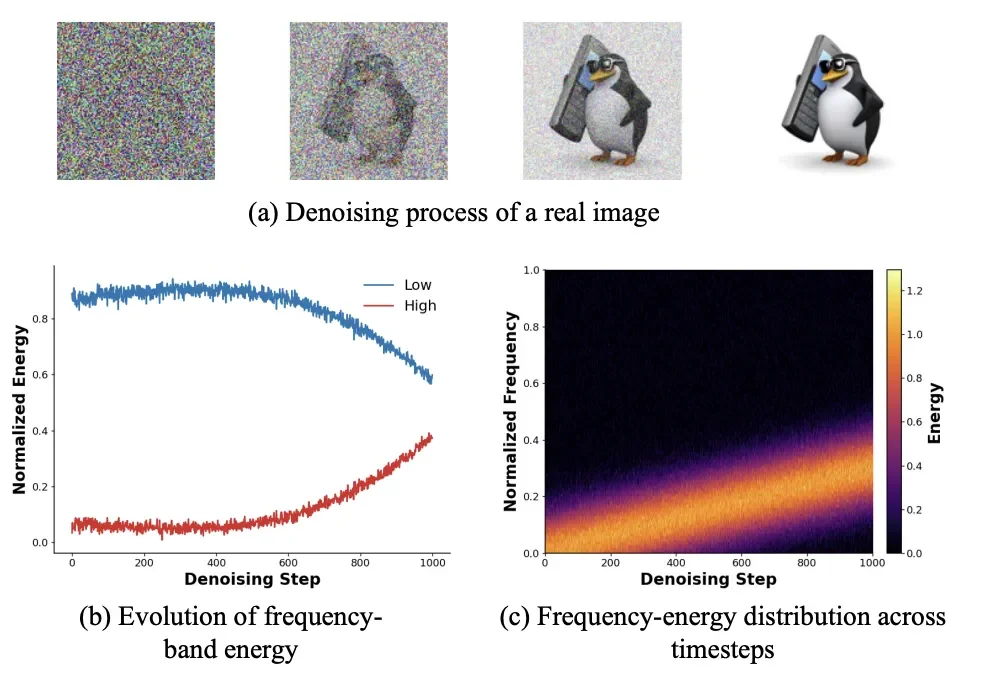

扩散生成的「频域时序性」

扩散模型的去噪过程(Denoising Process)本质上是一个从无序到有序的物理演变。研究团队通过对中间层特征的频谱分析发现,这一过程并非各向同性,而是具有鲜明的阶段性特征:

现有方法的局限

然而,LoRA 等主流 PEFT 方法在所有时间步(Timestep)上应用相同的低秩矩阵。这意味着,负责「画轮廓」的参数和负责「描细节」的参数是完全耦合的。这种目标错配(Misalignment)导致了计算资源的浪费:模型不得不在有限的参数空间内权衡结构与细节,往往导致生成的图像要么结构崩坏,要么纹理模糊。

因此,设计一种能够感知当前生成阶段,并「按需分配」算力的动态微调机制,成为突破性能瓶颈的关键。

方法介绍:FeRA 框架

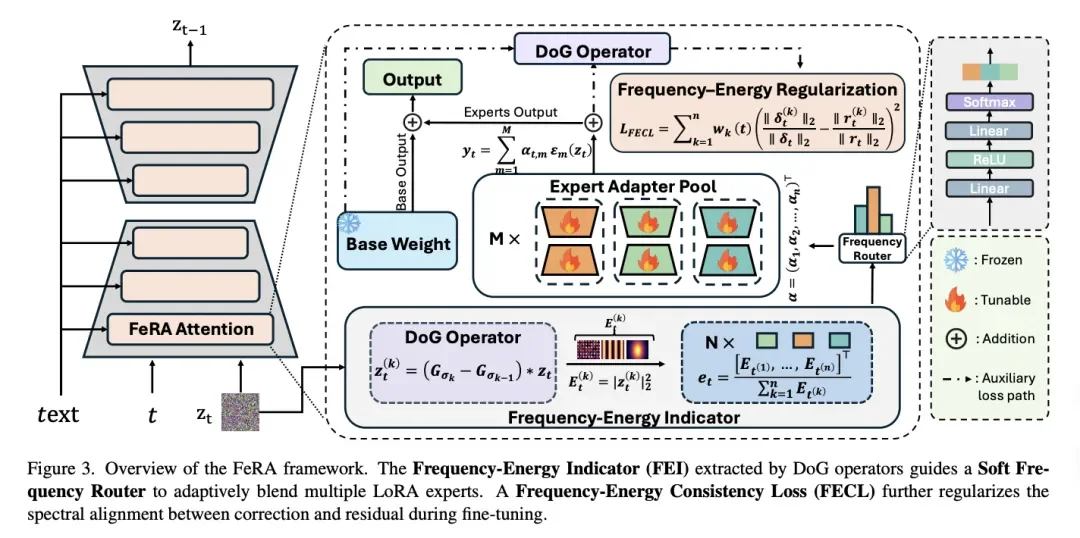

为了解决上述痛点,研究团队提出了 FeRA (Frequency-Energy Constrained Routing)。该框架包含三个核心组件,形成了一个感知 - 决策 - 优化的闭环:

频域能量指示器 (Frequency-Energy Indicator, FEI)

这是 FeRA 的「眼睛」,不同于以往方法仅依赖离散的时间步(Timestep)作为条件,FeRA 利用 高斯差分 (Difference-of-Gaussians, DoG) 算子,在潜空间直接提取特征的频域能量分布。

软频域路由器 (Soft Frequency Router)

这是 FeRA 的「大脑」,基于 FEI 提供的能量信号,路由器通过一个轻量级网络动态计算不同 LoRA 专家 (Experts) 的权重。

频域能量一致性正则化 (FECL)

这是 FeRA 的「稳定器」,为了防止微调过程偏离原本的生成轨迹,团队引入了 FECL (Frequency-Energy Consistency Loss)。该损失函数强制要求:LoRA 产生的参数更新量(Update),其在频域上的能量分布必须与模型原本的残差误差(Residual Error)保持一致。这确保了微调过程「指哪打哪」,极大地提升了训练稳定性。

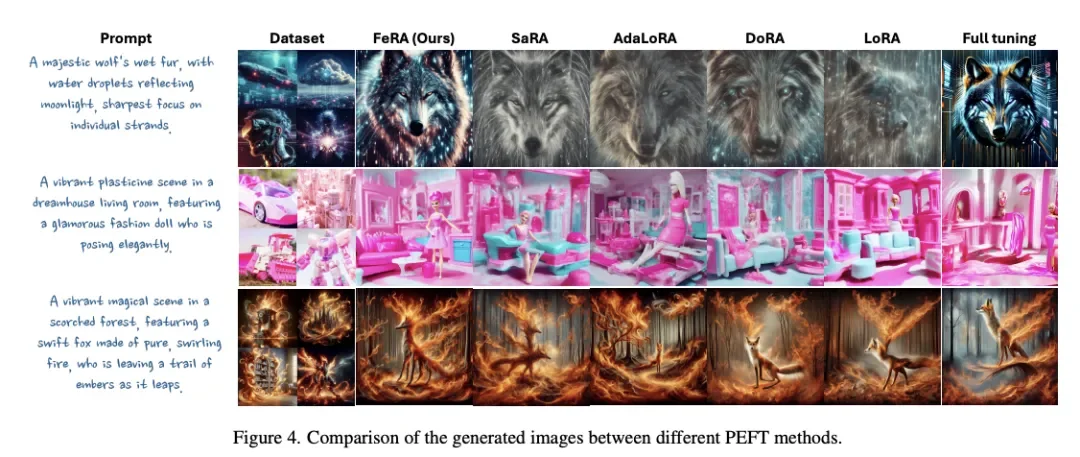

实验验证:从风格迁移到主体定制

研究团队在 Stable Diffusion 1.5、2.0、3.0、SDXL 以及最新的 FLUX.1 等多个主流底座上进行了广泛测试 。实验涵盖了风格迁移(Style Adaptation)和主体定制(DreamBooth)两大任务。

风格迁移:FID 与 CLIP 的双赢

在 Cyberpunk, Watercolor 等多种风格数据集上,FeRA 在 FID(图像质量) 、CLIP Score(语义对齐)和 Style(MLLM 评分) 上均取得了最优或次优的成绩。

主体定制:更懂你的 Prompt

在 DreamBooth 任务(如让特定的狗游泳、让特定的茶壶放在草地上)中,FeRA 展示了惊人的文本可控性。

总结

总的来看,目前的扩散模型微调仍以静态参数叠加为主,在处理复杂的多频段信息时存在天然瓶颈。

LV Lab 颜水成团队 提出的 FeRA 框架,通过引入频域第一性原理,将微调从「参数层面的分解」推进到了「机制层面的对齐」。FeRA 证明了:顺应生成过程的物理规律,利用频域能量进行动态路由,是实现高效、高质量微调的关键路径。

这一工作不仅刷新了各项 SOTA 指标,更为未来扩散模型在视频生成、3D 生成等更复杂任务中的微调提供了极具价值的新思路。

文章来自微信公众号 “ 机器之心 ”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【部分开源免费】FLUX是由Black Forest Labs开发的一个文生图和图生图的AI绘图项目,该团队为前SD成员构成。该项目是目前效果最好的文生图开源项目,效果堪比midjourney。

项目地址:https://github.com/black-forest-labs/flux

在线使用:https://fluximg.com/zh

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0