本文第一作者是二年级博士生闫熠辰,主要研究方向是多模态大模型的数据质量管理;通讯作者是李环研究员,主要研究方向包括人工智能数据准备、大模型高效推理与部署、时空大数据与模型轻量化等。

在深入技术细节之前,我们先用一张漫画来直观理解 COIDO (Coupled Importance-Diversity Optimization) 解决的核心问题与方案:

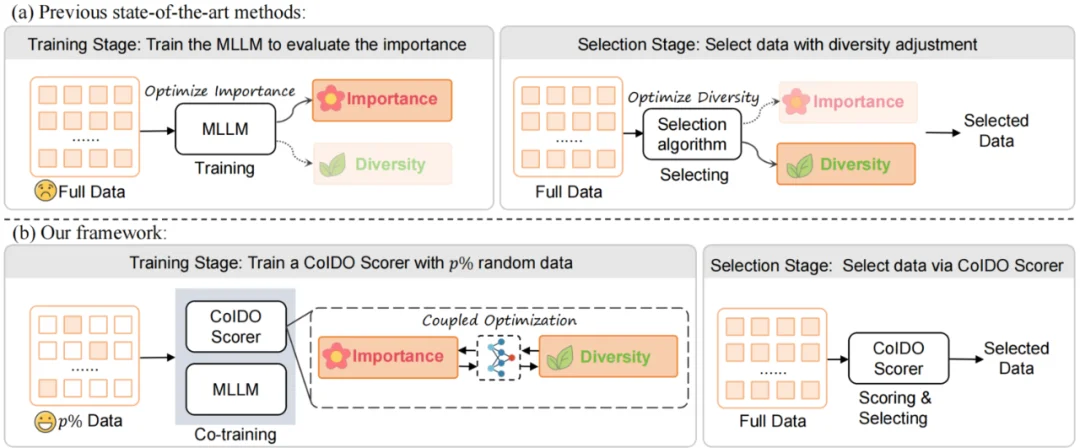

正如钟离在漫画中所言,面对海量视觉指令数据的选择任务,传统方法需要遍历全部数据才能进行筛选造成大量「磨损」(高昂计算成本)。同时在面对数据重要性和多样性问题时,传统方法往往顾此失彼。而 COIDO 通过「耦合优化」的新契约,实现了以简驭繁的效果。

多模态大语言模型(MLLM)的能力在很大程度上依赖于高质量的视觉指令微调(Visual Instruction Tuning)。然而,随着数据集规模的爆炸式增长(如 LLaVA-665K),在全量数据上进行微调带来了巨大的计算开销和冗余 。

现有的数据筛选方法虽然旨在选取高质量子集,但普遍存在两个关键痛点:

针对上述问题,本文提出了 COIDO 框架,旨在通过极低成本的训练,实现重要性与多样性的联合(耦合)优化 。

COIDO 的核心思想是摒弃「遍历全量数据」的旧范式,转而采用轻量级评分器(Plug-in Scorer)配合小样本采样的策略。

1. 轻量级评分器与小样本学习:不同于需要全量微调 MLLM 的方法,COIDO 引入了一个轻量级的插件评分器(COIDO Scorer)。我们仅从全量数据中随机采样一小部分(例如 20%)作为训练集。评分器通过这部分数据学习整个数据集的分布特征,从而能够对剩余数据进行泛化评分,无需遍历全集进行训练 。

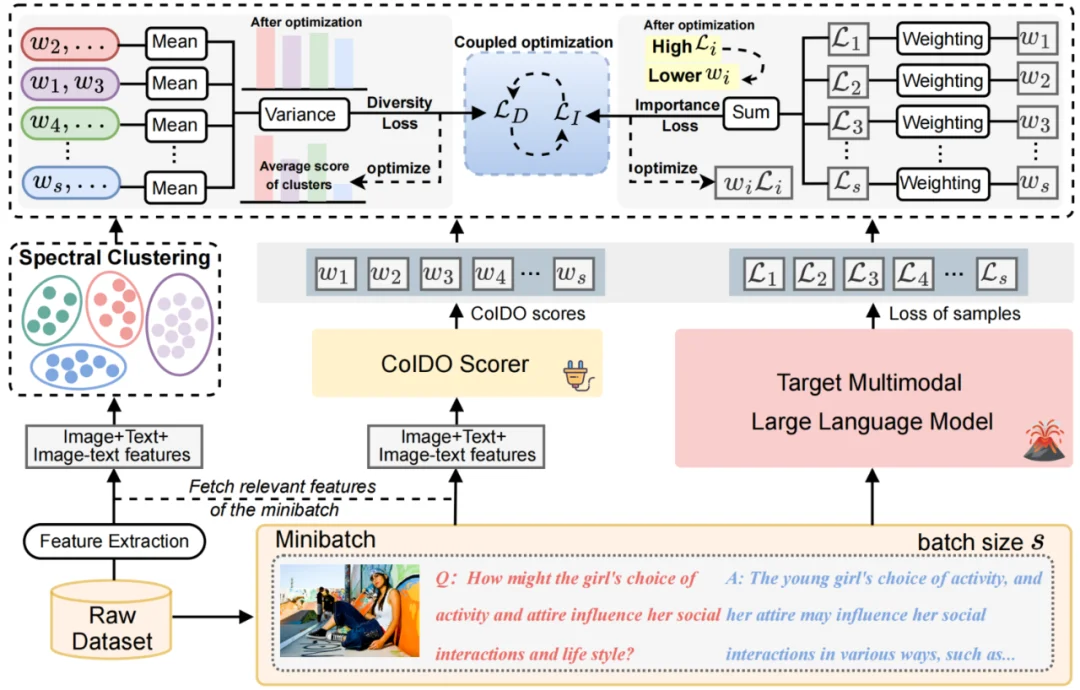

2. 重要性与多样性的耦合优化 (Coupled Optimization) :这是本论文的核心创新点。本文将重要性和多样性的优化统一在了一个联合训练框架中,而非分阶段进行:

重要性损失 (L_I):基于 Cross-Entropy Loss 的重加权。我们将评分器输出的得分 w 加权作用于 MLLM 的预测 Loss。根据反向传播原理,模型会自动降低高难度(高 Loss)样本的权重以最小化整体 Loss,从而使得评分器隐式地学习到样本的重要性(即:分数越低,样本越重要 / 越难)

多样性损失 (L_D):基于谱聚类(Spectral Clustering)的方差最小化。我们在特征空间将数据聚类,并计算各簇(Cluster)平均得分的方差。通过最小化该方差,迫使模型在挑选高分样本时,不会过度集中于某一类,从而保证了数据的多样性分布。

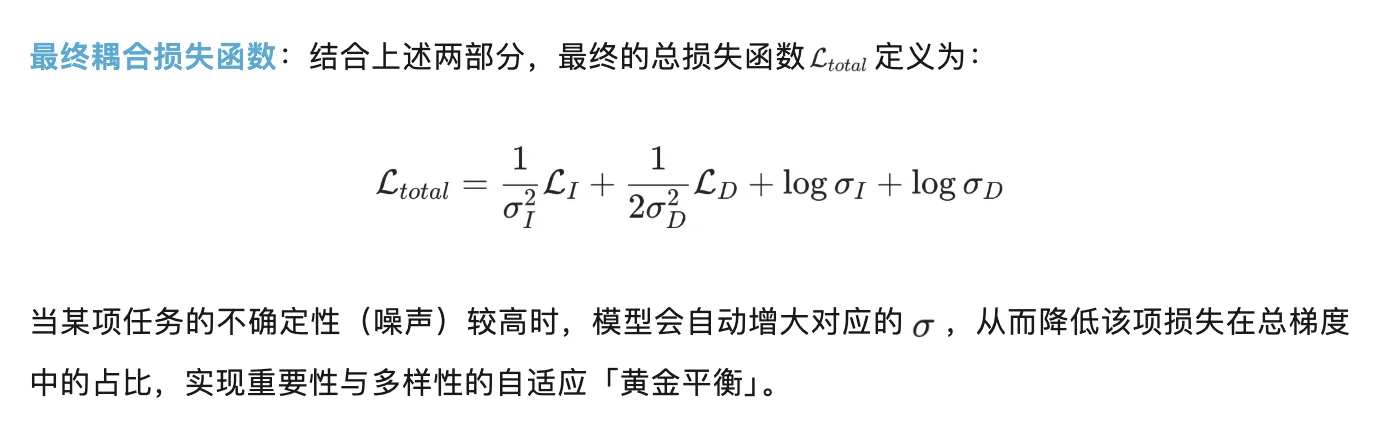

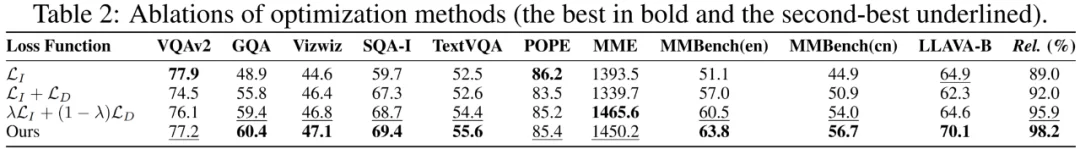

合损失函数:结合上述两部分,最终的总损失函数

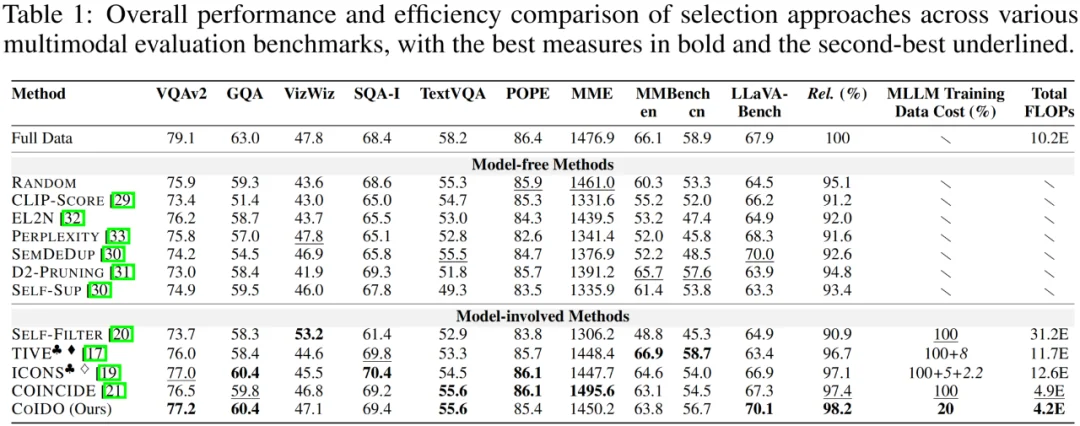

本文在 LLaVA-1.5-7B 模型及 LLaVA-665K 数据集上进行了广泛验证,并在 10 个主流多模态基准(包括 VQAv2, GQA, MMBench 等)上进行了测试。

1. 性能与效率的双重 SOTA:实验结果表明,COIDO 仅利用 20% 的数据进行训练和筛选,即可达到全量数据微调 98.2% 的平均性能。与现有的 SOTA 方法(如 ICONS、TIVE、COINCIDE)相比:

2. 强大的泛化性与迁移性:将在 LLaVA-665K 上训练好的 COIDO Scorer 直接应用于 Vision-Flan 数据集(Zero-shot Transfer),其表现甚至优于在该数据集上从头训练的评分器,证明了 COIDO 能够学习到通用的数据价值评估标准。

COIDO 提供了一种全新的多模态数据筛选范式。它打破了「数据筛选必须昂贵」的刻板印象,证明了通过耦合优化和小样本学习,我们可以「以简驭繁」,用极小的计算代价精准定位高价值的视觉指令数据。这不仅为资源受限的研究者提供了高效微调 MLLM 的可能,也为未来大规模多模态数据的自动化清洗与治理提供了新的思路。

关注项目主页获取更多细节与代码实现!

文章来自于微信公众号 “机器之心”,作者 “机器之心”

【开源免费】ai-comic-factory是一个利用AI生成漫画的创作工具。该项目通过大语言模型和扩散模型的组合使用,可以让没有任何绘画基础的用户完成属于自己的漫画创作。

项目地址:https://github.com/jbilcke-hf/ai-comic-factory?tab=readme-ov-file

在线使用:https://aicomicfactory.app/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner