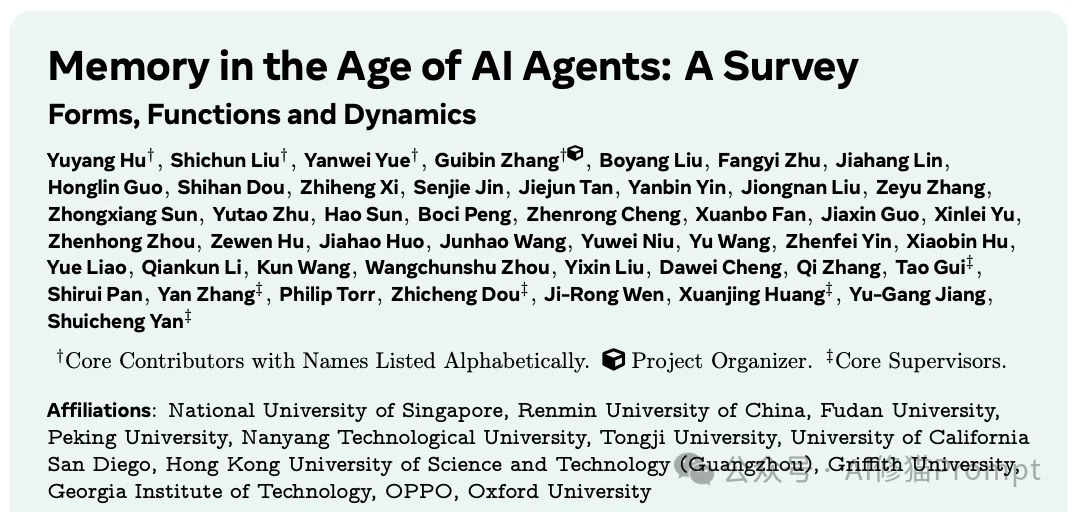

就在昨天,新加坡国立大学、中国人民大学、复旦大学等多所顶尖机构联合发布了一篇AI Agent 记忆(Memory)综述。

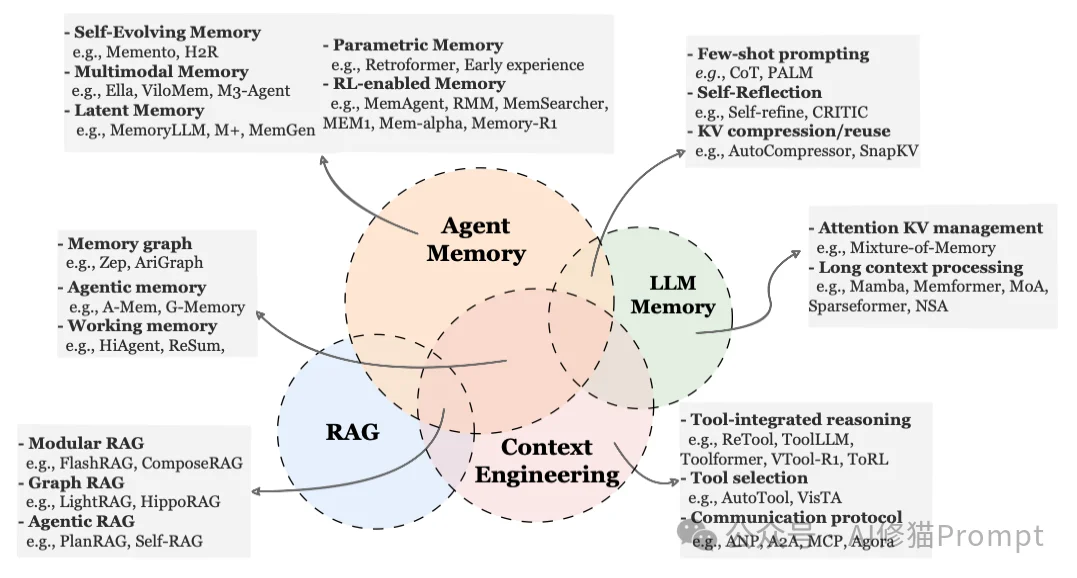

当前的 LLM 应用开发正面临严重的“记忆碎片化”问题:我们有用于短期记忆的 KV Cache,有用于知识检索的 RAG,还有用于长期交互的 MemGPT 类架构,但缺乏统一的理论指导。这篇综述不仅是对现有工作的盘点,更是一份解决“灾难性遗忘”与“上下文溢出”的系统方案。它详细拆解了如何通过Token级、参数级和潜在(Latent)级三种形式来构建记忆,并深入探讨了如何让记忆像生物体一样具备“自我遗忘”和“冲突修正”的能力。对于正在构建复杂Agent应用(如伴侣 Bot、自主编码 Agent)的读者朋友来说,这篇文章直接给出了技术选型的理论依据。

在深入技术细节之前,我们需要先达成一个共识:并不是所有“存下来的东西”都叫Agent记忆。研究者在论文中非常严谨地帮我们区分了三个容易混淆的概念,这有助于我们理解Agent记忆的独特性。

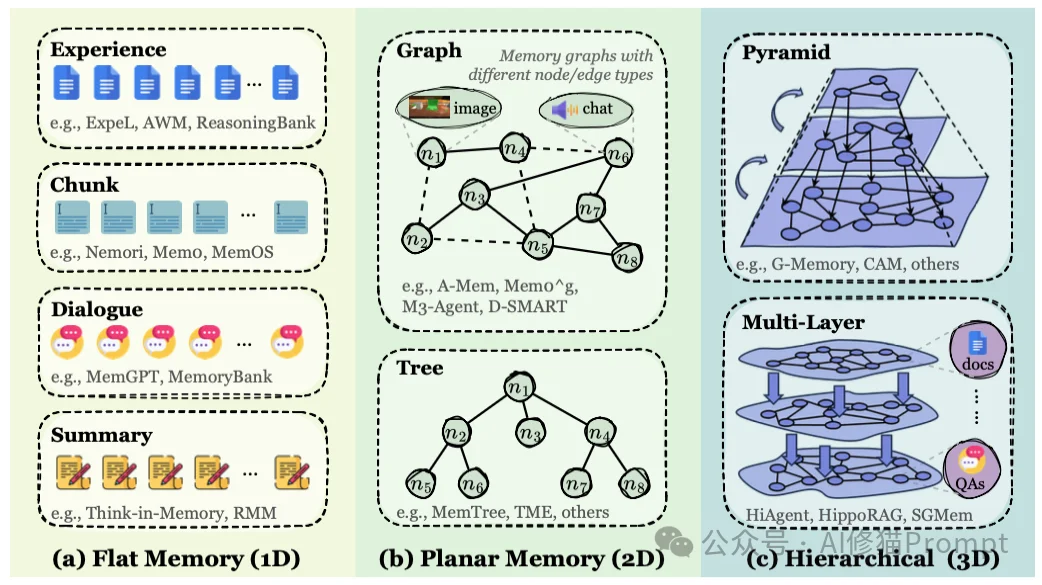

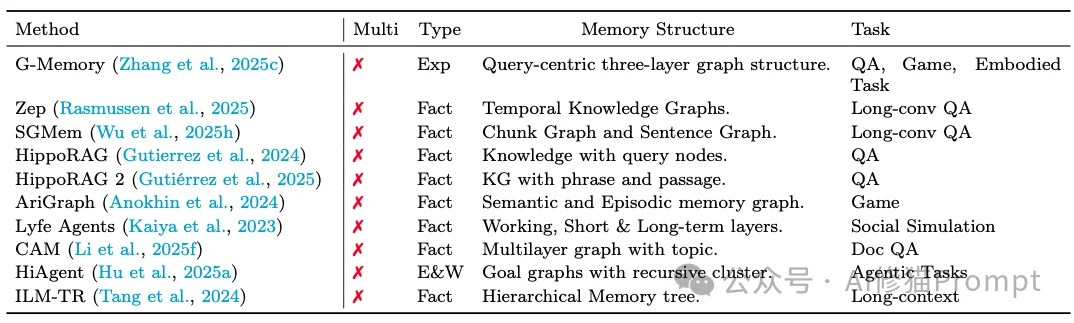

如果我们打开 Agent的“大脑”,我们会看到什么样的存储结构?研究者将记忆的形式归纳为三大类。这三种形式并不是互斥的,而是像人类大脑的不同区域一样协同工作。

这是目前最主流、最可解释的记忆形式。信息以离散的、可读的文本(Token)或数据块的形式存储在模型外部。根据组织方式的复杂程度,它从简单的线性记录进化到了复杂的立体结构。

Mem0 的图记忆版本,就能在对话中实时构建这种实体关系。

HiAgent 或 GraphRAG)允许 Agent在宏观规划时调用顶层记忆,在执行具体操作时调用底层细节,极大地平衡了检索效率与信息密度。这种记忆形式更隐蔽。信息不再是存储在硬盘上的文字,而是直接变成了模型神经网络中的权重参数。

K-Adapter),既保留了模型的通用能力,又注入了特定领域的知识,且支持即插即用。这种记忆形式对于人类来说是不可读的,但对于机器来说效率极高。它直接存储模型推理过程中的数学表示。

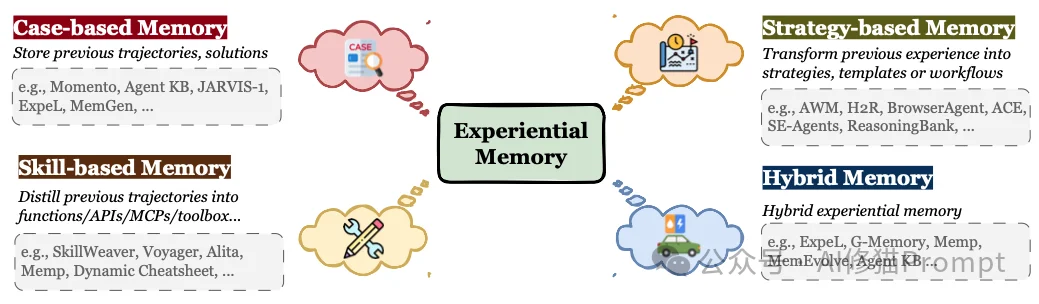

搞清楚了记忆存在哪里,我们再来看看 Agent到底在记什么。研究者提出了一个非常精妙的分类法,将记忆的功能分为了三类,分别对应了 Agent的不同能力维度。

这是 Agent对世界的声明性知识(Declarative Knowledge),它解决了一致性的问题。

MemGuide 系统会维护用户的“意图树”,即使话题跑偏,也能拉回最初的目标。这是区分普通Chatbot和高级Agent的关键。 它对应的是人类的“程序性记忆”(Procedural Knowledge),是Agent实现自我进化的基石。

这是经验记忆最高级的形式,它将抽象的经验固化为可执行的工具。

Voyager 这样的 Agent,在 Minecraft游戏中学会了“挖铁矿”的一系列复杂操作后,会自己写一段代码封装成 mine_iron() 函数存入技能库。下次再需要铁矿,直接调用这个函数,而不需要重新思考每一步怎么走。ToolLLM)。这就好比是我们电脑的内存(RAM),或者是人类正在进行心算时的思维草稿纸。它的核心挑战在于上下文窗口是昂贵且有限的。

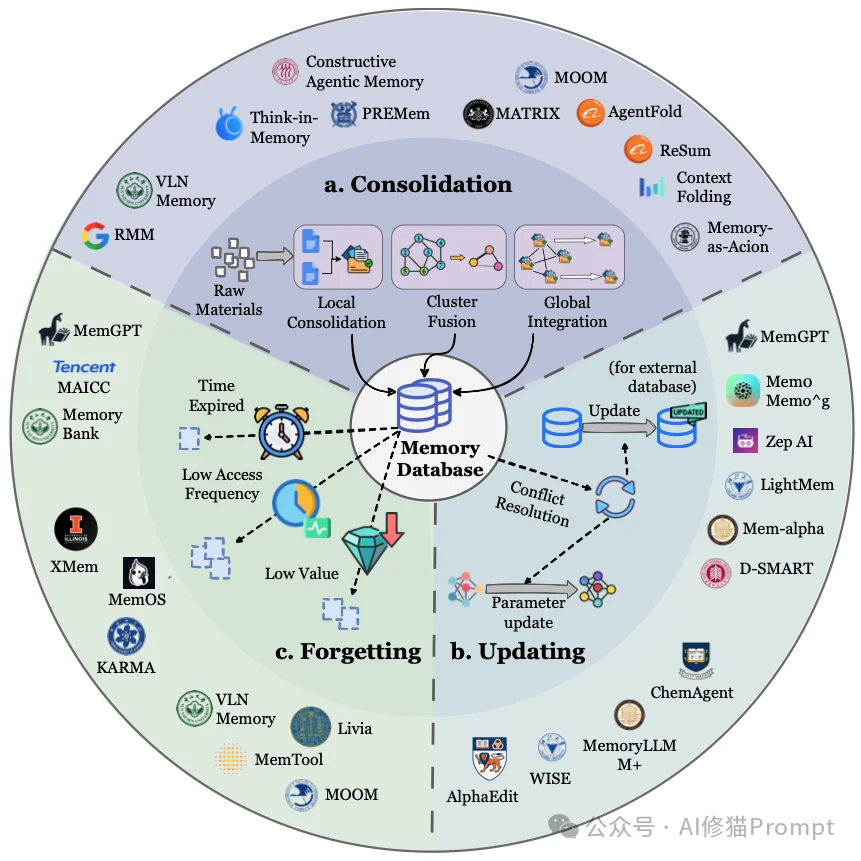

LLMLingua 等技术扔掉 80% 的冗余 Token,只保留核心信息进入处理流程;或者进行观测抽象(Observation Abstraction),将视频流转化为关键帧描述。记忆不是静态的数据库,它是一个活的系统。研究者将其生命周期拆解为三个核心过程:形成、演化、检索。

并不是所有的交互都值得被记住。如果把每一句“你好”、“在吗”都存入长期记忆,系统很快就会被垃圾信息淹没。

就像是人,每天经历无数事情,但晚上睡觉时,大脑只会筛选出最重要的片段,通过记忆巩固(Consolidation)存入长期记忆。

这是目前很多系统容易忽视的一环。记忆库如果不维护,就会变得混乱、冲突、过时。

传统的 RAG往往是被动的:用户问什么,系统搜什么。但高级Agent的检索是主动的、策略性的。

在这篇综述的最后,研究者们展望了几个极具潜力的发展方向。这些方向预示着 AI将从“工具”向“生命体”迈进。

现在的做法大多是把存好的文本原封不动地拿出来。但人类回忆时,其实是在重构场景。未来的 Agent可能会采用生成式记忆,根据当前的上下文,动态生成一段最符合当前需要的记忆描述,而不是死板地调取文件。这种方式能更好地融合多源信息,填补信息的空缺。

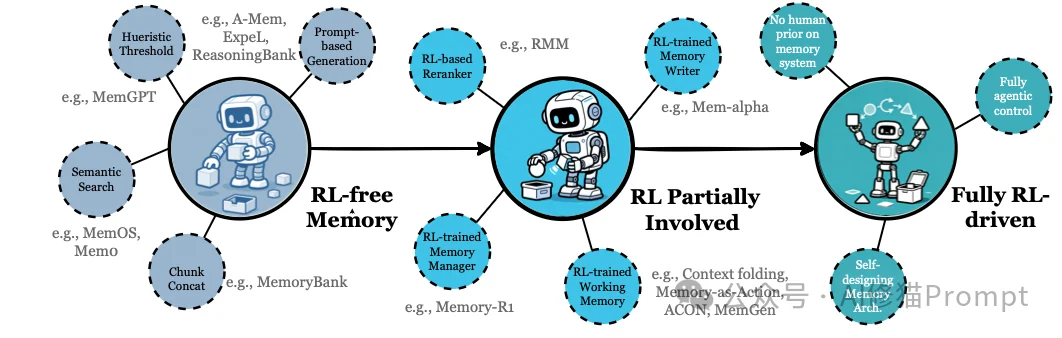

目前的记忆规则大多是人工设计的(比如“保留最近 10轮对话”)。未来,Agent应该通过强化学习(RL)自己学会如何管理记忆:

如果我们要构建能够模拟物理世界或复杂社会的Agent,它的记忆就需要包含时空一致性。Agent需要记住的不仅是文本,还有物体的位置、状态的变化、时间流逝的影响。这是通往具身智能(Embodied AI)的必经之路。

随着记忆越来越强,隐私和安全问题也随之而来。

读完这篇综述,我们不仅看到了技术的全景图,更看到了Agent进化的方向。

记忆,不再是一个简单的存储桶(Storage Bucket)。它是Agent实现连续性、个性化和自我进化的灵魂。从简单的文本记录,到复杂的层级结构,再到内化为参数的本能,Agent正一步步构建起属于它们自己的“海马体”。

当AI拥有了记忆,它就不再只是每一个 Session里新生的过客,而是成为了我们生活中可以积累感情、积累默契、共同成长的伙伴。这,或许才是 Agent时代的真正魅力所在。

文章来自于“AI修猫Prompt”,作者 “AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0