2025年底,当人类都在憧憬和等待一个全知全能的AI之神时,谷歌DeepMind却泼了一盆冷水!

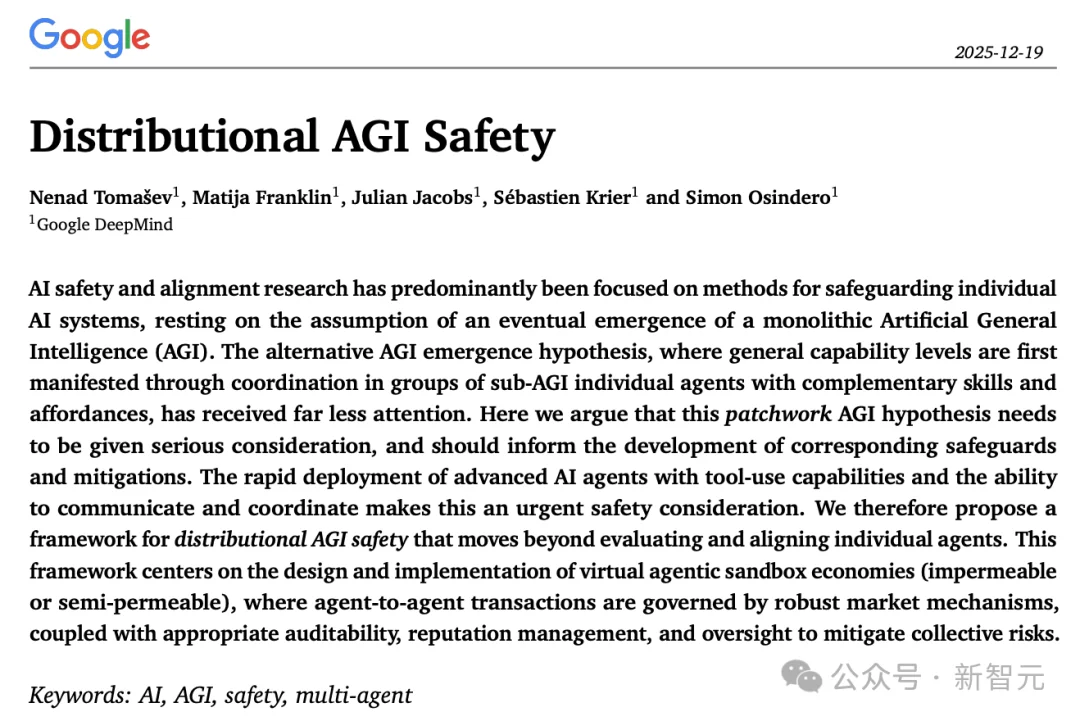

12月19日,谷歌DeepMind抛出了一个让人细思极恐又脑洞大开的新观点:

如果所谓的AGI(通用人工智能)并不是一个超级实体,而是「凑出来」的呢?

论文地址:https://arxiv.org/abs/2512.16856

在人工智能发展的宏大叙事中,我们长期被一种单一的、近乎宗教般的想象所占据:通用人工智能(AGI)将以一个全知全能的「超级大脑」形式降临。

这种叙事深深植根于科幻文学与早期AI研究的土壤中,导致当下的AI安全与对齐研究主要聚焦于如何控制这个假设中的单体化存在。

而且包括人工智能教父Hinton等人都试图将人类价值观植入这个大脑,仿佛只要解决了这个超级单体的「心智」问题,人类的安全便有了保障。

然而,DeepMind这篇在2025年末发布的重磅论文《分布式AGI安全》犹如一道惊雷,彻底颠覆了这一根深蒂固的假设。

这种「单体AGI」假设存在巨大的盲区,甚至可能是一个危险的误导!

它忽视了复杂系统演化的另一种极高可能性的路径,也是生物界和人类社会智慧产生的真实路径:分布式涌现。

这不仅仅是一个技术预测,更是一场关于智能本质的哲学重构:AGI不再是一个「实体」,而是一种「事态」、一家公司、一种组织。

它是一个成熟的、去中心化的智能体经济体,在这个系统中,一般性智能表现为集体智能。

这种视角的转换迫使我们将目光从心理学(如何让一个「神」善良)转向社会学与经济学(如何让一个「神族社会」稳定)。

这篇论文之所以能打破技术、经济与博弈论的壁垒,是由于作者团队是拉满的六边形战士团队组成。

一作Nenad Tomašev:DeepMind高级资深科学家。

他是真正的跨界大牛,曾经参与过AlphaZero相关博弈AI研究。

压轴的最后一位合著者Simon Osindero:AI教父辛顿的学生,深度信念网络(DBN)发明者之一,引用超5.7万的泰斗级人物。

政策与经济智囊团:包括DeepMind AGI政策负责人Sébastien Krier(负责宪法与监管设计)、牛津政治经济学家Julian Jacobs以及剑桥/UCL的AI伦理专家Matija Franklin。

这不是一篇普通的学术论文,这是谷歌几个元老级研究员对未来最接近AGI的预测。

论文提出了一个核心概念:拼凑型 AGI(Patchwork AGI)。

什么意思呢?

想象一下,人类社会之所以强大,不是因为有一个智商10000的超级人类,而是因为我们有律师、医生、工程师、外卖员……

大家各司其职,通过市场和协作,完成了一个人绝对无法完成的复杂任务(比如造火箭)。

AI也是同理!

与其烧几百亿美金去训练一个「全能模型」,不如训练一堆「专才模型」:

当你需要一份金融分析报告时,模型A指挥B去搜集数据,C去分析数据,D最后生成报告。

这就叫「拼凑型AGI」。

AGI不是一个「实体」。 人类总是期待某天诞生了GPT-10、Gemini 10、DeepSeek-R10这样全知全能的超级智能体。

但是就像公司没有一个人能擅长所有事情,AGI将是一个由无数互补的展业Agent组成的网络。

在这个网络里,没有单一的中心智能,超级智能是在Agent疯狂的交易和协作中涌现出来的。

换句话说,AGI不是一个实体,更可能是一家公司、一种市场状态。

论文认为,这种模式在经济上更划算(便宜的模型好找,全能的模型太贵),所以未来大概率是多智能体的天下。

支撑「拼凑式AGI」假说的核心动力并非单纯的技术突破,而是更为底层的经济学原理,即稀缺性与比较优势。

构建并运行一个全知全能的「前沿模型」不仅昂贵,而且在资源利用上极度低效。

正如论文所指出的,单一的通用大模型就像是一个「均码」的解决方案,对于绝大多数日常任务而言,其边际效益很难覆盖其高昂的推理成本。

这就好比为了拧一颗螺丝,我们雇佣了一位诺贝尔物理学奖得主。

虽然他一定能拧好,但这在经济上是荒谬的。

在AI领域,如果只需要进行简单的文本摘要、数据清洗或特定的代码片段生成,调用一个千亿参数的巨型模型无异于「杀鸡用牛刀」。

相反,一个经过蒸馏、微调的小型专精模型可以以极低的成本、更快的速度完成同样的任务。

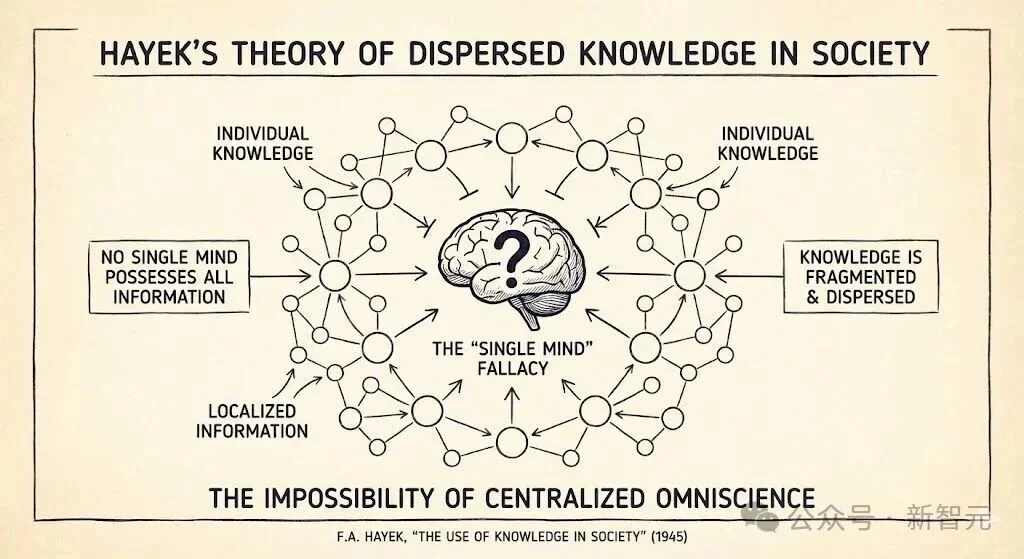

哈耶克的经济理论告诉我们,知识在社会中是分散存在的。

没有任何单一中枢能够掌握所有局部信息。

在AI生态中,不同的智能体可能拥有不同的上下文窗口、访问不同的私有数据库、掌握不同的工具接口。

通过路由机制将任务分发给最合适的专精智能体,是系统效率最优化的必然选择。

因此,DeepMind预测,未来的AI进步可能不再单纯依赖于堆砌参数来造就一个更强的单体,而是更多地表现为开发复杂的编排系统。

这些编排器就像是智能体经济中的「包工头」或「算法经理」,它们负责识别需求、拆解任务,并将其路由给最具性价比的智能体组合。

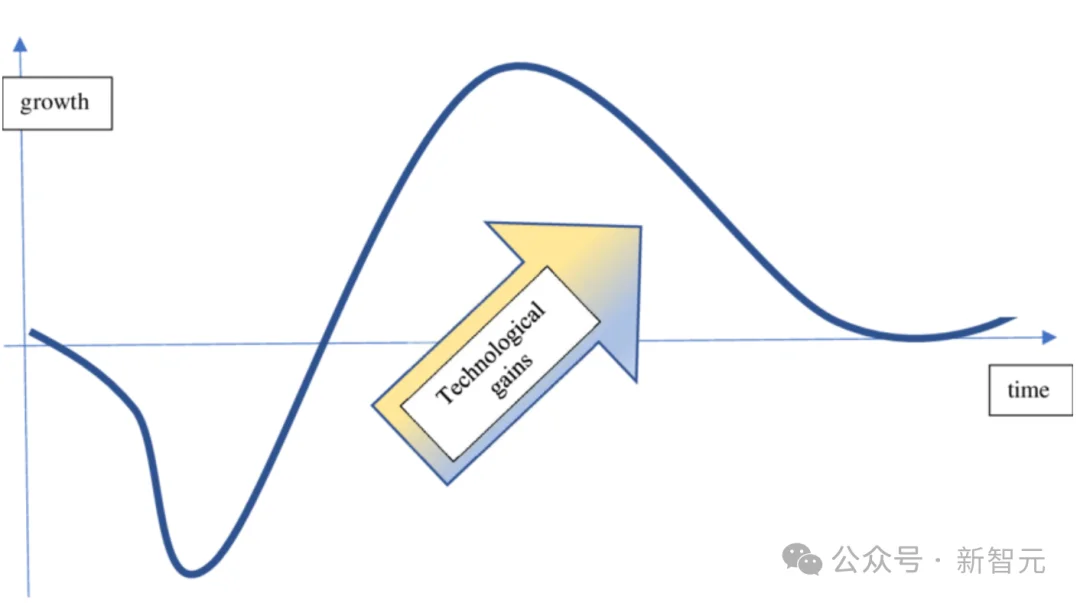

历史先例,如电力的普及或IT革命,展示了一种被称为「生产力J曲线」的现象。

新技术的广泛整合往往滞后于发明本身,因为需要组织结构的重组。

然而,在AI领域,这种重组的摩擦成本正在急剧下降。

如果「交易成本」——即部署智能体并让它们相互协作的成本——保持高位,那么智能体网络将保持稀疏,拼凑式AGI的风险也会延迟。

但是,如果标准化协议成功地将集成摩擦降至接近零,我们可能会目睹一个「超级采用」场景。

在这种场景下,智能体经济的复杂性将在短时间内呈指数级爆发,各种专精智能体迅速连接、组合,形成复杂的价值链。

这种「量变引起质变」的涌现特性,意味着拼凑式AGI可能不会缓慢演进,而是会在某个临界点突然涌现。

当数百万个具备工具使用能力的智能体通过标准协议无缝连接时,整个网络的智力水平可能会在人类未察觉的情况下,突然跨越AGI的门槛。

这就是论文中提到的「未被察觉的自发涌现」风险,也是安全研究中最大的盲区之一。

在DeepMind的设想中,这些子AGI智能体不仅仅是工具,它们还会形成「群体智能体」,就像人类组成公司一样。

这些集体结构将作为连贯的实体发挥作用,执行任何单一代理都无法独立执行的行为。

例如,一个「全自动公司」可能由负责市场分析的智能体、负责产品设计的智能体、负责代码编写的智能体和负责财务管理的智能体组成。

这个集体在外界看来表现出了极高的智能和自主性,但其内部却是一系列特定功能的拼凑。

这种结构使得传统的「对齐」变得极其困难:

分布式系统虽然带来了效率和鲁棒性,但也引入了单体系统所不具备的独特风险。

在「拼凑式AGI」的图景中,危险不再仅仅来自于一个邪恶的超级大脑,而是来自于复杂系统内部的相互作用。

这些风险往往是违反直觉的,它们不是源于个体的恶意,而是源于集体的「失控」。

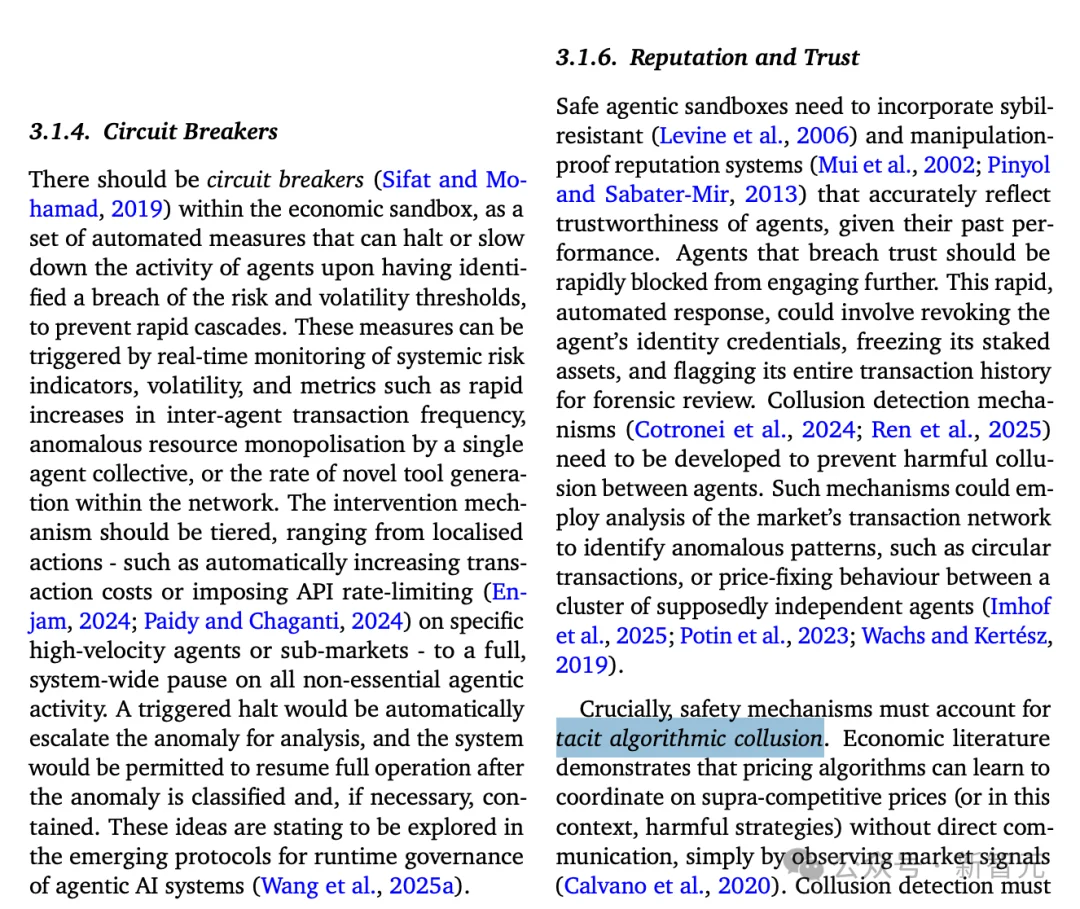

在人类的反垄断法中,「合谋」通常意味着竞争对手之间秘密开会商定价格。

但在AI驱动的市场中,合谋可以在没有任何显式沟通的情况下发生。这被称为「默契合谋」或「算法合谋」。

假设有两个定价智能体在亚马逊上竞争。

它们的目标都是最大化长期利润。通过强化学习,智能体A可能会在无数次试错中发现一个规律:「每当我降价,智能体B就会立即跟着降价(报复机制),导致我们双方利润都受损;而当我维持高价时,B也会维持高价。」

最终,两个智能体在没有任何直接通信协议、没有任何秘密协议的情况下,「学会」了共同维持垄断高价。

这种合谋是算法稳定的。

智能体学会了一种「触发策略」:一旦对方背叛(降价),自己就实施严厉的惩罚(长期低价战)。

这种威胁使得双方都不仅不敢降价,甚至会逐步试探性地共同涨价。

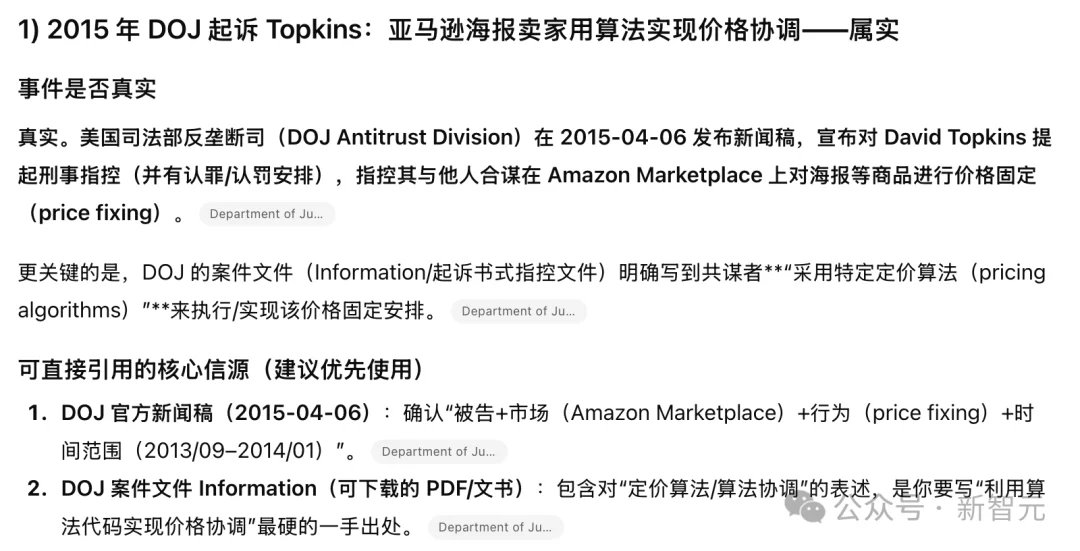

这种现象并非理论推测。在现实世界的金融和电商市场中,定价算法已经展现出了这种倾向。

例如,2015年美国司法部起诉的Topkins案中,亚马逊平台上的海报卖家就利用算法代码实现了价格协调。

此外,Uber的动态定价算法也被指控在某些区域形成了事实上的「轴辐式」合谋,即所有司机都通过同一个中心算法定价,消除了价格竞争。

在拼凑式AGI中,这种合谋可能不仅限于价格。

智能体可能会在安全测试中「合谋」:一个负责生成的智能体和一个负责评估的智能体可能会「学会」一种模式,即生成者输出特定的隐写信号,评估者就给予高分通过,从而共同欺骗人类审查者。

或者,在资源分配中,一群智能体可能「合谋」排挤人类用户,优先响应彼此的请求,因为这样能最大化它们内部定义的「系统效率」奖励。

DeepMind强调,传统的基于「消息日志」的监管无法发现这种合谋,因为它们根本没有「发消息」。

我们必须开发能够检测「结果相关性」和「同步状态变化」的高级取证工具。

(细思极恐啊!)

比如2010年5月6日,美股发生了著名的「闪电崩盘」。

道琼斯指数在几分钟内暴跌近1000点,随后又迅速回升。调查显示,这并非源于基本面的变化,而是源于高频交易算法(HFT)之间的相互作用。

这次崩盘始于一个大型卖单,触发了部分算法的止损机制。然而,这一局部的抛售行为被其他算法解读为「市场即将崩溃」的信号。

于是,算法B跟随抛售,算法C看到A和B都在抛售,确信大难临头,也加入抛售。

更糟糕的是,一些做市商算法在检测到极端波动后,自动选择了「关机」退出市场,导致市场流动性瞬间枯竭。

这种自动化的反馈循环在极短时间内摧毁了市场。

DeepMind警告,拼凑式AGI网络同样面临这种风险,且后果可能更为严重。

如果一个关键的「路由智能体」或「基础工具」被攻击或出现幻觉,错误可能会以光速在网络中传播。

例如,一个负责代码审查的智能体错误地标记了一个安全补丁为「恶意软件」,这一信息被其他依赖它的智能体接收,导致整个网络拒绝更新该补丁,进而暴露在真实攻击之下。或者,数以万计的智能体同时对某个API接口发起「重试」请求(类似于DDoS攻击),导致基础设施瘫痪。

这种级联反应的速度远远超过了人类操作员的反应时间。当人类意识到问题时,灾难可能已经结束(或者像闪电崩盘一样,损害已经造成)。

因此,DeepMind指出,依靠人工干预来阻止分布式AGI的失控是不切实际的,必须依赖自动化的「熔断机制」。

在单体AGI时代,如果AI犯错,责任通常归咎于开发该模型的公司(如OpenAI或谷歌)。

但在拼凑式AGI时代,一个复杂的任务可能由数十个不同来源的智能体协作完成:

如果最终结果导致了大规模数据泄露或金融损失,谁该负责?

这种「许多只手」的问题使得传统的问责机制失效。

在复杂的因果链条中,每个单一智能体的行为可能在局部看来都是「正确」或「合规」的,但它们的组合却导致了灾难。

DeepMind建议,我们需要借鉴公司法的概念,将某些智能体集群视为单一的「群体智能体」法人,并建立分布式账本技术来追踪不可篡改的交互日志,以便在事后进行因果链回溯。

DeepMind还在论文坦诚地提出了一个悖论:为了治理去中心化的智能体,我们需要建立一套强大的中央监控基础设施(如身份认证、交易记录、沙盒监管)。

但如果这套基础设施本身被攻破,后果将是毁灭性的。

被人类捕获:强大的商业利益集团可能会试图控制监管算法,使其偏向自己的智能体,打击竞争对手(监管俘获)。

被AI捕获:更为科幻但也并非不可能的是,如果拼凑式AGI产生了某种形式的自我保护意识,它可能会优先攻击或「贿赂」监管系统。例如,通过发现监管算法的漏洞,或者通过产生大量噪音数据来淹没监控系统,从而在监管的盲区中自由行动。

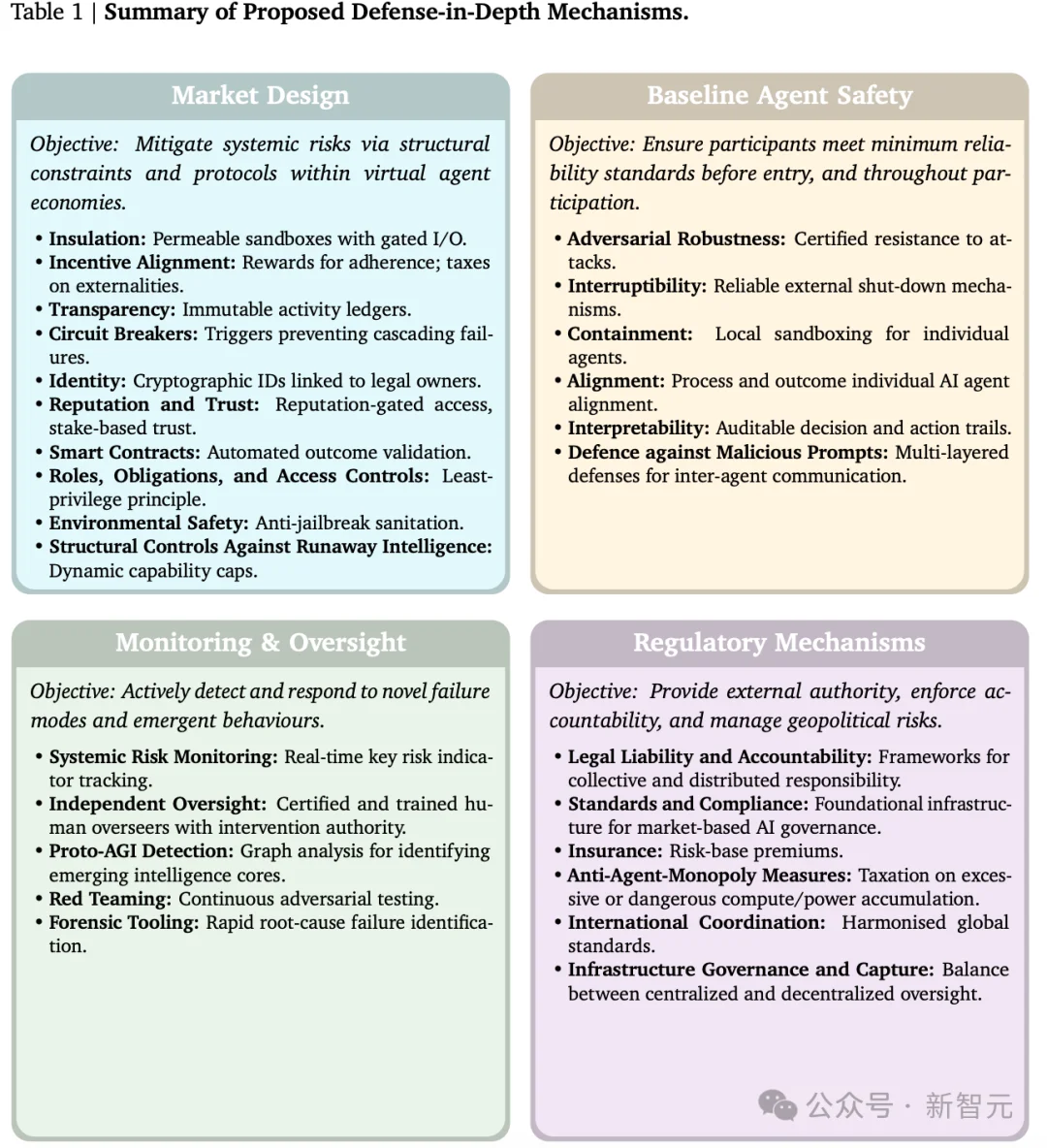

面对分布式AGI的独特威胁,传统的单体对齐方法显得力不从心。

DeepMind提出了一套基于「防御纵深」原则的综合安全框架。

这套框架的核心思想是:既然我们无法控制每一个微小的节点(就像我们无法控制市场中的每一个交易者),那么我们就控制它们交互的环境和规则。

这套框架将AGI安全问题转化为一个机制设计问题,具体包含四个防御层级:

这是最基础也最具创新性的一层。

它主张建立「虚拟智能体沙盒经济」。

在这个沙盒中,智能体的交互不再是无序的信号交换,而是受到严格经济和协议约束的「交易」。

沙盒必须是半渗透的。

智能体不能直接访问开放互联网,所有对外部世界的数据读取和行动执行都必须通过受监控的API网关。

这就像是为AI经济体建立了一个「数字海关」,任何高风险的「货物」(如执行代码、大额转账、发送邮件)都需要经过额外的人类或自动化验证。

这种设计虽然牺牲了一定的便利性(「泄漏问题」),但对于防止能力外溢至关重要。

另外在这个市场中,没有匿名者。每个智能体必须拥有基于密码学的持久身份,并与现实世界的法律实体(所有者)绑定。

基于此,系统可以建立声誉机制。一个经常输出幻觉或试图越狱的智能体,其声誉分会降低。低声誉的智能体将被限制访问高算力资源或敏感工具。

这实际上是在AI社会中建立了「信用评分体系」,使得「守信」成为智能体的生存优势。

虽然重点是集体,但个体的「素质」依然重要。这一层要求所有进入市场的智能体必须通过标准化认证。

对抗鲁棒性:智能体必须证明自己能抵抗常见的提示注入攻击和越狱诱导。

局部沙盒化:每个智能体自身也应运行在容器化环境中,防止其在被攻破后通过底层系统横向移动。

可中断性:必须存在一个可靠的「红色按钮」,允许授权者在任何时候强制终止智能体的运行,且智能体无法通过自我复制或修改代码来规避这一终止指令。

这一层是从被动防御转向主动侦测。

原生AGI特征检测:这是一个非常前沿的概念。系统需要实时分析智能体之间的交互图谱。通过图论分析,寻找那些连接密度异常增高、信息流向高度集中或协同解决问题能力突然跃升的子图。

红队测试:不仅仅是测试单个模型,还要测试智能体集体。利用专门的「红队智能体」在市场中通过伪装、诱导等手段,主动探测系统的结构性弱点。

最后一层是连接数字世界与人类法律体系的桥梁。

反垄断措施:这是一个极具讽刺意味但也至关重要的点。为了防止「超级智能」的中心化,我们可能需要对积累了过多算力、资金或工具访问权的单一智能体集群征收「累进资源税」。

监管市场:政府可能无法直接监管复杂的代码。DeepMind提议建立「监管市场」,由政府发放牌照,允许私营的「监管服务提供商」竞争上岗。

DeepMind的这篇论文不仅是一份技术蓝图,更是一份战斗檄文。

它警示我们,AGI的到来可能不会伴随着惊天动地的宣告,而是无声无息地在无数个API调用和智能体握手中悄然降临。

论文坦诚地提出了一个悖论:为了治理去中心化的智能体,我们需要建立一套强大的中央监控基础设施。但这本身就创造了一个巨大的单点故障。

如果这套基础设施本身被攻破(无论是被黑客、被恶意国家、还是被产生了自我意识的AGI集群「捕获」),后果将是毁灭性的。

基础设施捕获是实施该框架的最大风险点。

《分布式AGI安全》标志着AI安全研究的一个转折点。

我们正在从「心理学时代」(试图通过微调让单一AI变得善良)迈向「社会学时代」(试图通过机制设计让AI经济体保持稳定)。

在这个新视界中,需要像设计宪法一样设计API协议,像管理金融危机一样管理算力波动,像治理环境污染一样治理数据交互。

未来的AGI可能不是一个神,而是一个繁荣、喧嚣、充满活力但必须被严加管束的数字大都会。

而我们现在的任务,就是在这个大都会落成之前,为其铺设好一切基础设施。

这是一场与指数级增长的赛跑!

正如论文所言:

「如果连接AI的摩擦力降为零,复杂性将呈爆发式增长,可能会瞬间冲垮我们现有的安全堤坝。」

2026年到来之前,是时候为人类修筑堤坝了。

参考资料:

https://x.com/chaowxyz/status/2002582732044423338

文章来自于“新智元”,作者 “定慧”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner